Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)

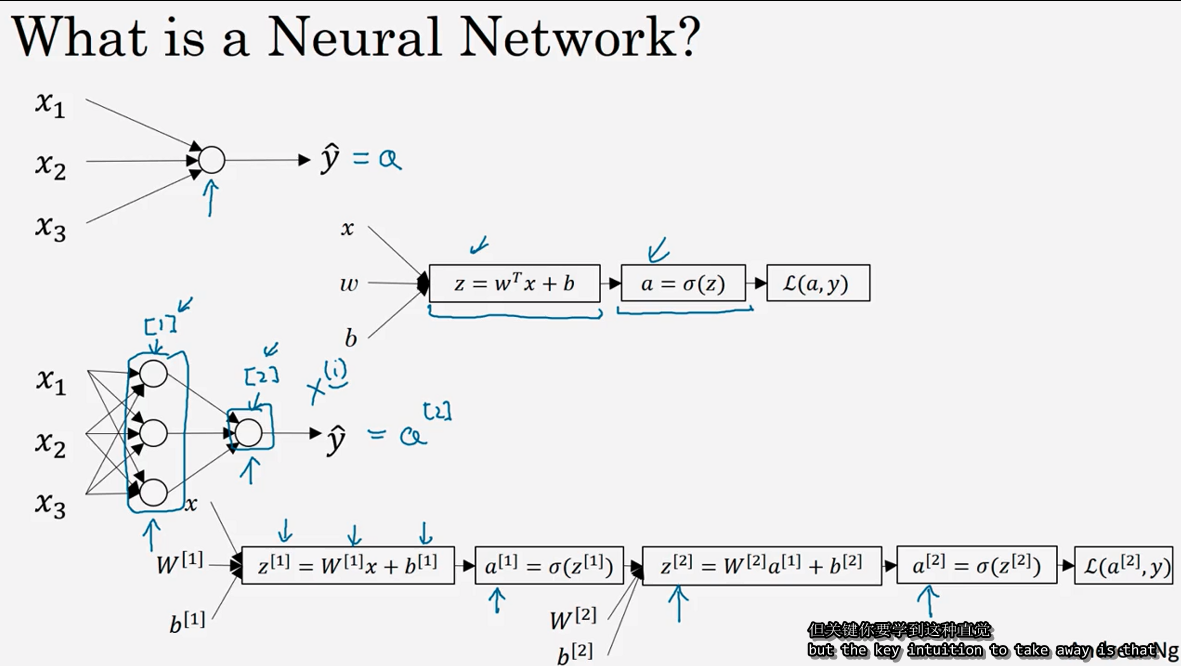

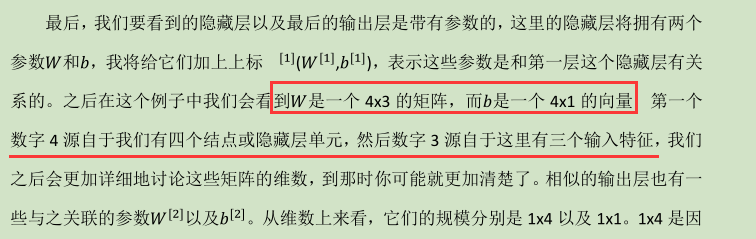

3.1 神经网络概述(Neural Network Overview )

(神经网络中,我们要反复计算a和z,最终得到最后的loss function)

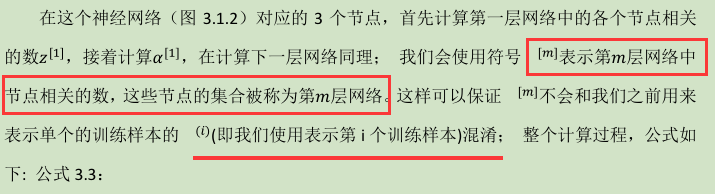

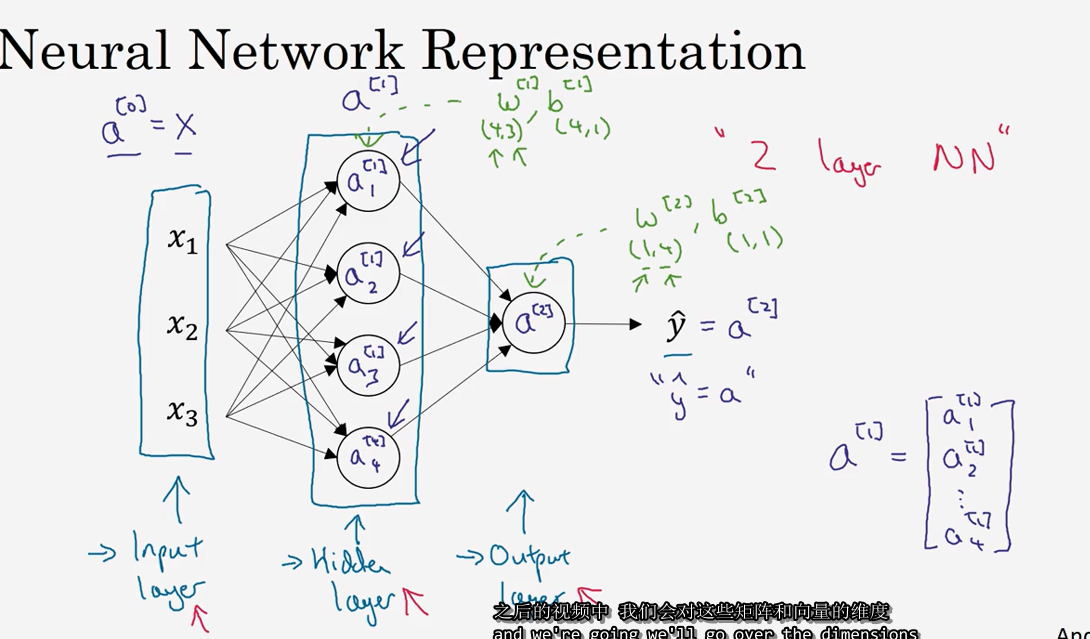

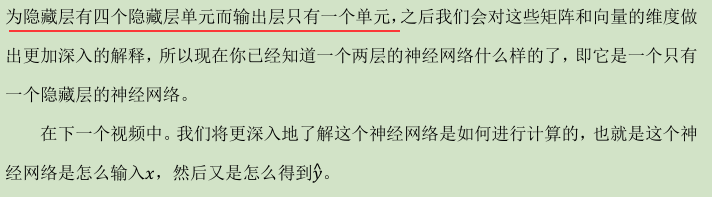

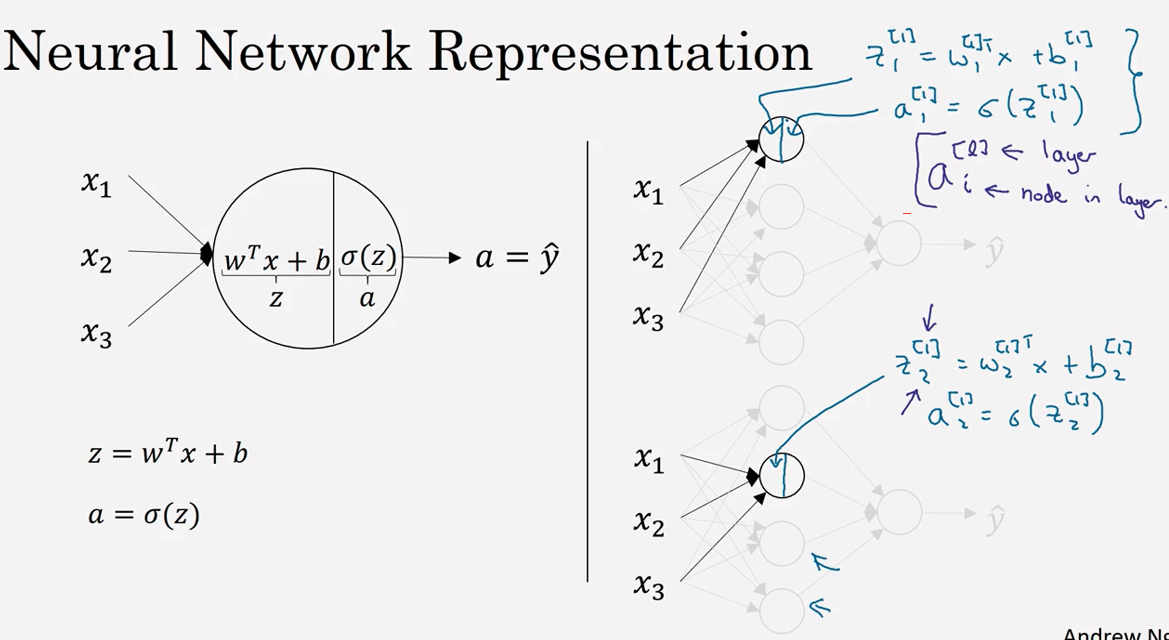

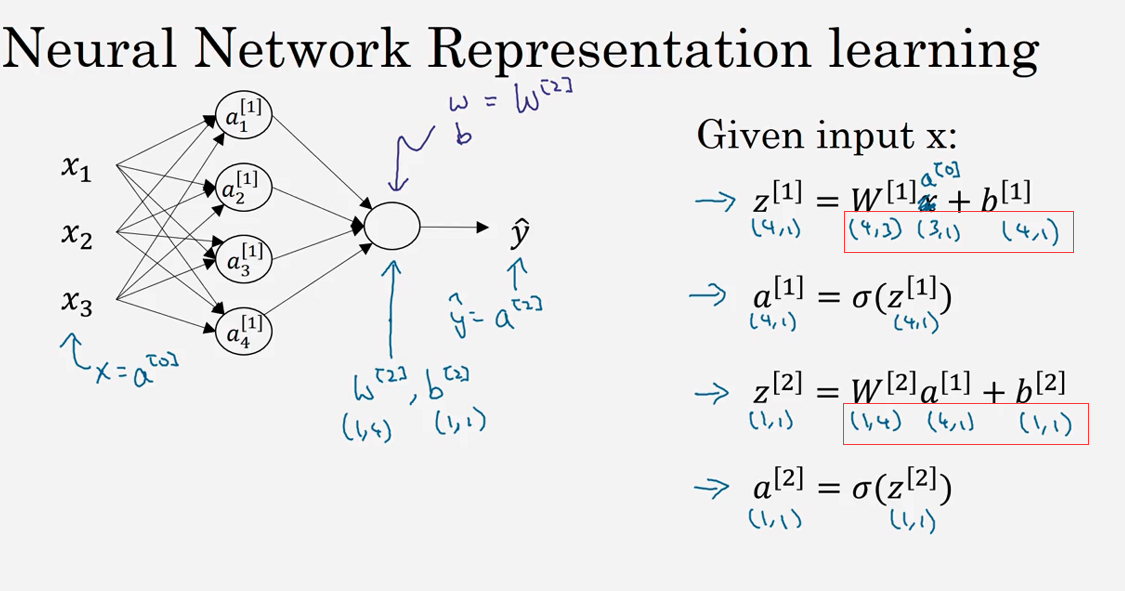

3.2 神经网络的表示(Neural Network Representation)

3.3 计算一个神经网络的输出(Computing a Neural Network's output )

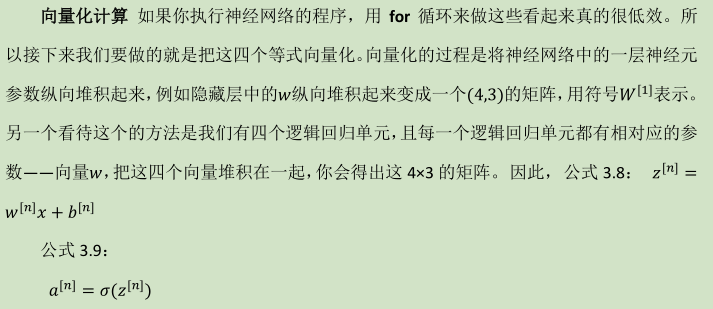

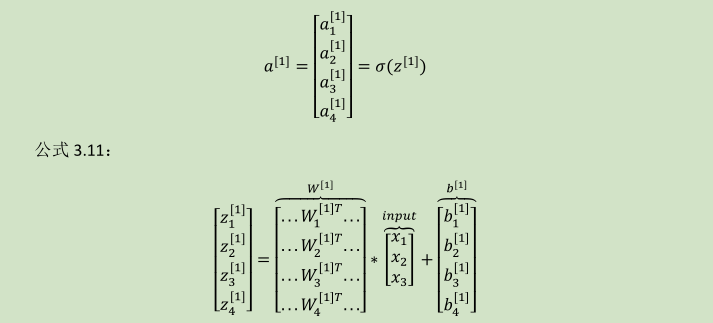

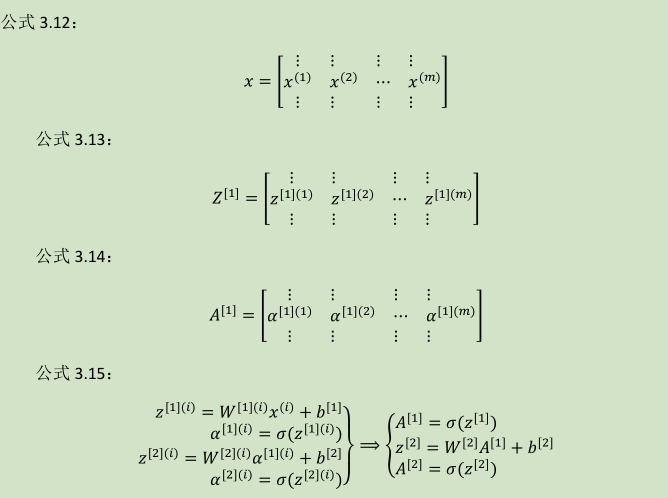

向量化计算:

详细过程见下: 公式 3.10:

(W---4x3)

(W---4x3)

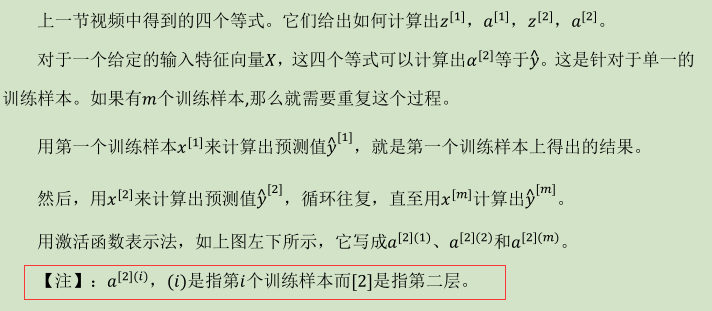

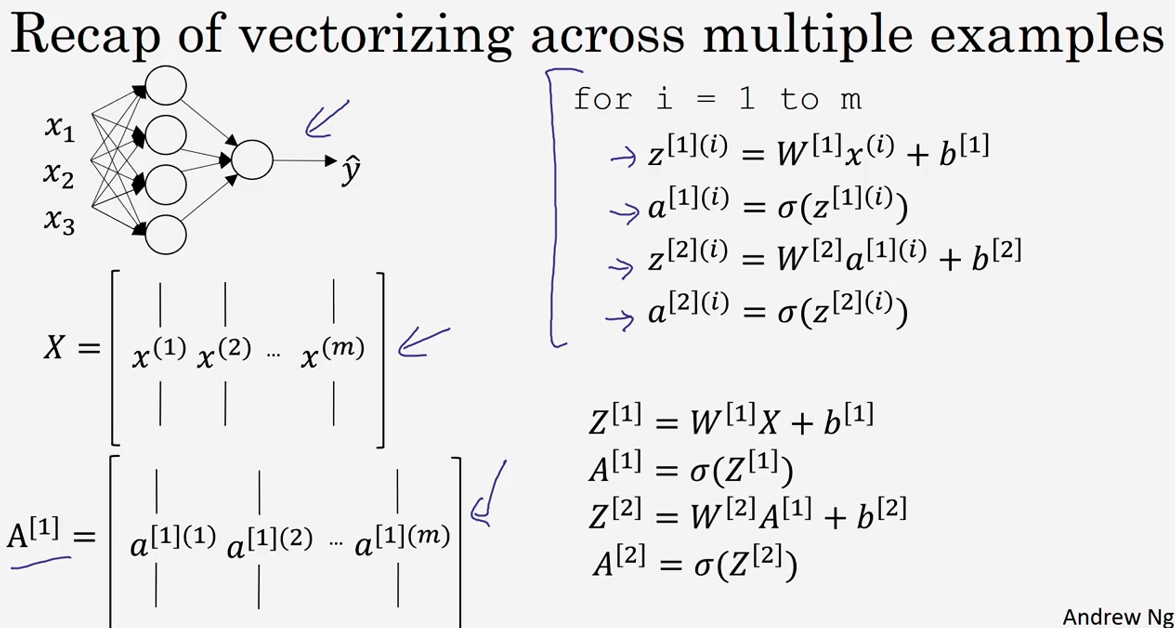

3.4 多样本向量化(Vectorizing across multiple examples )

所以横向矩阵A会扫过不同的训练样本,竖向是矩阵A中的不同指标。

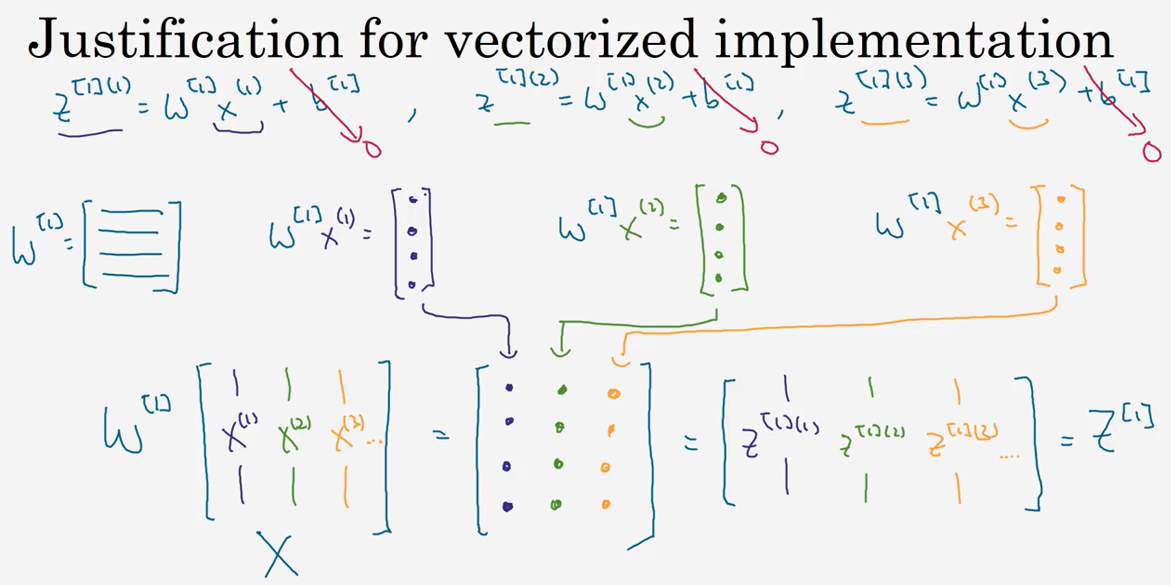

3.5 向 量 化 实 现 的 解 释 (Justification for vectorized implementation)

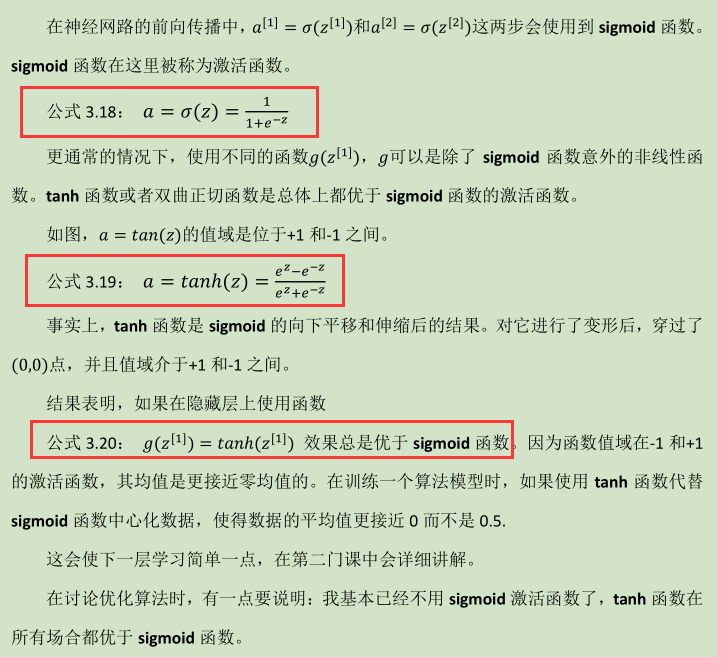

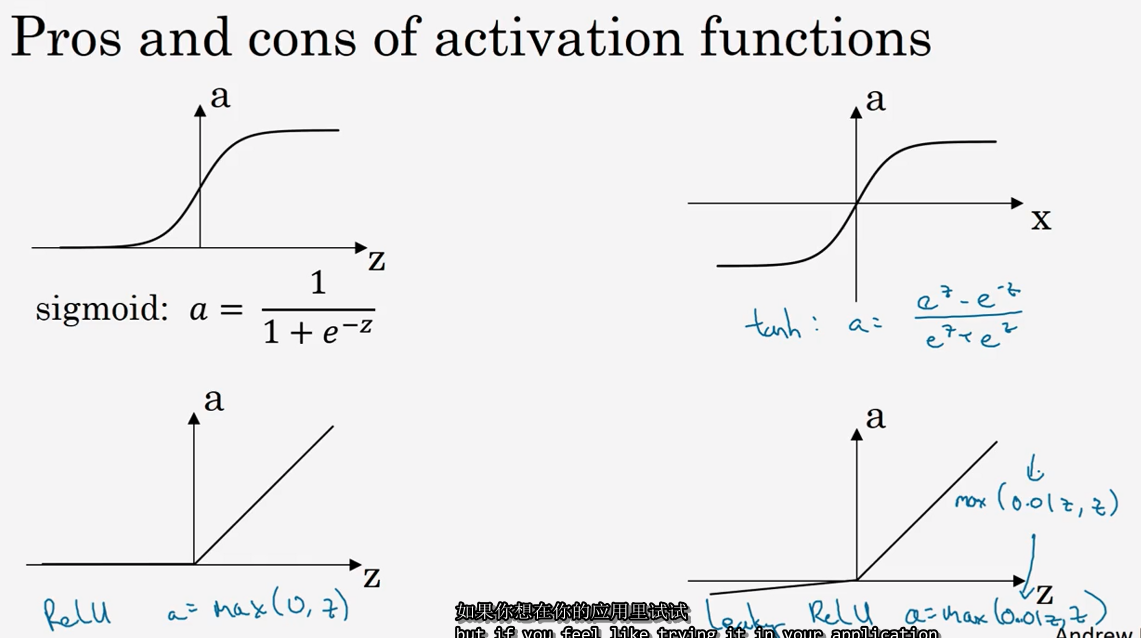

3.6 激活函数 (Activation functions)

tanh函数

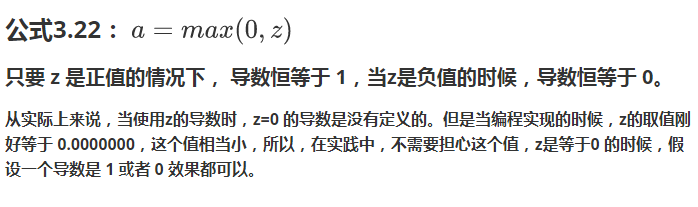

修正线性单元的函数(ReLu)(默认选项!)

如果输出是 0、1 值(二分类问题),则输出层选择 sigmoid 函数,然后其它的所有单元都选择 Relu 函数。

这是很多激活函数的默认选择,如果在隐藏层上不确定使用哪个激活函数,那么通常会使用 Relu 激活函数。有时,也会使用 tanh 激活函数,但 Relu 的一个缺点是:当z是负值的时候,导数等于 0。

这里也有另一个版本的 Relu 被称为 Leaky Relu。当z是负值时,这个函数的值不是等于 0,而是轻微的倾斜,如图。这个函数通常比 Relu 激活函数效果要好,尽管在实际中 Leaky ReLu 使用的并不多。

快速概括一下不同激活函数的过程和结论。

- sigmoid 激活函数:除了输出层是一个二分类问题基本不会用它。

- tanh 激活函数:tanh 是非常优秀的,几乎适合所有场合。

- ReLu 激活函数:最常用的默认函数,,如果不确定用哪个激活函数,就使用 ReLu

- Leaky ReLu: 公式 3.23:

Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)的更多相关文章

- Neural Networks and Deep Learning 课程笔记(第四周)深层神经网络(Deep Neural Networks)

1. 深层神经网络(Deep L-layer neural network ) 2. 前向传播和反向传播(Forward and backward propagation) 3. 总结 4. 深层网络 ...

- Neural Networks and Deep Learning 课程笔记(第二周)神经网络的编程基础 (Basics of Neural Network programming)

总结 一.处理数据 1.1 向量化(vectorization) (height, width, 3) ===> 展开shape为(heigh*width*3, m)的向量 1.2 特征归一化( ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第三周:浅层神经网络(Shallow neural networks) -课程笔记

第三周:浅层神经网络(Shallow neural networks) 3.1 神经网络概述(Neural Network Overview) 使用符号$ ^{[

- Neural Networks and Deep Learning学习笔记ch1 - 神经网络

近期開始看一些深度学习的资料.想学习一下深度学习的基础知识.找到了一个比較好的tutorial,Neural Networks and Deep Learning,认真看完了之后觉得收获还是非常多的. ...

- 吴恩达《深度学习》-第二门课 (Improving Deep Neural Networks:Hyperparameter tuning, Regularization and Optimization)-第一周:深度学习的实践层面 (Practical aspects of Deep Learning) -课程笔记

第一周:深度学习的实践层面 (Practical aspects of Deep Learning) 1.1 训练,验证,测试集(Train / Dev / Test sets) 创建新应用的过程中, ...

- AndrewNG Deep learning课程笔记 - CNN

参考, An Intuitive Explanation of Convolutional Neural Networks http://www.hackcv.com/index.php/archiv ...

- AndrewNG Deep learning课程笔记

神经网络基础 Deep learning就是深层神经网络 神经网络的结构如下, 这是两层神经网络,输入层一般不算在内,分别是hidden layer和output layer hidden layer ...

- AndrewNG Deep learning课程笔记 - RNN

The Unreasonable Effectiveness of Recurrent Neural Networks,http://karpathy.github.io/2015/05/21/rnn ...

- 《Neural Networks and Deep Learning》课程笔记

Lesson 1 Neural Network and Deep Learning 这篇文章其实是 Coursera 上吴恩达老师的深度学习专业课程的第一门课程的课程笔记. 参考了其他人的笔记继续归纳 ...

随机推荐

- A example that using JQuery clone

<html> <head> <script type="text/javascript" src="/jquery/jquery.js&qu ...

- Tomcat启动错误一例org.apache.catalina.core.StandardContext resources Start Error starting static Resources

org.apache.catalina.core.StandardContext resources Start Error starting static Resources 引发原因:Eclips ...

- 推荐一个php7+ mongodb三方类

373 次阅读 · 读完需要 8 分钟 5 由于项目需要,把项目升级到了php7.但是升级了之后发现mongo扩展不能用了.php7.0以上只支持mongodb扩展了.而mongodb扩展的驱 ...

- Linux shell 菜鸟学习笔记....

20171123 Linux shell 基础学习笔记1. shell 的开始 一般是 #!/bin/bash 通过 #! 来唯一指定使用的shell路径 其他的 # 都表示注释.2. shell 的 ...

- [转帖]DevOps/TestOps概念

发现收藏不好用..还是转吧.. https://www.cnblogs.com/fnng/p/8232410.html DevOps/TestOps概念 2018-01-07 22:02 by 虫师, ...

- Node url模块

const url = require("url");var u = "https://www.jd.com:443/ad/index?uname=qd";// ...

- 机器学习中的降维算法:ISOMAP & MDS

参见:https://blog.csdn.net/Dark_Scope/article/details/53229427

- liunx上安装MySQL一个非常简单的方法

1.官网下载yum源 https://www.mysql.com/ 2.把yum源包上传到linux,安装. 执行命令安装 [root@bogon ~]# yum localinstall mysql ...

- Bootstrap洼地

前面的话 这是一个轻量.灵活的组件,它能延伸至整个浏览器视口来展示网站上的关键内容.本文将详细介绍Bootstrap洼地 概述 洼地(Well)样式的效果和巨幕jumbotron样式类似,不同点是we ...

- python 解释器交互模块 -- sys

sys模块是与python解释器交互的一个接口 sys.argv 命令行参数List,第一个元素是程序本身路径 sys.getdefaultencoding(): 获取系统当前编码,一般默认为asci ...

- Neural Networks and Deep Learning 课程笔记(第四周)深层神经网络(Deep Neural Networks)