大数据学习——sparkSql对接mysql

1上传jar

2 加载驱动包

[root@mini1 bin]# ./spark-shell --master spark://mini1:7077 --jars mysql-connector-java-5.1.32.jar --driver-class-path mysql-connector-java-5.1.32.jar

create table dept(

deptno int ,

dname varchar(14) ,

loc varchar(13)

) ; create table emp(

eno int ,

ename varchar(10),

job varchar(9),

mgr int,

hirdate date,

sal int,

comm int,

deptno int not null

);

INSERT INTO dept VALUES(10,'ACCOUNTING','NEW YORK');

INSERT INTO dept VALUES(20,'RESEARCH','DALLAS');

INSERT INTO dept VALUES(30,'SALES','CHICAGO');

INSERT INTO dept VALUES(40,'OPERATIONS','BOSTON');

INSERT INTO emp VALUES(7369,'SMITH','CLERK',7902,'1980-12-17',800,NULL,20);

INSERT INTO emp VALUES(7499,'ALLEN','SALESMAN',7698,'1981-02-20',1600,300,30);

INSERT INTO emp VALUES(7521,'WARD','SALESMAN',7698,'1981-02-22',1250,500,30);

INSERT INTO emp VALUES(7566,'JONES','MANAGER',7839,'1981-04-02',2975,NULL,20);

INSERT INTO emp VALUES(7654,'MARTIN','SALESMAN',7698,'1981-09-28',1250,1400,30);

INSERT INTO emp VALUES(7698,'BLAKE','MANAGER',7839,'1981-05-01',2850,NULL,30);

INSERT INTO emp VALUES(7782,'CLARK','MANAGER',7839,'1981-06-09',2450,NULL,10);

INSERT INTO emp VALUES(7788,'SCOTT','ANALYST',7566,'1987-06-13',3000,NULL,20);

INSERT INTO emp VALUES(7839,'KING','PRESIDENT',NULL,'1981-11-17',5000,NULL,10);

INSERT INTO emp VALUES(7844,'TURNER','SALESMAN',7698,'1981-09-08',1500,0,30);

INSERT INTO emp VALUES(7876,'ADAMS','CLERK',7788,'1987-06-13',1100,NULL,20);

INSERT INTO emp VALUES(7900,'JAMES','CLERK',7698,'1981-12-03',950,NULL,30);

INSERT INTO emp VALUES(7902,'FORD','ANALYST',7566,'1981-12-03',3000,NULL,20);

INSERT INTO emp VALUES(7934,'MILLER','CLERK',7782,'1983-01-23',1300,NULL,10);

3

val sqlContext = new org.apache.spark.sql.SQLContext(sc)

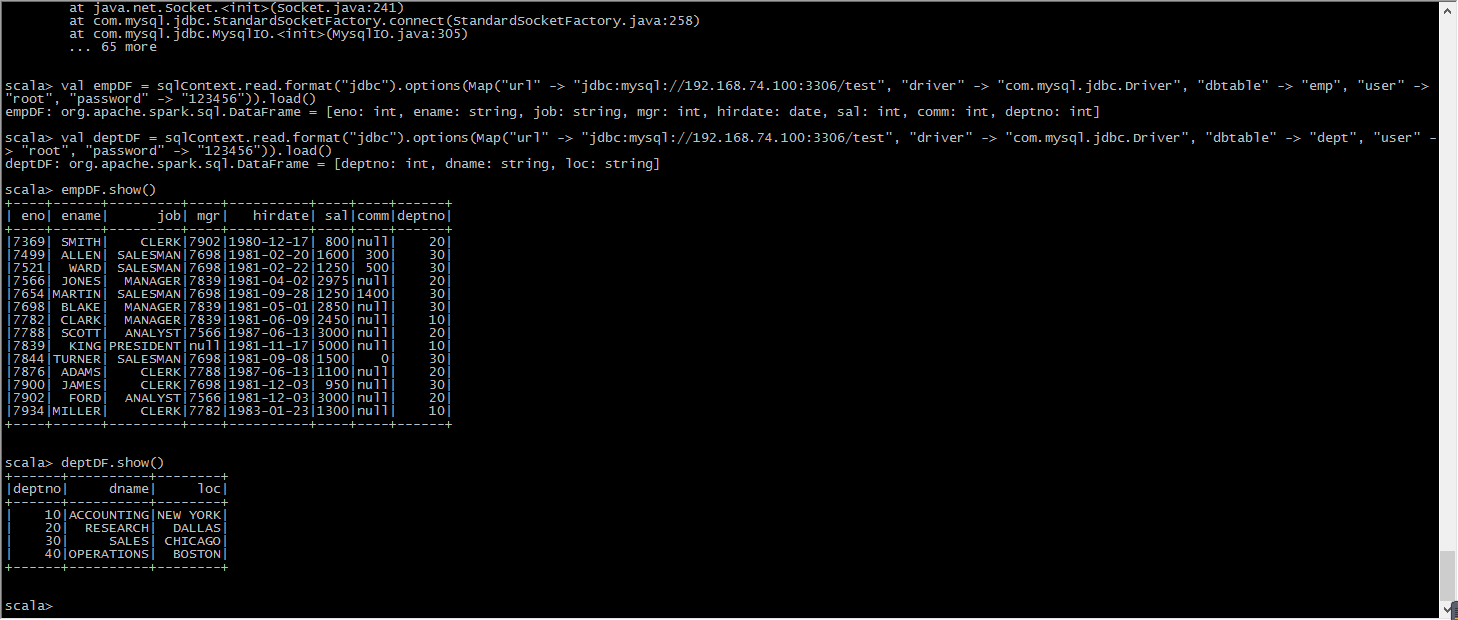

val empDF = sqlContext.read.format("jdbc").options(Map("url" -> "jdbc:mysql://192.168.74.100:3306/test", "driver" -> "com.mysql.jdbc.Driver", "dbtable" -> "emp", "user" -> "root", "password" -> "123456")).load()

val deptDF = sqlContext.read.format("jdbc").options(Map("url" -> "jdbc:mysql://192.168.74.100:3306/test", "driver" -> "com.mysql.jdbc.Driver", "dbtable" -> "dept", "user" -> "root", "password" -> "123456")).load()

4 读取数据(注意mysql要启动)

empDF.show()

deptDF.show()

empDF.registerTempTable("emp")

deptDF.registerTempTable("dept")

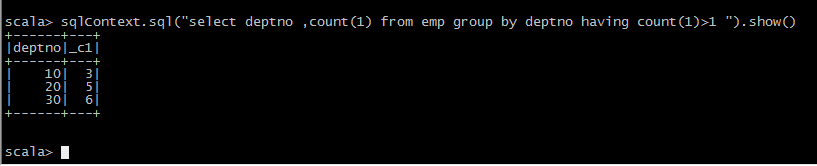

1.列出至少有一个员工的所有部门。

分析:每个部门有多少员工 ------ 根据部门编号进行分组

select deptno,count(*) from emp group by deptno having count(*) >= 1; 2.列出薪金比“SMITH”多的所有员工。(是否支持子查询)

分析:先查询出SMITH工资 : select sal from emp where ename='SMITH';

select * from emp where sal > (select sal from emp where ename='SMITH'); 3.***** 列出所有员工的姓名及其直接上级的姓名。

分析:表自映射,为表起别名,进行关联 t1 表模拟员工表 t2 表保存直接上级信息

select t1.ename 员工姓名, t2.ename 直接上级 from emp t1,emp t2 where t1.MGR = t2.empno; 4.列出受雇日期早于其直接上级的所有员工。

分析:原理和上题类似

select t1.*,t2.hirdate from emp t1,emp t2 where t1.MGR = t2.eno and t1.hirdate < t2.hirdate 5.列出部门名称和这些部门的员工信息,同时列出那些没有员工的部门。

分析:部门没员工也要显示 --- 外连接。无论怎样部门信息一定要显示,通过部门去关联员工

select * from dept left outer join emp on dept.deptno = emp.deptno ; 6.列出所有“CLERK”(办事员)的姓名及其部门名称。

分析:查找job为CLERK 员工姓名和部门名称

员工姓名 emp表

部门名称 dept表

select emp.ename,dept.dname,emp.job from emp,dept where emp.deptno = dept.deptno and emp.job='CLERK'; 7.列出最低薪金大于1500的各种工作。

分析:工作的最低薪金 ---- 按工作分组,求最低薪金

select min(sal) from emp group by job;

大于1500 是一个分组条件 --- having

select job,min(sal) from emp group by job having min(sal) > 1500; 8.列出在部门“SALES”(销售部)工作的员工的姓名,假定不知道销售部的部门编号。

分析:员工姓名位于 emp 部门名称 dept

select emp.ename from emp,dept where emp.deptno = dept.deptno and dept.dname = 'SALES'; 9.列出薪金高于公司平均薪金的所有员工。

分析:先求公司平均薪金 select avg(sal) from emp;

select * from emp where sal > (select avg(sal) from emp); 10.列出与“SCOTT”从事相同工作的所有员工。

分析:先查询SCOTT : select job from emp where ename ='SCOTT';

select * from emp where ename <> 'SCOTT' and job = (select job from emp where ename ='SCOTT'); 13.列出在每个部门工作的员工数量、平均工资。

分析:按部门分组

select deptno, count(*),avg(sal) from emp group by deptno; 14.列出所有员工的姓名、部门名称和工资。

分析:

select emp.ename,dept.dname,emp.sal from emp,dept where emp.deptno = dept.deptno; 15.列出所有部门的详细信息和部门人数。

分析:

select dept.deptno,count(1) from emp,dept where emp.deptno=dept.deptno group by dept.deptno ; 16.列出各种工作的最低工资。

分析:各个工作 分组 , 最低工资 min

select job,min(sal) from emp group by job; 17.列出各个部门的MANAGER(经理)的最低薪金。

分析:where job='MANAGER' 过滤所有不是经理数据

select deptno,min(sal) from emp where job ='MANAGER' group by deptno; 18.列出所有员工的年工资,按年薪从低到高排序。

分析: select ename, sal*12 from emp order by sal*12 asc; 19.查出emp表中薪水在3000以上(包括3000)的所有员工的员工号、姓名、薪水。

分析: select * from emp where sal >= 3000; 22.查询出emp表中所有的工作种类(无重复)

分析: select distinct job from emp; 23.查询出所有奖金(comm)字段不为空的人员的所有信息。

分析:不为空 is not null

select * from emp where comm is not null; 24.查询出薪水在800到2500之间(闭区间)所有员工的信息。(注:使用两种方式实现and以及between and)

分析:select * from emp where sal >= 800 and sal <= 2500;

select * from emp where sal between 800 and 2500; 25.查询出员工号为7521,7900,7782的所有员工的信息。(注:使用两种方式实现,or以及in)

分析:select * from emp where eno in(7521,7900,7782);

select * from emp where eno=7521 or eno = 7900 or eno = 7782; 26.查询出名字中有“A”字符,并且薪水在1000以上(不包括1000)的所有员工信息。

分析: 模糊查询

select * from emp where ename like '%A%' and sal > 1000; 27.查询出名字第三个字母是“M”的所有员工信息。

分析:第三个字母 __M%

select * from emp where ename like '__M%'; 28.将所有员工按薪水升序排序,薪水相同的按照入职时间降序排序。

分析:select * from emp order by sal asc,hiredate desc; 29.将所有员工按照名字首字母升序排序,首字母相同的按照薪水降序排序。

分析:SUBSTRING('字符串',第几个字符,长度); ---- 首字母 substring(ename,1,1)

select * from emp order by substring(ename,1,1) asc,sal desc;

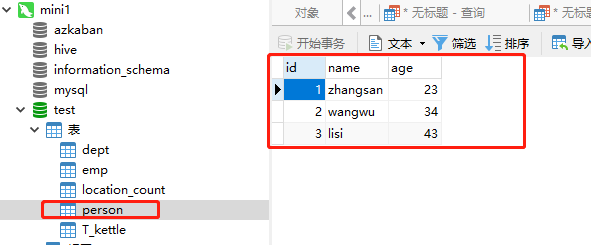

5 往mysql数据库写数据

package org.apache.spark import java.util.Properties import org.apache.spark.rdd.RDD

import org.apache.spark.sql.{DataFrame, DataFrameHolder, SQLContext} /**

* Created by Administrator on 2019/6/13.

*/

object JDBCsparksql {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("spark-joindemo").setMaster("local")

val sc = new SparkContext(conf)

val sqlContext = new SQLContext(sc)

val file = sc.textFile("hdfs://mini1:9000/person.json")

val personRDD: RDD[Person] = file.map(_.split(" ")).map(x => Person(x(0).toLong, x(1), x(2).toInt)) import sqlContext.implicits._

val personDF: DataFrame = personRDD.toDF()

personDF.registerTempTable("person")

val p: Properties = new Properties()

p.put("user", "root")

p.put("password", "123456") sqlContext.sql("select * from person").write.mode("overwrite").jdbc("jdbc:mysql://192.168.74.100:3306/test", "person", p)

sc.stop()

} } case class Person(id: Long, name: String, age: Int)

大数据学习——sparkSql对接mysql的更多相关文章

- 大数据学习——sparkSql对接hive

1. 安装mysql 2. 上传.解压.重命名 2.1. 上传 在随便一台有hadoop环境的机器上上传安装文件 su - hadoop rz –y 2.2. 解压 解压缩:apache- ...

- 大数据学习之路——MySQL基础(一)——MySQL的基础知识与常见操作

一.存储引擎 1.含义 存储引擎是数据库底层软件组织,数据库管理系统(DBMS)使用数据引擎进行创建.查询.更新和删除数据.不同的存储引擎提供不同的存储机制.索引技巧.锁定水平等功能,使用不同的存储引 ...

- 大数据学习——sparkSql

官网http://spark.apache.org/docs/1.6.2/sql-programming-guide.html val sc: SparkContext // An existing ...

- 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机)

引言 在大数据学习系列之一 ----- Hadoop环境搭建(单机) 成功的搭建了Hadoop的环境,在大数据学习系列之二 ----- HBase环境搭建(单机)成功搭建了HBase的环境以及相关使用 ...

- 大数据学习系列之五 ----- Hive整合HBase图文详解

引言 在上一篇 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机) 和之前的大数据学习系列之二 ----- HBase环境搭建(单机) 中成功搭建了Hive和HBase的环 ...

- 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

引言 在之前的大数据学习系列中,搭建了Hadoop+Spark+HBase+Hive 环境以及一些测试.其实要说的话,我开始学习大数据的时候,搭建的就是集群,并不是单机模式和伪分布式.至于为什么先写单 ...

- 大数据学习(一) | 初识 Hadoop

作者: seriouszyx 首发地址:https://seriouszyx.top/ 代码均可在 Github 上找到(求Star) 最近想要了解一些前沿技术,不能一门心思眼中只有 web,因为我目 ...

- 大数据学习笔记——Linux完整部署篇(实操部分)

Linux环境搭建完整操作流程(包含mysql的安装步骤) 从现在开始,就正式进入到大数据学习的前置工作了,即Linux的学习以及安装,作为运行大数据框架的基础环境,Linux操作系统的重要性自然不言 ...

- 大数据学习day38----数据仓库01-----区域字典的生成

更多内容见文档 1. 区域字典的生成 mysql中有如下表格数据 现要将这类数据转换成(GEOHASH码, 省,市,区)如下所示 (1)第一步:在mysql中使用sql语句对表格数据进行整理(此处使用 ...

随机推荐

- javascript组件封装中一段通用代码解读

有图有真相,先上图. 相信很多想去研究源码的小伙伴一定被这段代码给吓着了把,直接就打消了往下看下去的想法.我刚开始看的时候也是有点一头雾水,这是什么东东这么长,但是慢慢分析你就会发现其中的奥秘,且听我 ...

- gd调试命令,gdb调试core文件

使用 gcc -g test.c -o test.out 编译程序,只有加-g参数才支持gdb调试: 然后 gdb ./test.out 运行可执行文件,进入gdb调试模式(gdb),在括号后面的输入 ...

- jsp另外五大内置对象之response-设置头信息

<%@ page language="java" contentType="text/html; charset=utf-8" pageEncoding= ...

- 如何处理错误消息Please install the gcc make perl packages

如何处理这行错误消息? Please install the gcc make perl packages from your distribution. 执行命令行:yum install gcc ...

- 弄了一个星期的wp 8.1,吐血的感觉

看到8.1出来这么久了,心痒难耐,忍不住想重新把应用写一遍,于是上个星期开始动手,用的mvvm模式,结果一路下来,sqlce不能用了,那好吧,我用sqlite,webrequest变成httpclie ...

- UVA 690 PipelineScheduling 位运算+dfs+剪枝

一开始最容易想到间隔最多为n,但是结点还是太多了,需要优化. 预处理:预判一下并保存下一个可以放的位置距离之前的距离.这样可以减少很多判断. 最优化剪枝:如果当前长度+剩下没放的程序*最短间隔如果大于 ...

- Android(java)学习笔记137:ListView编写步骤(重点)

1.ListView在我们的手机android编写程序中使用是十分广泛的,比如如下图中 短信 和 手机设置 都是ListView的效果: 手机设置: 短信: 2.正因为这 ...

- 一些常用的HTML标签

由于本人目前没有系统学习,日常碰见哪个有用就记下来. pre标签 可定义预格式化的文本,在pre元素中的文本会保留空格和换行符.比如我们展示源代码的时候,只要放一个pre标签,然后把代码直接复制.粘贴 ...

- C++链表简单的应用

学生管理系统,输入学生的姓名和学号,然后再输出: #define _CRT_SECURE_NO_WARNINGS #include<stdio.h> #include <stdlib ...

- Spring框架配置文件中有两个相同名字的bean,最后会覆盖掉一个bean

问题容易出现在多个人合作的项目中,定义bean的名字的时候发生重复. 可以配置当bean定义重复的时候抛出异常,结束程序,强制提示更改重复的bean.