统计学习三:2.K近邻法代码实现(以最近邻法为例)

通过上文可知k近邻算法的基本原理,以及算法的具体流程,kd树的生成和搜索算法原理。本文实现了kd树的生成和搜索算法,通过对算法的具体实现,我们可以对算法原理有进一步的了解。具体代码可以在我的github上查看。

代码

#!/usr/bin/python3

# -*- coding:utf-8 -*-

import sys

import numpy as np

class Kdtree(object):

'''

类名: Kdtree

用于存储kd树的数据

成员:

__value: 训练数据,保存数据点的坐标

__type: 保存点对应的类型

__dim: 保存当前kd树节点的切分平面维度

left: 左子树

right: 右子树

'''

def __init__(self, node = None, node_type = -1, dim = 0, left = None, right = None):

self.__value = node

self.__type = node_type

self.__dim = dim

self.left = left

self.right = right

@property

def type(self):

return self.__type

@property

def value(self):

return self.__value

@property

def dim(self):

return self.__dim

def distance(self, node):

'''

计算当前节点与传入节点之间的距离

参数:

node: 需要计算距离的节点

'''

if node == None:

return sys.maxsize

dis = 0

for i in range(len(self.__value)):

dis = dis + (self.__value[i] - node.__value[i]) ** 2

return dis

def build_tree(self, nodes, dim = 0):

'''

利用训练数据建立一棵kd树

参数: nodes: 训练数据集

dim: 树的切分平面维度

return: a kd-tree

'''

if len(nodes) == 0:

return None

elif len(nodes) == 1:

self.__dim = dim

self.__value = nodes[0][:-1]

self.__type = nodes[0][-1]

return self

#将数据集按照第dim维度的值的大小进行排序

sortNodes = sorted(nodes, key = lambda x:x[dim], reverse = False)

#排序后,中间的点为当前节点值

midNode = sortNodes[len(sortNodes) // 2]

sortNodes.remove(midNode)

self.__value = midNode[:-1]

self.__type = midNode[-1]

self.__dim = dim

leftNodes = list(filter(lambda x: x[dim] < midNode[dim], sortNodes))

rightNodes = list(filter(lambda x: x[dim] >= midNode[dim], sortNodes))

nextDim = (dim + 1) % (len(midNode) - 1)

self.left = Kdtree().build_tree(leftNodes, nextDim)

self.right = Kdtree().build_tree(rightNodes, nextDim)

return self

def find_type(self, fnode):

'''

在kd树内查找传入点的最近邻点和对应的类型

参数: fnode: 需要判断类型的点

return: fnode的最近邻点和其类型

'''

if fnode == None:

return self, -1

fNode = Kdtree(fnode)

#首先搜索整棵树到达叶子节点

path = []

currentNode = self

while currentNode != None:

path.append(currentNode)

dim = currentNode.__dim

if fNode.value[dim] < currentNode.value[dim]:

currentNode = currentNode.left

else:

currentNode = currentNode.right

#path的最后一个节点即为叶子节点

nearestNode = path[-1]

nearestDist = fNode.distance(nearestNode)

path = path[:-1]

#向上进行回溯

while path != None and len(path) > 0:

currentNode = path[-1]

path = path[:-1]

dim = currentNode.__dim

#判断当前点是否比最近点更近

if fNode.distance(currentNode) < nearestDist:

nearestNode = currentNode

nearestDist = fNode.distance(currentNode)

#当前最近点一定存在于当前点的一棵子树上,那么找到它的兄弟子树的节点

brotherNode = currentNode.left

if fNode.value[dim] < currentNode.value[dim]:

brotherNode = currentNode.right

if brotherNode == None:

continue

#若兄弟子树的节点对应的区域与以fnode为圆心,以nearestDist为半径的圆相交,则进入兄弟子树,进行递归查找

bdim = brotherNode.__dim

if np.abs(fnode[bdim] - brotherNode.__value[bdim]) < nearestDist:

cNode, _ = brotherNode.find_type(fnode)

if fNode.distance(cNode) < nearestDist:

nearestDist = fNode.distance(cNode)

nearestNode = cNode

return nearestNode, nearestNode.type

if __name__ == "__main__":

#训练数据集

trainArray = [[1.0, 1.0, 'a'], [1.1, 1.1, 'a'], [1.5, 1.5, 'a'], \

[5.0, 5.0, 'b'], [5.2, 5.2, 'b'], [5.5, 5.5, 'b'], \

[3.0, 2.5, 'c'], [3.1, 2.8, 'c'], [3.2, 2.4, 'c']]

kdtree = Kdtree().build_tree(trainArray)

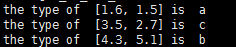

#test1

testNode = [1.6, 1.5]

_, testType = kdtree.find_type(testNode)

print("the type of ", testNode, "is ", testType)

#test2

testNode = [3.5, 2.7]

_, testType = kdtree.find_type(testNode)

print("the type of ", testNode, "is ", testType)

#test3

testNode = [4.3, 5.1]

_, testType = kdtree.find_type(testNode)

print("the type of ", testNode, "is ", testType)

测试结果

通过测试结果可知,kd树可以有效地对输入数据进行类型的识别。

讨论

虽然通过测试结果正确,但代码依然存在许多需要改进的地方,如kd树的选择,可以通过改进为红黑平衡树,来提高搜索速度。以及对于树的每层切分平面的维度选择,可以选择各维度中方差最大的维度,这样在此维度下的点分布更加分散,使后续的查找难度更小等等。

统计学习三:2.K近邻法代码实现(以最近邻法为例)的更多相关文章

- 统计学习方法三:K近邻

一.什么是K近邻? K近邻是一种基本的分类和回归方法. 在分类时,对新的实例,根据其K个最近邻的训练实例的类别,通过多数表决权等方式预测其类别. 通俗的讲,找K个和其关系最近的邻居,哪个类别的邻居多, ...

- 统计学习笔记之k近邻法

1.kNN算法的思想:给定一个训练数据集,对新的输入实例,在训练集中找到与该实例最近邻的k个实例,这k个实例的多数属于某类,就把输入实例分为这个类. 2.算法 (1)根据给定的距离度量,在训练集T中找 ...

- 4.机器学习——统计学习三要素与最大似然估计、最大后验概率估计及L1、L2正则化

1.前言 之前我一直对于“最大似然估计”犯迷糊,今天在看了陶轻松.忆臻.nebulaf91等人的博客以及李航老师的<统计学习方法>后,豁然开朗,于是在此记下一些心得体会. “最大似然估计” ...

- kd树 求k近邻 python 代码

之前两篇随笔介绍了kd树的原理,并用python实现了kd树的构建和搜索,具体可以参考 kd树的原理 python kd树 搜索 代码 kd树常与knn算法联系在一起,knn算法通常要搜索k近邻, ...

- 统计学习三:1.k近邻法

全文引用自<统计学习方法>(李航) K近邻算法(k-nearest neighbor, KNN) 是一种非常简单直观的基本分类和回归方法,于1968年由Cover和Hart提出.在本文中, ...

- 统计学习方法(三)——K近邻法

/*先把标题给写了.这样就能经常提醒自己*/ 1. k近邻算法 k临近算法的过程,即对一个新的样本,找到特征空间中与其最近的k个样本,这k个样本多数属于某个类,就把这个新的样本也归为这个类. 算法 ...

- 第三章 K近邻法(k-nearest neighbor)

书中存在的一些疑问 kd树的实现过程中,为何选择的切分坐标轴要不断变换?公式如:x(l)=j(modk)+1.有什么好处呢?优点在哪?还有的实现是通过选取方差最大的维度作为划分坐标轴,有何区别? 第一 ...

- kNN(k近邻)算法代码实现

目标:预测未知数据(或测试数据)X的分类y 批量kNN算法 1.输入一个待预测的X(一维或多维)给训练数据集,计算出训练集X_train中的每一个样本与其的距离 2.找到前k个距离该数据最近的样本-- ...

- 机器学习 —— 基础整理(三)生成式模型的非参数方法: Parzen窗估计、k近邻估计;k近邻分类器

本文简述了以下内容: (一)生成式模型的非参数方法 (二)Parzen窗估计 (三)k近邻估计 (四)k近邻分类器(k-nearest neighbor,kNN) (一)非参数方法(Non-param ...

随机推荐

- Python 学习笔记(九)Python元组和字典(二)

什么是字典 字典是另一种可变容器模型,且可存储任意类型对象. 字典的每个键值 key=>value 对用冒号 : 分割,每个键值对之间用逗号 , 分割,整个字典包括在花括号 {} 中 键必须是唯 ...

- mysql 使用order by

1.mysql 使用order by field() 自定义排序 order by field(value,str1,str2,str3,str4......strn) 例如:select * fro ...

- Deferred Lighting

Deferred lighting separate lighting from rendering and make lighting a completely image-space techni ...

- Swift_继承

Swift_继承 点击查看源码 func testInheritance() { //基类 class Base { var count = 0.0 var description: String { ...

- Swift_属性

Swift_属性 点击查看源码 class DataImporter { var fileName = "data.txt" init() { print("初始化&qu ...

- Mysql存储引擎myisam与inndb的区别?

最近在研究Mysql存储引擎这块,说白了就是如何存储数据.如何为存储的数据建立索引和如何更新.查询数据等技术的实现方法,在此做一个大概总结: 其实在工作中用的最多也就是MYISAM和INNODB,IN ...

- Ubuntu之C++开发环境的搭建

初学Linux,今天反复卸载与重装微软商店的Ubuntu好几次,终于解锁了在Ubuntu上搭建C++开发环境的正确姿势, 搭建了一个非常简单的开发环境:简单到什么地步呢?只是简单地配置了一下编辑器,安 ...

- 编译升级至openssh7.6

1.概述 目的:下载源码包(https://openbsd.hk/pub/OpenBSD/OpenSSH/portable/openssh-7.6p1.tar.gz),编译升级为openssh为7.6 ...

- javascript实现复选框单选多选!

<!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <title> ...

- Win7配置express4环境

本机环境: $ node -v v10.14.1 $ npm -v 6.4.1 配置node环境变量: #配置全局安装目录 npm config set prefix "G:\WEB\nod ...