【原】SparkContex源码解读(一)

版权声明:本文为原创文章,未经允许不得转载。

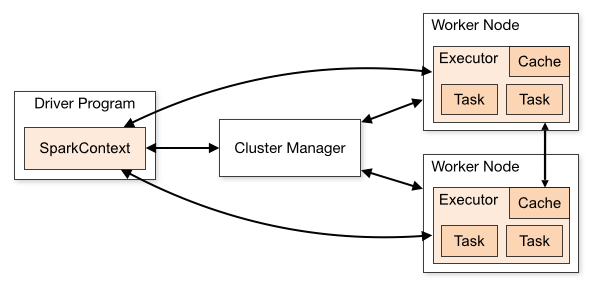

SparkContext(简称sc)是Spark程序的主入口,代表一个连接到Spark集群(Standalone、YARN、Mesos三种集群部署模式)的连接,能被用来在集群上创建RDDs、计数器(accumulators)和广播(broadcast)变量等。一旦和集群连接,sc首先得到集群中节点的executor信息,然后把app代码(jar形式或python文件)发送给executors,最后把job细分后的tasks派发给具体的executor执行。

Spark集群架构图

1.属性

(1)Spark异步事件监听器总线,可以理解为监听器的管家

private[spark] val listenerBus = new LiveListenerBus

(2)两个map集合,用于存储为每个静态文件和jar存放对应的URL和本地时间戳

private[spark] val addedFiles = HashMap[String, Long]

private[spark] val addedJars = HashMap[String, Long]

(3)用一个弱引用类型的Map,记录所有的持久化的RDDs,若值被gc后,那么引用将为null,每当插入N个元素后,就会从Map移除引用为空的entry

private[spark] val persistentRdds = new TimeStampedWeakValueHashMap[Int, RDD[_]]

(4)根据sparkconf、isLocal、监听总线创建Spark运行环境

private var _env: SparkEnv = createSparkEnv(_conf, isLocal, listenerBus)

(5)构造SparkContext的元数据清理器,使用了Timer周期性地清理日志信息,元数据类型不同,清理周期也可能不同

private var _metadataCleaner: MetadataCleaner = new MetadataCleaner(MetadataCleanerType.SPARK_CONTEXT, this.cleanup, _conf)

(6)默认executor的执行内存为1024M

private var _executorMemory: Int = _conf.getOption("spark.executor.memory")

.orElse(Option(System.getenv("SPARK_EXECUTOR_MEMORY")))

.orElse(Option(System.getenv("SPARK_MEM"))

.map(warnSparkMem))

.map(Utils.memoryStringToMb)

.getOrElse(1024)

(7)一个Spark application唯一的主键,它的形式取决于调度的实现,例如本地模式为'local-1433865536131'、YARN模式为 'application_1433865536131_34483'

private var _applicationId: String = _

(8)DAG调度器,把job根据shuffle边界划分为TaskSets

@volatile private var _dagScheduler: DAGScheduler = _

(9)Task调度器,目前只有一个实现子类TaskSchedulerImpl,负责接受从DAG调度器生成的TaskSets然后把他们分配到executor中执行,而TaskSetManager负责TaskSet的调度

private var _taskScheduler: TaskScheduler = _

(10)一个后端的调度接口,用于不同集群模式的调度

private var _schedulerBackend: SchedulerBackend = _

(11)设置一个心跳接收器,driver接受executor的心跳

private var _heartbeatReceiver: RpcEndpointRef = _

(12)JobProgressListener 用于处理Job及Stage相关的事件监听器

private var _jobProgressListener: JobProgressListener = _

2.方法

构造方法有8个,比较简单就不介绍了。

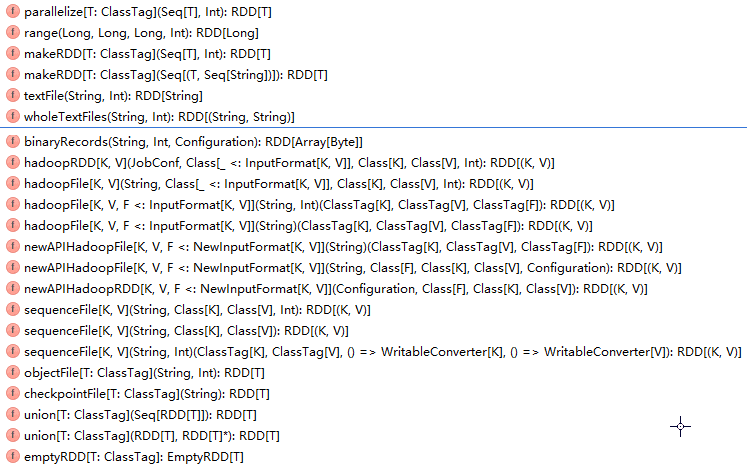

2.1.创建RDD的方法如下所示:

创建RDD的方法总览

方法对应生成的RDD类型有:BinaryFileRDD、BlockRDD、CartesianRDD、CheckpointRDD、CoalescedRDD、CoGroupedRDD、EmptyRDD、HadoopRDD、LocalCheckpointRDD、MapPartitionsRDD、MapPartitionsWithPrepationRDD、NewHadoopRDD、ParallelCollectionRDD、ParititionerAwareUnionRDD、PartitionPruningRDD、PartitionwiseSampledRDD、PipeRDD、SampleRDD、ShuffleRDD、SubstractedRDD、UnionRDD、ZippedPartitionsRDD、ZippedWithIndexRDD,如此多的的RDD,可见RDD的重要性。

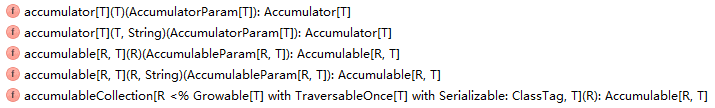

2.2.创建计数器(accumulators)的方法如下所示:

创建计数器的方法总览

2.3.创建广播(broadcast)变量的方法就一个:

def broadcast[T: ClassTag](value: T): Broadcast[T] = {

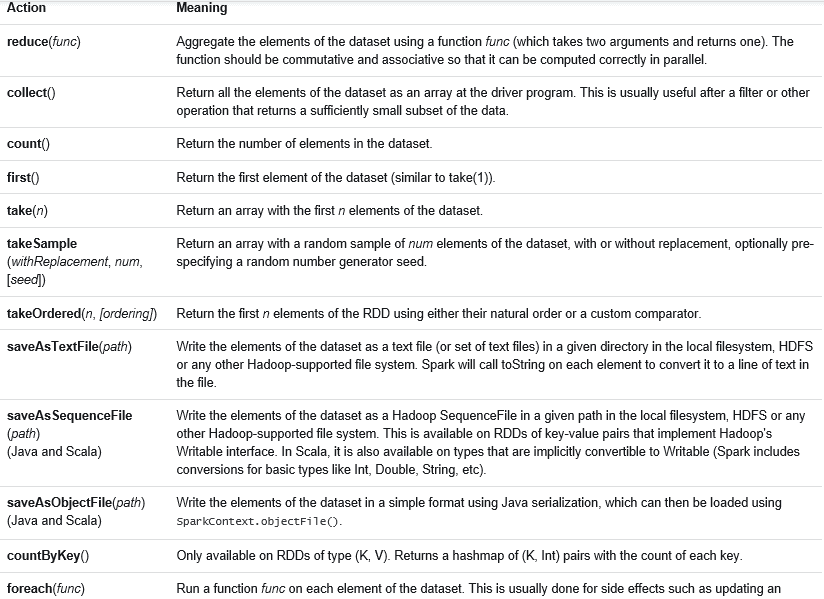

2.4.Spark程序程序job的运行是通过actions算子触发的,action算子如下所示:

action算子总览

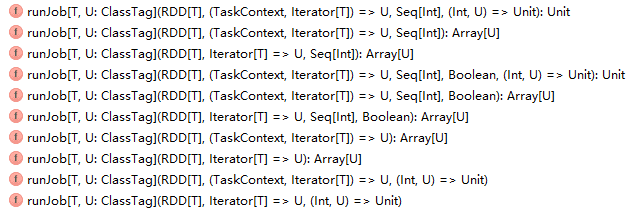

每一个action算子其实是一个runJob方法的运行,job的运行是将JobSubmitted事件添加到DAGScheduler中的事件执行队列中,并用JobWaiter等待结果的返回。runJob方法如下所示:

runjob方法总览

5.SparkContext如何在三种部署模式Standalone、YARN、Mesos下实现任务的调度

SparkContext中有一句关键性的代码:

//根据master(masterURL)及SparkContext对象创建TaskScheduler,返回SchedulerBackend及TaskScheduler

val (sched, ts) = SparkContext.createTaskScheduler(this, master)

考虑到篇幅的长度,方法createTaskScheduler的实现下一篇再介绍。

【原】SparkContex源码解读(一)的更多相关文章

- 【原】SparkContex源码解读(二)

版权声明:本文为原创文章,未经允许不得转载. 继续前一篇的内容.前一篇内容为: SparkContex源码解读(一)http://www.cnblogs.com/yourarebest/p/53266 ...

- 【原】Spark中Job的提交源码解读

版权声明:本文为原创文章,未经允许不得转载. Spark程序程序job的运行是通过actions算子触发的,每一个action算子其实是一个runJob方法的运行,详见文章 SparkContex源码 ...

- 【原】Spark不同运行模式下资源分配源码解读

版权声明:本文为原创文章,未经允许不得转载. 复习内容: Spark中Task的提交源码解读 http://www.cnblogs.com/yourarebest/p/5423906.html Sch ...

- SDWebImage源码解读_之SDWebImageDecoder

第四篇 前言 首先,我们要弄明白一个问题? 为什么要对UIImage进行解码呢?难道不能直接使用吗? 其实不解码也是可以使用的,假如说我们通过imageNamed:来加载image,系统默认会在主线程 ...

- underscore 源码解读之 bind 方法的实现

自从进入七月以来,我的 underscore 源码解读系列 更新缓慢,再这样下去,今年更完的目标似乎要落空,赶紧写一篇压压惊. 前文 跟大家简单介绍了下 ES5 中的 bind 方法以及使用场景(没读 ...

- Alamofire源码解读系列(四)之参数编码(ParameterEncoding)

本篇讲解参数编码的内容 前言 我们在开发中发的每一个请求都是通过URLRequest来进行封装的,可以通过一个URL生成URLRequest.那么如果我有一个参数字典,这个参数字典又是如何从客户端传递 ...

- nodeJS之eventproxy源码解读

1.源码缩影 !(function (name, definition) { var hasDefine = typeof define === 'function', //检查上下文环境是否为AMD ...

- AbstractQueuedSynchronizer源码解读

1. 背景 AQS(java.util.concurrent.locks.AbstractQueuedSynchronizer)是Doug Lea大师创作的用来构建锁或者其他同步组件(信号量.事件等) ...

- swoft 源码解读【转】

官网: https://www.swoft.org/ 源码解读: http://naotu.baidu.com/file/814e81c9781b733e04218ac7a0494e2a?toke ...

随机推荐

- php导出word(可包含图片)

为大家介绍一个 php 生成 导出word(可包含图片)的代码,有需要的朋友可以参考下. 之前介绍过php生成word的例子,只是不能包含图片与链接. 今天 为大家介绍一个 php 生成 导出word ...

- php开学之环境搭建

1. php版本选择 1.1 PHP非线程安全与线程安全版本的选择技巧 1.2 版本区别 PHP的大版本主要分三支:PHP4/PHP5/PHP6 其中,PHP4由于太古老.对QQ支持不力已基本被淘汰, ...

- mysql 远程连接 1045 Access denied for user 'root'@'XX.XX.XX.XX' (using password:YES)

用户名/密码错误,需要输入开放远程时设置的密码

- can't add foreign key in mysql?

create table department (dept_name ), building ), budget numeric(,) ), primary key (dept_name) ); cr ...

- 1.0 基础、标示符、常量、数据类型(enum 枚举,struct 结构体)、操作符、循环、数组

一.程序 现实生活中,程序是指完成某些事务的一种既定方法和过程,可以把程序看成是一系列动作执行过程的描述. 在计算机世界,程序是指令,即为了让计算机执行某些操作或解决某个问题而编写的一系列有序指令的集 ...

- Codeforces Round #361 div2

ProblemA(Codeforces Round 689A): 题意: 给一个手势, 问这个手势是否是唯一. 思路: 暴力, 模拟将这个手势上下左右移动一次看是否还在键盘上即可. 代码: #incl ...

- centos 卸载vsftpd方法

centos 卸载vsftpd方法 在服务器上安装了vsftpd,配置出错需要卸载vsftpd.卸载vsftpd的命令如下: 1 [root@localhost ~]# rpm -aq vsftpd2 ...

- 各大搜索引擎的User-Agent

baidu:Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) Google:Moz ...

- C# List<> 删除

List<string> l = new List<string>() { "A1", "A2", "A3", &q ...

- Linux下 config/configure/Configure、make 、make test/make check、sudo make install 的作用

转自Linux下 config/configure/Configure.make .make test/make check.sudo make install 的作用 这些都是典型的使用GNU的AU ...