Spark记录(一):Spark全景概述

一、Spark是什么

Spark是一个开源的大数据处理引擎。

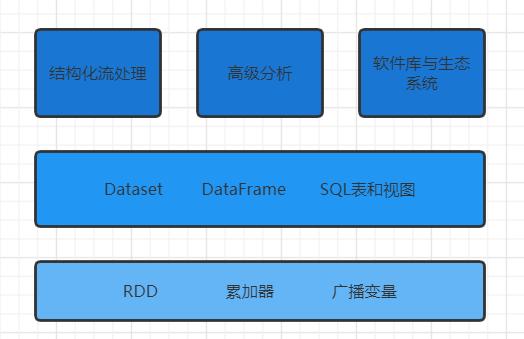

二、Spark的主要组件如下图所示:

三、Spark运行时架构

Spark共有三种运行模式:本地模式、集群模式、客户端模式。

生产环境基本都是用集群模式。集群模式需要用到集群管理器,三个核心的集群管理器为:Spark自带的独立集群管理器、Yarn、Mesos。

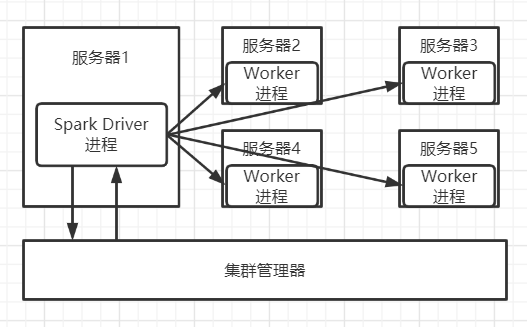

集群模式运行时,单个Spark任务的架构图为:

其中集群管理器负责分配/回收服务器资源和监控整个Spark任务是否完成。

四、IDEA环境准备

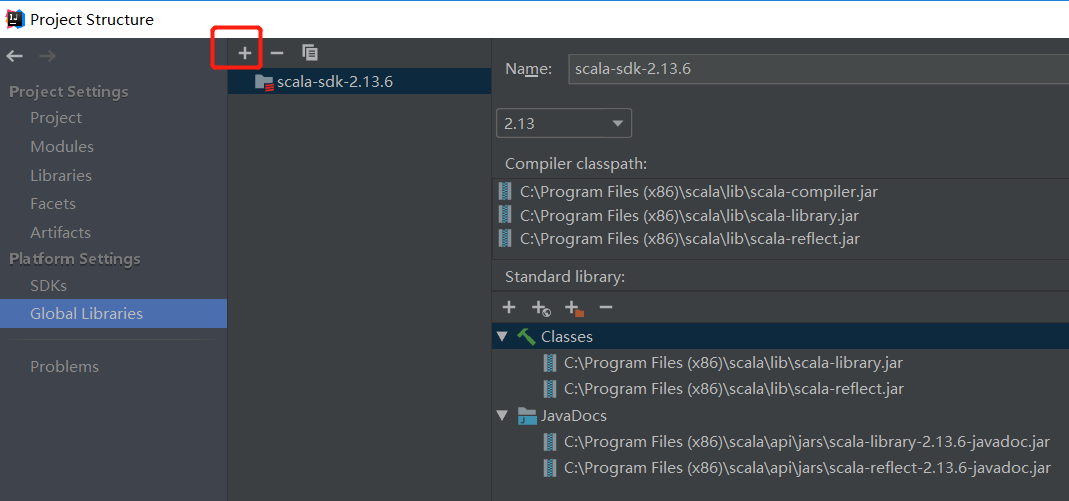

1、准备Scala的SDK

若用Scala开发的话,需做此步。下载Scala的msi文件本地安装之后,在IDEA中如下图所示的加号位处导入Scala的SDK目录,导入之后会如下图所示:

2、在Plugins中安装名叫Scala的插件

自行安装即可

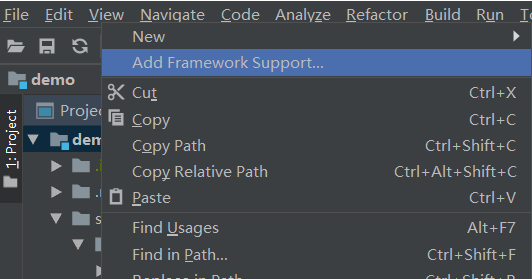

3、配置项目支持Scala

选中项目最高级目录后右键,选择【Add Framework Support】,然后在里面勾选Scala选项

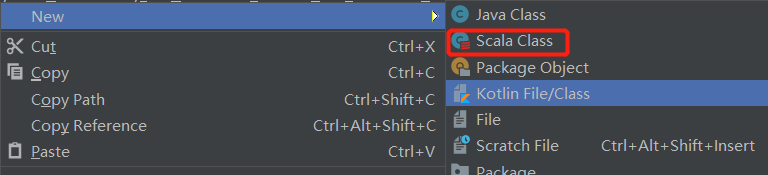

如此之后,便可以在包里面右键new Scala类了:

4、导入maven依赖

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-mllib_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

版本用的是:

<spark.version>3.2.0</spark.version>

<scala.version>2.13</scala.version>

5、编写个简单的脚本运行

def main(args: Array[String]): Unit = {

val ss = SparkSession.builder().appName("localhost").master("local[*]").getOrCreate()

val df1 = ss.range(2, 100, 2).toDF()

val df2 = ss.range(2, 100, 4).toDF()

val df11 = df1.repartition(5)

val df21 = df2.repartition(6)

val df12 = df11.selectExpr("id * 5 as id")

val df3 = df2.join(df12, "id")

val df4 = df3.selectExpr("sum(id)")

df4.collect().foreach(println(_))

df4.explain()

}

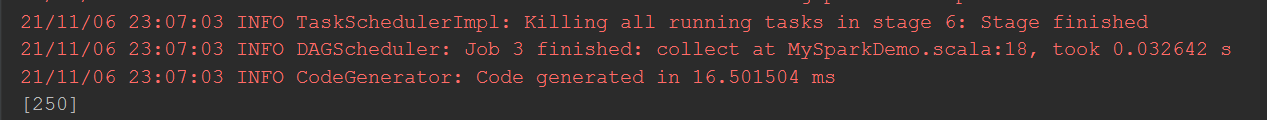

运行结果:

Intersting Number!

explain打印出来的逻辑计划,有时间再详细解读。

另附:

1、下载历史Hadoop版本的地址:

http://archive.apache.org/dist/hadoop/core/

2、下载winutils.exe、hadoop.dll文件的地址:

https://blog.csdn.net/ytp552200ytp/article/details/107223357

Spark记录(一):Spark全景概述的更多相关文章

- Spark记录-本地Spark读取Hive数据简单例子

注意:将mysql的驱动包拷贝到spark/lib下,将hive-site.xml拷贝到项目resources下,远程调试不要使用主机名 import org.apache.spark._ impor ...

- Spark记录-SparkSql官方文档中文翻译(部分转载)

1 概述(Overview) Spark SQL是Spark的一个组件,用于结构化数据的计算.Spark SQL提供了一个称为DataFrames的编程抽象,DataFrames可以充当分布式SQL查 ...

- Spark记录-SparkSQL相关学习

$spark-sql --help 查看帮助命令 $设置任务个数,在这里修改为20个 spark-sql>SET spark.sql.shuffle.partitions=20; $选择数据 ...

- Spark记录-实例和运行在Yarn

#运行实例 #./bin/run-example SparkPi 10 #./bin/spark-shell --master local[2] #./bin/pyspark --master l ...

- Spark记录-官网学习配置篇(一)

参考http://spark.apache.org/docs/latest/configuration.html Spark提供三个位置来配置系统: Spark属性控制大多数应用程序参数,可以使用Sp ...

- Spark记录-spark编程介绍

Spark核心编程 Spark 核心是整个项目的基础.它提供了分布式任务调度,调度和基本的 I/O 功能.Spark 使用一种称为RDD(弹性分布式数据集)一个专门的基础数据结构,是整个机器分区数据的 ...

- Spark记录-spark介绍

Apache Spark是一个集群计算设计的快速计算.它是建立在Hadoop MapReduce之上,它扩展了 MapReduce 模式,有效地使用更多类型的计算,其中包括交互式查询和流处理.这是一个 ...

- Spark记录-spark与storm比对与选型(转载)

大数据实时处理平台市场上产品众多,本文着重讨论spark与storm的比对,最后结合适用场景进行选型. 一.spark与storm的比较 比较点 Storm Spark Streaming 实时计算模 ...

- Spark记录-Spark on mesos配置

1.安装mesos #用centos6的源yum安装 # rpm -Uvh http://repos.mesosphere.io/el/6/noarch/RPMS/mesosphere-el-repo ...

随机推荐

- setTimeout 与setInterval的区别

setTimeout(code,millisec) 方法用于在指定的毫秒数后调用函数或计算表达式 setInterval(code,millisec) 方法可按照指定的周期(以毫秒计)来调用函数或计算 ...

- AT4505-[AGC029F]Construction of a tree【构造题,hall定理,网络流】

正题 题目链接:https://www.luogu.com.cn/problem/AT4505 题目大意 给出\(n\)个点和\(n-1\)个点集\(U_i\),每个点集中选择两个点连边使得该图是一棵 ...

- AngularJS的简单实用

Angular Js 的初步认识和使用 一: 1.模块化 定义模块和控制器 ng-app="myapp" controller=&qu ...

- 3.docker容器常用命令

docker容器的常用命令 docker有很多命令,让我们一个一个全部背下来,基本是不可能的,帮助文档的作用就很大了,想要查询那个命令,直接去找帮助文档,帮助文档地址:https://docs.doc ...

- MySQL的本地事务、全局事务、分布式事务

本地事务 事务特性:ACID,其中C一致性是目的,AID是手段. 实现隔离性 写锁:数据加了写锁,其他事务不能写也不能读. 读锁:数据加了读锁,其他事务不能加写锁可以加读锁,可以允许自己升级为写锁. ...

- AtCoder Beginner Contest 221 A~E题解

目录 A - Seismic magnitude scales B - typo C - Select Mul D - Online games E - LEQ 发挥比较好的一场,就来搓篇题解. F ...

- Redux使用指南

Redux使用指南 00-简介 本文主要是用来记录Redux结合React的使用过程,帮助大家在使用Redux的时候,能够更好的理解Redux,从而更好地使用它 01-为什么需要Redux JavaS ...

- CF850E Random Elections 题解

题目传送门 题目大意 没法描述,过于繁杂. 思路 果然自己是个菜鸡,只能靠读题解读题,难受极了,其实不是很难自己应该做得出来的....哎.... 不难发现可以统计 \(A\) 获胜的情况乘上 \(3\ ...

- springboot事务的传播行为和隔离级别

springboot事务的传播行为和隔离级别 在springboot中事务的传播行为和隔离级别都是在TransactionDefinition这个接口中定义的 传播行为定义了7种,分别用0-6来表示 ...

- UE4蓝图AI角色制作(四)之Gameplay调试器

8. 寻路网格体和Gameplay调试器 为了及时识别出AI系统中的导航问题,UE4提供了一个工具用来解决这类问题,它叫Gameplay调试器.打开项目设置,在左侧找到"引擎",然 ...