吴裕雄 PYTHON 神经网络——TENSORFLOW 单隐藏层自编码器设计处理MNIST手写数字数据集并使用TensorBord描绘神经网络数据

import os

import numpy as np

import tensorflow as tf

import matplotlib.pyplot as plt

from tensorflow.examples.tutorials.mnist import input_data os.environ['TF_CPP_MIN_LOG_LEVEL'] = '' learning_rate = 0.01 # 学习率

training_epochs = 20 # 训练轮数,1轮等于n_samples/batch_size

batch_size = 128 # batch容量

display_step = 1 # 展示间隔

example_to_show = 10 # 展示图像数目 n_hidden_units = 256

n_input_units = 784

n_output_units = n_input_units def WeightsVariable(n_in, n_out, name_str):

return tf.Variable(tf.random_normal([n_in, n_out]), dtype=tf.float32, name=name_str) def biasesVariable(n_out, name_str):

return tf.Variable(tf.random_normal([n_out]), dtype=tf.float32, name=name_str) def encoder(x_origin, activate_func=tf.nn.sigmoid):

with tf.name_scope('Layer'):

Weights = WeightsVariable(n_input_units, n_hidden_units, 'Weights')

biases = biasesVariable(n_hidden_units, 'biases')

x_code = activate_func(tf.add(tf.matmul(x_origin, Weights), biases))

return x_code def decode(x_code, activate_func=tf.nn.sigmoid):

with tf.name_scope('Layer'):

Weights = WeightsVariable(n_hidden_units, n_output_units, 'Weights')

biases = biasesVariable(n_output_units, 'biases')

x_decode = activate_func(tf.add(tf.matmul(x_code, Weights), biases))

return x_decode with tf.Graph().as_default():

with tf.name_scope('Input'):

X_input = tf.placeholder(tf.float32, [None, n_input_units])

with tf.name_scope('Encode'):

X_code = encoder(X_input)

with tf.name_scope('decode'):

X_decode = decode(X_code)

with tf.name_scope('loss'):

loss = tf.reduce_mean(tf.pow(X_input - X_decode, 2))

with tf.name_scope('train'):

Optimizer = tf.train.RMSPropOptimizer(learning_rate)

train = Optimizer.minimize(loss) init = tf.global_variables_initializer()

writer = tf.summary.FileWriter(logdir='logs', graph=tf.get_default_graph())

writer.flush() learning_rate = 0.01 # 学习率

training_epochs = 20 # 训练轮数,1轮等于n_samples/batch_size

batch_size = 128 # batch容量

display_step = 1 # 展示间隔

example_to_show = 10 # 展示图像数目 n_hidden_units = 256

n_input_units = 784

n_output_units = n_input_units def WeightsVariable(n_in, n_out, name_str):

return tf.Variable(tf.random_normal([n_in, n_out]), dtype=tf.float32, name=name_str) def biasesVariable(n_out, name_str):

return tf.Variable(tf.random_normal([n_out]), dtype=tf.float32, name=name_str) def encoder(x_origin, activate_func=tf.nn.sigmoid):

with tf.name_scope('Layer'):

Weights = WeightsVariable(n_input_units, n_hidden_units, 'Weights')

biases = biasesVariable(n_hidden_units, 'biases')

x_code = activate_func(tf.add(tf.matmul(x_origin, Weights), biases))

return x_code def decode(x_code, activate_func=tf.nn.sigmoid):

with tf.name_scope('Layer'):

Weights = WeightsVariable(n_hidden_units, n_output_units, 'Weights')

biases = biasesVariable(n_output_units, 'biases')

x_decode = activate_func(tf.add(tf.matmul(x_code, Weights), biases))

return x_decode with tf.Graph().as_default():

with tf.name_scope('Input'):

X_input = tf.placeholder(tf.float32, [None, n_input_units])

with tf.name_scope('Encode'):

X_code = encoder(X_input)

with tf.name_scope('decode'):

X_decode = decode(X_code)

with tf.name_scope('loss'):

loss = tf.reduce_mean(tf.pow(X_input - X_decode, 2))

with tf.name_scope('train'):

Optimizer = tf.train.RMSPropOptimizer(learning_rate)

train = Optimizer.minimize(loss)

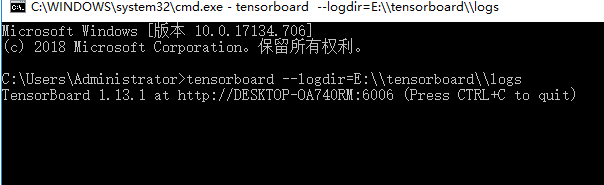

init = tf.global_variables_initializer() writer = tf.summary.FileWriter(logdir='E:\\tensorboard\\logs', graph=tf.get_default_graph())

writer.flush() mnist = input_data.read_data_sets("E:\\MNIST_data\\", one_hot=True) with tf.Session() as sess:

sess.run(init)

total_batch = int(mnist.train.num_examples / batch_size)

for epoch in range(training_epochs):

for i in range(total_batch):

batch_xs, batch_ys = mnist.train.next_batch(batch_size)

_, Loss = sess.run([train, loss], feed_dict={X_input: batch_xs})

Loss = sess.run(loss, feed_dict={X_input: batch_xs})

if epoch % display_step == 0:

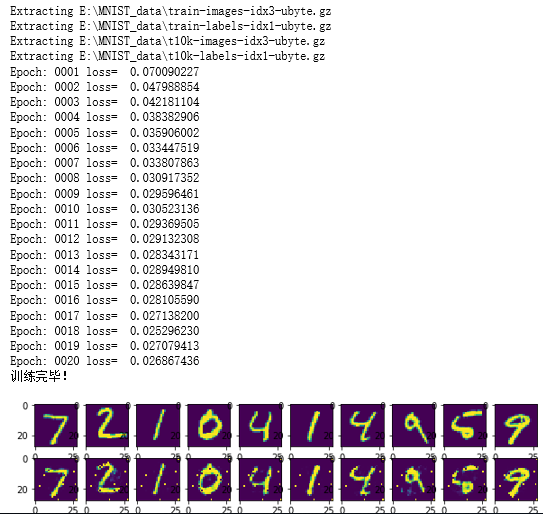

print('Epoch: %04d' % (epoch + 1), 'loss= ', '{:.9f}'.format(Loss))

writer.close()

print('训练完毕!') '''比较输入和输出的图像'''

# 输出图像获取

reconstructions = sess.run(X_decode, feed_dict={X_input: mnist.test.images[:example_to_show]})

# 画布建立

f, a = plt.subplots(2, 10, figsize=(10, 2))

for i in range(example_to_show):

a[0][i].imshow(np.reshape(mnist.test.images[i], (28, 28)))

a[1][i].imshow(np.reshape(reconstructions[i], (28, 28)))

f.show() # 渲染图像

plt.draw() # 刷新图像

# plt.waitforbuttonpress()

吴裕雄 PYTHON 神经网络——TENSORFLOW 单隐藏层自编码器设计处理MNIST手写数字数据集并使用TensorBord描绘神经网络数据的更多相关文章

- 吴裕雄 PYTHON 神经网络——TENSORFLOW 双隐藏层自编码器设计处理MNIST手写数字数据集并使用TENSORBORD描绘神经网络数据2

import os import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data os.envi ...

- Android+TensorFlow+CNN+MNIST 手写数字识别实现

Android+TensorFlow+CNN+MNIST 手写数字识别实现 SkySeraph 2018 Email:skyseraph00#163.com 更多精彩请直接访问SkySeraph个人站 ...

- 基于tensorflow的MNIST手写数字识别(二)--入门篇

http://www.jianshu.com/p/4195577585e6 基于tensorflow的MNIST手写字识别(一)--白话卷积神经网络模型 基于tensorflow的MNIST手写数字识 ...

- TensorFlow——MNIST手写数字识别

MNIST手写数字识别 MNIST数据集介绍和下载:http://yann.lecun.com/exdb/mnist/ 一.数据集介绍: MNIST是一个入门级的计算机视觉数据集 下载下来的数据集 ...

- Tensorflow实现MNIST手写数字识别

之前我们讲了神经网络的起源.单层神经网络.多层神经网络的搭建过程.搭建时要注意到的具体问题.以及解决这些问题的具体方法.本文将通过一个经典的案例:MNIST手写数字识别,以代码的形式来为大家梳理一遍神 ...

- mnist手写数字识别——深度学习入门项目(tensorflow+keras+Sequential模型)

前言 今天记录一下深度学习的另外一个入门项目——<mnist数据集手写数字识别>,这是一个入门必备的学习案例,主要使用了tensorflow下的keras网络结构的Sequential模型 ...

- 用tensorflow搭建RNN(LSTM)进行MNIST 手写数字辨识

用tensorflow搭建RNN(LSTM)进行MNIST 手写数字辨识 循环神经网络RNN相比传统的神经网络在处理序列化数据时更有优势,因为RNN能够将加入上(下)文信息进行考虑.一个简单的RNN如 ...

- Tensorflow可视化MNIST手写数字训练

简述] 我们在学习编程语言时,往往第一个程序就是打印“Hello World”,那么对于人工智能学习系统平台来说,他的“Hello World”小程序就是MNIST手写数字训练了.MNIST是一个手写 ...

- 基于TensorFlow的MNIST手写数字识别-初级

一:MNIST数据集 下载地址 MNIST是一个包含很多手写数字图片的数据集,一共4个二进制压缩文件 分别是test set images,test set labels,training se ...

随机推荐

- Winfrom控件 特效

链接:https://pan.baidu.com/s/1O9e7sxnYFYWD55Vh5fxFQg 提取码:5cey 复制这段内容后打开百度网盘手机App,操作更方便哦 Winfrom控件查询手册. ...

- ASP.NET Razor 语法

主要的 Razor C# 语法规则 Razor 代码块包含在 @{ ... } 中 内联表达式(变量和函数)以 @ 开头 代码语句用分号结束 变量使用 var 关键字声明 字符串用引号括起来 C# 代 ...

- [CCPC2019秦皇岛] E. Escape

[CCPC2019秦皇岛E] Escape Link https://codeforces.com/gym/102361/problem/E Solution 观察到性质若干然后建图跑最大流即可. 我 ...

- ORA-00928: missing SELECT keyword

问题描述 ORA-00928: missing SELECT keyword 问题原因 未写表名

- java-日期取特定值

import java.text.SimpleDateFormat; import java.util.Calendar; import java.util.Date; /** * @author G ...

- Carmichael Numbers (快速幂)

当今计算机科学的一个重要的领域就是密码学.有些人甚至认为密码学是计算机科学中唯一重要的领域,没有密码学生命都没有意义. 阿尔瓦罗就是这样的一个人,它正在设计一个为西班牙杂烩菜饭加密的步骤.他在加 ...

- springmvc 整合 redis

引入依赖 <!--redis--> <dependency> <groupId>redis.clients</groupId> <artifact ...

- 题解 SP27102/UVA1747 【Swap Space】

SP27102 [Swap Space] 双倍经验:UVA1747 Swap Space 用(a,b)表示每个硬盘的原容量和新文件系统下的容量.分两种情况考虑:a≤b和a>b 第一类a≤b格式化 ...

- OmniGraffle原型案例 | 某APP产品原型PDF文件分享之二

1.从 App 首页进入商城 App底部 Tab有社区.商城,我们点击「商城」进入「乐宠商城」,下面简称商城.商城采用的是经典的宫格式导航设计(还有普通列表式.和瀑布流列表式.或两者皆有等),主要有搜 ...

- 题解【CJOJ2608】[JZOJ 100043]第k小数

P2608 - [JZOJ 100043]第k小数 Description 有两个非负整数数列,元素个数分别为N和M.从两个数列中分别任取一个数相乘,这样一共可以得到N*M个数,询问这N*M个数中第K ...