20155223 Exp6 信息收集与漏洞扫描

20155223 Exp6 信息收集与漏洞扫描

本次实验以熟悉信息收集手段与漏洞扫描手段为主。

实践步骤

whois域名查找

在虚拟机Kali的终端输入命令:whois baidu.com,查询百度的域名注册信息。

从截图中我知道百度的域名于1999年10月11日创建,有效期截止至2026年10月11日(有效期27年),百度域名有一个域名服务器和四个NS服务器支持。

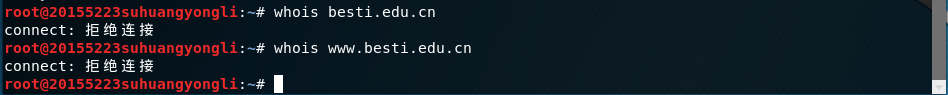

我突然想试试查询学校校网的注册信息!

不给连接?

whois查询方式只对.com、.net、.edu这类域名有效,如果出现.edu.cn这样的域名,会因为域名注册保护措施(视具体域名服务器而定)而无法查询。

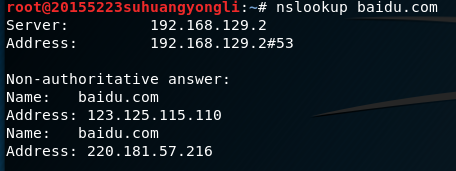

nslookup+dig域名查询

再次以百度网站为例。

输入命令:nslookup baidu.com。

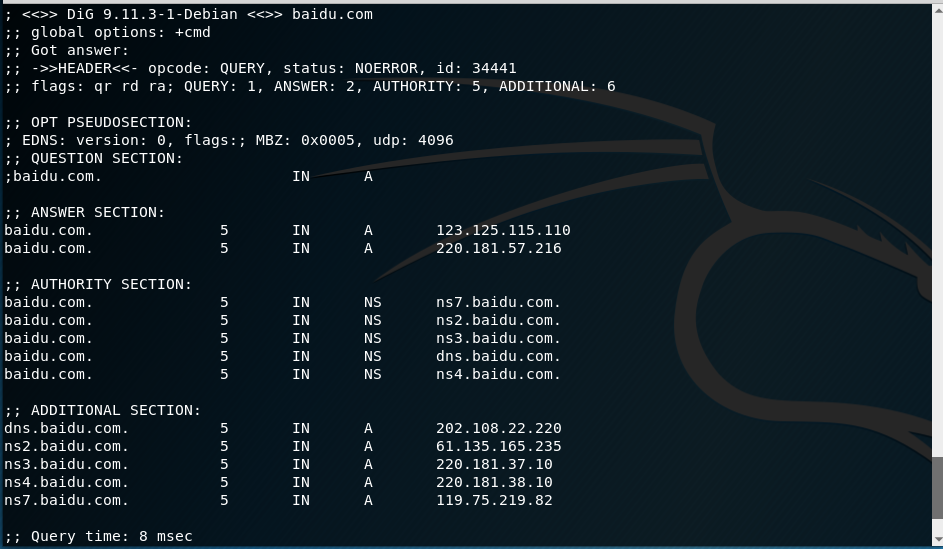

再次输入命令:dig baidu.com。

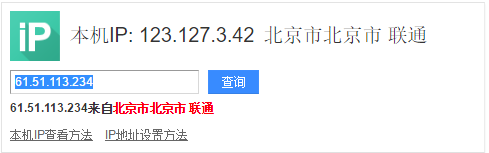

经过查询,所获得的服务器IP地址都在北京市里。

traceroute路由探测

必须注意到的是,如果使用的是虚拟机来启动traceroute,除了第一个IP可以看见之外,其他的都只会显示“ * * * ”,原因可能是之后跳转的数据包的源地址写的不是虚拟机IP地址,而是宿主机的IP地址。

我想看个全的,所以我会在宿主机上开启traceroute。

查询倒数第二和倒数第三的IP:

搜索引擎查询技术

尝试用百度查询:site:edu.cn filetype:pdf 信息隐藏

site:搜索范围限定在特定站点中.如果知道某个站点中有自己需要找的东西,就可以把搜索范围限定在这个站点中,提高查询效率。

filetype:搜索范围限定在指定文档格式中 查询词用Filetype语法可以限定查询词出现在指定的文档中,支持文档格式有pdf,doc,xls,ppt,rtf,all(所有上面的文档格式)。对于找文档资料相当有帮助。

intitle:搜索范围限定在网页标题.网页标题通常是对网页内容提纲挈领式的归纳。把查询内容范围限定在网页标题中,有时能获得良好的效果。

双引号“”和书名号《》精确匹配:查询词加上双引号“”则表示查询词不能被拆分,在搜索结果中必需完整出现,可以对查询词精确匹配。如果不加双引号“”经过百度分析后可能会拆分。

我试试搜索一下这个:site:edu.cn filetype:pdf 越南战争。

要是不仅仅局限于“找文档”,能找其他的就更好了。我才不是想开车!

Kali下的nmap使用

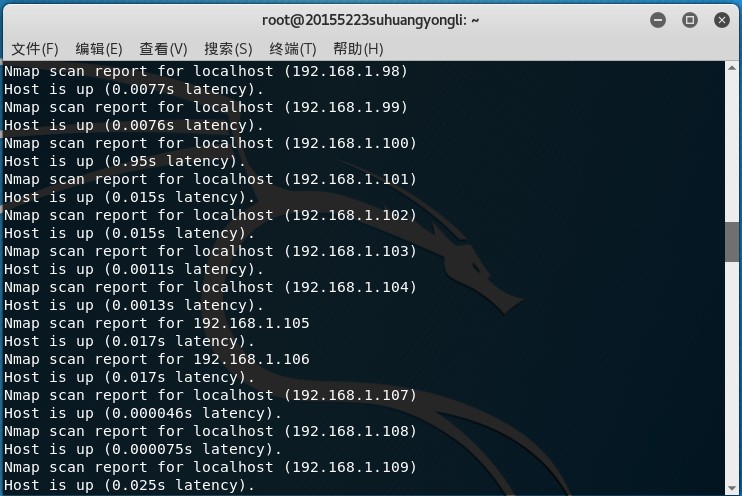

输入命令:nmap -sn 192.168.1.*,我就看看有没有我的主机。

有!

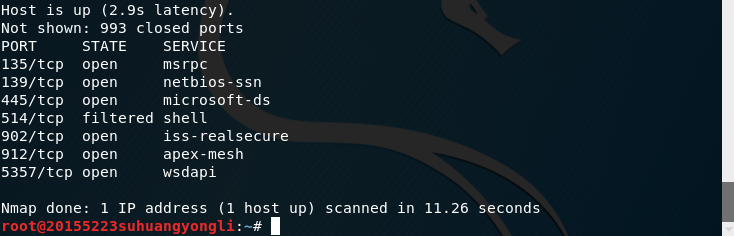

再来,nmap -sS [数据删除],看看我的主机有没有开启TCP服务。

刚刚查了一下,那些被搜索到的端口的确是开放的。冷汗横流.jpg。

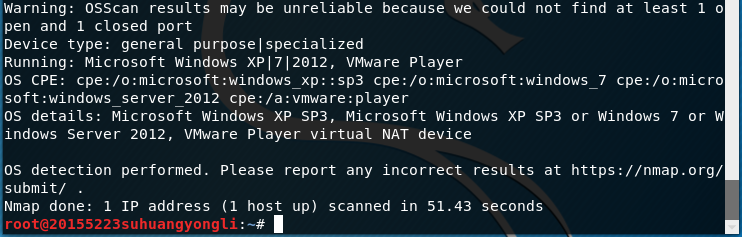

再看看,我刚才搜到的那些主机IP当中那些电脑的操作系统:nmap -O [数据删除]。

别说操作系统了,连虚拟机都可以找出来。

扫描网络

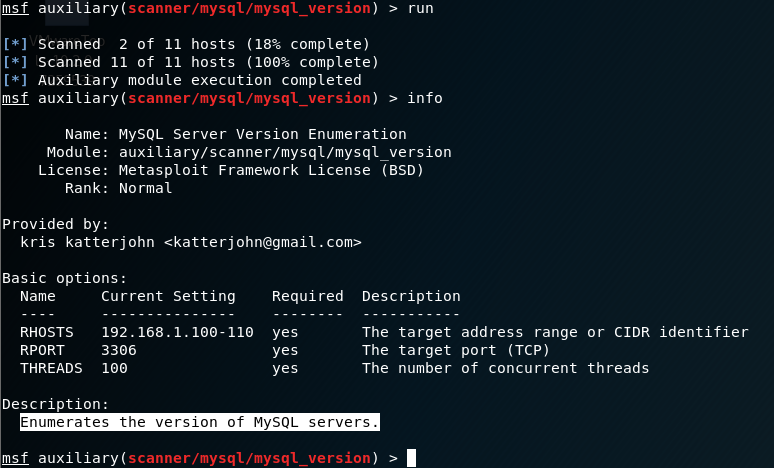

Msfconsole里有扫描网络服务的辅助模块,具体操作略去。

我要试试mysql那个。

这又是一个找服务器的!

漏洞扫描

更新Kali并安装OpenVas,耗时3小时。

随便建立一个账号:openvasmd --user=[数据删除] --new-password=[数据删除]

花费好久我才搞定这个难伺候的漏洞扫描工具。

借助Task Wizard开始扫描,随后是一阵漫长的等待……为什么会占用那么长的时间?我就应该早上做的!

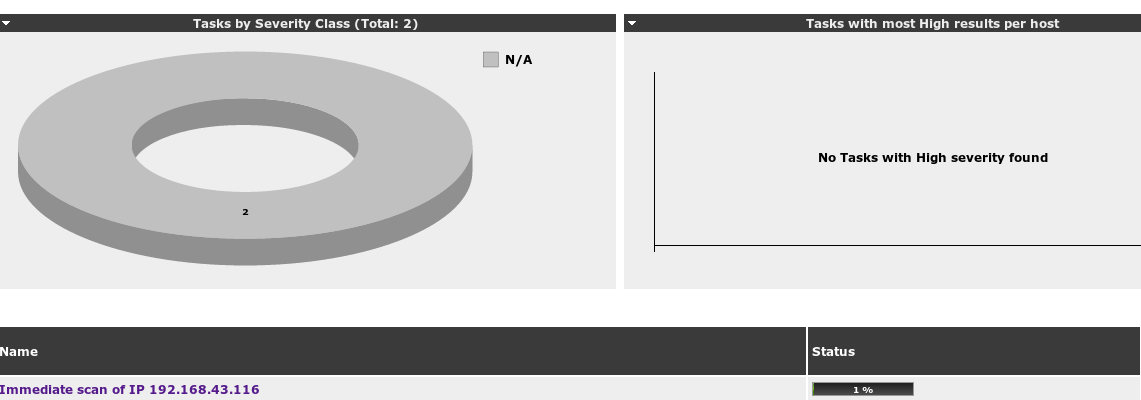

我扫描自己的电脑的结果出来了。

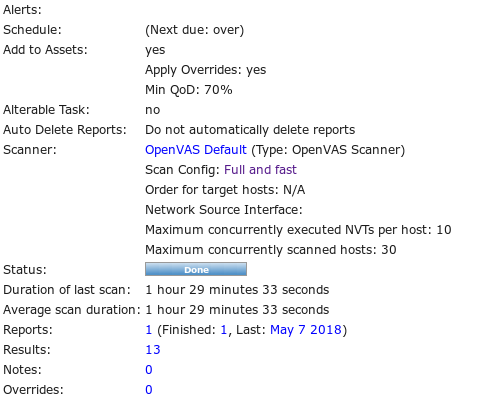

点击Full and Fast查看详细信息。

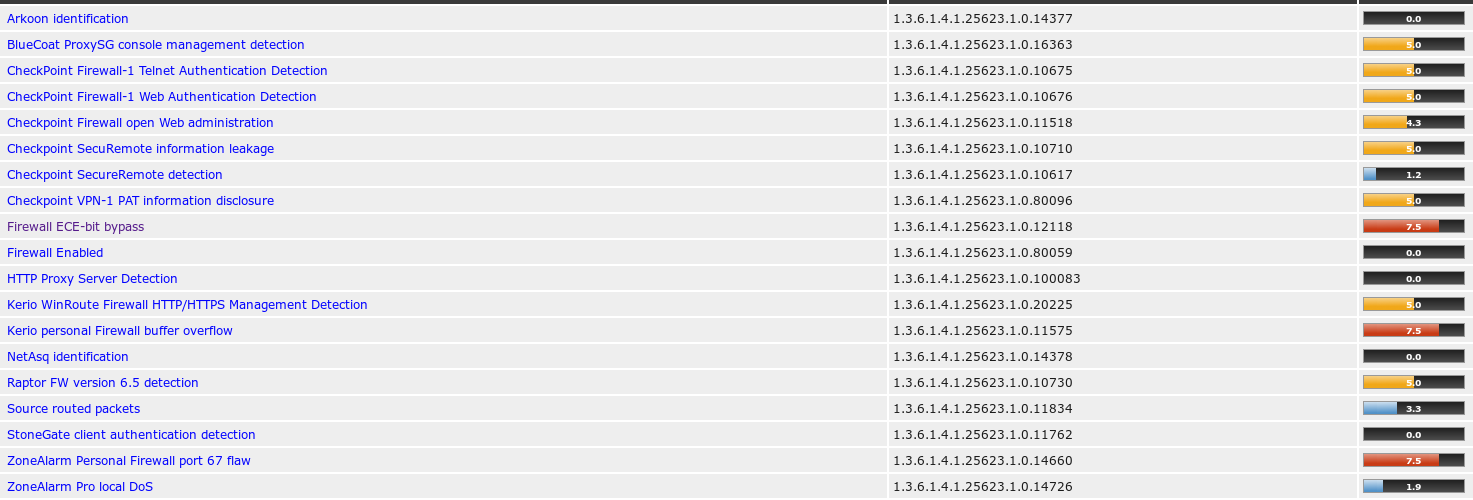

可以看的信息挺多的,我就瞧瞧那个防火墙的就行了。

为什么会有0.0这种东西存在?是很安全还是没开启?

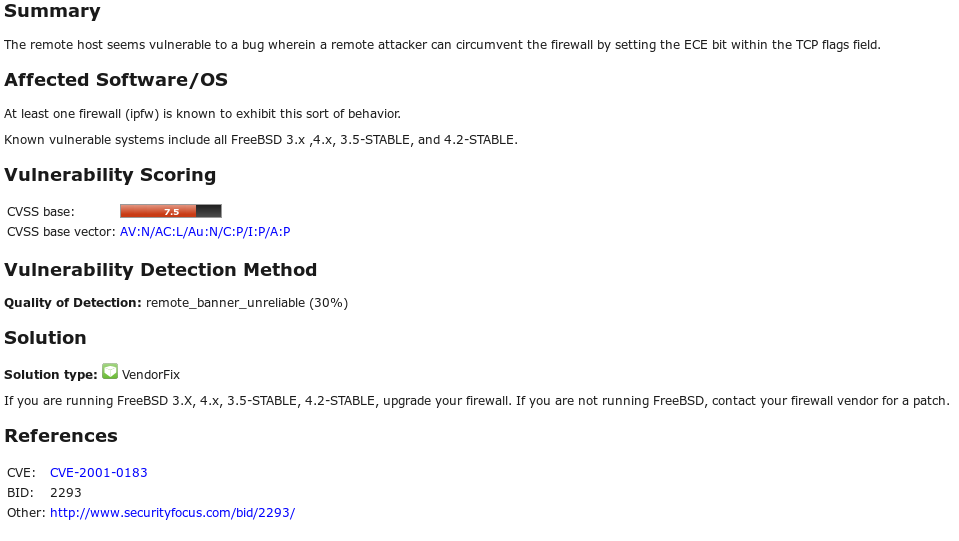

点击第一个红色的漏洞看看。

看来是我的电脑的这个防火墙漏洞可以让远程攻击方通过设置TCP标志域来入侵,可以通过运行reeBSD来保护电脑。

保护我方水晶塔

基础问题

哪些组织负责DNS,IP的管理?

全球根服务器均由美国政府授权的ICANN统一管理,负责全球的域名根服务器、DNS和IP地址管理。

全球根域名服务器:绝大多数在欧洲和北美(全球13台,用A~M编号),中国仅拥有镜像服务器所以我们一定要弄IPv6,一定要在下一轮IP中占领高地。

什么是3R信息?

这三个R:注册人(Registrant) 、注册商(Registrar)、官方注册局(Registry)。

实验感想

为什么这个OpenVas就死活不愿意一次性安装完?

20155223 Exp6 信息收集与漏洞扫描的更多相关文章

- 2018-2019-2 20165205 《网络对抗技术》 Exp6 信息收集与漏洞扫描

2018-2019-2 20165205 <网络对抗技术> Exp6 信息收集与漏洞扫描 实验目标 掌握信息收集的最基本技能与常用工具的方式 实验内容 各种搜索技巧的应用 DNS IP注册 ...

- 20155326刘美岑 Exp6 信息收集与漏洞扫描

20155326刘美岑 Exp6 信息收集与漏洞扫描 实验后回答的问题 (1)哪些组织负责DNS,IP的管理. 全球根服务器均由美国政府授权的ICANN统一管理,负责全球的域名根服务器.DNS和IP地 ...

- 20155202张旭 Exp6 信息收集与漏洞扫描

20155202张旭 Exp6 信息收集与漏洞扫描 一.实践目标与内容 1.实践目标: 掌握信息搜集的最基础技能. 具体有: 各种搜索技巧的应用 DNS IP注册信息的查询 基本的扫描技术:主机发现. ...

- 20155227《网络对抗》Exp6 信息收集与漏洞扫描

20155227<网络对抗>Exp6 信息收集与漏洞扫描 实践目标 掌握信息搜集的最基础技能与常用工具的使用方法. 基础问题回答 哪些组织负责DNS,IP的管理. 全球根服务器均由美国政府 ...

- 20155302《网络对抗》Exp6 信息收集与漏洞扫描

20155302<网络对抗>Exp6 信息收集与漏洞扫描 实验内容 (1)各种搜索技巧的应用 (2)DNS IP注册信息的查询 (3)基本的扫描技术:主机发现.端口扫描.OS及服务版本探测 ...

- 20155310 Exp6 信息收集与漏洞扫描

20155310 Exp6 信息收集与漏洞扫描 基础问题回答 1.哪些组织负责DNS,IP的管理. 顶级的管理者是Internet Corporation for Assigned Names and ...

- 20145233《网络对抗》Exp6 信息收集和漏洞扫描

20145233<网络对抗>Exp6 信息收集和漏洞扫描 实验问题思考 哪些组织负责DNS,IP的管理 全球根服务器均由美国政府授权的ICANN统一管理,负责DNS和IP地址管理.全球一共 ...

- 2018-2019-2 20165114《网络对抗技术》Exp6 信息收集与漏洞扫描

Exp6 信息收集与漏洞扫描 目录 一.实验目标与内容 二.实验后问题回答 三.实验过程记录 3.1 各种搜索技巧的应用 3.2 DNS IP注册信息的查询 3.3 基本的扫描技术 [主机发现] [端 ...

- 20165218 《网络对抗技术》Exp6 信息收集与漏洞扫描

Exp6 信息收集与漏洞扫描 实践过程记录 一.各种搜索技巧的应用 1_搜索网址目录结构 dir_scanner use auxiliary/scanner/http/dir_scanner This ...

随机推荐

- plsql 导出查询结果

点击青色按钮即可 说明: 会将查询到的所有数据导出到指定文件,并不是只导出下面列表显示的几行数据: 也不用点击"获取最后页"那个按钮. 注意: 当你选择导出为excel文件时, ...

- AutoCompleteTextView 自定义提示样式

项目中用到AutoCompleteTextView 自动提示功能,如果用自带的ArrayAdapter就一种样式,非常丑,而且每一项提示文字过多的话不会自动换行. 所以自己自定义了一个适配器. 效果 ...

- 微信小程序开发--背景图显示

这两天开发微信小程序,在设置背景图片时,发现在wxss里面设置 background-image:(url) 属性,不管是开发工具还是线上都无法显示.经过查资料发现,background-image ...

- MySQL——索引实现原理

在MySQL中,索引属于存储引擎级别的概念,不同存储引擎对索引的实现方式是不同的,本文主要讨论MyISAM和InnoDB两个存储引擎的索引实现方式. MyISAM索引实现 MyISAM引擎使用B+Tr ...

- css设计并排布局

css code form#reset_password ul { list-style: none; margin: 0 0 20px 200px; padding:; } form#reset_p ...

- Javascript执行流总结

面对各种各样的JavaScript代码,我们有时候难免会犯错.可当自己仔细研究一下,哦原来是这么回事.有时候怎么会想为什么Javascript程序会是这样执行的呢?为什么没有得到自己预期的答案呢?自己 ...

- JAVAEE——SSH项目实战01:SVN介绍、eclipse插件安装和使用方法

1 学习目标 1.掌握svn服务端.svn客户端.svn eclipse插件安装方法 2.掌握svn的基本使用方法 2 svn介绍 2.1 项目管理中的版本控制问题 通常软件开发由多人协作开发,如果对 ...

- MySQL 支持utf8mb4

utf8mb4 utf8mb3 utf8 Refer to The utf8mb4 Character Set The utf8 Character Set (Alias for utf8mb3) M ...

- python爬虫_入门_翻页

写出来的爬虫,肯定不能只在一个页面爬,只要要爬几个页面,甚至一个网站,这时候就需要用到翻页了 其实翻页很简单,还是这个页面http://bbs.fengniao.com/forum/10384633. ...

- [Spark RDD_add_1] groupByKey & reduceBykey 的区别

[groupByKey & reduceBykey 的区别] 在都能实现相同功能的情况下优先使用 reduceBykey Combine 是为了减少网络负载 1. groupByKey 是没有 ...