带宽优化新思路:RoCE网卡聚合实现X2增长

本文分享自华为云社区《2个RoCE网卡Bond聚合,实现带宽X2》,作者: tsjsdbd 。

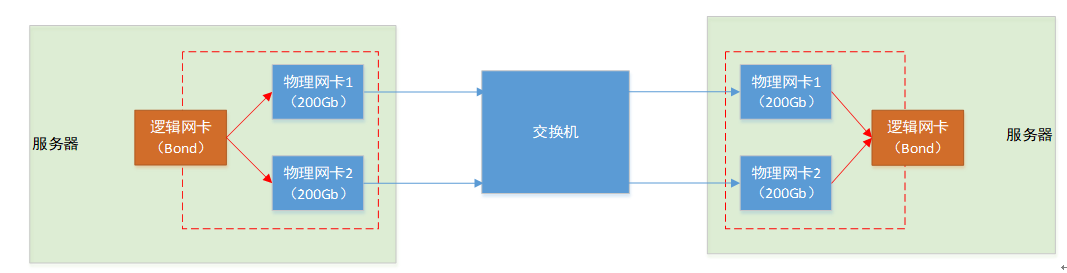

我们知道操作系统里面,可以将2个实际的物理网卡,合体形成一个“逻辑网卡”,从而达到如主备/提升带宽等目的。但是RoCE网卡,是否也跟普通网卡一样,支持Bond能力呢?答案是的,RoCE也可以组Bond,只是比普通网卡多了一些约束。

今天我们就来实际操作一下这个过程,并了解其中需要注意的地方。也欢迎一起交流学习。

一、RoCE网卡链路聚合(LAG)

根据找到的资料:https://mellanox.my.site.com/mellanoxcommunity/s/article/How-to-Configure-RoCE-over-LAG-ConnectX-4-ConnectX-5-ConnectX-6 里面说的,RoCE网卡的Bond,只支持3种模式:

- 模式1(主备)

- 模式2(负载均衡)

- 模式4(链路聚合)

相比普通网卡总共0-6共七种模式而言,算是打了大折。好在我们想要的“提升带宽”的模式还是有的。

二、服务器执行双网卡聚合(Bond)操作

不同的操作系统,执行Bond的命令不一样。这里我实际操作的是Ubuntu22.04,使用自带的 netplan工具,执行bond过程如下:

修改:

vi /etc/netplan/00-installer-config.yaml

network:

ethernets:

ens3f0np0

dhcp4: no

ens3f1np1

dhcp4: no

version: 2

renderer: networkd

bonds:

bond0:

interfaces: [ens3f0np0, ens3f1np1]

parameters:

mode: 802.3ad

mii-monitor-interval: 1

lacp-rate: faset

transmit-hash-policy: layer3+4

addresses: [10.10.2.20/24]

执行:

netplan apply

后,就可以看到一个叫“bond0”的网卡了。

这里,咱们配置的bond里面有2个重要的参数:

(1)选择bond模式4,即802.3ad(链路聚合)

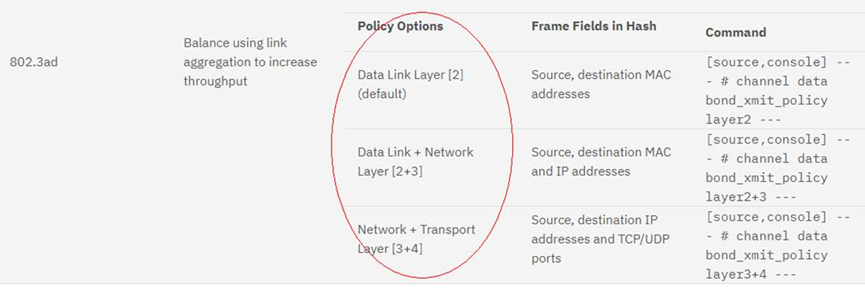

(2)transmit-hash-policy,负载均衡策略,有以下3种值:

这里由于RDMA点对点通信的时候,IP+MAC地址都不会变。所以咱选 layer3+4,毕竟发送报文的时候,源端口还是随机的。

附CentOS的操作供参考:

新建bond口

nmcli con add type bond ifname tsjbond0 bond.options "mode=2,miimon=100,updelay=100,downdelay=100"

添加子网卡

nmcli con add type ethernet ifname enp80s0f0 master tsjbond0

nmcli con add type ethernet ifname enp80s0f1 master tsjbond0

激活子网卡

nmcli con up bond-slave-enp80s0f0

nmcli con up bond-slave-enp80s0f1

修改了bond卡的配置

vi /etc/sysconfig/network-scripts/ifcfg-bond-tsjbond0

IPADDR=29.28.195.228

NETMASK=255.255.240.0

修改2子网卡配置

vi /etc/sysconfig/network-scripts/ifcfg-enp80s0f0

DEVICE=enp80s0f0

TYPE=Ethernet

ONBOOT=yes

MASTER= tsjbond0

SLAVE=yes

BOOTPROTO=none

激活bond卡

ifup bond-slave-enp80s0f0

ifup bond-slave-enp80s0f1

ifdown bond-tsjbond0

ifup bond-tsjbond0

三、服务器为新网卡开启PFC流控

执行如下命令,首先设置MTU:

ifconfig bond0 mtu 4200

然后开启队列4的pfc流控策略:

mlnx_qos -i ens3f0np0 --pfc=0,0,0,0,1,0,0,0 --turst=dscp

mlnx_qos -i ens3f1np1 --pfc=0,0,0,0,1,0,0,0 --turst=dscp

cma_roce_mode -d mlx5_bond_0 -p 1 -m 2

echo 128 > /sys/class/infiniband/mlx5_bond_0/tc/1/traffic_class

其中,前2条命令需要分别为bond下的各个子网卡开启pfc。

然后,mlx5_bond_0 可以通过 ibdev2netdev 命令查询得到。

最后一条echo 128命令,是指强制网卡发送的报文的Traffic Class为128,即匹配网卡发送队列4。不设置的话也行,可以通过 NCCL_IB_TC=128 达成相同的目的。详细可以参考《为什么华为云上AI训练必须设置NCCL_IB_TC=128》一文。

四、交换机执行双网口聚合(LACP)

不同的交换机开启LACP模式的命令不一样,这里型号是 CE9860。执行如下:

开启eth-trunk口。

interface Eth-Trunk1

port link-type trunk

mode lacp-static

然后切换到对应的网口,使其加入到这个trunk口。

interface GigabitEthernet0/0/1

eth-trunk 1 interface GigabitEthernet0/0/2

eth-trunk 1

命令操作基本这个思路,另外,LACP的LB策略,是通过修改 load-balance profile default配置完成的:

eth-trunk hash-mode ?

INTEGER<1-9> Different hash mode provide different load distribution result for egress traffic flows from a trunk, the default is 1

For Eth-Trunk, mode 1 is suggested

For SMAC change, mode 1/2/6/7 is suggested

For SIP change, mode 1/5/7/9 is suggested

For DIP change, mode 5/6 is suggested

For DMAC&SMAC change, mode 9 is suggested

For SMAC+SIP change, mode 5/6 is suggested

默认值是1。

五、交换机为对应端口开启PFC流控

交换机上执行:

qos buffer headroom-pool size 20164 cells slot 1

interface 400 x/x/x

trust dscp

dcb pfc enable mode manual

dcb pfc buffer 4 xoff dynamic 4 hdrm 3000 cells

commit

上面的命令,其实除了开启pfc之外,还设置了网口对应的buffer大小。具体参数值大小自己看着办。

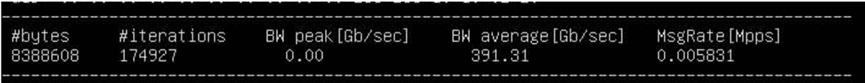

六、RDMA流量带宽测试

这个就是咱们平时经常用的带宽测试命令了:

首先服务器端,启动Server,

ib_write_bw -s 8388608 -F --run_infinitely -x 3 -q 8 --report_gbits

然后Client开始给服务端打流:

ib_write_bw -s 8388608 -F --run_infinitely -x 3 10.10.2.20 -q 8 --report_gbits

其中 -x参数设置为3,是表示使用 RoCE V2协议。

参数 --run_infinitely 可以让测试一直进行而不停止。

-q 表示使用多个QPS(Queue-Pairs)流。对应 NCCL_IB_QPS_PER_CONNECTION,可以尝试设大一点试试效果。

示意的一个结果如下:

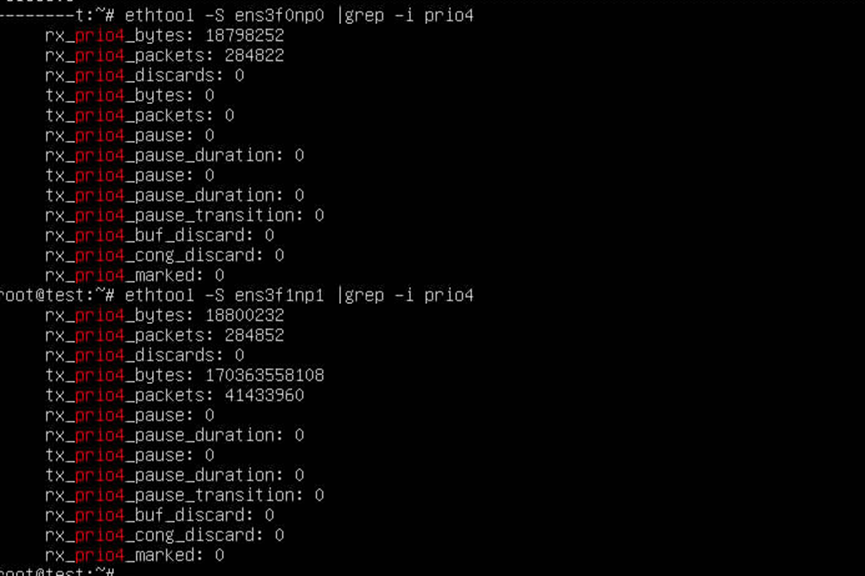

七、服务器端统计信息

查询队列4的报文数量:

watch -n 2 “ethtool -S ens3f0np0 | grep prio4”

这个报文数不会减少,清零不方便,好像重启服务器数量也不会清0。

只找到了通过卸载IB模块来达到清空统计数的目的(假如需要的话):

rmmod mlx5_ib

rmmod mlx5_core

modprob mlx5_core

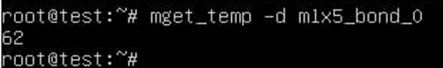

查询网卡温度:

mget_temp -d mlx5_bond_0

可以看到温度,一般都是62/63度左右。

八、小结

本文只是操作记录,用于互相交流,不一定是最佳实践,自己有选择的看。

因为官网https://mellanox.my.site.com/mellanoxcommunity/s/article/How-to-Configure-RoCE-over-LAG-ConnectX-4-ConnectX-5-ConnectX-6

这么写的:

带宽优化新思路:RoCE网卡聚合实现X2增长的更多相关文章

- CentOS下多网卡绑定bond/多网卡聚合

网卡bond我直接理解成网卡聚合了,就是把多张网卡虚拟成1张网卡,出口时,这张网卡无论哪个断线都不影响网络,入口时,需要结合交换机的端口聚合功能实现和网卡配置的bond模式进行负载均衡.bond需要在 ...

- CentOS 7使用nmcli配置双网卡聚合

进入CentOS 7以后,网络方面变化比较大,例如eth0不见了,ifconfig不见了,其原因是网络服务全部都由NetworkManager管理了,下面记录下今天下午用nmcli配置的网卡聚合,网络 ...

- Linux网卡聚合时,其中一个网卡有两种配置的解决方法

先来看看: ficonfig 其中第一网卡是ssh使用: 第二个网卡是在Linux 最小化安装后IP的配置(手动获取静态IP地址)这个文章中配置过ip是192.168.1.2:在Linux重命名网卡名 ...

- Linux 网卡聚合

Linux 网卡聚合的类型: 1.broadcast:传输来自所有端口的每个包 2.roundrobin:以轮播方式传输来自每个端口的包 3.activebackup:故障转移运行程序,监视更改并选择 ...

- CentOS下bond网卡聚合与网桥结合

需求:服务器配置bond多网卡聚合,然后KVM需要使用到网桥,那么需要做到网桥绑定到bond网卡上. 实现核心: 1.bond配置参考:https://www.cnblogs.com/EasonJim ...

- 转:CentOS 7使用nmcli配置双网卡聚合LACP

进入CentOS 7以后,网络方面变化比较大,例如eth0不见了,ifconfig不见了,其原因是网络服务全部都由NetworkManager管理了,下面记录下今天下午用nmcli配置的网卡聚合,网络 ...

- Linux物理网卡聚合及桥接

说明: (1).在网卡聚合绑定之前,要先停用NetworkManager服务(或者在网卡中添加参数:NM_CONTROLLED=no),否则系统重启后绑定的IP失效了. # systemctl sto ...

- centos 网卡聚合及Cisco交换机链路聚合

一.配置环境 centos 系统.网卡1口和2口做链路聚合. 交换机网口 6口和7口. 二.服务器操作步骤 centos 6 1.创建一个channel bonding interface #v ...

- PWA 时代的移动端图片优化新思路

图片通常是移动端网页中最占流量的资源.在很多类型的网站中(比如电商.社区),图片占据了网页的大部分空间.优化图片的质量和加载速度成为提高用户体验的重要途径. 传统方案的弊端 目前有一些被广泛应用的方案 ...

- SqlServer数据库优化之添加主键和自增长

今天需要给有500万条数据的表添加主键和自增长列,其中最大的难度在于如何UPDATE这500万多条数据,开始吧! 1.先给表添加一个字段叫ID,并允许空 2.查询表,我想到了使用其中的时间列排序来创建 ...

随机推荐

- JUC同步锁原理

JUC同步锁原理 1.锁的本质 1.什么是锁? 通俗来讲,锁要保证的就是原子性,就是一个代码块不允许多线程同时执行,就是锁.从生活的角度上来说,就比如你要去上厕所,当你在上厕所期间,你会把门锁上, ...

- 前端树形结构图treeShapeStruct,可拖拽移动,点击展开收缩,无限添加子集

快速实现树形结构图,可拖拽移动,点击展开收缩,无限添加子集; 下载完整代码请访问uni-app插件市场地址:https://ext.dcloud.net.cn/plugin?id=12650 效果图如 ...

- 【技术积累】Git中的基础知识【一】

Git是什么?有什么特点? Git是一个分布式版本控制系统,常用于软件开发中的源代码管理.它最初由Linux开发者Linus Torvalds创建,旨在管理Linux内核的开发. Git具有以下特点: ...

- 逍遥自在学C语言 | 指针陷阱-空指针与野指针

前言 在C语言中,指针是一种非常强大和灵活的工具,但同时也容易引发一些问题,其中包括空指针和野指针. 本文将带你了解这两个概念的含义.产生原因以及如何避免它们所导致的问题. 一.人物简介 第一位闪亮登 ...

- Python运维开发之路《编程》

一.编程思想介绍 1.编程范式 编程是程序员用特定的语法+数据结构+算法组成的代码来告诉计算机如何执行任务的过程,一个程序是程序员为了得到一个任务结果而编写的一组指令的集合,正所谓条条大路通罗马,实现 ...

- Java版人脸跟踪三部曲之一:极速体验

欢迎访问我的GitHub 这里分类和汇总了欣宸的全部原创(含配套源码):https://github.com/zq2599/blog_demos 关于<Java版人脸跟踪三部曲>系列 -& ...

- P5752 [NOI1999] 棋盘分割题解

本文来自我的洛谷博客. 这个题解思路虽然与其他人的思路相同, 但力求使用清晰易懂的图片和文字,讲解最简洁的道理. 请大家耐心地看完,注意要结合图片一起哦~~ 2022-8-24 更改了格式与错别字. ...

- .Net8的AOT引导程序BootStrap

前言 .Net8的本地预编机器码AOT,它几乎进行了100%的自举.微软为了摆脱C++的钳制,做了很多努力.也就是代码几乎是用C#重写,包括了虚拟机,GC,内存模型等等.而需要C++做的,也就仅仅是引 ...

- ASP.NET Core - 日志记录系统(一)

一.日志记录 日志记录是什么?简单而言,就是通过一些方式记录应用程序运行中的某一时刻的状态,保留应用程序当时的信息.这对于我们进行应用程序的分析.审计以及维护有很大的作用. 作为程序员,我们恐怕谁也不 ...

- Lazy(Func<T>)的异常缓存问题

Lazy可以提供多线程环境下的安全保障,但是用不好也是会跳到坑里. 我这里使用Lazy<t>(Func<T>)来创建一个Lazy实例,然后在需要的地方访问它的Value属性,它 ...