1、web爬虫,requests请求

requests请求,就是用python的requests模块模拟浏览器请求,返回html源码

模拟浏览器请求有两种,一种是不需要用户登录或者验证的请求,一种是需要用户登录或者验证的请求

一、不需要用户登录或者验证的请求

这种比较简单,直接利用requests模块发一个请求即可拿到html源码

#!/usr/bin/env python

# -*- coding:utf8 -*-

import requests #导入模拟浏览器请求模块 http =requests.get(url="http://www.iqiyi.com/") #发送http请求

http.encoding = "utf-8" #http请求编码

neir = http.text #获取http字符串代码

print(neir)

<!DOCTYPE html>

<html>

<head>

<title>抽屉新热榜-聚合每日热门、搞笑、有趣资讯</title>

<meta charset="utf-8" />

<meta name="keywords" content="抽屉新热榜,资讯,段子,图片,公众场合不宜,科技,新闻,节操,搞笑" /> <meta name="description" content="

抽屉新热榜,汇聚每日搞笑段子、热门图片、有趣新闻。它将微博、门户、社区、bbs、社交网站等海量内容聚合在一起,通过用户推荐生成最热榜单。看抽屉新热榜,每日热门、有趣资讯尽收眼底。

" /> <meta name="robots" content="index,follow" />

<meta name="GOOGLEBOT" content="index,follow" />

<meta name="Author" content="搞笑" />

<meta http-equiv="X-UA-Compatible" content="IE=EmulateIE8">

<link type="image/x-icon" href="/images/chouti.ico" rel="icon"/>

<link type="image/x-icon" href="/images/chouti.ico" rel="Shortcut Icon"/>

<link type="image/x-icon" href="/images/chouti.ico" rel="bookmark"/>

<link type="application/opensearchdescription+xml"

二、需要用户登录或者验证的请求

获取这种页面时,我们首先要了解整个登录过程,一般登录过程是,当用户第一次访问时,会自动在浏览器生成cookie文件,当用户输入登录信息后会携带着生成的cookie文件,如果登录信息正确会给这个cookie

授权,授权后以后访问需要登录的页面时携带授权后cookie即可

1、首先访问一下首页,然后查看是否有自动生成cookie

#!/usr/bin/env python

# -*- coding:utf8 -*-

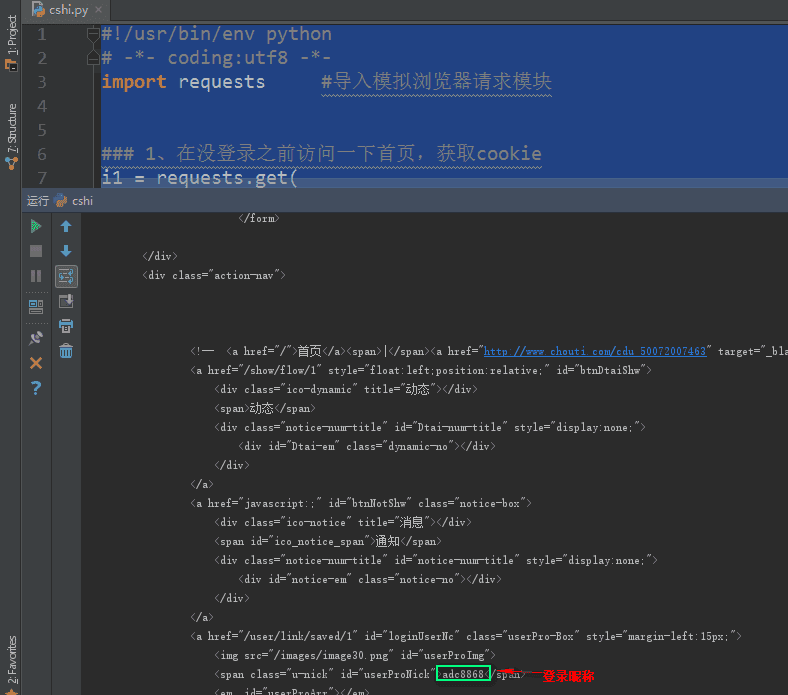

import requests #导入模拟浏览器请求模块 ### 1、在没登录之前访问一下首页,获取cookie

i1 = requests.get(

url="http://dig.chouti.com/",

headers={'Referer': 'http://dig.chouti.com/'}

)

i1.encoding = "utf-8" #http请求编码

i1_cookie = i1.cookies.get_dict()

print(i1_cookie) #返回获取到的cookie

#返回:{'JSESSIONID': 'aaaTztKP-KaGLbX-T6R0v', 'gpsd': 'c227f059746c839a28ab136060fe6ebe', 'route': 'f8b4f4a95eeeb2efcff5fd5e417b8319'}

可以看到生成了cookie,说明如果登陆信息正确,后台会给这里的cookie授权,以后访问需要登录的页面携带授权后的cookie即可

2、让程序自动去登录授权cookie

首先我们用浏览器访问登录页面,随便乱输入一下登录密码和账号,获取登录页面url,和登录所需要的字段

携带cookie登录授权

#!/usr/bin/env python

# -*- coding:utf8 -*-

import requests #导入模拟浏览器请求模块 ### 1、在没登录之前访问一下首页,获取cookie

i1 = requests.get(

url="http://dig.chouti.com/",

headers={'Referer':'http://dig.chouti.com/'}

)

i1.encoding = "utf-8" #http请求编码

i1_cookie = i1.cookies.get_dict()

print(i1_cookie) #返回获取到的cookie

#返回:{'JSESSIONID': 'aaaTztKP-KaGLbX-T6R0v', 'gpsd': 'c227f059746c839a28ab136060fe6ebe', 'route': 'f8b4f4a95eeeb2efcff5fd5e417b8319'} ### 2、用户登陆,携带上一次的cookie,后台对cookie中的随机字符进行授权

i2 = requests.post(

url="http://dig.chouti.com/login", #登录url

data={ #登录字段

'phone': "",

'password': "",

'oneMonth': ""

},

headers={'Referer':'http://dig.chouti.com/'},

cookies=i1_cookie #携带cookie

)

i2.encoding = "utf-8"

dluxxi = i2.text

print(dluxxi) #查看登录后服务器的响应

#返回:{"result":{"code":"9999", "message":"", "data":{"complateReg":"0","destJid":"cdu_50072007463"}}} 登录成功

3、登录成功后,说明后台已经给cookie授权,这样我们访问需要登录的页面时,携带这个cookie即可,比如获取个人中心

#!/usr/bin/env python

# -*- coding:utf8 -*-

import requests #导入模拟浏览器请求模块 ### 1、在没登录之前访问一下首页,获取cookie

i1 = requests.get(

url="http://dig.chouti.com/",

headers={'Referer':'http://dig.chouti.com/'}

)

i1.encoding = "utf-8" #http请求编码

i1_cookie = i1.cookies.get_dict()

print(i1_cookie) #返回获取到的cookie

#返回:{'JSESSIONID': 'aaaTztKP-KaGLbX-T6R0v', 'gpsd': 'c227f059746c839a28ab136060fe6ebe', 'route': 'f8b4f4a95eeeb2efcff5fd5e417b8319'} ### 2、用户登陆,携带上一次的cookie,后台对cookie中的随机字符进行授权

i2 = requests.post(

url="http://dig.chouti.com/login", #登录url

data={ #登录字段

'phone': "",

'password': "",

'oneMonth': ""

},

headers={'Referer':'http://dig.chouti.com/'},

cookies=i1_cookie #携带cookie

)

i2.encoding = "utf-8"

dluxxi = i2.text

print(dluxxi) #查看登录后服务器的响应

#返回:{"result":{"code":"9999", "message":"", "data":{"complateReg":"0","destJid":"cdu_50072007463"}}} 登录成功 ### 3、访问需要登录才能查看的页面,携带着授权后的cookie访问

shouquan_cookie = i1_cookie

i3 = requests.get(

url="http://dig.chouti.com/user/link/saved/1",

headers={'Referer':'http://dig.chouti.com/'},

cookies=shouquan_cookie #携带着授权后的cookie访问

)

i3.encoding = "utf-8"

print(i3.text) #查看需要登录才能查看的页面

获取需要登录页面的html源码成功

全部代码

get()方法,发送get请求

encoding属性,设置请求编码

cookies.get_dict()获取cookies

post()发送post请求

text获取服务器响应信息

搜索887934385交流群免费获取全部源码

1、web爬虫,requests请求的更多相关文章

- Python爬虫requests请求库

requests:pip install request 安装 实例: import requestsurl = 'http://www.baidu.com'response = requests. ...

- 第三百二十二节,web爬虫,requests请求

第三百二十二节,web爬虫,requests请求 requests请求,就是用yhthon的requests模块模拟浏览器请求,返回html源码 模拟浏览器请求有两种,一种是不需要用户登录或者验证的请 ...

- web爬虫,requests请求

requests请求,就是用yhthon的requests模块模拟浏览器请求,返回html源码 模拟浏览器请求有两种,一种是不需要用户登录或者验证的请求,一种是需要用户登录或者验证的请求 一.不需要用 ...

- 一 web爬虫,requests请求

requests请求,就是用python的requests模块模拟浏览器请求,返回html源码 模拟浏览器请求有两种,一种是不需要用户登录或者验证的请求,一种是需要用户登录或者验证的请求 一.不需要用 ...

- 爬虫 Http请求,urllib2获取数据,第三方库requests获取数据,BeautifulSoup处理数据,使用Chrome浏览器开发者工具显示检查网页源代码,json模块的dumps,loads,dump,load方法介绍

爬虫 Http请求,urllib2获取数据,第三方库requests获取数据,BeautifulSoup处理数据,使用Chrome浏览器开发者工具显示检查网页源代码,json模块的dumps,load ...

- 第三百二十七节,web爬虫讲解2—urllib库爬虫—基础使用—超时设置—自动模拟http请求

第三百二十七节,web爬虫讲解2—urllib库爬虫 利用python系统自带的urllib库写简单爬虫 urlopen()获取一个URL的html源码read()读出html源码内容decode(& ...

- 解决爬虫浏览器中General显示 Status Code:304 NOT MODIFIED,而在requests请求时出现403被拦截的情况。

在此,非常感谢 “完美风暴4” 的无私共享经验的精神 在Python爬虫爬取网站时,莫名遇到 浏览器中General显示 Status Code: 304 NOT MODIFIED 而在req ...

- 爬虫(一)—— 请求库(一)requests请求库

目录 requests请求库 爬虫:爬取.解析.存储 一.请求 二.响应 三.简单爬虫 四.requests高级用法 五.session方法(建议使用) 六.selenium模块 requests请求 ...

- 爬虫 http原理,梨视频,github登陆实例,requests请求参数小总结

回顾:http协议基于请求响应的方式,请求:请求首行 请求头{'keys':vales} 请求体 :响应:响应首行,响应头{'keys':'vales'},响应体. import socket soc ...

随机推荐

- .net access config 相对路径

<configuration> <connectionStrings> <add name="ConStr" connectionString=&qu ...

- apache与tomcat的区别

1. Apache是web服务器,Tomcat是应用(java)服务器,它只是一个servlet容器,是Apache的扩展. 2. Apache和Tomcat都可以做为独立的web服务器来运行,但是A ...

- Unity学习路线

转载请标明原文地址:http://www.cnblogs.com/zhangyukof/p/7068615.html 1.Unity下载安装和破解方法: http://blog.sina.com.cn ...

- C# MD5加密字符串

/// <summary> /// 用MD5加密字符串,可选择生成16位或者32位的加密字符串 /// </summary> /// <param name=" ...

- YiluPHP是如何做到不用配置、不用注入就能直接使用所有的类?

使用过YiluPHP的人都会发现,不管是模型类还是逻辑类.辅助类还是工具类,使用所有类都不需要在配置文件中设置加载或注入,也不需要在页面中使用 include 或 require 或 use ,直接使 ...

- 在Windows10中安装与配置Nginx

一.使用环境: Windows 10 1909 nginx 1.16.1 二.安装与配置: 1. 打开链接,http://nginx.org/en/download.html 下载稳定版本nginx ...

- Spring基础——IOC九种bean声明方式

Spring简介 Spring不是服务于开发web项目的功能,或业务.而是服务于项目的开发,方便各层间的解耦调用,方便对类的批量管理,是提高软件开发效率,降低后期维护成本的框架. Spring的核心思 ...

- JS---获取元素计算后的样式属性值 (getComputedStyle)---兼容函数

获取计算后的样式属性----获取一个元素任意一个样式属性值 获取元素距离左边位置的值 会有如下兼容性问题: my$("btn").onclick = function () { / ...

- BIM工程信息管理系统-详细设计

详细设计说明书 1引言 1.1编写目的 编写详细设计说明书的目的就是为程序员写出实际的程序代码提供依据.它是软件详细设计阶段所有任务和所有相关人员所需的参考资料. 1.2背景 说明: a. 软件名称 ...

- JDK1.8新特性-Lambda表达式

Lambda 表达式 Lambda 表达式,也可称为闭包,它是推动 Java 8 发布的最重要新特性. Lambda 允许把函数作为一个方法的参数(函数作为参数传递进方法中). 使用 Lambda 表 ...