spark cogroup算子

java

/**

*cogroup与join算子不同的是如果rdd中的一个key,对应多个value,则返回<Iterable<key>,Iterable<value>>

*@author Tele

*/

public class CogroupDemo {

private static SparkConf conf = new SparkConf().setMaster("local").setAppName("congroupdemo");

private static JavaSparkContext jsc = new JavaSparkContext(conf);

public static void main(String[] args) {

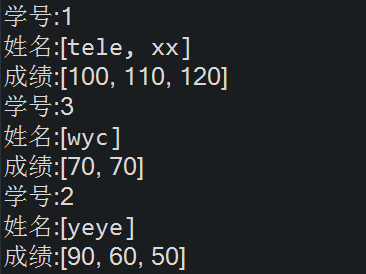

//每个学生有多门成绩

List<Tuple2<Integer,String>> studentList = Arrays.asList(

new Tuple2<Integer,String>(1,"tele"),

new Tuple2<Integer,String>(1,"xx"),

new Tuple2<Integer,String>(2,"yeye"),

new Tuple2<Integer,String>(3,"wyc")

); List<Tuple2<Integer,Integer>> scoreList = Arrays.asList(

new Tuple2<Integer,Integer>(1,100),

new Tuple2<Integer,Integer>(1,110),

new Tuple2<Integer,Integer>(1,120),

new Tuple2<Integer,Integer>(2,90),

new Tuple2<Integer,Integer>(2,60),

new Tuple2<Integer,Integer>(2,50),

new Tuple2<Integer,Integer>(3,70),

new Tuple2<Integer,Integer>(3,70)

); JavaPairRDD<Integer, String> studentRDD = jsc.parallelizePairs(studentList);

JavaPairRDD<Integer, Integer> scoreRDD = jsc.parallelizePairs(scoreList); JavaPairRDD<Integer, Tuple2<Iterable<String>, Iterable<Integer>>> result = studentRDD.cogroup(scoreRDD);

result.foreach(new VoidFunction<Tuple2<Integer,Tuple2<Iterable<String>,Iterable<Integer>>>>() { private static final long serialVersionUID = 1L; @Override

public void call(Tuple2<Integer, Tuple2<Iterable<String>, Iterable<Integer>>> t) throws Exception {

System.out.println("学号:" + t._1);

System.out.println("姓名:" + t._2._1);

System.out.println("成绩:" + t._2._2); /* System.out.print("成绩:[");

t._2._2.forEach(i->System.out.print(i + ","));

System.out.println("]");

System.out.println("====================");*/ }

}); jsc.close();

}

}

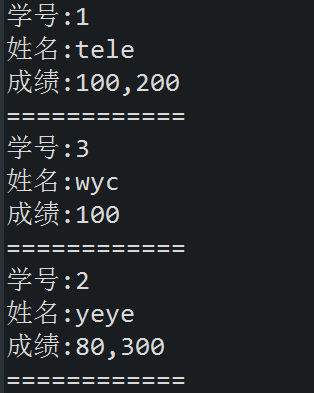

scala

object CogroupDemo {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setMaster("local").setAppName("cogroupdemo");

val sc = new SparkContext(conf);

val studentArr = Array((1,"tele"),(2,"yeye"),(3,"wyc"));

val scoreArr = Array((1,100),(1,200),(2,80),(2,300),(3,100));

val studentRDD = sc.parallelize(studentArr,1);

val scoreRDD = sc.parallelize(scoreArr,1);

val result = studentRDD.cogroup(scoreRDD);

result.foreach(t=>{

println("学号:" + t._1);

println("姓名:" + t._2._1.mkString(" "));

println("成绩:" + t._2._2.mkString(","));

println("============");

})

}

}

spark cogroup算子的更多相关文章

- Spark RDD概念学习系列之Spark的算子的分类(十一)

Spark的算子的分类 从大方向来说,Spark 算子大致可以分为以下两类: 1)Transformation 变换/转换算子:这种变换并不触发提交作业,完成作业中间过程处理. Transformat ...

- Spark常用算子-KeyValue数据类型的算子

package com.test; import java.util.ArrayList; import java.util.List; import java.util.Map; import or ...

- Spark操作算子本质-RDD的容错

Spark操作算子本质-RDD的容错spark模式1.standalone master 资源调度 worker2.yarn resourcemanager 资源调度 nodemanager在一个集群 ...

- Spark RDD概念学习系列之Spark的算子的作用(十四)

Spark的算子的作用 首先,关于spark算子的分类,详细见 http://www.cnblogs.com/zlslch/p/5723857.html 1.Transformation 变换/转换算 ...

- java实现spark常用算子之cogroup

import org.apache.spark.SparkConf;import org.apache.spark.api.java.JavaPairRDD;import org.apache.spa ...

- 列举spark所有算子

一.RDD概述 1.什么是RDD RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可 ...

- spark常用算子总结

算子分为value-transform, key-value-transform, action三种.f是输入给算子的函数,比如lambda x: x**2 常用算子: keys: 取pair rdd ...

- Spark RDD 算子总结

Spark算子总结 算子分类 Transformation(转换) 转换算子 含义 map(func) 返回一个新的RDD,该RDD由每一个输入元素经过func函数转换后组成 filter(func) ...

- Spark 初级算子

#常用Transformation(即转换,延迟加载) #通过并行化scala集合创建RDD val rdd1 = sc.parallelize(Array(1,2,3,4,5,6,7,8)) #查看 ...

随机推荐

- 利用Socket进行大文件传输

分类: WINDOWS 最近接触到利用socket进行大文件传输的技术,有些心得,与大家分享.首先看看这个过程是怎么进行的(如下图): 所以,我们需要三个socket在窗体加载的时候初始化: ...

- ajax获取服务器响应信息

window.onload = function(){ document.getElementById('btn').onclick = function(){ var req = new XMLHt ...

- 知无涯者(The Man Who Knew Infinity)

1913年的1月16号在剑桥大学的三一学院那里,著名的数学家哈代教授收到了一封信,信的开头是这种: "尊敬的先生.仅自我介绍例如以下,我是马德拉斯港务信托处的一个职员,年薪唯独20英镑.23 ...

- Android检测网络状态,判断当前网络是否可用

用户手机当前网络可用:WIFI.2G/3G网络,用户打开与不打开网络,和是否可以用是两码事.可以使用指的是:用户打开网络了并且可以连上互联网进行上网. 检测当前网络是否可用,代码如下: /** * 检 ...

- 接口如何使用(以笑话大全api为例)

接口如何使用(以笑话大全api为例) 一.总结 一句话总结:直接用ajax,或者post,get方式向接口网址请求数据,然后接收网站传过来的数据就好,和我们写网站的时候前台向后台请求数据的方式一样. ...

- TransE论文剩余部分

4.3链接预測 表3:链接预測结果.不同方法的性能. 整体结果 表3显示了全部数据集全部方法的比較. 与预期结果一致,经过过滤设置的结果具有较低的平均排名和较高的hits@10,相信在链接预測方面对各 ...

- 3、应用层常用lib函数使用说明

1.mmap函数 void* mmap(void* start,size_t length,int prot,int flags,int fd,off_t offset); start:映射区的开始地 ...

- [TypeScript] Define a function type

type DigitValidator = (char) => boolean; -]{}/.test(char); export const digitValidators: {[key: s ...

- spark提交应用的方法(spark-submit)

参考自:https://spark.apache.org/docs/latest/submitting-applications.html 常见的语法: ./bin/spark-submit \ ...

- 又在折腾cygwin

apt-cyg https://github.com/transcode-open/apt-cyg/blob/master/README.md cygwin 163镜像 http://mirrors. ...