【Spark-core学习之七】 Spark广播变量、累加器

环境

虚拟机:VMware 10

Linux版本:CentOS-6.5-x86_64

客户端:Xshell4

FTP:Xftp4

jdk1.8

scala-2.10.4(依赖jdk1.8)

spark-1.6

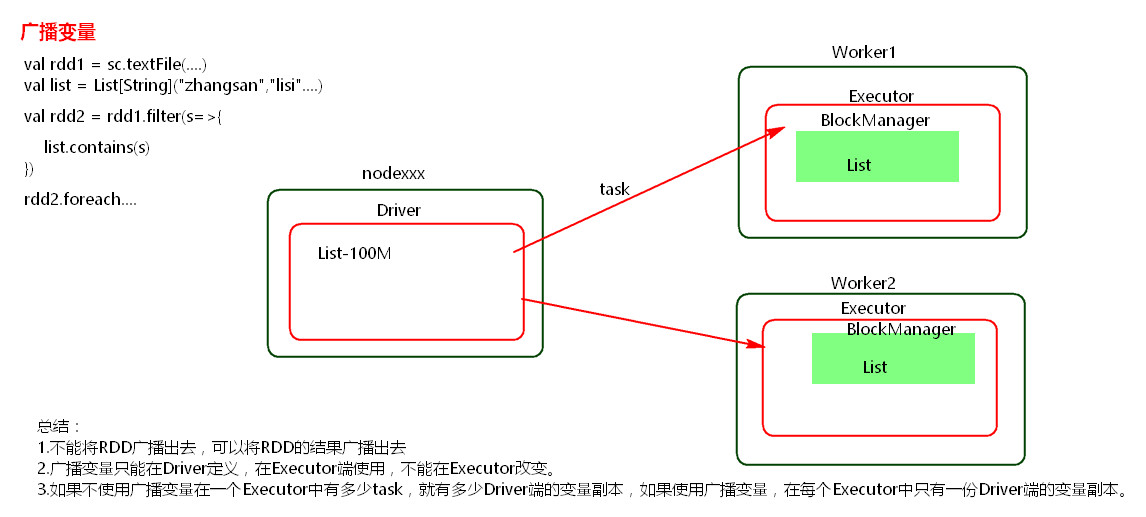

一、广播变量

package com.wjy import org.apache.spark.SparkConf

import org.apache.spark.SparkContext object GuboVal {

def main(args: Array[String]): Unit = {

val conf = new SparkConf();

conf.setMaster("local").setAppName("broadcast");

val sc= new SparkContext(conf); val list = List("hello wjy");

val broadcast = sc.broadcast(list);//定义一个广播变量 val linesRDD = sc.textFile("./data/words.txt");

//广播变量可以在excutor使用

linesRDD.filter{x=>broadcast.value.contains(x)}.foreach(println); sc.stop();

}

}

注意:

(1) 能不能将一个RDD使用广播变量广播出去?

不能,因为RDD是不存储数据的。可以将RDD的结果广播出去。

(2)广播变量只能在Driver端定义,不能在Executor端定义。

(3) 在Driver端可以修改广播变量的值,在Executor端无法修改广播变量的值。

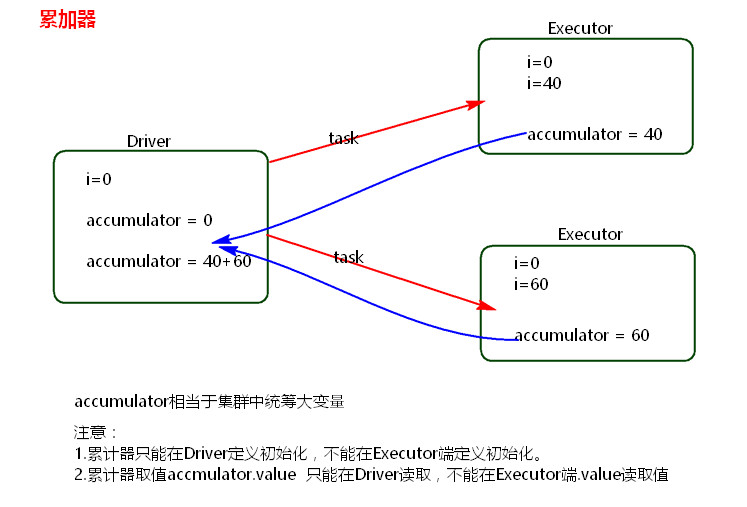

二、累加器

package com.wjy import org.apache.spark.SparkConf

import org.apache.spark.SparkContext object accumulator {

def main(args: Array[String]): Unit = {

val conf =new SparkConf();

conf.setMaster("local").setAppName("accumulator");

val sc = new SparkContext(conf);

//创建累加器 累加器可以是整形 也可以是其他自定义对象

val accumulator = sc.accumulator(0);

//累加器在excutor里累加

sc.textFile("./data/words.txt").foreach(x=>{accumulator.add(1)});

println(accumulator.value); sc.stop();

}

}

注意:

累加器在Driver端定义赋初始值,累加器只能在Driver端读取,在Excutor端更新。

参考:

Spark

【Spark-core学习之七】 Spark广播变量、累加器的更多相关文章

- spark SQL学习(spark连接 mysql)

spark连接mysql(打jar包方式) package wujiadong_sparkSQL import java.util.Properties import org.apache.spark ...

- 【Spark调优】Broadcast广播变量

[业务场景] 在Spark的统计开发过程中,肯定会遇到类似小维表join大业务表的场景,或者需要在算子函数中使用外部变量的场景(尤其是大变量,比如100M以上的大集合),那么此时应该使用Spark的广 ...

- 【spark core学习---算子总结(java版本) (第1部分)】

map算子 flatMap算子 mapParitions算子 filter算子 mapParttionsWithIndex算子 sample算子 distinct算子 groupByKey算子 red ...

- Spark Core源代码分析: Spark任务运行模型

DAGScheduler 面向stage的调度层,为job生成以stage组成的DAG,提交TaskSet给TaskScheduler运行. 每个Stage内,都是独立的tasks,他们共同运行同一个 ...

- Spark Core源代码分析: Spark任务模型

概述 一个Spark的Job分为多个stage,最后一个stage会包含一个或多个ResultTask,前面的stages会包含一个或多个ShuffleMapTasks. ResultTask运行并将 ...

- spark SQL学习(spark连接hive)

spark 读取hive中的数据 scala> import org.apache.spark.sql.hive.HiveContext import org.apache.spark.sql. ...

- Spark RDD持久化、广播变量和累加器

Spark RDD持久化 RDD持久化工作原理 Spark非常重要的一个功能特性就是可以将RDD持久化在内存中.当对RDD执行持久化操作时,每个节点都会将自己操作的RDD的partition持久化到内 ...

- Spark共享变量(广播变量、累加器)

转载自:https://blog.csdn.net/Android_xue/article/details/79780463 Spark两种共享变量:广播变量(broadcast variable)与 ...

- spark累加器、广播变量

一言以蔽之: 累加器就是只写变量 通常就是做事件统计用的 因为rdd是在不同的excutor去执行的 你在不同excutor中累加的结果 没办法汇总到一起 这个时候就需要累加器来帮忙完成 广播变量是只 ...

- Spark 3.x Spark Core详解 & 性能优化

Spark Core 1. 概述 Spark 是一种基于内存的快速.通用.可扩展的大数据分析计算引擎 1.1 Hadoop vs Spark 上面流程对应Hadoop的处理流程,下面对应着Spark的 ...

随机推荐

- swoole推送信息一对一,一对多

服务端 $ws->on('message', function ($ws, $frame) { //echo "接收到的信息: {$frame->data}\n"; / ...

- Mixed Content: xxx This request has been blocked; the content must be served over HTTPS.

在升级https的过程中,出现如下问题: Mixed Content: The page at 'https://www.xxx.com/denglu.html' was loaded over HT ...

- C#实现复杂XML的序列化与反序列化

已知.xml(再此命名default.xml)文件,请将其反序列化到一个实例对象. Default.XML文件如下: <?xml version="1.0" encoding ...

- CentOS6.5 添加开机自启动脚本

有时候我们需要Linux系统在开机的时候自动加载某些脚本或系统服务.在解问题之前先来看看Linux的启动流程. 一.Linux的启动流程 主要顺序就是: 1. 加载内核 2. 启动初始化进程 3. 确 ...

- java模拟http请求(代理ip)

java实现动态切换上网IP (ADSL拨号上网) java动态设置IP java模拟http的Get/Post请求 自动生成IP模拟POST访问后端程序 JAVA 动态替换代理IP并模拟POST

- window下强制删除文件

在windows系统下,有时候总有一下没办法删除的文件,这个时候可以使用一个命令行脚本强行删除 步骤如下: 把以下代码保存为一个delete.txt文件 DEL /F /A /Q \\?\%1 RD ...

- array_rand

array_rand — 从数组中随机取出一个或多个单元 mixed array_rand ( array $array [, int $num = 1 ] ) 从数组中取出一个或多个随机的单元,并返 ...

- JS创建对象的几种方式整理

javascript是一种“基于prototype的面向对象语言“,与java有非常大的区别,无法通过类来创建对象.那么,既然是面象对象的,如何来创建对象呢? 一:通过“字面量”方式创建对象 方法:将 ...

- 创建dblink

创建dblinkcreate database link user1_Link_app--dblink名称----connect to ehl_app ----远程数据库名称----identifie ...

- C++ 中文拼音排序方法。

参考文档:http://zisxks.com/2013/10/25/sort-Chinese-characters-in-cpp/ 采用locate.注意事项:排序的名字,如果出现某一个人,出现在顶上 ...