spark-submit参数说明--on YARN

示例: spark-submit [--option value] <application jar> [application arguments]

|

参数名称 |

含义 |

|

--master MASTER_URL |

yarn |

|

--deploy-mode DEPLOY_MODE |

Driver程序运行的地方:client、cluster |

|

--class CLASS_NAME |

The FQCN of the class containing the main method of the application. For example, org.apache.spark.examples.SparkPi. 应用程序主类名称,含包名 |

|

--name NAME |

应用程序名称 |

|

--jars JARS |

Driver和Executor依赖的第三方jar包 |

|

--properties-file FILE |

应用程序属性的文件路径,默认是conf/spark-defaults.conf |

|

以下设置Driver |

|

|

--driver-cores NUM |

Driver程序使用的CPU核数(只用于cluster),默认为1 |

|

--driver-memory MEM |

Driver程序使用内存大小 |

|

--driver-library-path |

Driver程序的库路径 |

|

--driver-class-path |

Driver程序的类路径 |

|

--driver-java-options |

|

|

以下设置Executor |

|

|

--num-executors NUM |

The total number of YARN containers to allocate for this application. Alternatively, you can use the spark.executor.instances configuration parameter. 启动的executor的数量,默认为2 |

|

--executor-cores NUM |

Number of processor cores to allocate on each executor 每个executor使用的CPU核数,默认为1 |

|

--executor-memory MEM |

The maximum heap size to allocate to each executor. Alternatively, you can use the spark.executor.memory configuration parameter. 每个executor内存大小,默认为1G |

|

--queue QUEUE_NAME |

The YARN queue to submit to. 提交应用程序给哪个YARN的队列,默认是default队列 |

|

--archives ARCHIVES |

|

|

--files FILES |

用逗号隔开的要放置在每个executor工作目录的文件列表 |

1.部署模式概述

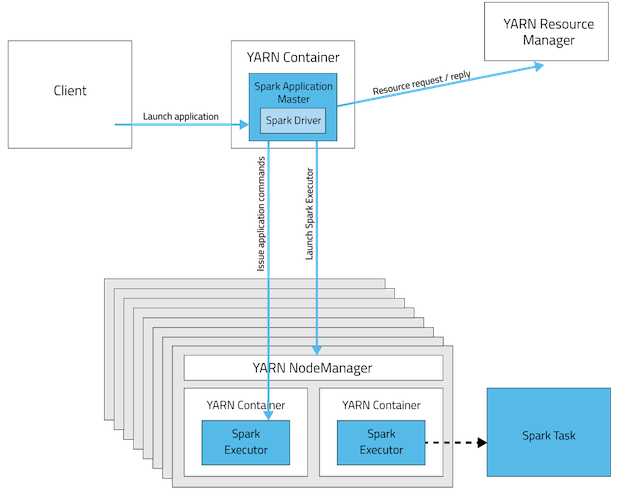

2.部署模式:Cluster

In cluster mode, the driver runs in the ApplicationMaster on a cluster host chosen by YARN.

This means that the same process, which runs in a YARN container, is responsible for both driving the application and requesting resources from YARN.

The client that launches the application doesn't need to continue running for the entire lifetime of the application.

Cluster mode is not well suited to using Spark interactively.

Spark applications that require user input, such as spark-shell and pyspark, need the Spark driver to run inside the client process that initiates the Spark application.

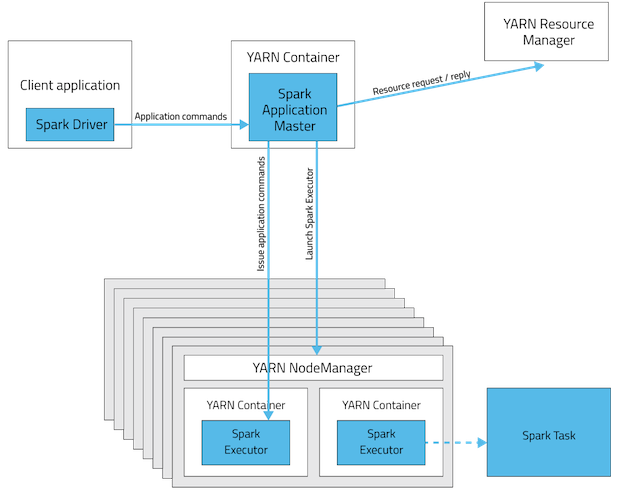

3.部署模式:Client

In client mode, the driver runs on the host where the job is submitted.

The ApplicationMaster is merely present to request executor containers from YARN.

The client communicates with those containers to schedule work after they start:

4.参考文档:

https://www.cloudera.com/documentation/enterprise/5-4-x/topics/cdh_ig_running_spark_on_yarn.html

http://spark.apache.org/docs/1.3.0/running-on-yarn.html

spark-submit参数说明--on YARN的更多相关文章

- spark submit参数及调优

park submit参数介绍 你可以通过spark-submit --help或者spark-shell --help来查看这些参数. 使用格式: ./bin/spark-submit \ ...

- spark submit参数及调优(转载)

spark submit参数介绍 你可以通过spark-submit --help或者spark-shell --help来查看这些参数. 使用格式: ./bin/spark-submit \ -- ...

- Spark On Yarn:提交Spark应用程序到Yarn

转载自:http://lxw1234.com/archives/2015/07/416.htm 关键字:Spark On Yarn.Spark Yarn Cluster.Spark Yarn Clie ...

- 【原创】大数据基础之Spark(1)Spark Submit即Spark任务提交过程

Spark2.1.1 一 Spark Submit本地解析 1.1 现象 提交命令: spark-submit --master local[10] --driver-memory 30g --cla ...

- Spark作业提交至Yarn上执行的 一个异常

(1)控制台Yarn(Cluster模式)打印的异常日志: client token: N/A diagnostics: Application application_1584359 ...

- spark submit local遇到路径hdfs的问题

有时候第一次执行 spark submit --master local[*] 单机模式的时候,可以对linux本地路径进行输出.但是有时候提交到yarn的时候,是自动加上hdfs的路径这没问题, 但 ...

- Spark集群之yarn提交作业优化案例

Spark集群之yarn提交作业优化案例 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.启动Hadoop集群 1>.自定义批量管理脚本 [yinzhengjie@s101 ...

- spark任务提交到yarn上命令总结

spark任务提交到yarn上命令总结 1. 使用spark-submit提交任务 集群模式执行 SparkPi 任务,指定资源使用,指定eventLog目录 spark-submit --class ...

- spark submit参数调优

在开发完Spark作业之后,就该为作业配置合适的资源了.Spark的资源参数,基本都可以在spark-submit命令中作为参数设置.很多Spark初学者,通常不知道该设置哪些必要的参数,以及如何设置 ...

随机推荐

- Java多线程学习之wait、notify/notifyAll 详解

1.wait().notify/notifyAll() 方法是Object的本地final方法,无法被重写. 2.wait()使当前线程阻塞,前提是 必须先获得锁,一般配合synchronized 关 ...

- 函数chdir、fchdir和getcwd

函数chdir.fchdir和getcwd chdir.fchdir函数 每个进程都有一个当前工作目录,当前目录是进程的一个属性 当用户登录UNIX系统时,其当前工作目录通常是口令文件 ...

- 【转】Entity Framework 5.0系列之自动生成Code First代码

在前面的文章中我们提到Entity Framework的“Code First”模式也同样可以基于现有数据库进行开发.今天就让我们一起看一下使用Entity Framework Power Tools ...

- Java 中实现方法重试的一种机制

有这样一个需求,当调用某个方法抛出异常,比如通过 HttpClient 调用远程接口时由于网络原因报 TimeOut 异常:或者所请求的接口返回类似于"处理中"这样的信息,需要重复 ...

- OPENGLES 绘制纹理带黑圈pre-multiplying

1. 问题 在进行 OpenGL 纹理混合的过程中,遇到一个诡异的现象,两个纹理混合的效果出人所料: 将一个ALPHA渐变的[胡须]加在另一张图片上,这个 [胡须]是由外向里逐渐增加透明度的,也就是最 ...

- Thinkphp使用phpexcel导入文件并写入数据库

现实中,我们往往很多地方都需要这样批量导入数据,除了phpexcel还有csv等方法可以解决 下面详细介绍一下使用方法 首先在官方下载安装包解压到本地,然后复制保存到tp框架下的vendor目录下 h ...

- TCP/IP协议栈 --- IP路由

IP路由:当一个IP包在主机发送出去或者在网络当中时,是怎么选择路径到达目的主机的呢? 一般情况下, 如果说源主机和目的主机在同一个网络中的话,那个数据报可以直接到达目的主机而不经过路由器,下面可以试 ...

- openstack集群环境准备

#0.openstack集群环境准备 openstack pike 部署 目录汇总 http://www.cnblogs.com/elvi/p/7613861.html #openstack集群环境准 ...

- C# 使用Task实现任务超时,多任务一起执行

简介:充分使用Task的异步功能代码实现:1.实现了任务超时 退出任务 2.多个任务一起执行 /// <summary> ///做事 需要 ms秒 才能完成 / ...

- 关于pipelineDB调用GetLocalStreamReaders的BUG

如果想获取一个stream所有的reader,那么必须调用这个函数: Bitmapset *targets = GetLocalStreamReaders(relid); 如果stream下面没有re ...