python爬虫--案例分析之针对简单的html文件

python爬虫常用的库:Python 库(urllib、BeautifulSoup、requests、scrapy)实现网页爬虫

python爬虫最简单案例分析: 对一个html文件进行分解,获取里面想要的数据

<html lang="en">

<head>

<meta charset="UTF-8"/>

<title>测试bs4</title>

</head>

<body>

<div>

<p>百里守约</p>

</div> <div class="song">

<p>李清照</p>

<p>王安石</p>

<p>苏轼</p>

<p>柳宗元</p>

<a href="http://www.song.com/" title="赵匡胤" target="_self">

<span>this is span</span>

宋朝是最强大的王朝,不是军队的强大,而是经济很强大,国民都很有钱</a>

<a href="" class="du">总为浮云能蔽日,长安不见使人愁</a>

<img src="http://www.baidu.com/meinv.jpg" alt=""/>

</div> <div class="tang">

<ul>

<li><a href="http://www.baidu.com" title="qing">清明时节雨纷纷,路上行人欲断魂,借问酒家何处有,牧童遥指杏花村</a></li>

<li><a href="http://www.163.com" title="qin">秦时明月汉时关,万里长征人未还,但使龙城飞将在,不教胡马度阴山</a></li>

<li><a href="http://www.126.com" alt="qi">岐王宅里寻常见,崔九堂前几度闻,正是江南好风景,落花时节又逢君</a></li>

<li><a href="http://www.sina.com" class="du">杜甫</a></li>

<li><a href="http://www.dudu.com" class="du">杜牧</a></li>

<li><b>杜小月</b></li>

<li><i>度蜜月</i></li>

<li><a href="http://www.haha.com" id="feng">凤凰台上凤凰游,凤去台空江自流,吴宫花草埋幽径,晋代衣冠成古丘</a></li>

</ul>

</div>

</body>

</html>

import requests

from lxml import etree tree = etree.parse("E:\odoo14\odoo14\myaddons\demo.html") # 获取html文件

tang_info = tree.xpath("//div[@class='tang']/ul/li/a/text()") # 获取标签里的文本

print('tang_info', tang_info)

# "tang_info ['清明时节雨纷纷,路上行人欲断魂,借问酒家何处有,牧童遥指杏花村', '秦时明月汉时关,万里长征人未还,但使龙城飞将在,不教胡马度阴山', '岐王宅里寻常见,崔九堂前几度闻,正是江南好风景,落花时节又逢君', '杜甫', '杜牧', '凤凰台上凤凰游,凤去台空江自流,吴宫花草埋幽径,晋代衣冠成古丘']" song_info = tree.xpath("//div[@class='song']/p/text()") #找到div的class 是song的,标签是p的文本

print('song_info', song_info)

# 结果 "song_info ['李清照', '王安石', '苏轼', '柳宗元']" song_src = tree.xpath("//div[@class='song']/img/@src") #找 到div的class 是song的,的img属性

print('song_src', song_src) # song_src ['http://www.baidu.com/meinv.jpg']

song_src_a = tree.xpath("//div[@class='song']/a/text()")

print('song_src_a', song_src_a)

# song_src_a ['\n ', '\n 宋朝是最强大的王朝,不是军队的强大,而是经济很强大,国民都很有钱', '总为浮云能蔽日,长安不见使人愁']

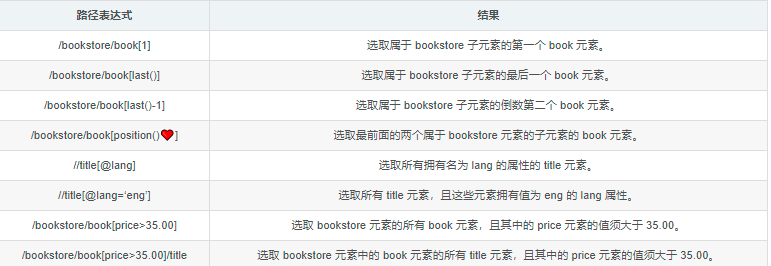

关于xpath路径的写法:XPath(全称XML Path Languang),即XML路径语言,是一种在XML文档中查找信息的语言。

1、/ 表示从根节点选取

2、// 从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置。

3、@ 选取属性 返回所指元素的文本内容。

4、text() 返回所指元素的文本内容

4.1、string() 函数会得到所指元素的所有节点文本内容,这些文本讲会被拼接成一个字符串。

4.3、data():data()函数和string()函数通用,而且不建议经常使用data()函数,有数据表明,该函数会影响XPath的性能。

注意:爬取内容都为数字的时候只能使用data(),不能使用text()或 string(),因为XPath不支持字符串做数学运算。

案例:song_info = tree.xpath("//div[@class='song']/p/text()") #找到div的class 是song的,标签是p的文本

5.查找页面上第一个form元素://form[1]

6.查找页面上id为loginForm的form元素://form[@id=‘loginForm’]

7、/bookstore/book[1] 选取属于 bookstore 子元素的第一个 book 元素。

8、/bookstore/book[last()] 选取属于 bookstore 子元素的最后一个 book 元素。

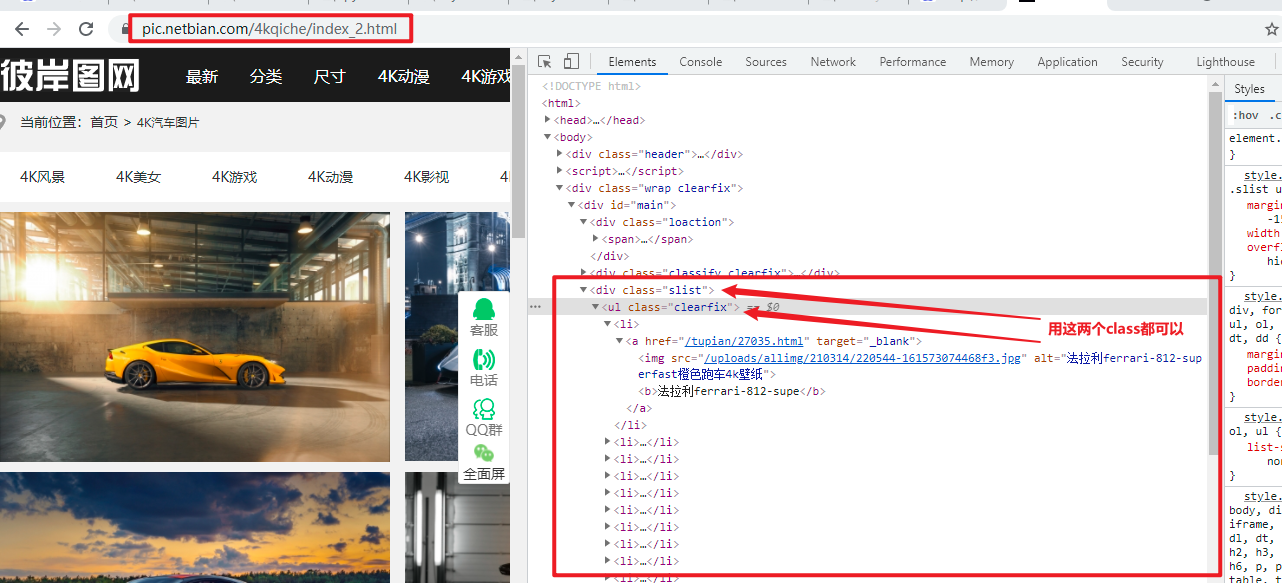

案例2:分析结构:

链接:首页 url = 'http://pic.netbian.com/4kqiche/'

后面分页:url = 'https://pic.netbian.com/4kqiche/index_%s.html' % page

import requests

from lxml import etree headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36'

}

# url = 'http://pic.netbian.com/4kdongman/' for page in range(1, 23):

if page == 1:

url = 'http://pic.netbian.com/4kqiche/'

else:

url = 'https://pic.netbian.com/4kqiche/index_%s.html' % page response = requests.get(url=url, headers=headers)

# response.encoding = 'utf-8' #手动设定响应数据的编码 page_text = response.text # 数据解析(图片地址,图片名称)

tree = etree.HTML(page_text)

# li_list = tree.xpath('//div[@class="slist"]/ul/li')

li_list = tree.xpath('//ul[@class="clearfix"]/li')

print('------------page--------------:', page)

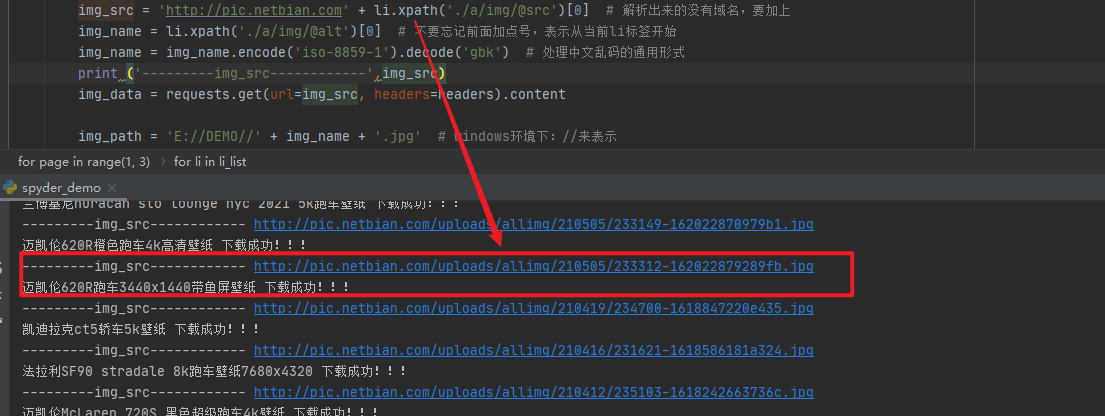

for li in li_list:

# 局部内容解析一定是以./开头。etree和element都可以调用xpath

img_src = 'http://pic.netbian.com' + li.xpath('./a/img/@src')[0] # 解析出来的没有域名,要加上

img_name = li.xpath('./a/img/@alt')[0] # 不要忘记前面加点号,表示从当前li标签开始

img_name = img_name.encode('iso-8859-1').decode('gbk') # 处理中文乱码的通用形式

img_data = requests.get(url=img_src, headers=headers).content img_path = 'E://DEMO//' + img_name + '.jpg' # windows环境下://来表示

with open(img_path, 'wb') as fp:

fp.write(img_data)

print(img_name, '下载成功!!!')

python爬虫--案例分析之针对简单的html文件的更多相关文章

- python爬虫之分析Ajax请求抓取抓取今日头条街拍美图(七)

python爬虫之分析Ajax请求抓取抓取今日头条街拍美图 一.分析网站 1.进入浏览器,搜索今日头条,在搜索栏搜索街拍,然后选择图集这一栏. 2.按F12打开开发者工具,刷新网页,这时网页回弹到综合 ...

- Python爬虫教程-14-爬虫使用filecookiejar保存cookie文件(人人网)

Python爬虫教程-14-爬虫使用filecookiejar保存cookie文件(人人网) 上一篇介绍了利用CookieJar访问人人网,本篇将使用filecookiejar将cookie以文件形式 ...

- 【Python爬虫案例】用Python爬取李子柒B站视频数据

一.视频数据结果 今天是2021.12.7号,前几天用python爬取了李子柒的油管评论并做了数据分析,可移步至: https://www.cnblogs.com/mashukui/p/1622025 ...

- 简单python爬虫案例(爬取慕课网全部实战课程信息)

技术选型 下载器是Requests 解析使用的是正则表达式 效果图: 准备好各个包 # -*- coding: utf-8 -*- import requests #第三方下载器 import re ...

- 【Python爬虫案例学习】分析Ajax请求并抓取今日头条街拍图片

1.抓取索引页内容 利用requests请求目标站点,得到索引网页HTML代码,返回结果. from urllib.parse import urlencode from requests.excep ...

- 【Python爬虫案例学习】python爬取淘宝里的手机报价并以价格排序

第一步: 先分析这个url,"?"后面的都是它的关键字,requests中get函数的关键字的参数是params,post函数的关键字参数是data, 关键字用字典的形式传进去,这 ...

- 【Python爬虫案例学习】Python爬取天涯论坛评论

用到的包有requests - BeautSoup 我爬的是天涯论坛的财经论坛:'http://bbs.tianya.cn/list.jsp?item=develop' 它里面的其中的一个帖子的URL ...

- 【Python爬虫案例学习】下载某图片网站的所有图集

前言 其实很简短就是利用爬虫的第三方库Requests与BeautifulSoup. 其实就几行代码,但希望没有开发基础的人也能一下子看明白,所以大神请绕行. 基本环境配置 python 版本:2.7 ...

- python爬虫案例:使用XPath爬网页图片

用XPath来做一个简单的爬虫,尝试爬取某个贴吧里的所有帖子,并且将该这个帖子里每个楼层发布的图片下载到本地. # -*- coding:utf-8 -*- import urllib import ...

随机推荐

- ThreadLocal源码阅读笔记

功能描述 ThreadLocal解决了访问共享变量的阻塞问题,并且不需要像CAS操作一样牺牲CPU资源,它为每一个线程维护了一个变量副本,每个线程在访问ThrealLocal里面的变量时实际上访问的是 ...

- 【NX二次开发】Block UI 组

设置组及组内成员不可见 this->group->GetProperties()->SetLogical("Show", false); 设置组及组内成员不可操作 ...

- Effective Fusion Factor in FPN for Tiny Object Detection

微小目标检测的FPN有效融合因子 摘要:基于FPN的检测器在一般物体检测方面取得了显著的进步,例如MS COCO和PASCAL VOC.然而,这些检测器在某些应用场景中会失败,例如微小物体检测.在本文 ...

- 面试总被问到HTTP缓存机制及原理?看完你就彻底明白了

前言 Http 缓存机制作为 web 性能优化的重要手段,对于从事 Web 开发的同学们来说,应该是知识体系库中的一个基础环节,同时对于有志成为前端架构师的同学来说是必备的知识技能. 但是对于很多前端 ...

- 【题解】PIZZA 贪心

题目描述 Michael请N个朋友吃馅饼,但是每个朋友吃且仅吃一个馅饼的1/4.1/2或3/4.请你编程求出Michael至少需要买多少个馅饼. 输入输出格式 输入格式: 输入文件的第一行是整数N:接 ...

- unity的安装,配置,及问题

下载unity 在官网下载unity unity有三个版本,个人版免费,pro和专业版收费. 个人版 在导出exe文件时不能去掉水印片头.其他版本可以. 地址[https://store.unity. ...

- 什么是OSI的第7层

1.什么是Internet的第7层? 第7层是指Internet的7层OSI模型的顶层,也称为"应用程序层".这是数据处理的顶层,位于用户与之交互的软件应用程序的表面之下或幕后.例 ...

- 11、文件比较与同步工具(FreeFileSync)

11.1.基本介绍: 1.FreeFileSync是一个用于文件同步的免费开源程序.FreeFileSync通过比较其内容,日期或文件大小上的一个或多个文件夹,然 后根据用户定义的设置同步内容.除了支 ...

- 12.10File类

要点提示:File类包含了获得一个文件/目录的属性,以及对文件/目录进行改名和删除的方法. 在文件系统中,每个文件都存放在一个目录下.绝对文件名,是由文件名和它的完整路径以及驱动器字母组成.例如,c: ...

- Vue 两个字段联合校验典型例子--修改密码

1.前言 本文是前文<Vue Element-ui表单校验规则,你掌握了哪些?>针对多字段联合校验的典型应用. 在修改密码时,一般需要确认两次密码一致,涉及2个属性字段.类似的涉及 ...