4.2:Scrapy爬虫

使用Scrapy框架对网站的内容进行爬取

在桌面处打开终端,并在终端中输入:

scrapy startproject bitNews

cd bitNews/bitNews

修改items文件的内容,输入vim items.py按 i 进行编辑,将其中的代码修改为:

# -*- coding: utf-8 -*-

import scrapy class BitnewsItem(scrapy.Item):

# define the fields for your item here like:

name = scrapy.Field()

pass

按shift+zz 退出。在终端输入:

scrapy genspider bitnews "www.bit.edu.cn"

cd spiders

vim bitnews.py

修改代码为下图所示:

# -*- coding: utf-8 -*-

import scrapy

from bitNews.items import BitnewsItem class BitnewsSpider(scrapy.Spider):

name = 'bitnews'

allowed_domains = ['www.bit.edu.cn']

start_urls = ['http://www.bit.edu.cn/xww/jdgz/index.htm'] def parse(self, response):

items=[]

div = response.xpath("//div[@class='new_con']")

for each in div.xpath("ul/li"):

item=BitnewsItem()

item['name']=each.xpath('a/text()').extract()

items.append(item)

pass

return items

保存退出之后,在终端输入:cd ..

修改settings.py:vim settings.py

找到ROBOTSTXT_OBEY的值改为False:并添加设置如下:

ROBOTSTXT_OBEY=False

FEED_EXPORT_ENCODING = "UTF-8"

保存退出后,终端输入:

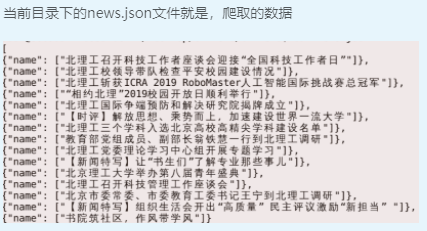

scrapy crawl bitnews -o news.json

4.2:Scrapy爬虫的更多相关文章

- scrapy爬虫结果插入mysql数据库

1.通过工具创建数据库scrapy

- Python之Scrapy爬虫框架安装及简单使用

题记:早已听闻python爬虫框架的大名.近些天学习了下其中的Scrapy爬虫框架,将自己理解的跟大家分享.有表述不当之处,望大神们斧正. 一.初窥Scrapy Scrapy是一个为了爬取网站数据,提 ...

- Linux搭建Scrapy爬虫集成开发环境

安装Python 下载地址:http://www.python.org/, Python 有 Python 2 和 Python 3 两个版本, 语法有些区别,ubuntu上自带了python2.7. ...

- Scrapy 爬虫

Scrapy 爬虫 使用指南 完全教程 scrapy note command 全局命令: startproject :在 project_name 文件夹下创建一个名为 project_name ...

- [Python爬虫] scrapy爬虫系列 <一>.安装及入门介绍

前面介绍了很多Selenium基于自动测试的Python爬虫程序,主要利用它的xpath语句,通过分析网页DOM树结构进行爬取内容,同时可以结合Phantomjs模拟浏览器进行鼠标或键盘操作.但是,更 ...

- 同时运行多个scrapy爬虫的几种方法(自定义scrapy项目命令)

试想一下,前面做的实验和例子都只有一个spider.然而,现实的开发的爬虫肯定不止一个.既然这样,那么就会有如下几个问题:1.在同一个项目中怎么创建多个爬虫的呢?2.多个爬虫的时候是怎么将他们运行起来 ...

- 如何让你的scrapy爬虫不再被ban之二(利用第三方平台crawlera做scrapy爬虫防屏蔽)

我们在做scrapy爬虫的时候,爬虫经常被ban是常态.然而前面的文章如何让你的scrapy爬虫不再被ban,介绍了scrapy爬虫防屏蔽的各种策略组合.前面采用的是禁用cookies.动态设置use ...

- 如何让你的scrapy爬虫不再被ban

前面用scrapy编写爬虫抓取了自己博客的内容并保存成json格式的数据(scrapy爬虫成长日记之创建工程-抽取数据-保存为json格式的数据)和写入数据库(scrapy爬虫成长日记之将抓取内容写入 ...

- scrapy爬虫成长日记之将抓取内容写入mysql数据库

前面小试了一下scrapy抓取博客园的博客(您可在此查看scrapy爬虫成长日记之创建工程-抽取数据-保存为json格式的数据),但是前面抓取的数据时保存为json格式的文本文件中的.这很显然不满足我 ...

- 【图文详解】scrapy爬虫与动态页面——爬取拉勾网职位信息(2)

上次挖了一个坑,今天终于填上了,还记得之前我们做的拉勾爬虫吗?那时我们实现了一页的爬取,今天让我们再接再厉,实现多页爬取,顺便实现职位和公司的关键词搜索功能. 之前的内容就不再介绍了,不熟悉的请一定要 ...

随机推荐

- ProxySQL监控后端节点

ProxySQL通过Monitor模块监控后端MySQL Server的read_only值来自动调整节点所属的组.所以,在配置读.写组之前,必须先配置好监控. 首先看下Monitor库中的表: ad ...

- 0-mysql数据库下载及安装

1 下载mysql源安装包 wget http://dev.mysql.com/get/mysql57-community-release-el7-8.noarch.rpm 2 安装mysql源 yu ...

- 请求库之requests库

目录 一.介绍 二.基于get请求 1 基本请求 2 带参数的get请求 3 请求携带cookie 三.基于post请求 1 基本用法 2 发送post请求,模拟浏览器的登录行为 四.响应Respon ...

- NSIS 检测默认浏览器

#检测默认浏览器 #编写:水晶石 #原理:用FindExecutable函数查找htm关联程序路径与名称,然后分析字串中包含的可执行文件名. !include "LogicLib.nsh&q ...

- Libgdx游戏开发(2)——接水滴游戏实现

原文:Libgdx游戏开发(2)--接水滴游戏实现 - Stars-One的杂货小窝 本文使用Kotlin语言开发 通过本文的学习可以初步了解以下基础知识的使用: Basic file access ...

- 关于Jenkins-Item-Office 365 Connector-下的多选框的参数定义

在Jenkins的Item中Office 365 Connector下,我们有时会使用到,多选框(复选框),目的是可选择多个多个条目赋值给指定的变量 然后在Build Triggers中可以进行引用, ...

- HDU3507 print article (斜率优化DP)

状态表示:dp[i]表示打印前i个单词的最小成本:s[i]维护前缀和. 状态转移:dp[i]=min(dp[j]+(s[i]-s[j])2)+m , 0<=j<i. 换成y=kx+b的形式 ...

- python-绘图与可视化

python 有许多可视化工具,但本书只介绍Matplotlib.Matplotlib是一种2D的绘图库,它可以支持硬拷贝和跨系统的交互,它可以在python脚本,IPython的交互环境下.Web应 ...

- KubeEdge SIG AI发布首个分布式协同AI Benchmark调研

摘要:AI Benchmark旨在衡量AI模型的性能和效能. 本文分享自华为云社区<KubeEdge SIG AI发布首个分布式协同AI Benchmark调研>,作者:KubeEdge ...

- 成功解决:snippet设置的开机自启没有效果

1.问题描述 勾选开机启动后.没有效果.每次开机都要我重新找到对应的安装目录.双击运行开启 2.解决方法 将snipaste的快捷方式放到开机启动目录下 C:\Users\Administrator\ ...