ReLU函数

Rectifier(neural networks)

在人工神经网络中,rectfier(整流器,校正器)是一个激活函数,它的定义是:参数中为正的部分。

其中,x是神经元的输入。这也被称为ramp function(斜坡函数),类似于电气工程中半波整流。

由来:

2000年由Hahnloser et al等人首次将该激活函数引入动态网络中,具有强烈的生物学动机和数学理论。

此激活函数在 convolutional networks中被广泛应用,比logistic sigmoid更有效和实用。

rectfier是2017年深度神经网络中最流行的激活函数。

ReLU:

采用rectifier的单元被称为rectfier linear unit(ReLU)

rectifier的平滑近似是analytic function:

被称为softplus function。它的偏导数是

Rectified linear units在computer vision,speech recognition 等深度神经网络中有广泛应用。

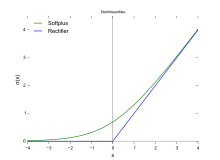

Plot of the rectifier (blue) and softplus (green) functions near x = 0

Variants:

Noisy ReLUs

Rectfier linear units可以被扩展成包含Gaussian noise,

Noisy ReLUs成功应用在一些计算机视觉任务上。

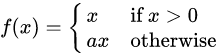

Leaky ReLUs

Leaky ReLUs allow a small, non-zero gradient when the unit is not active.

Parametric ReLUs将coefficient of leakage(泄露系数)转化为与其它神经网络参数一起学习的参数

注意,如果a<=1,那么它等价于

就与maxout networks有关

就与maxout networks有关

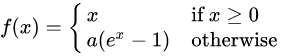

ELUs:

Exponential linear units try to make the mean activations closer to zero which speeds up learning. It has been shown that ELUs can obtain higher classification accuracy than ReLUs

a是需要调的参数,且a>=0

Advantages

请参考

https://en.wikipedia.org/wiki/Rectifier_(neural_networks)

Potential problems

请参考

https://en.wikipedia.org/wiki/Rectifier_(neural_networks)

ReLU函数的更多相关文章

- 神经网络的另一种非线性阶跃函数---ReLU函数

import numpy as np import matplotlib.pylab as plt from matplotlib.font_manager import FontProperties ...

- relu函数为分段线性函数,为什么会增加非线性元素

relu函数为分段线性函数,为什么会增加非线性元素 我们知道激活函数的作用就是为了为神经网络增加非线性因素,使其可以拟合任意的函数.那么relu在大于的时候就是线性函数,如果我们的输出值一直是在大于0 ...

- relu函数是否存在梯度消失问题以及relu函数的死亡节点问题

relu函数是否存在梯度消失问题以及relu函数的死亡节点问题 存在,在小于的时候,激活函数梯度为零,梯度消失,神经元不更新,变成了死亡节点. 出现这个原因可能是因为学习率太大,导致w更新巨大,使得输 ...

- ReLU函数的缺陷

ReLU激活功能并不完美. 它有一个被称为 “ReLU 死区” 的问题:在训练过程中,一些神经元会“死亡”,即它们停止输出 0 以外的任何东西.在某些情况下,你可能会发现你网络的一半神经元已经死亡,特 ...

- CNN卷积层:ReLU函数

卷积层的非线性部分 一.ReLU定义 ReLU:全称 Rectified Linear Units)激活函数 定义 def relu(x): return x if x >0 else 0 #S ...

- python实现并绘制 sigmoid函数,tanh函数,ReLU函数,PReLU函数

Python绘制正余弦函数图像 # -*- coding:utf-8 -*- from matplotlib import pyplot as plt import numpy as np impor ...

- ReLU 函数

线性整流函数(Rectified Linear Unit, ReLU),又称修正线性单元,是一种人工神经网络中常用的激活函数(activation function),通常指代以斜坡函数及其变种 为代 ...

- ReLU激活函数的缺点

训练的时候很”脆弱”,很容易就”die”了,训练过程该函数不适应较大梯度输入,因为在参数更新以后,ReLU的神经元不会再有激活的功能,导致梯度永远都是零. 例如,一个非常大的梯度流过一个 ReLU 神 ...

- 激活函数(ReLU, Swish, Maxout)

神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectified Linear Unit,修正线性单元) 形式如下: \[ \begin{equation} f(x)= \b ...

随机推荐

- 机器学习——提升方法AdaBoost算法,推导过程

0提升的基本方法 对于分类的问题,给定一个训练样本集,求比较粗糙的分类规则(弱分类器)要比求精确的分类的分类规则(强分类器)容易的多.提升的方法就是从弱分类器算法出发,反复学习,得到一系列弱分类器(又 ...

- Fibnoccia 数列简单题

In the Fibonacci integer sequence, F0 = 0, F1 = 1, and Fn = Fn − 1 + Fn − 2 for n ≥ 2. For example, ...

- 类选择器练习:Google 案例

<!DOCTYPE html> <html lang="en"> <head> <meta charset="utf-8&quo ...

- __call__ 方法

对象() 或 类()() 调用 __call__里面的方法 class Call: def __call__(self, *args, **kwargs): print("Hello __c ...

- auth.User.groups: (fields.E304) Reverse accessor for 'User.groups'

创建表,运行下面命令,出错 makemigrations 原因:继承auth_user 解决方案 在settings.py文件添加 AUTH_USER_MODEL = "app名称.类名&q ...

- 如何清理 Docker 占用的磁盘空间

Docker 很占用空间,每当我们运行容器.拉取镜像.部署应用.构建自己的镜像时,我们的磁盘空间会被大量占用. 如果你也被这个问题所困扰,咱们就一起看一下 Docker 是如何使用磁盘空间的,以及如何 ...

- lisp学习总结(一)

lisp太简单 lisp核心太简单了只有几个简单的逻辑定理,简单到你会认为他啥事都做不了. lisp语法太简单了,只有符号,参数,以及括号,组成一种万能的表达式. 由于上述lisp的简单,所以对于初学 ...

- elasticsearch为什么比mysql快

mysql关系型数据库索引原理 数据库的索引是B+tree结构 主键是聚合索引 其他索引是非聚合索引,先从非聚合索引找,见下图 elasticsearch倒排索引原理 两者对比 对于倒排索引,要分两种 ...

- 机器学习-TensorFlow建模过程 Linear Regression线性拟合应用

TensorFlow是咱们机器学习领域非常常用的一个组件,它在数据处理,模型建立,模型验证等等关于机器学习方面的领域都有很好的表现,前面的一节我已经简单介绍了一下TensorFlow里面基础的数据结构 ...

- ASP.Net Core 发布到IIS Http Error 502.5 官方解决办法

Http Error 502.5 - Process Failure 在IIS上发布.NET Core程序出现这个错误.网上搜索到的办法为什么总行不通呢? 有可能年代久远,现在的环境与当年不同,所以解 ...