<强化学习>基于采样迭代优化agent

前面介绍了三种采样求均值的算法

——MC

——TD

——TD(lamda)

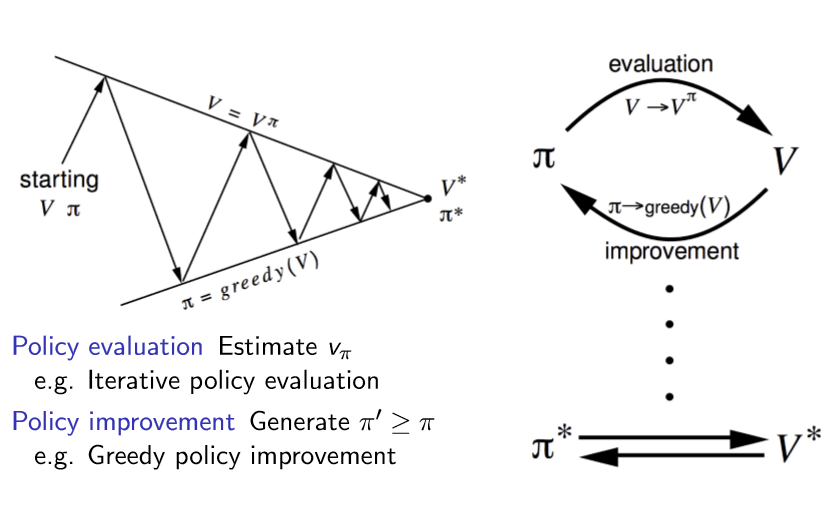

下面我们基于这几种方法来 迭代优化agent

传统的强化学习算法

||

ν

ν

已经知道完整MDP——使用价值函数V(s)

没有给出完整MDP——使用价值函数Q(s,a)

可见我们的目标就是确定下来最优策略和最优价值函数

|

|——有完整MDP && 用DP解决复杂度较低

| ====》 使用贝尔曼方程和贝尔曼最优方程求解

|——没有完整MDP(ENV未知) or 知道MDP但是硬解MDP问题复杂度太高

| ====》 policy evaluation使用采样求均值的方法

| |—— ON-POLICY MC

| |—— ON-POLICY TD

| |____ OFF-POLICY TD

1 价值函数是V(s)还是Q(s,a)?

agent对外界好坏的认识是对什么的认识呢?是每一个状态s的好坏还是特定状态下采取特定行为(s,a)的好坏?

这取决于是什么样的问题背景。

有完整的MDP,知道从这个状态下采取某行为会有多大概率后继状态为某状态,那么我们的agent需要知道的是状态的好坏。如sutton书中的jack‘s car rental问题,方格问题等等,这些都是事先就明确知道状态行为转移概率矩阵的。丝毫没有“人工智能”的感觉。

没有完整的MDP,知道从这个状态下采取某行为会有多大概率后继状态为某状态,那么我们的agent需要知道的是状态行为对(s,a)的好坏。比如,围棋!我们下子之后,对手会把棋落哪是完全没法预测的,所以后继state是绝对不可预测,所以agent是不能用V(s)作为评价好坏的价值函数,所以agent应该在乎的是这个(s,a)好这个(s,a)不好,所以使用Q(s,a)作为价值函数。

2. ON-POLICY 和OFF-POLICY

on policy :基于策略A采样获取episode,并且被迭代优化的策略也是A

off policy :基于策略A采样获取episode,而被迭代优化的策略是B

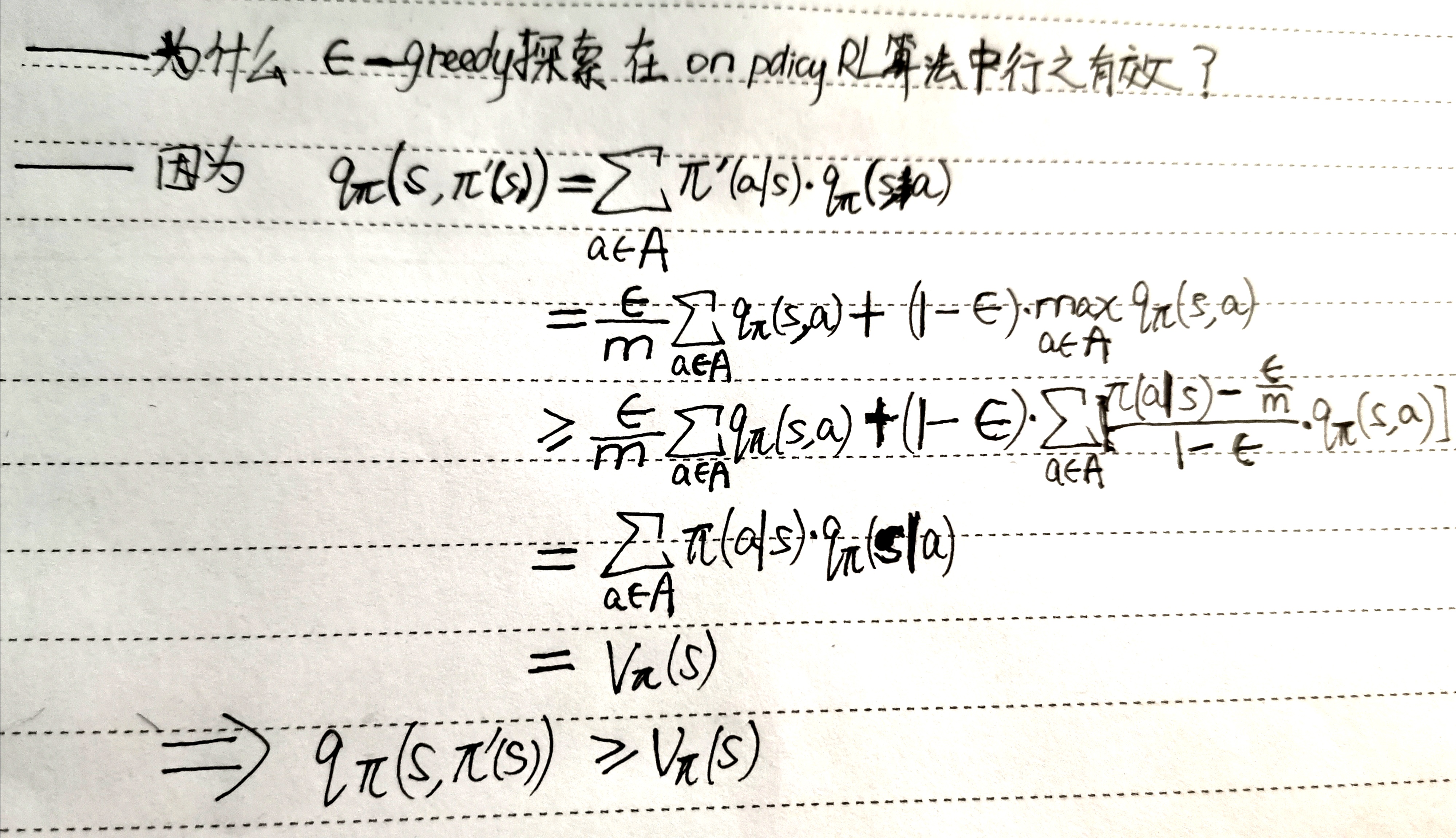

3.为什么ε-greedy探索在on policyRL算法中行之有效?

<强化学习>基于采样迭代优化agent的更多相关文章

- 强化学习之七:Visualizing an Agent’s Thoughts and Actions

本文是对Arthur Juliani在Medium平台发布的强化学习系列教程的个人中文翻译,该翻译是基于个人分享知识的目的进行的,欢迎交流!(This article is my personal t ...

- 强化学习论文(Scalable agent alignment via reward modeling: a research direction)

原文地址: https://arxiv.org/pdf/1811.07871.pdf ======================================================== ...

- 深度学习-强化学习(RL)概述笔记

强化学习(Reinforcement Learning)简介 强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益.其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予 ...

- <强化学习>开门帖

(本系列只用作本人笔记,如果看官是以新手开始学习RL,不建议看我写的笔记昂) 今天是2020年2月7日,开始二刷david silver ulc课程.https://www.youtube.com/w ...

- David Silver强化学习Lecture1:强化学习简介

课件:Lecture 1: Introduction to Reinforcement Learning 视频:David Silver深度强化学习第1课 - 简介 (中文字幕) 强化学习的特征 作为 ...

- 【转载】 准人工智能分享Deep Mind报告 ——AI“元强化学习”

原文地址: https://www.sohu.com/a/231895305_200424 ------------------------------------------------------ ...

- DQN(Deep Q-learning)入门教程(一)之强化学习介绍

什么是强化学习? 强化学习(Reinforcement learning,简称RL)是和监督学习,非监督学习并列的第三种机器学习方法,如下图示: 首先让我们举一个小时候的例子: 你现在在家,有两个动作 ...

- 伯克利、OpenAI等提出基于模型的元策略优化强化学习

基于模型的强化学习方法数据效率高,前景可观.本文提出了一种基于模型的元策略强化学习方法,实践证明,该方法比以前基于模型的方法更能够应对模型缺陷,还能取得与无模型方法相近的性能. 引言 强化学习领域近期 ...

- 基于Keras的OpenAI-gym强化学习的车杆/FlappyBird游戏

强化学习 课程:Q-Learning强化学习(李宏毅).深度强化学习 强化学习是一种允许你创造能从环境中交互学习的AI Agent的机器学习算法,其通过试错来学习.如上图所示,大脑代表AI Agent ...

随机推荐

- 操作系统OS - 同步和异步,阻塞和非阻塞

同步和异步关注的是消息通信机制,阻塞/非阻塞是程序在等待调用结果(消息,返回值)时的状态

- 单链表 C++ 实现 - 含虚拟头节点

本文例程下载链接:ListDemo 链表 vs 数组 链表和数组的最大区别在于链表不支持随机访问,不能像数组那样对任意一个(索引)位置的元素进行访问,而需要从头节点开始,一个一个往后访问直到查找到目标 ...

- C++代码书写规范——给新手程序员的一些建议

代码就是程序员的面子,无论是在工作中在电脑上写程序代码还是在面试时在纸上写演示代码我们都希望写出整洁,优雅的代码.特别在工作中当我们碰到需要维护别人的代码,或者是多人参与一个项目大家一起写代码的时候, ...

- Python基础-1 基础语法

基础语法 标识符 所谓的标识符就是对变量.常量.函数.类等对象起的名字. 首先必须说明的是,Python语言在任何场景都严格区分大小写!也就是说A和a代表的意义完全不同 python对于表示标识符的命 ...

- 3D_solarSys

计算机图形学_3DsolarSys 一.软件功能 1.实现3D太阳系,有太阳.土星.土星环.地球.月球.天王星.海王星.火星.其中土星.地球.天王星.海王星.火星绕着太阳转,土星环绕着土 ...

- SpringBoot + redis + @Cacheable注解实现缓存清除缓存

一.Application启动类添加注解 @EnableCaching 二.注入配置 @Bean public CacheManager cacheManager(RedisTemplate redi ...

- Spring Mvc中Jsp也页面怎么会获取不到Controller中的数据

----------Controller ------- package com.test.mvc; import org.springframework.stereotype.Controller; ...

- Python学习笔记之基础篇(五)字典

#数据类型划分:可变数据类型 不可变数据类型 #不可变数据类型 : 元组 bool int str --> 可哈希 #可变数据类型 list ,dict set --->不可哈希 ''' ...

- python-python基础7

一.静态方法 通过@staticmethod装饰器即可把其装饰的方法变为一个静态方法,什么是静态方法呢?其实不难理解,普通的方法,可以在实例化后直接调用,并且在方法里可以通过self.调用实例变量或类 ...

- Laradock 开放 workspace 端口

1.在 laradock/workspace/Dockerfile 文件的最后添加一行,申明开放端口: EXPOSE 1215; 2.在 laradock/docker-compose ...