Spark应用监控解决方案--使用Prometheus和Grafana监控Spark应用

Spark任务启动后,我们通常都是通过跳板机去Spark UI界面查看对应任务的信息,一旦任务多了之后,这将会是让人头疼的问题。如果能将所有任务信息集中起来监控,那将会是很完美的事情。

通过Spark官网指导文档,发现Spark只支持以下sink

Each instance can report to zero or more sinks. Sinks are contained in the org.apache.spark.metrics.sink package:

ConsoleSink: Logs metrics information to the console.CSVSink: Exports metrics data to CSV files at regular intervals.JmxSink: Registers metrics for viewing in a JMX console.MetricsServlet: Adds a servlet within the existing Spark UI to serve metrics data as JSON data.GraphiteSink: Sends metrics to a Graphite node.Slf4jSink: Sends metrics to slf4j as log entries.StatsdSink: Sends metrics to a StatsD node.

没有比较常用的Influxdb和Prometheus ~~~

谷歌一把发现要支持influxdb需要使用第三方包,比较有参考意义的是这篇,Monitoring Spark Streaming with InfluxDB and Grafana ,在提交任务的时候增加file和配置文件,但成功永远不会这么轻松。。。

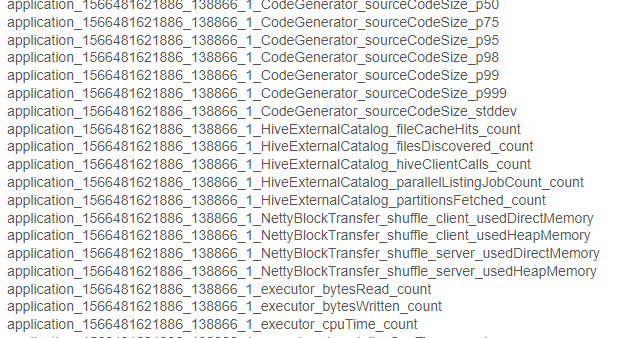

写入influxdb的数据都是以application_id命名的,类似这种application_1533838659288_1030_1_jvm_heap_usage,也就是说每个任务的指标都是在单独的表,最终我们展示在grafana不还得一个一个配置么?

显然这个不是我想要的结果,最终目的就是:一次配置后每提交一个任务自动会在监控上看到。

谷歌是治愈一切的良药,终究找到一个比较完美的解决方案,就是通过graphite_exporter中转数据后接入Prometheus,再通过grafana展示出来。

所以,目前已经实践可行的方案有两个

方案一:

监控数据直接写入influxdb,再通过grafana读取数据做展示,步骤如下:

1.在spark下 conf/metrics.properties 加入以下配置

master.source.jvm.class=org.apache.spark.metrics.source.JvmSource

worker.source.jvm.class=org.apache.spark.metrics.source.JvmSource

driver.source.jvm.class=org.apache.spark.metrics.source.JvmSourc

executor.source.jvm.class=org.apache.spark.metrics.source.JvmSource

*.sink.influx.class=org.apache.spark.metrics.sink.InfluxDbSink

*.sink.influx.protocol=http

*.sink.influx.host=xx.xx.xx.xx

*.sink.influx.port=8086

*.sink.influx.database=sparkonyarn

*.sink.influx.auth=admin:admin

2.在提交任务的时候增加以下配置,并确保以下jar存在

--files /spark/conf/metrics.properties \

--conf spark.metrics.conf=metrics.properties \

--jars /spark/jars/metrics-influxdb-1.1.8.jar,/spark/jars/spark-influx-sink-0.4.0.jar \

--conf spark.driver.extraClassPath=metrics-influxdb-1.1.8.jar:spark-influx-sink-0.4.0.jar \

--conf spark.executor.extraClassPath=metrics-influxdb-1.1.8.jar:spark-influx-sink-0.4.0.jar

缺点:application_id发生变化需要重新配置grafana

方案二(目前在用的):

通过graphite_exporter将原生数据通过映射文件转化为有 label 维度的 Prometheus 数据

1.下载graphite_exporter,解压后执行以下命令,其中graphite_exporter_mapping需要我们自己创建,内容为数据映射文件

nohup ./graphite_exporter --graphite.mapping-config=graphite_exporter_mapping &

例如

mappings:

- match: '*.*.jvm.*.*'

name: jvm_memory_usage

labels:

application: $1

executor_id: $2

mem_type: $3

qty: $4会将数据转化成 metric name 为 jvm_memory_usage,label 为 application,executor_id,mem_type,qty 的格式。

application_1533838659288_1030_1_jvm_heap_usage -> jvm_memory_usage{application="application_1533838659288_1030",executor_id="driver",mem_type="heap",qty="usage"}

2.配置 Prometheus 从 graphite_exporter 获取数据,重启prometheus

/path/to/prometheus/prometheus.ymlscrape_configs:

- job_name: 'spark'

static_configs:

- targets: ['localhost:9108']3.在spark下 conf/metrics.properties 加入以下配置

master.source.jvm.class=org.apache.spark.metrics.source.JvmSource

worker.source.jvm.class=org.apache.spark.metrics.source.JvmSource

driver.source.jvm.class=org.apache.spark.metrics.source.JvmSourc

executor.source.jvm.class=org.apache.spark.metrics.source.JvmSource

*.sink.graphite.class=org.apache.spark.metrics.sink.GraphiteSink

*.sink.graphite.protocol=tcp

*.sink.graphite.host=xx.xx.xx.xx

*.sink.graphite.port=9109

*.sink.graphite.period=5

*.sink.graphite.unit=seconds

4.提交spark任务的时候增加 --files /spark/conf/metrics.properties

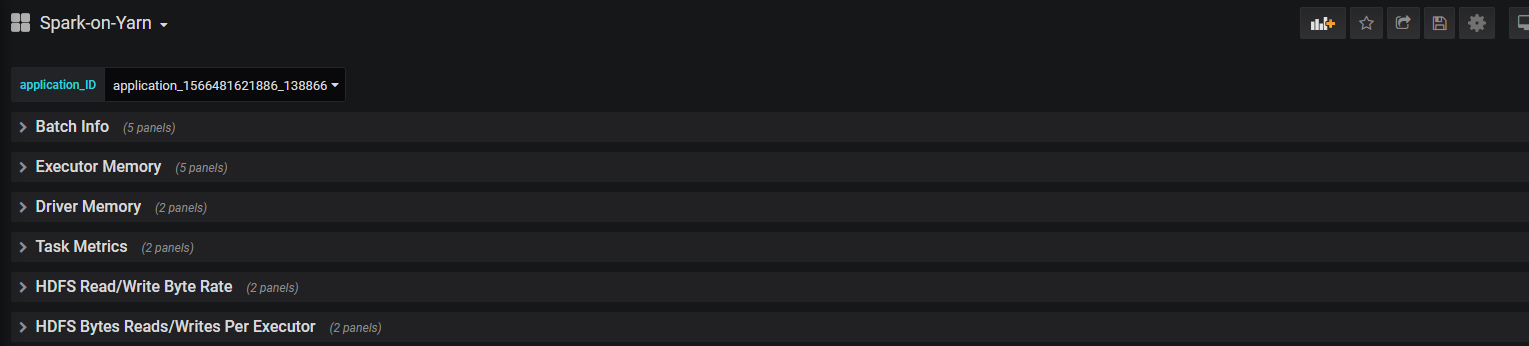

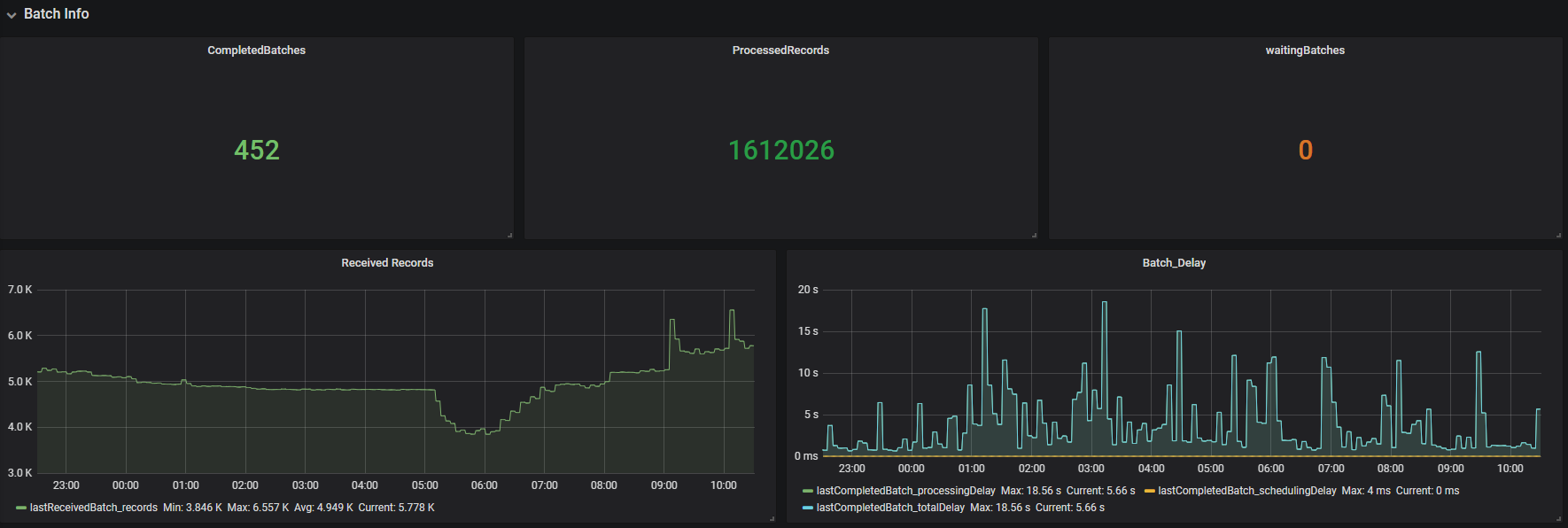

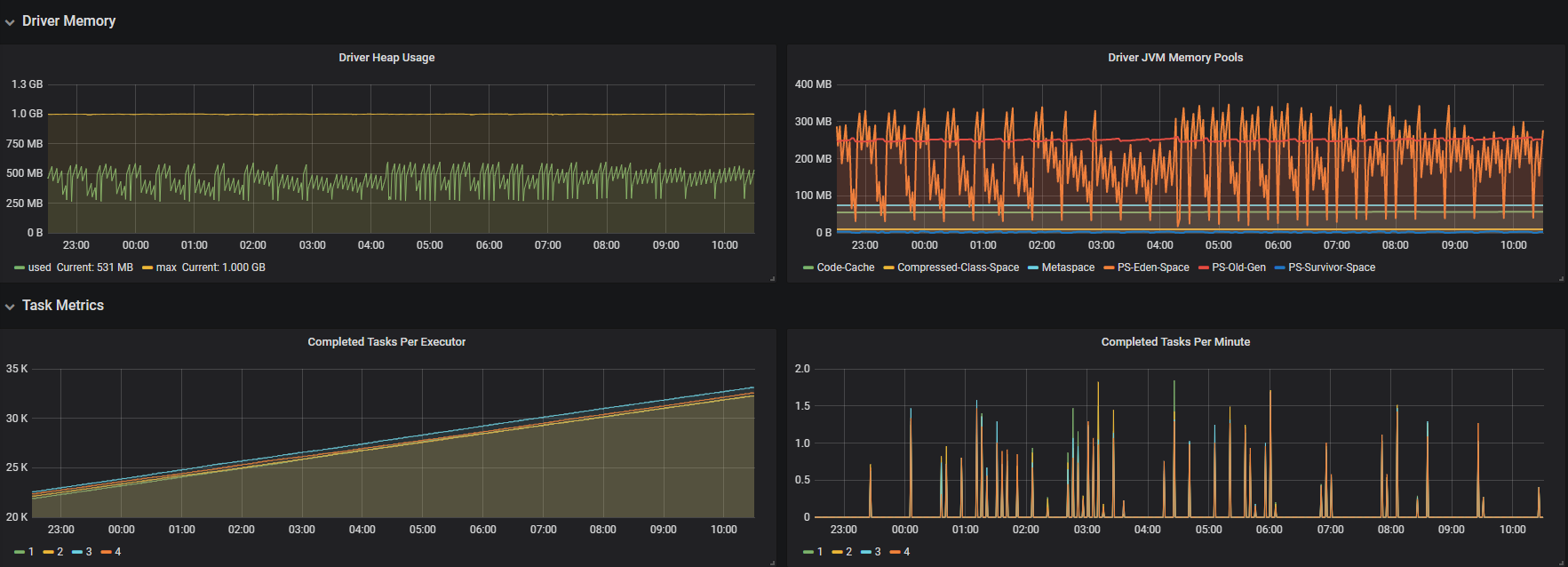

5.最后在grafana创建prometheus数据源,创建需要的指标,最终效果如下,有新提交的任务不需要再配置监控,直接选择application_id就可以看对应的信息

需要用到的jar包

https://repo1.maven.org/maven2/com/izettle/metrics-influxdb/1.1.8/metrics-influxdb-1.1.8.jar

https://mvnrepository.com/artifact/com.palantir.spark.influx/spark-influx-sink

模板

mappings:

- match: '*.*.executor.filesystem.*.*'

name: filesystem_usage

labels:

application: $1

executor_id: $2

fs_type: $3

qty: $4 - match: '*.*.executor.threadpool.*'

name: executor_tasks

labels:

application: $1

executor_id: $2

qty: $3 - match: '*.*.executor.jvmGCTime.count'

name: jvm_gcTime_count

labels:

application: $1

executor_id: $2 - match: '*.*.executor.*.*'

name: executor_info

labels:

application: $1

executor_id: $2

type: $3

qty: $4 - match: '*.*.jvm.*.*'

name: jvm_memory_usage

labels:

application: $1

executor_id: $2

mem_type: $3

qty: $4 - match: '*.*.jvm.pools.*.*'

name: jvm_memory_pools

labels:

application: $1

executor_id: $2

mem_type: $3

qty: $4 - match: '*.*.BlockManager.*.*'

name: block_manager

labels:

application: $1

executor_id: $2

type: $3

qty: $4 - match: '*.driver.DAGScheduler.*.*'

name: DAG_scheduler

labels:

application: $1

type: $2

qty: $3 - match: '*.driver.*.*.*.*'

name: task_info

labels:

application: $1

task: $2

type1: $3

type2: $4

qty: $5

graphite_exporter_mapping

参考资料

https://github.com/palantir/spark-influx-sink

https://spark.apache.org/docs/latest/monitoring.html

https://www.linkedin.com/pulse/monitoring-spark-streaming-influxdb-grafana-christian-g%C3%BCgi

https://github.com/prometheus/prometheus/wiki/Default-port-allocations

https://github.com/prometheus/graphite_exporter

https://prometheus.io/download/

https://rokroskar.github.io/monitoring-spark-on-hadoop-with-prometheus-and-grafana.html

https://blog.csdn.net/lsshlsw/article/details/82670508

https://www.jianshu.com/p/274380bb0974

Spark应用监控解决方案--使用Prometheus和Grafana监控Spark应用的更多相关文章

- Prometheus Alertmanager Grafana 监控警报

Prometheus Alertmanager Grafana 监控警报 #node-exporter, Linux系统信息采集组件 #prometheus , 抓取.储存监控数据,供查询指标 #al ...

- 使用Docker部署监控系统,Prometheus,Grafana,监控服务器信息及Mysql

使用Docker部署监控系统,Prometheus,Grafana,监控服务器信息及Mysql 一.docker部署prometheus监控系统 1.1 配置安装环境 1.1.1 安装promethe ...

- 14、Docker监控方案(Prometheus+cAdvisor+Grafana)

上一篇文章我们已经学习了比较流行的cAdvisor+InfluxDB+Grafana组合进行Docker监控.这节课来学习Prometheus+cAdvisor+Grafana组合. cAdvisor ...

- Prometheus+Alertmanager+Grafana监控组件容器部署

直接上部署配置文件 docker-compose.yml version: '3' networks: monitor: driver: bridge services: prometheus: im ...

- 使用Prometheus和Grafana监控emqx集群

以 Prometheus为例: emqx_prometheus 支持将数据推送至 Pushgateway 中,然后再由 Promethues Server 拉取进行存储. 注意:emqx_promet ...

- 使用Prometheus和Grafana监控nacos集群

官方文档:https://nacos.io/zh-cn/docs/monitor-guide.html 按照部署文档搭建好Nacos集群 配置application.properties文件,暴露me ...

- 使用Prometheus和Grafana监控RabbitMQ集群 (使用RabbitMQ自带插件)

配置RabbitMQ集群 官方文档:https://www.rabbitmq.com/prometheus.html#quick-start 官方github地址:https://github.com ...

- Prometheus+Grafana监控SpringBoot

Prometheus+Grafana监控SpringBoot 一.Prometheus监控SpringBoot 1.1 pom.xml添加依赖 1.2 修改application.yml配置文件 1. ...

- Docker监控平台prometheus和grafana,监控redis,mysql,docker,服务器信息

Docker监控平台prometheus和grafana,监控redis,mysql,docker,服务器信息 一.通过redis_exporter监控redis 1.1 下载镜像 1.2 运行服务 ...

随机推荐

- 入门训练-1.A+B问题

问题描述 输入A.B,输出A+B. 说明:在“问题描述”这部分,会给出试题的意思,以及所要求的目标. 输入格式 输入的第一行包括两个整数,由空格分隔,分别表示A.B. 说明:“输入格式”是描述在测试你 ...

- 跟着大彬读源码 - Redis 7 - 对象编码之简单动态字符串

Redis 没有直接使用 C 语言传统的字符串表示(以空字符串结尾的字符数组),而是构建了一种名为简单动态字符串(simple dynamic string)的抽象类型,并将 SDS 用作 Redis ...

- 10w数组去重,排序,找最多出现次数

配置在博客底部 主函数 package ooDay11.zy13; import ooDay11.zy13.hanshu.GetKeyList;import ooDay11.zy13.hanshu.G ...

- 章节十五、3-对象仓库、Page Factory实例应用

一.如何创建对象仓库 package pageclasses; import org.openqa.selenium.WebDriver; import org.openqa.selenium.Web ...

- 提交bug的标准及书写规范

Bug有效性 1.交付过程中测试者需按照专家设定好的模块,对Bug进行归类提交: 2.Bug的类型默认为UI问题.功能问题.崩溃问题,提交Bug时不能弄错: 3.需求是否明确.前提条件是否满足.输入数 ...

- bit、byte、kb、mb、g的区别

1Byte=8bit1KB=1024Byte(字节)=8*1024bit1MB=1024KB1GB=1024MB1TB=1024GB bit是计算机数据的最小单元.要么是0,要么是1. byte 关键 ...

- Unity经典游戏教程之:是男人就下100层

版权声明: 本文原创发布于博客园"优梦创客"的博客空间(网址:http://www.cnblogs.com/raymondking123/)以及微信公众号"优梦创客&qu ...

- PyCharm如何导入python项目

Pycharm导入python项目 进入PyCharm后,点击File→Open,然后在弹窗中选择需要导入项目的文件夹: 打开了python项目后,需要配置该项目对应的python才可以正常运行: 配 ...

- .NET Core 3.0预览版7中的ASP.NET Core和Blazor更新

.NET Core 3.0 Preview 7现已推出,它包含一系列ASP.NET Core和Blazor的新更新. 以下是此预览中的新功能列表: 最新的Visual Studio预览包括.NET C ...

- DIY cnblog——背景渐变切换

进来的小伙伴应该已经看过了我的博客样式,但还是贴张图先: 先大致说一下实现的思路,然后把代码贴出来供小伙伴们参考. 由于不是特别技术性的文章,格式就放宽松一点,跟着意识流走吧. 先跟大家分享一个渐变背 ...