Linux 搭建ELK日志收集系统

在搭建ELK之前,首先要安装Redis和JDK,安装Redis请参考上一篇文章。

首先安装JDK及配置环境变量

1.解压安装包到/usr/local/java目录下

[root@VM_0_9_centos ~]# tar xvf /ryt/soft/jdk-11.0.3_linux-x64_bin.tar.gz -C /usr/local/java/

2.配置环境变量(在尾部追加内容如下)

[root@VM_0_9_centos ~]# vim /etc/profile

export JAVA_HOME=/usr/local/java/jdk-11.0.3

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

3.重启配置文件,使其立即生效

[root@VM_0_9_centos ~]# source /etc/profile

ELK搭建详细过程

安装程序:filebeat,elasticsearch,logstash,kibana

1.安装Elasticsearch

1)解压安装包到路径/usr/local/elk下

[root@VM_0_9_centos ~]# tar -zxvf /ryt/soft/elk/elasticsearch-7.2.0-linux-x86_64.tar.gz -C /usr/local/elk/

2.创建用户并赋权

[root@VM_0_9_centos elk]# useradd es_user

[root@VM_0_9_centos elk]# groupadd esgroup

[root@VM_0_9_centos elk]# chown -R es_user:esgroup /usr/local/elk/elasticsearch-7.2.0/

3)修改ES配置文件:

[root@VM_0_9_centos elk]# vim /usr/local/elk/elasticsearch-7.2.0/config/elasticsearch.yml

#这里指定的是集群名称,需要修改为对应的,开启了自发现功能后,ES会按照此集群名称进行集群发现cluster.name: elk-application

node.name: node-1

#目录需要手动创建

path.data: /data/elasticsearch/data

path.logs: /data/elasticsearch/logs

#ES监听地址

network.host: 0.0.0.0 #允许外网个访问

http.port: 9200

discovery.seed_hosts: ["172.17.0.9"] #内网ip

cluster.initial_master_nodes: ["node-1"]

4)修改系统参数#添加参数

vm.max_map_count=655360注:ES启动的时候回占用特别大的资源所以需要修改下系统参数,若不修改资源启动会异常退出[root@VM_0_9_centos elk]# vim /etc/sysctl.conf

5)重新载入配置

[root@VM_0_9_centos elk]# sysctl -p /etc/sysctl.conf6)修改资源参数[root@VM_0_9_centos elk]# vim /etc/security/limits.conf

修改内容

* soft nofile 65536

* hard nofile 131072

* soft nproc 65536

* hard nproc 131072

7)设置用户资源参数

[root@VM_0_9_centos elk]# vim /etc/security/limits.d/20-nproc.conf

#添加

es_user soft nproc 65536

8)创建数据和日志目录并修改目录权限

[root@VM_0_9_centos elk]# mkdir -pv /usr/local/elk/{data,logs}

[root@VM_0_9_centos elk]# chown -R es_user:esgroup/data/elasticsearch/[root@VM_0_9_centos elk]# chown -R es_user:esgroup /usr/local/elk/elasticsearch-7.2.0

9)切换用户并后台启动ES

[root@VM_0_9_centos elk]# su esuser

[es_user@VM_0_9_centos elk]$ /usr/local/elk/elasticsearch-7.2.0/bin/elasticsearch &

2.安装logstash

1.解压安装包并移到/usr/local/elk目录下

[root@VM_0_9_centos filebeat-7.2.0]# tar -zvxf /ryt/soft/elk/logstash-7.2.0.tar.gz -C /usr/local/elk/

2.创建软连接

[root@VM_0_9_centos elk]# ln -s /usr/local/elk/logstash-7.2.0 /usr/local/elk/logstash

注:Java HotSpot(TM) 64-Bit Server VM warning:

INFO: os::commit_memory(0x00000000c5330000, 986513408, 0) failed;

error='Not enough space' (errno=12)

[root@VM_0_9_centos elk]# vim ./elasticsearch-7.2.0/config/jvm.options

3.在/usr/local/elk/logstash/config/下新建文件logstash.config

内容如下:

input {

redis {

data_type => "list" #存储类型

type => "redis-input"

key => "logstash:redis" #key值,后面要与spring boot中key保持一致

host => "localhost"

port => 6379

# threads => 5 #启动线程数量

codec => "json"

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "springboot-elk" #index是定义将过滤后的日志推送到Elasticsearch后存储的名字

}

stdout { codec => rubydebug} #是否在控制台打印

}

4.载入配置

[root@VM_0_9_centos config]# ../bin/logstash -f logstash-elasticsearch.conf -t

3.安装filebeat

1)解压安装包到路径/usr/local/elk下

[root@VM_0_9_centos elk]# tar xvf filebeat-7.2.0-linux-x86_64.tar.gz -C /usr/local/elk/

2)修改配置文件,使filebeat获取的日志进入redis:

注:此处演示获取spring cloud框架中eureka日志,其他程序日志都可相同方法获取

[root@VM_0_9_centos filebeat-7.2.0]#

[root@VM_0_9_centos filebeat-7.2.0]# pwd

/usr/local/elk/filebeat-7.2.0

[root@VM_0_9_centos filebeat-7.2.0]# vim ./filebeat.yml

#修改的内容有一家几个字段

enabled:true

paths:程序日志路径

#output只能有一个

#output.logstash:

# hosts:["服务器IP:5044"]

output.redis:

hosts:127.0.0.1 #redis所在服务器IP

port:6379 #redis端口3)设置开机启动

修改配置rc.local,后面追加 /usr/local/elk/filebeat-7.2.0/filebeat > /tmp/filebeat.log 2>&1

[root@VM_0_9_centos filebeat-7.2.0]# vim /etc/rc.local

4)后台启动filebeat

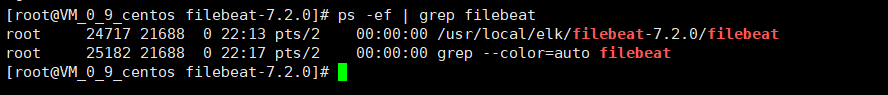

[root@VM_0_9_centos filebeat-7.2.0]# /usr/local/elk/filebeat-7.2.0/filebeat & 5)查看启动,filebeat有没有监听端口,主要看日志和进程

[root@VM_0_9_centos filebeat-7.2.0]# ps -ef | grep filebeat

[root@VM_0_9_centos filebeat-7.2.0]# tailf logs/filebeat

4.启动logstash

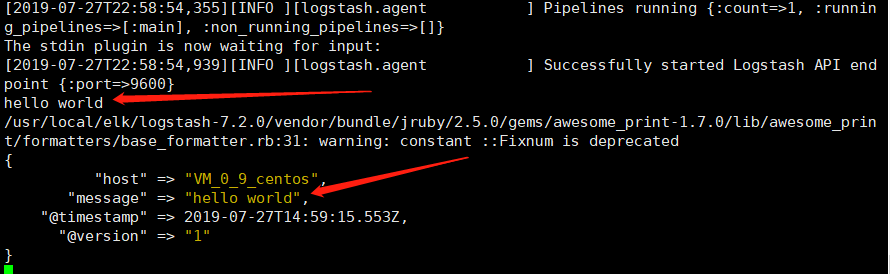

测试一下logstash不指定配置文件启动

[root@VM_0_9_centos config]# /usr/local/elk/logstash/bin/logstash -e 'input { stdin { } } output { stdout {} }'

注:手动输入 hello world,它也会输出 hello world

5.安装kibana

1)解压安装包到路径/usr/local/elk下

[root@VM_0_9_centos ~]# tar -zxvf /ryt/soft/elk/kibana-7.2.0-linux-x86_64.tar.gz -C /usr/local/elk/

2)编辑kibana配置文件

[root@VM_0_9_centos ~]# vim /usr/local/elk/kibana-7.2.0/config/kibana.yml

3)后台启动kibana

[root@VM_0_9_centos ~]# /usr/local/elk/kibana-7.2.0/bin/kibana --allow-root &

6.ELK logstash启动慢解决方案

使用如下命令查询

[root@VM_0_9_centos ~]# cat /proc/sys/kernel/random/entropy_avail 如果返回值小于1000, 那么就需要安装haveged包。

[root@VM_0_9_centos ~]# yum -y install haveged

我在安装了以后, logstash启动慢的问题解决,在10秒内启动。

参考链接:https://wiki.archlinux.org/index.php/Haveged_(%E7%AE%80%E4%BD%93%E4%B8%AD%E6%96%87)

Linux 搭建ELK日志收集系统的更多相关文章

- 快速搭建应用服务日志收集系统(Filebeat + ElasticSearch + kibana)

快速搭建应用服务日志收集系统(Filebeat + ElasticSearch + kibana) 概要说明 需求场景,系统环境是CentOS,多个应用部署在多台服务器上,平时查看应用日志及排查问题十 ...

- 用ElasticSearch,LogStash,Kibana搭建实时日志收集系统

用ElasticSearch,LogStash,Kibana搭建实时日志收集系统 介绍 这套系统,logstash负责收集处理日志文件内容存储到elasticsearch搜索引擎数据库中.kibana ...

- ELK 日志收集系统

传统系统日志收集的问题 在传统项目中,如果在生产环境中,有多台不同的服务器集群,如果生产环境需要通过日志定位项目的Bug的话,需要在每台节点上使用传统的命令方式查询,这样效率非常底下. 通常,日志被分 ...

- 快速搭建ELK日志分析系统

一.ELK搭建篇 官网地址:https://www.elastic.co/cn/ 官网权威指南:https://www.elastic.co/guide/cn/elasticsearch/guide/ ...

- Kubernetes 系列(八):搭建EFK日志收集系统

Kubernetes 中比较流行的日志收集解决方案是 Elasticsearch.Fluentd 和 Kibana(EFK)技术栈,也是官方现在比较推荐的一种方案. Elasticsearch 是一个 ...

- Docker搭建EFK日志收集系统,并自定义es索引名

EFK架构图 一.EFK简介 EFK不是一个软件,而是一套解决方案,并且都是开源软件,之间互相配合使用,完美衔接,高效的满足了很多场合的应用,是目前主流的一种日志系统. EFK是三个开源软件的缩写,分 ...

- ELK日志收集系统搭建

架构图 ELK 架构图:其中es 是集群,logstash 是单节点(猜想除非使用nginx对log4j的网络输出分发),kibana是单机(用不着做成集群). 1.拓扑图 2.logstash ...

- Windows系统搭建ELK日志收集服务器

一.ELK是什么?ELK是由Elasticsearch.Logstash.Kibana这3个软件的首字母缩写. Elasticsearch是一个分布式搜索分析引擎,稳定.可水平扩展.易于管理是它的主要 ...

- 十九,基于helm搭建EFK日志收集系统

目录 EFK日志系统 一,EFK日志系统简介: 二,EFK系统部署 1,EFK系统部署方式 2,基于Helm方式部署EFK EFK日志系统 一,EFK日志系统简介: 关于系统日志收集处理方案,其实有很 ...

随机推荐

- 【ACwing 93】【模版】非递归实现组合型枚举——模拟递归

(题面来自ACwing) 从 1~n 这 n 个整数中随机选出 m 个,输出所有可能的选择方案. 输入格式 两个整数 n,m ,在同一行用空格隔开. 输出格式 按照从小到大的顺序输出所有方案,每行1个 ...

- Codeforces Round #672 (Div. 2) B. Rock and Lever题解(思维+位运算)

题目链接 题目大意 给你一个长为n(n<=1e5)的数组,让你求有多少对a[i]和a[j] (i!=j)满足a[i]&a[j]>a[i]^a[j] 题目思路 这些有关位运算的题目肯 ...

- C++基础知识篇:C++ 变量作用域

作用域是程序的一个区域,一般来说有三个地方可以定义变量: 在函数或一个代码块内部声明的变量,称为局部变量. 在函数参数的定义中声明的变量,称为形式参数. 在所有函数外部声明的变量,称为全局变量. 我们 ...

- PowerManagerService流程分析

一.PowerManagerService简介 PowerManagerService主要服务Android系统电源管理工作,这样讲比较笼统,就具体细节上大致可以认为PowerManagerServi ...

- seata

启动seataserver: 回滚日志: server日志: file模式的文件 整个过程如果观察数据库变化的话,会发现事务是先提交了的,出现异常之后由seata又回滚回去

- 解决 spring-integration-mqtt 频繁报 Lost connection 错误

问题描述 在之前的博客介绍了如何在 Spring Boot 集成 MQTT,后面使用中没有发现问题,最近发现一直报错: Lost connection: Connection lost; retryi ...

- 老猿学5G扫盲贴:3GPP规范中与计费相关的主要规范文档列表及下载链接

专栏:Python基础教程目录 专栏:使用PyQt开发图形界面Python应用 专栏:PyQt入门学习 老猿Python博文目录 老猿学5G博文目录 在<老猿学5G扫盲贴:3GPP规范中部分与计 ...

- 转:【Python3网络爬虫开发实战】 requests基本用法

1. 准备工作 在开始之前,请确保已经正确安装好了requests库.如果没有安装,可以参考1.2.1节安装. 2. 实例引入 urllib库中的urlopen()方法实际上是以GET方式请求网页,而 ...

- 为什么Python中sort方法和sorted函数调用废弃使用cmp参数

Python中sort方法和sorted函数老猿在前面一些章节介绍过,具体语法及含义在此不再展开说明,但老猿在前面学习相关内容时,只使用了简单的案例,对这两个方法的key参数没有深入研究,总以为就是以 ...

- APP软件系统测试

1.功能模块测试 2.交叉事件测试 3.压力测试 存储压力测试 边界压力测试 响应能力压力测试 网络流量测试 4.容量测试 5.安装卸载测试 6.易用性.用户体验测试 7.UI界面测试