elasticsearch-spark的用法

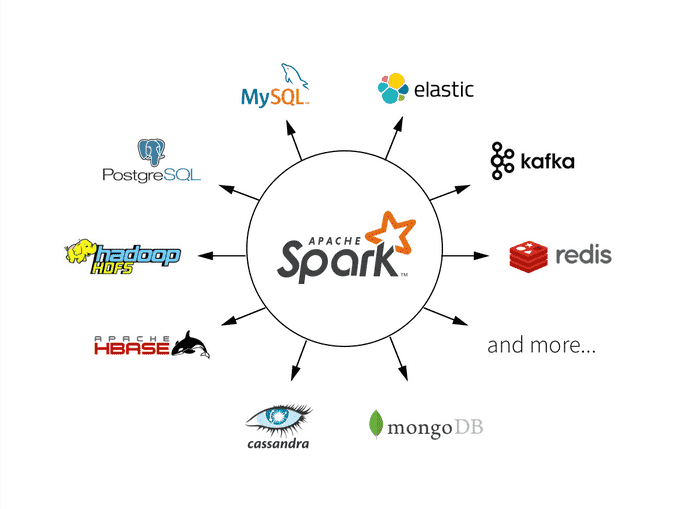

Hadoop允许Elasticsearch在Spark中以两种方式使用:通过自2.1以来的原生RDD支持,或者通过自2.0以来的Map/Reduce桥接器。从5.0版本开始,elasticsearch-hadoop就支持Spark 2.0。目前spark支持的数据源有:

(1)文件系统:LocalFS、HDFS、Hive、text、parquet、orc、json、csv

(2)数据RDBMS:mysql、oracle、mssql

(3)NOSQL数据库:HBase、ES、Redis

(4)消息对象:Redis

elasticsearch相对hdfs来说,容易搭建、并且有可视化kibana支持,非常方便spark的初学入门,本文主要讲解用elasticsearch-spark的入门。

一、原生RDD支持

1.1 基础配置

相关库引入:

<dependency>

<groupId>org.elasticsearch</groupId>

<artifactId>elasticsearch-spark-30_2.13</artifactId>

<version>8.1.3</version>

</dependency>

SparkConf配置,更多详细的请点击这里或者源码ConfigurationOptions。

public static SparkConf getSparkConf() {

SparkConf sparkConf = new SparkConf().setAppName("elasticsearch-spark-demo");

sparkConf.set("es.nodes", "host")

.set("es.port", "xxxxxx")

.set("es.nodes.wan.only", "true")

.set("es.net.http.auth.user", "elxxxxastic")

.set("es.net.http.auth.pass", "xxxx")

.setMaster("local[*]");

return sparkConf;

}

1.2 读取es数据

这里用的是kibana提供的sample data里面的索引kibana_sample_data_ecommerce,也可以替换成自己的索引。

public static void main(String[] args) {

SparkConf conf = getSparkConf();

try (JavaSparkContext jsc = new JavaSparkContext(conf)) {

JavaPairRDD<String, Map<String, Object>> esRDD =

JavaEsSpark.esRDD(jsc, "kibana_sample_data_ecommerce");

esRDD.collect().forEach(System.out::println);

}

}

esRDD同时也支持query语句esRDD(final JavaSparkContext jsc, final String resource, final String query),一般对es的查询都需要根据时间筛选一下,不过相对于es的官方sdk,并没有那么友好的api,只能直接使用原生的dsl语句。

1.3 写数据

支持序列化对象、json,并且能够使用占位符动态索引写入数据(使用较少),不过多介绍了。

public static void jsonWrite(){

String json1 = "{\"reason\" : \"business\",\"airport\" : \"SFO\"}";

String json2 = "{\"participants\" : 5,\"airport\" : \"OTP\"}";

JavaRDD<String> stringRDD = jsc.parallelize(ImmutableList.of(json1, json2));

JavaEsSpark.saveJsonToEs(stringRDD, "spark-json");

}

比较常用的读写也就这些,更多可以看下官网相关介绍。

二、Spark Streaming

spark的实时处理,es5.0的时候开始支持,Spark Streaming中的DStream编程接口是RDD,我们需要对RDD进行处理,处理起来较为费劲且不美观。

在spark streaming中,如果我们需要修改流程序的代码,在修改代码重新提交任务时,是不能从checkpoint中恢复数据的(程序就跑不起来),是因为spark不认识修改后的程序了。

public class EsSparkStreaming extends EsBaseConfig {

public static void main(String[] args) throws StreamingQueryException, TimeoutException {

SparkConf conf = getSparkConf();

JavaSparkContext jsc = new JavaSparkContext(conf);

JavaStreamingContext jssc = new JavaStreamingContext(jsc, Seconds.apply(1));

Map<String, ?> numbers = ImmutableMap.of("one", 1, "two", 2);

Map<String, ?> airports = ImmutableMap.of("OTP", "Otopeni", "SFO", "San Fran");

JavaRDD<Map<String, ?>> javaRDD = jsc.parallelize(ImmutableList.of(numbers, airports));

Queue<JavaRDD<Map<String, ?>>> microbatches = new LinkedList<>();

microbatches.add(javaRDD);

JavaDStream<Map<String, ?>> javaDStream = jssc.queueStream(microbatches);

JavaEsSparkStreaming.saveToEs(javaDStream, "spark-streaming");

jssc.start();

}

}

这里没有执行awaitTermination,执行代码后没有卡住,即可在es上查看

三、Spark SQL

elasticsearch-hadoop也提供了spark sql的插件,换言之,elasticsearch变成了Spark SQL的原生数据源,可以通过Spark SQL显示调用,下面的例子将kibana_sample_data_ecommerce索引读取,然后转化成dataset,在用sql来统计出当前货币。

public class EsToMysqlDemo extends EsBaseConfig {

public static void main(String[] args) {

SparkConf conf = getSparkConf();

try (JavaSparkContext jsc = new JavaSparkContext(conf)) {

SparkSession sparkSession = SparkSession.builder()

.config(conf)

.getOrCreate();

JavaRDD<Map<String, Object>> esRDD = JavaEsSpark.esRDD(jsc, "kibana_sample_data_ecommerce").values();

JavaRDD<Row> map = esRDD.map(v -> {

String currency = v.get("currency").toString();

String customerFullName = v.get("customer_full_name").toString();

String productsSku = v.getOrDefault("products", "").toString();

return RowFactory.create(currency, customerFullName, productsSku);

});

Dataset<Row> dataset = sparkSession.createDataFrame(map, StructType.fromDDL("currency string,customer_full_name string,products string"));

dataset.show(2);

Dataset<Row> count = dataset.select("currency").groupBy("currency").count();

count.show(2);

}

}

}

第一个show展示了当前的dataset,第二个show展示group by之后的结果。

四、Spark Structure Streaming

Structured Streaming使用DataFrame、DataSet的编程接口,处理数据时可以使用Spark SQL中提供的方法,数据的转换和输出会变得更加简单。

在structured streaming中,对于指定的代码修改操作,是不影响修改后从checkpoint中恢复数据的。具体可参见文档。下面这个例子是从控制台中读取数据,然后根据","切割,把第一个赋值给name,然后写入到es的spark-structured-streaming索引中去,启动程序前需要在控制台执行下命令:nc -lk 9999。

@Data

public static class PersonBean {

private String name;

private String surname;

}

public static void main(String[] args) throws StreamingQueryException {

SparkConf sparkConf = getSparkConf();

SparkSession spark = SparkSession.builder().config(sparkConf).getOrCreate();

Dataset<Row> lines = spark.readStream().format("socket").option("host", "localhost").option("port", 9999).load();

Dataset<PersonBean> people = lines.as(Encoders.STRING())

.map((MapFunction<String, PersonBean>) value -> {

String[] split = value.split(",");

PersonBean personBean = new PersonBean();

personBean.setName(split[0]);

return personBean;

}, Encoders.bean(PersonBean.class));

StreamingQuery es = people.writeStream().option("checkpointLocation", "./location")

.format("es").start("spark-structured-streaming");

es.awaitTermination();

}

checkpointLocation是用来设置检查点,里面会存储一些commits、offsets、sinks、metadata的信息。

执行完nc -lk 9999后,在控制台随便输入,即可在es中查看响应的结果。

相关源代码:

参考:

3.使用SparkSQL操作Elasticsearch - Spark入门教程

4.Spark——Spark Streaming 对比 Structured Streaming

elasticsearch-spark的用法的更多相关文章

- elasticsearch+spark+hbase 整合

1.用到的maven依赖 <dependency> <groupId>org.apache.spark</groupId> <artifactId>sp ...

- ElasticSearch的基本用法与集群搭建

一.简介 ElasticSearch和Solr都是基于Lucene的搜索引擎,不过ElasticSearch天生支持分布式,而Solr是4.0版本后的SolrCloud才是分布式版本,Solr的分布式 ...

- Elasticsearch批量操作API用法介绍

Elasticsearch的Bulk API允许批量提交index和delete请求,有如下两种用法: 用法1 BulkRequestBuilder requestBuilder = client.p ...

- ElasticSearch的基本用法与集群搭建 good

一.简介 ElasticSearch和Solr都是基于Lucene的搜索引擎,不过ElasticSearch天生支持分布式,而Solr是4.0版本后的SolrCloud才是分布式版本,Solr的分布式 ...

- 中间件:ElasticSearch组件RestHighLevelClient用法详解

本文源码:GitHub·点这里 || GitEE·点这里 一.基础API简介 1.RestHighLevelClient RestHighLevelClient的API作为ElasticSearch备 ...

- elasticsearch的基本用法

开始学习使用 elasticsearch, 把步骤记录在这里: 最大的特点: 1. 数据库的 database, 就是 index 2. 数据库的 table, 就是 tag 3. 不要使用bro ...

- elasticsearch的基本用法(转载)

本文出自:http://blog.csdn.net/feelig/article/details/8499614 最大的特点: 1. 数据库的 database, 就是 index 2. 数据库 ...

- elasticsearch 映射 dynamic用法

- Spark读取elasticsearch数据指南

最近要在 Spark job 中通过 Spark SQL 的方式读取 Elasticsearch 数据,踩了一些坑,总结于此. 环境说明 Spark job 的编写语言为 Scala,scala-li ...

- 使用spark与ElasticSearch交互

使用 elasticsearch-hadoop 包,可在 github 中搜索到该项目 项目地址 example import org.elasticsearch.spark._ import org ...

随机推荐

- POJ 2236:Wireless Network

描述 n台电脑,如果两台电脑间的距离的d范围内,则两台电脑能够连通. 如果AB连通,BC连通,则认为AC连通. 已知电脑台数N,最大距离d,以及每个电脑的坐标.有如下两种操作: O i 表示修复编号为 ...

- Linux_连接工具_SecureCRT的使用教程

什么是SecureCRT? SecureCRT是一款支持 SSH2.SSH1.Telnet.Telnet/SSH.Relogin.Serial.TAPI.RAW 等协议的终端仿真程序,最吸引我的是,S ...

- 为Anaconda python3安装gi模块

项目开发中需要使用到gi模块,Ubuntu自带的Python3.5可以正常使用gi.项目解释环境是Anaconda python3.5,提示ImportError: No module named ' ...

- 如何利用MHA+ProxySQL实现读写分离和负载均衡

摘要:本文分享一下"MHA+中间件ProxySQL"如何来实现读写分离+负载均衡的相关知识. 本文分享自华为云社区<MySQL高可用架构MHA+ProxySQL实现读写分离和 ...

- 爬虫---scrapy架构和原理

scrapy是一个为了爬取网站数据, 提取结构性数据而编写的应用框架, 它是基于Twisted框架开发而来, 而Twisted框架是事件驱动的, 比较适合异步代码. 对会阻塞线程的操作, 包括访问数据 ...

- 美团动态线程池实践思路开源项目(DynamicTp),线程池源码解析及通知告警篇

大家好,这篇文章我们来聊下动态线程池开源项目(DynamicTp)的通知告警模块.目前项目提供以下通知告警功能,每一个通知项都可以独立配置是否开启.告警阈值.告警间隔时间.平台等,具体代码请看core ...

- zabbix3.2 监控MongoDB

本文参考连接: https://www.jianshu.com/p/a6b36d5b74ba 一.实验环境: MongoDB/zabbix-agent:172.16.88.44 zabbix-serv ...

- python中其他数据类型内置方法

补充字符串数据类型内置方法 1.移除字符串首尾的指定字符可以选择方向1: s1 = '$$$jason$$$' print(s1.strip('$')) # jason print(s1.lstrip ...

- 解决k8s故障,eureka处于unknow的问题

//pod Unknown状态,开始强制删除eureka-server-node-0,eureka-server-node-1等,强制删除不了 [root@fp158 sts]# kubectl de ...

- Git上传本地仓库文件到Gitee(Github同理)

前言:本来想把最近的代码更新到Github上,但是校园网打不开,于是决定暂时先更新到Gitee中,Github中的操作也同理. 1. 创建云仓库: 就是在Gitee/Github上创建仓库,这里不演示 ...