week 5: ;Lasso regression & coordinate descent

笔记。

岭回归, 计算回归系数时使( RSS(w)+λ||w||2) 最小

岭回归的结果会是所有的特征的weight都较小,但大多数又不完全为零。

而实际情况中,有的特征的确与输出值相关程度很高,weight本就应该取一个较大的值,

而有的特征与输出结果几乎毫无关系,取一个很小的值不如直接取零。

岭回归的结果,一方面使“非常有用的”特征权值取不到一个较大的值,"有用"的特征无法很好表达,

另一方面又不能有效的筛掉“无用”的特征,很累赘。在特征很少时,这个缺陷可能没什么影响,但当

特征很多时,岭回归的缺陷较为明显。后续计算复杂度显著提高(很多非零的weight实际上很小)。

一个解决方法是在合理的范围里提高结果 (weights)的稀疏度(sparsity),尽量只留下“有用”的

特征的权值,其他相关度低的特征权值直接取零。这样后续计算只需要关注非零的权值,复杂度大大降低。

如何筛选出部分”有用“的特征?

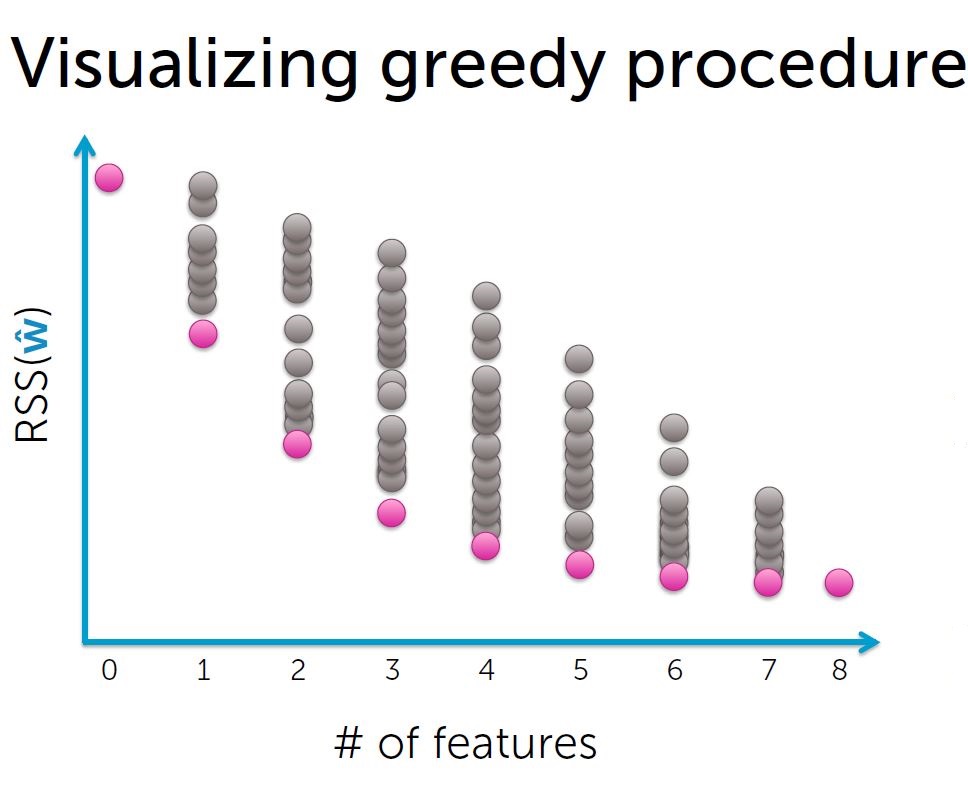

一个方法是使用贪婪算法。

过程:

1. 特征集合F初始为空集;

2.用特征集合F拟合模型,得到weights, 计算training error;

3.选择下一个最佳特征 f:

使用{F+f}作为特征集合可以使training error达到新低;

4. F <-- F+ f

5.递归

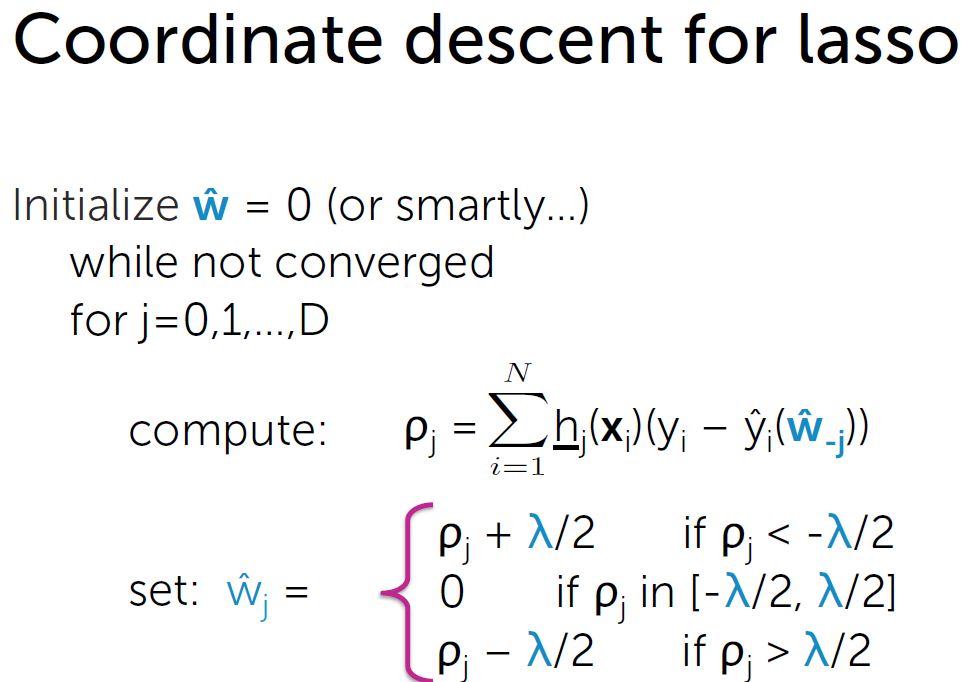

Lasso 回归: minimize (RSS(w)+λ||w||1)

||w||1为L1 范数,系数绝对值之和 |w|

|w|导数?

直接解方程 或 梯度下降 方法都不适用。

可以用subgradient 方法。

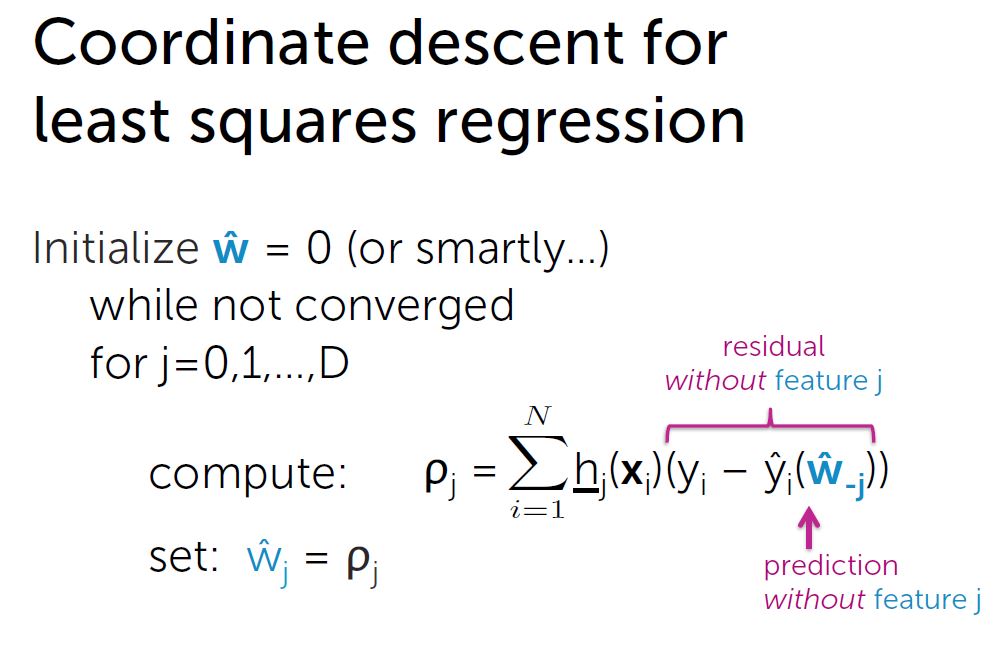

Coordinate descent:

用于解决一类最小值问题。适用于 直接求全局最小值很困难, 但单个坐标求最小值很容易 的函数。

求解过程:

1. 初始化

2. 循环,单个坐标一个个更新到最小值

3. 计算每一步的步长(步长应越来越小),当最大步长 < ε 停止,否则循环

def lasso_coordinate_descent_step(i, feature_matrix, output, weights, l1_penalty):

# compute prediction

prediction = predict_output(feature_matrix, weights)

# compute ro[i] = SUM[ [feature_i]*(output - prediction + weight[i]*[feature_i]) ]

ro_i = np.dot(feature_matrix[:,i],(output - prediction + weights[i]*feature_matrix[:,i])) if i == 0: # intercept -- do not regularize

new_weight_i = ro_i

elif ro_i < -l1_penalty/2.:

weight_i = ro_i + l1_penalty/2.

elif ro_i > l1_penalty/2.:

new_weight_i = ro_i - l1_penalty/2.

else:

new_weight_i = 0. return new_weight_i def lasso_cyclical_coordinate_descent(feature_matrix, output, weights, l1_penalty, tolerance): converged = False while converged == False:

coordinate = []

for i in xrange(len(weights)):

old_weights_i = weights[i] # remember old value of weight[i], as it will be overwritten

# the following line uses new values for weight[0], weight[1], ..., weight[i-1]

# and old values for weight[i], ..., weight[d-1]

weights[i] = lasso_coordinate_descent_step(i, feature_matrix, output, weights, l1_penalty) # use old_weights_i to compute change in coordinate

coordinate.append(abs(weights[i] - old_weights_i))

if max(coordinate) < tolerance:

converged = True return weights

week 5: ;Lasso regression & coordinate descent的更多相关文章

- 坐标下降法(coordinate descent method)求解LASSO的推导

坐标下降法(coordinate descent method)求解LASSO推导 LASSO在尖点是singular的,因此传统的梯度下降法.牛顿法等无法使用.常用的求解算法有最小角回归法.coor ...

- [Scikit-learn] 1.1 Generalized Linear Models - Lasso Regression

Ref: http://blog.csdn.net/daunxx/article/details/51596877 Ref: https://www.youtube.com/watch?v=ipb2M ...

- V-rep学习笔记:机器人逆运动学数值解法(Cyclic Coordinate Descent Method)

When performing inverse kinematics (IK) on a complicated bone chain, it can become too complex for a ...

- 吴恩达深度学习:2.9逻辑回归梯度下降法(Logistic Regression Gradient descent)

1.回顾logistic回归,下式中a是逻辑回归的输出,y是样本的真值标签值 . (1)现在写出该样本的偏导数流程图.假设这个样本只有两个特征x1和x2, 为了计算z,我们需要输入参数w1.w2和b还 ...

- 坐标下降(Coordinate descent)

坐标下降法属于一种非梯度优化的方法,它在每步迭代中沿一个坐标的方向进行线性搜索(线性搜索是不需要求导数的),通过循环使用不同的坐标方法来达到目标函数的局部极小值.

- Python机器学习——线性模型

http://www.dataguru.cn/portal.php?mod=view&aid=3514 摘要 : 最近断断续续地在接触一些python的东西.按照我的习惯,首先从应用层面搞起, ...

- Python大战机器学习——基础知识+前两章内容

一 矩阵求导 复杂矩阵问题求导方法:可以从小到大,从scalar到vector再到matrix. x is a column vector, A is a matrix d(A∗x)/dx=A d( ...

- Scikit Learn: 在python中机器学习

转自:http://my.oschina.net/u/175377/blog/84420#OSC_h2_23 Scikit Learn: 在python中机器学习 Warning 警告:有些没能理解的 ...

- [Example of Sklearn] - Example

reference : http://my.oschina.net/u/175377/blog/84420 目录[-] Scikit Learn: 在python中机器学习 载入示例数据 一个改变数据 ...

随机推荐

- android加密解密完美教程

经常使用加密算法:DES.3DES.RC4.AES,RSA等; 对称加密:des,3des,aes 非对称加密:rsa 不可逆加密:md5 加密模式:ECB.CBC.CFB.OFB等; 填充模式:No ...

- javascript快速入门18--样式

修改元素外观方式 修改元素外观主要有下面3种方法:修改ID,修改className,修改元素的style属性 修改ID?会造成多么混乱的结果可想而知! 修改className确实是非常好的方法,我们甚 ...

- webmagic的多线程及线程池的应用

- 倍福TwinCAT(贝福Beckhoff)常见问题(FAQ)-人机界面如何快速调整大量控件的位置

打开元素列表,然后直接从顶部按住Shift批量选中控件即可 更多教学视频和资料下载,欢迎关注以下信息: 我的优酷空间: http://i.youku.com/acetaohai123 我的 ...

- HDFS主要节点解说(一)节点功能

1 HDFS体系结构简单介绍及优缺点 1.1体系结构简单介绍 HDFS是一个主/从(Mater/Slave)体系结构.从终于用户的角度来看,它就像传统的文件系统一样,能够通过文件夹路径对文件运行CR ...

- 使用tornado实现用户认证

关于用户的登录状态,一部分的应用程序是采用session实现的. HTTP是一个无状态协议,用户的每次请求都是相互独立的,HTTP本身意识不到用户是否登录. 很多web框架选择将session存放在c ...

- NodeJS实战——创建基础应用并应用模板引擎

本次的目的是搭建一个最基础忽地可以实现功能的NodeJSserver,可以体现出NodeJS的工作流程以及开发的基本框架. 需求:已经安装了nodejs以及express. 一.构建基础的NodeJS ...

- 02-创建hibernate工程

编写hibernate需要的步骤 1,创建hibernate的配置文件 2,创建持久化类 3,创建对象-关系映射文件 4,通过hibernate API编写访问数据库代码 准备需要的文件. 1,准备一 ...

- 压测过程中,CPU和内存占用率很高,案例简单分析

Q: 最近公司测试一个接口,数据库采用Mongo 并发策略:并发400个用户,每3秒加载5个用户,持续运行30分钟 数据量:8000条左右 压测结果发现: TPS始终在5左右 ...

- 简易推荐引擎的python实现

代码地址如下:http://www.demodashi.com/demo/12913.html 主要思路 使用协同过滤的思路,从当前指定的用户过去的行为和其他用户的过去行为的相似度进行相似度评分,然后 ...