AI 技术发展简史

AI技术发展简史

一、AI的定义与核心目标

人工智能(Artificial Intelligence,AI)自诞生以来,一直是计算机科学和软件工程领域的重要研究方向。随着计算能力的提升、算法的演进以及数据规模的增长,AI技术在多个行业迅速落地,从早期的专家系统到今天的深度学习和大模型,AI的应用边界不断扩展,影响着软件开发、数据治理和数字化管理等多个领域。

从本质上讲,AI的目标是让机器具备模拟人类智能的能力,包括学习、推理、规划和创造等。早期的AI以符号主义和规则推理为核心,而后逐渐演进为基于统计学习的机器学习(Machine Learning, ML),并最终发展出深度学习(Deep Learning, DL)和大规模预训练模型(如GPT、BERT等)。在此过程中,AI的研究范式也经历了从手工构建知识到数据驱动学习的重大转变。

当前AI技术可以大致分为两大类:判别式AI(Discriminative AI) 和 生成式AI(Generative AI)。判别式AI主要用于分类和预测,擅长识别模式、做出决策,如人脸识别、推荐系统等;而生成式AI则能够学习数据的分布,并生成新的数据,如文本生成、图像合成、代码自动补全等。这两类AI在实际应用中相辅相成,共同推动了智能系统的发展。

二、AI的起源与早期发展

人工智能的概念虽然在1956年才正式提出,但其理论基础可以追溯到更早的计算理论研究。

20世纪30至40年代,艾伦·图灵提出了图灵机(Turing Machine),如图1所示,证明了计算可以通过一组简单规则实现,这一理论成为人工智能可行性的数学基础。同时,约翰·冯·诺依曼提出了存储程序计算机架构(Von Neumann Architecture),使计算机能够执行复杂的任务,为AI的发展提供了必要的计算平台。在这一时期,人工智能仍然是计算理论的一个远景设想,但已具备早期数学模型的支撑,例如McCulloch-Pitts神经元模型(1943),它模拟了人脑神经元的计算过程,为后来的神经网络研究奠定了基础。此外,克劳德·香农在1948年提出的信息论,为模式识别和机器学习提供了重要的数学工具。

(图1:图灵与图灵机示意)

1950年,艾伦·图灵在论文《计算机器与智能》中提出了图灵测试,以此作为衡量机器是否具备智能的标准。这一概念引发了关于机器是否能够思考的广泛讨论,并成为后续人工智能研究的重要理论基础。1956年,约翰·麦卡锡(John McCarthy)、马文·明斯基(Marvin Minsky)、克劳德·香农(Claude Shannon)等人(如图2)在达特茅斯会议上正式提出“人工智能(Artificial Intelligence)”这一术语,标志着AI作为独立研究领域的诞生。从此,研究人员开始尝试构建能够模拟人类智能的计算机程序,人工智能进入了符号主义(Symbolic AI)主导的时代。

(图2:达特茅茨会议的七位主要科学家)

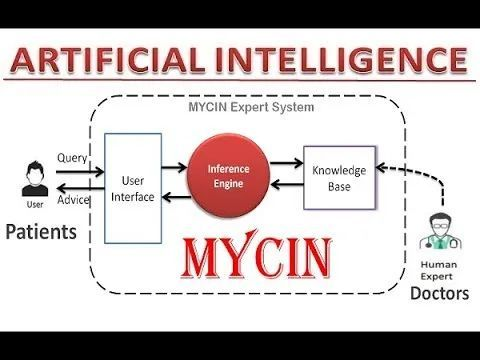

在20世纪50至70年代,符号主义AI占据主导地位,也被称为基于规则的AI。这一方法认为,智能可以通过符号操作来实现,核心思想是利用逻辑推理构建智能系统。早期的AI程序如Logic Theorist和General Problem Solver(GPS) 尝试使用数学逻辑进行自动推理,而LISP语言(1958)的发明则成为AI研究的主要编程语言,特别适用于符号处理。到了1970年代,AI研究者开始构建专家系统(Expert Systems),如DENDRAL(用于化学分子结构分析)和MYCIN(用于医学诊断),如图3,这些系统基于手工编写的规则,在特定领域内模拟人类专家的推理过程,并在商业和工业应用中展现出一定的价值。

(图3:MYCIN专家系统架构简图)

然而,随着研究的深入,符号主义AI暴露出诸多问题,导致AI在1970-1980年代进入第一次低谷。符号主义AI高度依赖计算资源,而当时的硬件性能远不足以支持大规模推理运算。面对这些挑战,AI的研究热潮逐渐降温,研究资金减少,许多项目被迫暂停。

尽管如此,AI在这一阶段奠定了许多基础理论,并推动了计算机科学的发展。进入1980年代后,随着机器学习方法的兴起,AI逐渐从符号主义向数据驱动的方法转变,开启了新一轮的复兴,为后续深度学习的爆发奠定了技术基础。

三、机器学习的崛起与大模型时代的到来

进入1980年代后,人工智能研究逐渐摆脱早期符号主义的局限,转向数据驱动的 机器学习(Machine Learning, ML) 方法。研究者意识到,与其手工编写规则,不如让计算机从数据中自动学习模式,从而提升AI的泛化能力。基于这一理念,统计学习方法、神经网络以及强化学习等技术相继发展,并推动了AI的广泛应用。

1986年,杰弗里·辛顿(Geoffrey Hinton)等人提出误差反向传播算法(Backpropagation),解决了多层神经网络的训练问题,使神经网络能够学习更复杂的非线性关系。1990年代,支持向量机(SVM)、决策树和贝叶斯网络等统计学习方法崭露头角,在模式识别、语音识别等任务中取得突破。1997年,IBM的深蓝(Deep Blue) 战胜世界象棋冠军卡斯帕罗夫,如图4,展示了AI在特定任务中的强大计算能力。2000年代,随着数据规模的增长和计算资源的提升, 卷积神经网络(CNN)和循环神经网络(RNN) 等深度学习模型开始在计算机视觉和自然语言处理领域展现出卓越性能,AI进入深度学习时代。

(图4:IBM深蓝击败人类棋手)

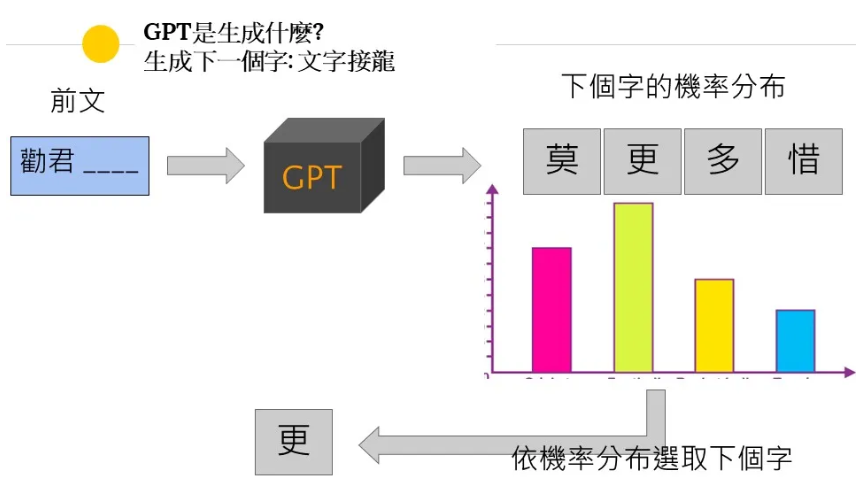

2012年,辛顿团队在ImageNet挑战赛中使用深度卷积神经网络AlexNet夺冠,证明了深度学习在计算机视觉任务上的强大能力,由此引发AI领域的深度学习革命。2014年,生成对抗网络(GANs)被提出,为生成式AI(详细了解生成式AI与判别式AI的差异)奠定了基础。2017年,Google提出Transformer架构,其 自注意力机制(Self-Attention) 能够高效处理长文本序列,解决了传统RNN难以捕捉长期依赖关系的问题。这一突破成为现代大规模语言模型(LLM)的基础。2018年,Google发布 BERT(Bidirectional Encoder Representations from Transformers) ,提出Transformer的构想,实现了更先进的自然语言理解能力。2022年,OpenAI公司ChatGPT的发布将AI推向公众视野,如图5,展示了大模型在语言理解、对话交互和任务自动化上的巨大潜力。2025年后,以deepseek为代表的开源大模型,进一步增强了AI的能力、降低了私有化部署门槛,使得AI能够理解和生成文本、图像、音频等多种数据类型,并应用于更多场景。

(图5:ChatGPT的原理简图)

至此,AI已经迈入大模型时代,深度学习与大规模数据驱动的模型成为主流并发展至今。当前,AI的发展不仅推动了自动化、智能化应用的普及,也引发了关于伦理、隐私、安全等方面的讨论。随着计算能力的持续提升与算法的不断优化,AI正向更具推理能力、更可控、更高效的智能体方向演进。

四、AI技术发展的挑战依然严峻

当前AI技术虽已取得突破性进展,但在实际落地过程中仍面临多维度的关键挑战。

技术方面,模型可靠性问题尤为突出。大语言模型存在的 AI幻觉(AI Hallucination) 现象,生成的内容符合逻辑但与事实不符,且黑箱特性使得决策过程 缺乏可解释性(Explainability),这导致其生成内容的可信度存疑。

工程化落地方面,模型的抗干扰能力不足。输入数据的细微差别有可能导致AI做出完全错误的判断,进一步加剧了用户对其可解释性的担心。此外,私有化部署的大模型的硬件成本过高、运维方案不完善等问题,阻碍了AI在企业中落地。

投资方面,AGI(通用人工智能)的可行性仍存争议。符号主义AI和大数据驱动AI的技术路线之争仍为结束,虽然后者暂时更受投资人欢迎,但并不能排除前者才是实现AGI的可行路线,这有可能会带来巨大的资源和时间浪费。

上述挑战只是冰山一角,行业需要产学研协同创新:在技术上突破模型可解释性瓶颈,在工程上建立标准化部署方案,在战略层面保持技术路线多样性等。只有通过这种系统性推进,AI技术才能完成从“玩具”到“工具”的变身,真正实现从实验室到产业的价值转化,为人类社会带来可持续的智能变革。

AI 技术发展简史的更多相关文章

- 【转】WEB技术发展简史

[转]WEB技术发展简史 一.Web技术发展的第一阶段——静态文档 第一阶段的Web,主要是用于静态Web页面的浏览.用户使用客户机端的Web浏览器,可以访问Internet上各个Web站点,在每一个 ...

- (原创)我对未来的人类的发展,以及AI技术发展的一些思考。

最近AI非常的火,不仅仅是阿尔法狗的成功,因为它击败了人类最强的大脑,颠覆了人类几千年来的对传统的认识,也让人类意识 到了一个问题:天外有天,人外有AI. 那么AI究竟会对人类的未来造成什么深远的影响 ...

- WEB技术发展简史

一.Web技术发展的第一阶段——静态文档 第一阶段的Web,主要是用于静态Web页面的浏览.用户使用客户机端的Web浏览器,可以访问Internet上各个Web站点,在每一个站点上都有一个主页(Hom ...

- Kubernetes 入门必备云原生发展简史

作者|张磊 阿里云容器平台高级技术专家,CNCF 官方大使 "未来的软件一定是生长于云上的"这是云原生理念的最核心假设.而所谓"云原生",实际上就是在定义一条能 ...

- zz2017-2018年AI技术前沿进展与趋势

2017年AI技术前沿进展与趋势 人工智能最近三年发展得如火如荼,学术界.工业界.投资界各方一起发力,硬件.算法与数据共同发展,不仅仅是大型互联网公司,包括大量创业公司以及传统行业的公司都开始涉足人工 ...

- AI技术说:人工智能相关概念与发展简史

作为近几年的一大热词,人工智能一直是科技圈不可忽视的一大风口.随着智能硬件的迭代,智能家居产品逐步走进千家万户,语音识别.图像识别等AI相关技术也经历了阶梯式发展.如何看待人工智能的本质?人工智能的飞 ...

- paper 27 :图像/视觉显著性检测技术发展情况梳理(Saliency Detection、Visual Attention)

1. 早期C. Koch与S. Ullman的研究工作. 他们提出了非常有影响力的生物启发模型. C. Koch and S. Ullman . Shifts in selective visual ...

- Web前端发展简史

Web前端发展简史 有人说“前端开发”是IT界最容易被误解的岗位,这不是空穴来风.如果你还认为前端只是从美工那里拿到切图, JS和CSS一番乱炖,难搞的功能就去网上信手拈来,CtrlC + Ctrl ...

- IBM沃森会成为第一个被抛弃的AI技术吗?

作者|William Vorhies 译者|姚佳灵 编辑|Debra 导读:IBM 的沃森问答机(Question Answering Machine,简称 QAM),因 2011 年参加综艺节目&l ...

- 一个AI产品经理怎么看AI的发展

一个AI产品经理怎么看AI的发展 https://www.jianshu.com/p/bed6b22ae837 最近一直在思考这个问题,人工智能接下来的几年会有什么样的发展,是否真的能够在很多工作岗位 ...

随机推荐

- 4. MySQL 逻辑架构说明

4. MySQL 逻辑架构说明 @ 目录 4. MySQL 逻辑架构说明 1. 逻辑架构剖析 1.1 服务器处理客户端请求 1.2 Connectors(连接器) 1.3 第1层:连接层 1.4 第2 ...

- Linux - 配置服务器之间SSH免密登录

如果集群中服务器之间没有配置SSH免密,那么SSH访问其他服务器时就需要输入密码 一般都要设置密码强口令,又长又难记,就想配置一下SSH免密. 一.生成公钥和私钥 在ctos79-01执行如下命令,公 ...

- 基于Openframeworks调取摄像头方式的定时抓拍保存图像方法小结

这次是采用Openframeworks来调取摄像头画面并抓图保存. 开始 借向导自动生成代码,因为要调取摄像头设备,因此增添ofVideoGrabber对象声明,又因为保存需求,所以还需添加ofPix ...

- Vigenere密码无密钥求解

0.前言 最近摸了很长时间的鱼,然后最近突然想搞一个Vigenere密码的自动求解,花了不到一天来实现了一下这个东西,不过受限于自己的水平,没有搞的太难.当然,代码部分不是全部都是从 0 开始的,关于 ...

- Kubernetes身份认证资源 —— TokenReview详解

1.概述 Kubernetes 中的 TokenReview 是用于验证令牌(Token)有效性的一种 API 资源,属于 authentication.k8s.io/v1 API 组.它允许客户端通 ...

- python py文件名称不能和库名称一样,否则报错module 'requests' has no attribute 'post'

这个问题自己犯过几次,加深一下记忆

- ssh WARNING: UNPROTECTED PRIVATE KEY FILE!

前言 在 ssh -i 指定密钥文件 登录时,出现以下报错: Permissions 0644 for 'xxxx' are too open. It is required that your pr ...

- Docker学习笔记:Docker 网络配置

2016-10-12 10:29:00 先知 转贴 51964 图: Docker - container and lightweight virtualization Dokcer 通过使用 Li ...

- 系统自带模版在 emlog pro 1.8.0 底部信息错位问题暂时的解决方案

问题描述 作为一名 emlog 爱好者,笔者闲暇时间经常为 emlog 系统的 Github 仓库里( https://github.com/emlog/emlog )提 pr 和修修补补,就像其他知 ...

- 客户端“自废武功”背后的深层秘密——CORS跨域是怎么回事?

客户端"自废武功"背后的深层秘密--CORS跨域是怎么回事? 嘿,对于刚入门的开发新手,你是不是曾经遇到过这样的情况:你正在愉快地开发一个 Web 应用,代码写得热火朝天,前后端配 ...