【Spark篇】---SparkSQL on Hive的配置和使用

一、前述

Spark on Hive: Hive只作为储存角色,Spark负责sql解析优化,执行。

二、具体配置

1、在Spark客户端配置Hive On Spark

在Spark客户端安装包下spark-1.6.0/conf中创建文件hive-site.xml:

配置hive的metastore路径

<configuration>

<property>

<name>hive.metastore.uris</name>

<value>thrift://node1:9083</value>

</property>

</configuration>

2、启动Hive的metastore服务

hive --service metastore

3、启动zookeeper集群,启动HDFS集群。

4、启动SparkShell 读取Hive中的表总数,对比hive中查询同一表查询总数测试时间。

./spark-shell

--master spark://node1:7077,node2:7077

--executor-cores 1

--executor-memory 1g

--total-executor-cores 1

import org.apache.spark.sql.hive.HiveContext

val hc = new HiveContext(sc)

hc.sql("show databases").show

hc.sql("user default").show

hc.sql("select count(*) from jizhan").show

可以发现性能明显提升!!!

注意:

如果使用Spark on Hive 查询数据时,出现错误:

找不到HDFS集群路径,要在客户端机器conf/spark-env.sh中设置HDFS的路径:

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

三、读取Hive中的数据加载成DataFrame

1、HiveContext是SQLContext的子类,连接Hive建议使用HiveContext。

2、由于本地没有Hive环境,要提交到集群运行,提交命令:

/spark-submit

--master spark://node1:7077,node2:7077

--executor-cores 1

--executor-memory 2G

--total-executor-cores 1

--class com.bjsxt.sparksql.dataframe.CreateDFFromHive

/root/test/HiveTest.jar

java代码:

SparkConf conf = new SparkConf();

conf.setAppName("hive");

JavaSparkContext sc = new JavaSparkContext(conf);

//HiveContext是SQLContext的子类。

HiveContext hiveContext = new HiveContext(sc);

hiveContext.sql("USE spark");

hiveContext.sql("DROP TABLE IF EXISTS student_infos");

//在hive中创建student_infos表

hiveContext.sql("CREATE TABLE IF NOT EXISTS student_infos (name STRING,age INT) row format delimited fields terminated by '\t' ");

hiveContext.sql("load data local inpath '/root/test/student_infos' into table student_infos"); hiveContext.sql("DROP TABLE IF EXISTS student_scores");

hiveContext.sql("CREATE TABLE IF NOT EXISTS student_scores (name STRING, score INT) row format delimited fields terminated by '\t'");

hiveContext.sql("LOAD DATA "

+ "LOCAL INPATH '/root/test/student_scores'"

+ "INTO TABLE student_scores");

/**

* 查询表生成DataFrame

*/

DataFrame goodStudentsDF = hiveContext.sql("SELECT si.name, si.age, ss.score "

+ "FROM student_infos si "

+ "JOIN student_scores ss "

+ "ON si.name=ss.name "

+ "WHERE ss.score>=80"); hiveContext.sql("DROP TABLE IF EXISTS good_student_infos"); goodStudentsDF.registerTempTable("goodstudent");

DataFrame result = hiveContext.sql("select * from goodstudent");

result.show(); /**

* 将结果保存到hive表 good_student_infos

*/

goodStudentsDF.write().mode(SaveMode.Overwrite).saveAsTable("good_student_infos"); Row[] goodStudentRows = hiveContext.table("good_student_infos").collect();

for(Row goodStudentRow : goodStudentRows) {

System.out.println(goodStudentRow);

}

sc.stop();

scala代码:

val conf = new SparkConf()

conf.setAppName("HiveSource")

val sc = new SparkContext(conf)

/**

* HiveContext是SQLContext的子类。

*/

val hiveContext = new HiveContext(sc)

hiveContext.sql("use spark")

hiveContext.sql("drop table if exists student_infos")

hiveContext.sql("create table if not exists student_infos (name string,age int) row format delimited fields terminated by '\t'")

hiveContext.sql("load data local inpath '/root/test/student_infos' into table student_infos") hiveContext.sql("drop table if exists student_scores")

hiveContext.sql("create table if not exists student_scores (name string,score int) row format delimited fields terminated by '\t'")

hiveContext.sql("load data local inpath '/root/test/student_scores' into table student_scores") val df = hiveContext.sql("select si.name,si.age,ss.score from student_infos si,student_scores ss where si.name = ss.name")

hiveContext.sql("drop table if exists good_student_infos")

/**

* 将结果写入到hive表中

*/

df.write.mode(SaveMode.Overwrite).saveAsTable("good_student_infos") sc.stop()

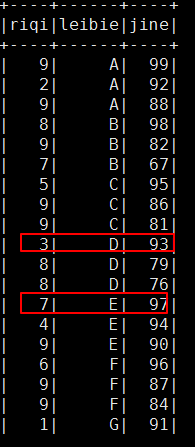

结果:

可以看到分组内有序,组间并不是有序的!!!!

【Spark篇】---SparkSQL on Hive的配置和使用的更多相关文章

- hive on spark VS SparkSQL VS hive on tez

http://blog.csdn.net/wtq1993/article/details/52435563 http://blog.csdn.net/yeruby/article/details/51 ...

- [Spark]Spark-sql与hive连接配置

一.在Mysql中配置hive数据库 创建hive数据库,刷新root用户权限 create database hive; grant all on *.* to root@'; flush priv ...

- Spark之 SparkSql整合hive

整合: 1,需要将hive-site.xml文件拷贝到Spark的conf目录下,这样就可以通过这个配置文件找到Hive的元数据以及数据存放位置. 2,如果Hive的元数据存放在Mysql中,我们还需 ...

- spark on yarn模式下配置spark-sql访问hive元数据

spark on yarn模式下配置spark-sql访问hive元数据 目的:在spark on yarn模式下,执行spark-sql访问hive的元数据.并对比一下spark-sql 和hive ...

- SparkSQL和hive on Spark

SparkSQL简介 SparkSQL的前身是Shark,给熟悉RDBMS但又不理解MapReduce的技术人员提供快速上手的工具,hive应运而生,它是当时唯一运行在Hadoop上的SQL-on-h ...

- Hive On Spark和SparkSQL

SparkSQL和Hive On Spark都是在Spark上实现SQL的解决方案.Spark早先有Shark项目用来实现SQL层,不过后来推翻重做了,就变成了SparkSQL.这是Spark官方Da ...

- 【Spark篇】---SparkSQL初始和创建DataFrame的几种方式

一.前述 1.SparkSQL介绍 Hive是Shark的前身,Shark是SparkSQL的前身,SparkSQL产生的根本原因是其完全脱离了Hive的限制. SparkSQL支持查询原 ...

- SparkSQL与Hive on Spark的比较

简要介绍了SparkSQL与Hive on Spark的区别与联系 一.关于Spark 简介 在Hadoop的整个生态系统中,Spark和MapReduce在同一个层级,即主要解决分布式计算框架的问题 ...

- SparkSQL与Hive on Spark

SparkSQL与Hive on Spark的比较 简要介绍了SparkSQL与Hive on Spark的区别与联系 一.关于Spark 简介 在Hadoop的整个生态系统中,Spark和MapR ...

随机推荐

- Yii2 console执行定时脚本

为什么要做crontab脚本 我们的项目使用YII2开发,并不是很大的一个电商平台,pv.IP访问量并不是很高,但客户的数据是日积月累已经产生100万条数据了,之前更新订单等数据使用定时脚本直接访问内 ...

- typora画图

https://steemit.com/utopian-io/@jubi/typora-typora-tutorial-exquisite-graph https://support.typora.i ...

- nginx反向代理+tomcat域名绑定

今天在用nginx做反向代理时,由于一个tomcat下有多个应用,因此要在tomcat做域名绑定.tomcat启动后,通过域名+端口是可以访问到页面的,但是通过nginx转发后就不能访问了,因此tom ...

- 2018-2019-2 20165239其米仁增《网络对抗》Exp1 PC平台逆向破解

一.实验内容 1.掌握NOP, JNE, JE, JMP, CMP汇编指令的机器码(0.5分) 2.掌握反汇编与十六进制编程器 (0.5分) 3.能正确修改机器指令改变程序执行流程(0.5分) 4.能 ...

- Windows phone 8.1之数据绑定(Data Binding)

学习Winphone8.1的时候经常需要对Slider进行数据绑定后使之视觉化,方便调节Slider的值. 数据绑定分为源(Source)和目标(Target),Source一般分为两种,其他控件的数 ...

- 学习easyui的小伙伴有福利了

easy-ui常用属性和方法 css定义与js定义两个版本

- Scrapy架构概述

Scrapy架构概述 1, 从最初自己编写的spiders,获取到start_url,并且封装成Request对象. 2,通过engine(引擎)调度给SCHEDULER(Requests管理调度器) ...

- 关于css盒子模型和BFC的理解

CSS盒子模型 包含元素内容(content).内边距(padding).边框(border).外边距(margin) 一般元素总宽度 = element的width+padding的左右边距+mar ...

- vue调用 Highcharts 实现多个数据可视化展示

一创建一个 options.js 代码为: export const option1 = { bar: { title: { text: '珠海猪场' // 指定图表标题 }, credits: { ...

- window上杀死node进程

1.查询端口占用的进程ID点击"开始"-->"运行",输入"cmd"后点击确定按钮,进入DOS窗口,接下来分别运行以下命令:netst ...