Numpy实现机器学习交叉验证的数据划分

Numpy实现K折交叉验证的数据划分

本实例使用Numpy的数组切片语法,实现了K折交叉验证的数据划分

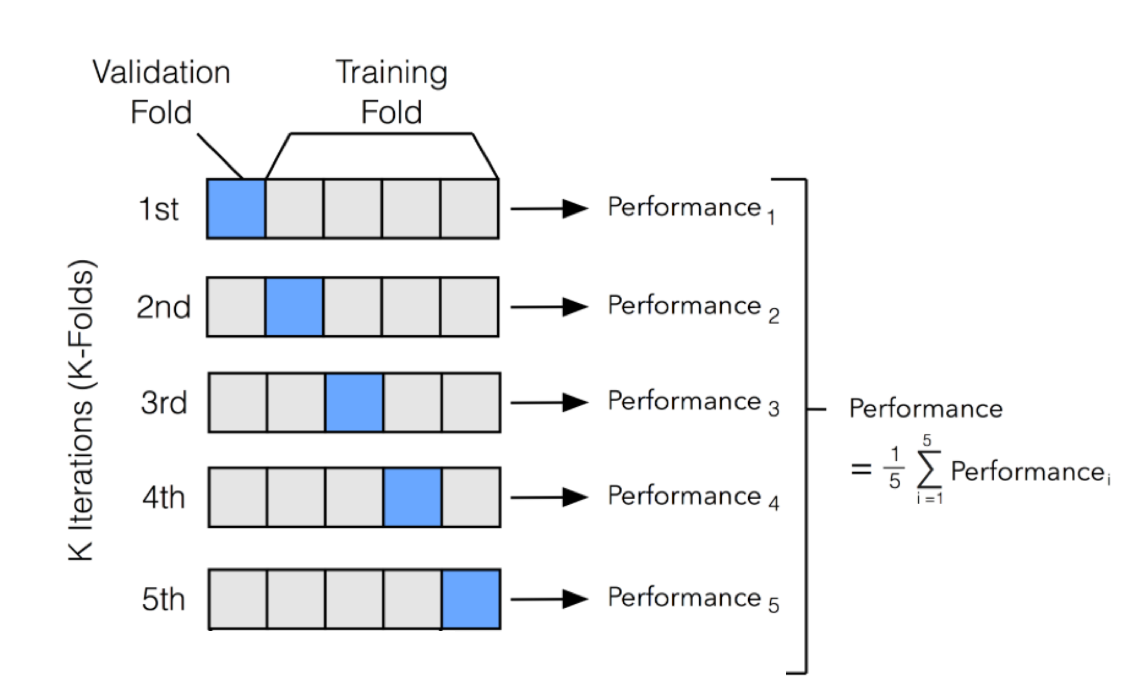

背景:K折交叉验证

为什么需要这个?

在机器学习中,因为如下原因,使用K折交叉验证能更好评估模型效果:

- 样本量不充足,划分了训练集和测试集后,训练数据更少;

- 训练集和测试集的不同划分,可能会导致不同的模型性能结果;

K折验证是什么

K折验证(K-fold validtion)将数据划分为大小相同的K个分区。

对每个分区i,在剩余的K-1个分区上训练模型,然后在分区i上评估模型。

最终分数等于K个分数的平均值,使用平均值来消除训练集和测试集的划分影响;

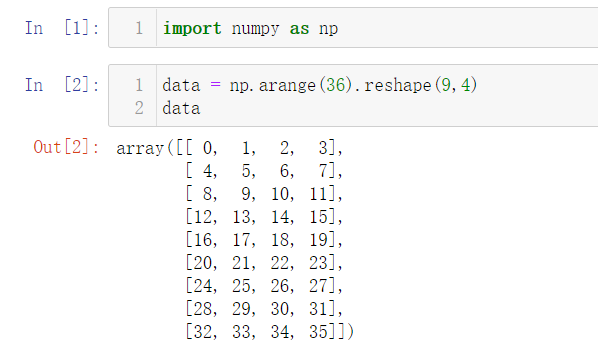

1. 模拟构造样本集合

用样本的角度解释下data数组:

- 这是一个二维矩阵,行代表每个样本,列代表每个特征

- 这里有9个样本,每个样本有4个特征

这是scikit-learn模型训练输入的标准格式

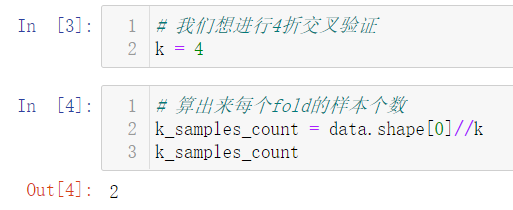

2. 使用Numpy实现K次划分

for fold in range(k):

validation_begin = k_samples_count*fold

validation_end = k_samples_count*(fold+1) validation_data = data[validation_begin:validation_end] # np.vstack,沿着垂直的方向堆叠数组

train_data = np.vstack([

data[:validation_begin],

data[validation_end:]

]) print()

print(f"#####第{fold}折#####")

print("验证集:\n", validation_data)

print("训练集:\n", train_data)

结果:

#####第0折#####

验证集:

[[0 1 2 3]

[4 5 6 7]]

训练集:

[[ 8 9 10 11]

[12 13 14 15]

[16 17 18 19]

[20 21 22 23]

[24 25 26 27]

[28 29 30 31]

[32 33 34 35]] #####第1折#####

验证集:

[[ 8 9 10 11]

[12 13 14 15]]

训练集:

[[ 0 1 2 3]

[ 4 5 6 7]

[16 17 18 19]

[20 21 22 23]

[24 25 26 27]

[28 29 30 31]

[32 33 34 35]] #####第2折#####

验证集:

[[16 17 18 19]

[20 21 22 23]]

训练集:

[[ 0 1 2 3]

[ 4 5 6 7]

[ 8 9 10 11]

[12 13 14 15]

[24 25 26 27]

[28 29 30 31]

[32 33 34 35]] #####第3折#####

验证集:

[[24 25 26 27]

[28 29 30 31]]

训练集:

[[ 0 1 2 3]

[ 4 5 6 7]

[ 8 9 10 11]

[12 13 14 15]

[16 17 18 19]

[20 21 22 23]

[32 33 34 35]]

如果使用scikit-learn,已经有封装好的实现:

from sklearn.model_selection import cross_val_score

Numpy实现机器学习交叉验证的数据划分的更多相关文章

- 机器学习——交叉验证,GridSearchCV,岭回归

0.交叉验证 交叉验证的基本思想是把在某种意义下将原始数据(dataset)进行分组,一部分做为训练集(train set),另一部分做为验证集(validation set or test set) ...

- 机器学习 - 案例 - 样本不均衡数据分析 - 信用卡诈骗 ( 标准化处理, 数据不均处理, 交叉验证, 评估, Recall值, 混淆矩阵, 阈值 )

案例背景 银行评判用户的信用考量规避信用卡诈骗 ▒ 数据 数据共有 31 个特征, 为了安全起见数据已经向了模糊化处理无法读出真实信息目标 其中数据中的 class 特征标识为是否正常用户 (0 代表 ...

- 机器学习中的train valid test以及交叉验证

转自 https://www.cnblogs.com/rainsoul/p/6373385.html 在以前的网络训练中,有关于验证集一直比较疑惑,在一些机器学习的教程中,都会提到,将数据集分为三部分 ...

- 机器学习基础:(Python)训练集测试集分割与交叉验证

在上一篇关于Python中的线性回归的文章之后,我想再写一篇关于训练测试分割和交叉验证的文章.在数据科学和数据分析领域中,这两个概念经常被用作防止或最小化过度拟合的工具.我会解释当使用统计模型时,通常 ...

- 斯坦福大学公开课机器学习:advice for applying machine learning | model selection and training/validation/test sets(模型选择以及训练集、交叉验证集和测试集的概念)

怎样选用正确的特征构造学习算法或者如何选择学习算法中的正则化参数lambda?这些问题我们称之为模型选择问题. 在对于这一问题的讨论中,我们不仅将数据分为:训练集和测试集,而是将数据分为三个数据组:也 ...

- Spark机器学习——模型选择与参数调优之交叉验证

spark 模型选择与超参调优 机器学习可以简单的归纳为 通过数据训练y = f(x) 的过程,因此定义完训练模型之后,就需要考虑如何选择最终我们认为最优的模型. 如何选择最优的模型,就是本篇的主要内 ...

- Spark2.0机器学习系列之2:基于Pipeline、交叉验证、ParamMap的模型选择和超参数调优

Spark中的CrossValidation Spark中采用是k折交叉验证 (k-fold cross validation).举个例子,例如10折交叉验证(10-fold cross valida ...

- 机器学习--K折交叉验证和非负矩阵分解

1.交叉验证 交叉验证(Cross validation),交叉验证用于防止模型过于复杂而引起的过拟合.有时亦称循环估计, 是一种统计学上将数据样本切割成较小子集的实用方法. 于是可以先在一个子集上做 ...

- 机器学习 数据量不足问题----1 做好特征工程 2 不要用太多的特征 3 做好交叉验证 使用线性svm

来自:https://www.zhihu.com/question/35649122 其实这里所说的数据量不足,可以换一种方式去理解:在维度高的情况下,数据相对少.举一个特例,比如只有一维,和1万个数 ...

随机推荐

- (第二章第四部分)TensorFlow框架之TFRecords数据的存储与读取

系列博客链接: (第二章第一部分)TensorFlow框架之文件读取流程:https://www.cnblogs.com/kongweisi/p/11050302.html (第二章第二部分)Tens ...

- spring boot application.yml 常用基本配置

1.Tomcat 配置 server: #设置请求端口 port: 8080 servlet: #指定 Tomcat的请求路径 context-path: /cl #设置 Tomcat 编码格式 en ...

- Ajax的疑难杂种详解

跨域问题 如图所示,这是通过jquery封装的ajax请求了一个本地的php文件(无框架),console提示CORS策略已阻止"来自来源"的"null":请求 ...

- 以QT为例谈环境搭建

以QT为例谈环境搭建 作者:哲思 时间:2022.1.5 邮箱:1464445232@qq.com GitHub:zhe-si (哲思) (github.com) 前言 自从实习结束,好久没写博客了. ...

- aria2 源码解析专题 —— (二) Exception 部分

首先声明 Exception 部分的几个异常类的继承关系,如下: 这一版的 Exception 部分只有头文件,没有源文件,所以涉及到的更多的只是定义而已,没有太多实现,所以这一部分也简单说说每个类的 ...

- PHP防止订单超卖,秒杀,限购,PHP高并发防止超卖代码实践

建表 1.订单表 CREATE TABLE `order` ( `id` int(11) NOT NULL AUTO_INCREMENT, `order_sn` varchar(45) NOT NUL ...

- 手写 Vue2 系列 之 编译器

前言 接下来就要正式进入手写 Vue2 系列了.这里不会从零开始,会基于 lyn-vue 直接进行升级,所以如果你没有阅读过 手写 Vue 系列 之 Vue1.x,请先从这篇文章开始,按照顺序进行学习 ...

- CF437C题解

思路很妙/youl 题目大意见翻译,说得很清楚/youl 首先,这个图到最后所有点都会被删除,所以所有边都会被删除. 但是考虑点的贡献会很麻烦,所以在这里我们考虑边的贡献. 边的贡献就是,左端点和右端 ...

- linux 常用命令:

查看启动进程命令 ps -ef | grep donet 1.vi 进入编辑界面 2.ls,ll 查看命令 3.cd 进入命令 4.i 进入插入界面 5. esc 退出编辑界面 6.输入:冒号,进入 ...

- 什么是CSRF跨站请求伪造?(from表单效验csrf-ajdax效验csrf-Ajax设置csrf-CBV装饰器验证csrf)

目录 一:csrf跨站请求伪造 1.什么是CSRF? 2.CSRF攻击案例(钓鱼网站) 3.钓鱼网站 内部原理 4.CSRF原理(钓鱼网站内部本质) 5.从上图可以看出,要完成一次CSRF攻击,受害者 ...