Caffe源码阅读(1) 全连接层

Caffe源码阅读(1) 全连接层

今天看全连接层的实现。

主要看的是https://github.com/BVLC/caffe/blob/master/src/caffe/layers/inner_product_layer.cpp

主要是三个方法,setup,forward,backward

- setup 初始化网络参数,包括了w和b

- forward 前向传播的实现

- backward 后向传播的实现

setup

主体的思路,作者的注释给的很清晰。

主要是要弄清楚一些变量对应的含义

1 |

M_ 表示的样本数 |

为了打字方便,以下省略下划线,缩写为M,K,N

forward

实现的功能就是 y=wx+b

1 |

x为输入,维度 MxK |

具体到代码实现,用的是这个函数caffe_cpu_gemm,具体的函数头为

1 |

void caffe_cpu_gemm<float>(const CBLAS_TRANSPOSE TransA, |

略长,整理它的功能其实很直观,即C←αA×B+βC

1 |

const CBLAS_TRANSPOSE TransA # A是否转置 |

从实际代码来算,全连接层的forward包括了两步:

1 |

# 这一步表示 y←wx,或者说是y←xw' |

backward

分成三步:

- 更新w

- 更新b

- 计算delta

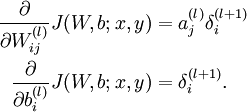

用公式来说是下面三条:

一步步来,先来第一步,更新w,对应代码是:

1 |

caffe_cpu_gemm<Dtype>(CblasTrans, CblasNoTrans, N_, K_, M_, (Dtype)1., |

对照公式,有

1 |

需要更新的w的梯度的维度是NxK |

然后是第二步,更新b,对应代码是:

1 |

caffe_cpu_gemv<Dtype>(CblasTrans, M_, N_, (Dtype)1., top_diff, |

这里用到了caffe_cpu_gemv,简单来说跟上面的caffe_cpu_gemm类似,不过前者是计算矩阵和向量之间的乘法的(从英文命名可以分辨,v for vector, m for matrix)。函数头:

1 |

void caffe_cpu_gemv<float>(const CBLAS_TRANSPOSE TransA, const int M, |

绕回到具体的代码实现。。如何更新b?根据公式b的梯度直接就是delta

1 |

# 所以对应的代码其实就是将top_diff转置后就可以了(忽略乘上bias_multiplier这步) |

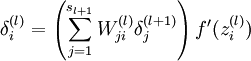

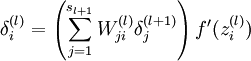

第三步是计算delta,对应公式

这里面可以忽略掉最后一项f’,因为在caffe实现中,这是由Relu layer来实现的,这里只需要实现括号里面的累加就好了,这个累加其实可以等价于矩阵乘法

1 |

caffe_cpu_gemm<Dtype>(CblasNoTrans, CblasNoTrans, M_, K_, N_, (Dtype)1., |

附录

又及,这里具体计算矩阵相乘用的是blas的功能,描述页面我参考的是:https://developer.apple.com/library/mac/documentation/Accelerate/Reference/BLAS_Ref/Reference/reference.html#//apple_ref/c/func/cblas_sgemm

Caffe源码阅读(1) 全连接层的更多相关文章

- caffe源码阅读

参考网址:https://www.cnblogs.com/louyihang-loves-baiyan/p/5149628.html 1.caffe代码层次熟悉blob,layer,net,solve ...

- caffe源码阅读(1)_整体框架和简介(摘录)

原文链接:https://www.zhihu.com/question/27982282 1.Caffe代码层次.回答里面有人说熟悉Blob,Layer,Net,Solver这样的几大类,我比较赞同. ...

- caffe源码阅读(1)-数据流Blob

Blob是Caffe中层之间数据流通的单位,各个layer之间的数据通过Blob传递.在看Blob源码之前,先看一下CPU和GPU内存之间的数据同步类SyncedMemory:使用GPU运算时,数据要 ...

- caffe源码阅读(3)-Datalayer

DataLayer是把数据从文件导入到网络的层,从网络定义prototxt文件可以看一下数据层定义 layer { name: "data" type: "Data&qu ...

- caffe源码阅读(2)-Layer

神经网络是由层组成的,深度神经网络就是层数多了.layer对应神经网络的层.数据以Blob的形式,在不同的layer之间流动.caffe定义的神经网络已protobuf形式定义.例如: layer { ...

- caffe源码阅读(一)convert_imageset.cpp注释

PS:本系列为本人初步学习caffe所记,由于理解尚浅,其中多有不足之处和错误之处,有待改正. 一.实现方法 首先,将文件名与它对应的标签用 std::pair 存储起来,其中first存储文件名,s ...

- caffe 源码阅读

bvlc:Berkeley Vision and Learning Center. 1. 目录结构 models(四个文件夹均有四个文件构成,deploy.prototxt, readme.md, s ...

- caffe源码 全连接层

图示全连接层 如上图所示,该全链接层输入n * 4,输出为n * 2,n为batch 该层有两个参数W和B,W为系数,B为偏置项 该层的函数为F(x) = W*x + B,则W为4 * 2的矩阵,B ...

- 源码阅读经验谈-slim,darknet,labelimg,caffe(1)

本文首先谈自己的源码阅读体验,然后给几个案例解读,选的例子都是比较简单.重在说明我琢磨的点线面源码阅读方法.我不是专业架构师,是从一个深度学习算法工程师的角度来谈的,不专业的地方请大家轻拍. 经常看别 ...

随机推荐

- Python中正则表达式的巧妙使用

字符串的匹配查询 re模块中的findall函数可以对指定的字符串进行遍历匹配,获取字符串中所有匹配的子串,并返回一个列表结果.该函数的参数含义如下: findall(pattern, string, ...

- Luogu4221 WC2018州区划分(状压dp+FWT)

合法条件为所有划分出的子图均不存在欧拉回路或不连通,也即至少存在一个度数为奇数的点或不连通.显然可以对每个点集预处理是否合法,然后就不用管这个奇怪的条件了. 考虑状压dp.设f[S]为S集合所有划分方 ...

- MT【15】证明无理数(1)

证明:$tan3^0$是无理数. 分析:证明无理数的题目一般用反证法,最经典的就是$\sqrt{2}$是无理数的证明. 这里假设$tan3^0$是有理数,利用二倍角公式容易得到$tan6^0,tan1 ...

- Android canvast View 代码实例

package com.app.canvastest; import android.content.Context; import android.graphics.Bitmap; import a ...

- pytesseract 使用框架

import pytesseract import cv2 img = cv2.imread("captcha.jpg",0) try: img.shape except Attr ...

- CF 987

毒瘤啊啊啊啊啊 虽然排名还不错,331,但是B我没做出来...... 这是战绩: 可以看到我大发神威势如破竹的A了CDE,但是B把我卡了三次...不然我就能进前300了(还是很水). 逐一分析题目: ...

- 【洛谷P1091】合唱队列

题目大意:给定一个有 N 个正整数的序列,从其中拿走一些数,使得剩下的数满足严格单峰性,即先严格递增后严格递减,允许单调增和单调减,求最少需要拿走多少数. 题解:先考虑严格单调的情况,最少需要拿走多少 ...

- mac subLime3 JSON 格式化插件安装

1.首先找到路径:/Users/hou***in/Library/Application' 'Support/Sublime' 'Text' '3/Packages/ 2.git clone http ...

- sort逆序(char String)

import java.util.Arrays; import java.util.Collections; import java.util.Scanner; public class Main { ...

- k8s 常用命令汇集

通过yaml文件创建: kubectl create -f xxx.yaml (不建议使用,无法更新,必须先delete) kubectl apply -f xxx.yaml (创建+更新,可以重复使 ...