2019-05-19 Python之第一个爬虫和测试

一.使用request和get访问某个网页20次并且打印返回状态,内容

扩展:常见状态码含义 200 - 服务器成功返回网页,404 - 请求的网页不存在,403(禁止)服务器拒绝请求,404(未找到)服务器找不到请求的网页,503 - 服务器超时,3xx (重定向)

(1)request库简介:处理HTTP请求的第三方库,建立在urllib3库的基础上

(2)常用函数 get(url[,timeout = n ]), post

delete,head,options,put等等

(3)status_code返回状态。 text返回字符串形式。encoding返回编码方式。content返回二进制形式。注:response.text是解过码的字符串(比如html代码)。当requests发送请求到一个网页时,requests库会推测目标网页的编码,并对其解码,转为字符串(str)。这种方法比较容易出现乱码。

(4)实例代码

import requests

r = requests.get('https://www.sogou.com/', timeout = 4) #使用get方式请求搜狗网站

print("状态码 = {}".format( r.status_code))#输出状态码

print("text内容 = {}".format(r.text))

print("编码方式 = {}".format(r.encoding))

print("二进制形式 = {}".format(r.content))

(5)输出结果:

状态码 = 200

。。。。。。。。。。。。。。。。省略

编码方式 = UTF-8

二进制形式 = b'<!DOCTYPE。。。。。。。。。。。。省略

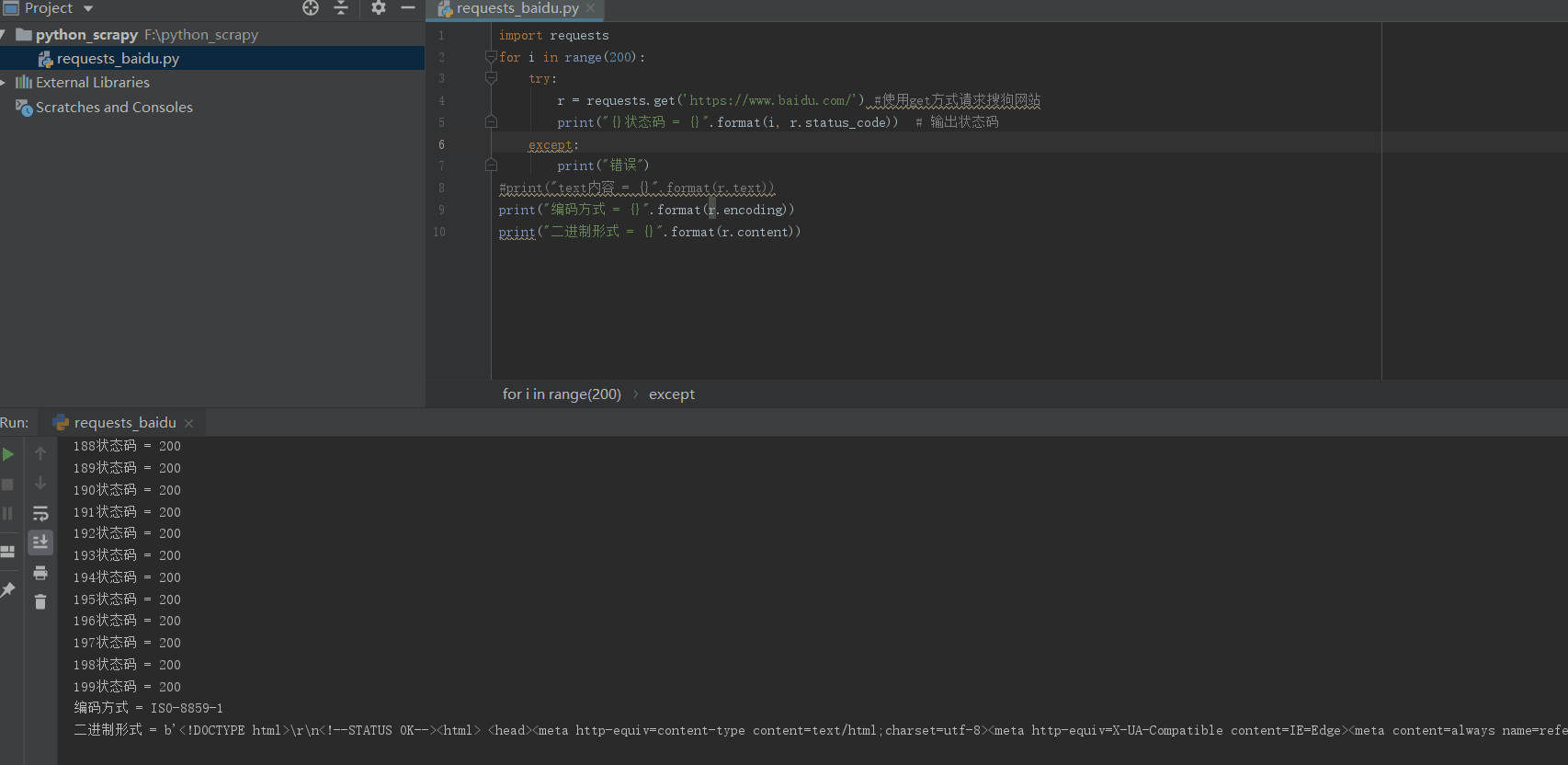

(6)测试连续访问20次的结果

import requests

for i in range(200):

r = requests.get('https://www.baidu.com/') #使用get方式请求搜狗网站

print("状态码 = {}".format(r.status_code)) # 输出状态码

#print("text内容 = {}".format(r.text))

print("编码方式 = {}".format(r.encoding))

print("二进制形式 = {}".format(r.content))

二.使用beautifulsoup4解析HTML页面格式,提取有用信息

(1)beautifulsoup4库的简介:解析和处理HTML和XML

(2)常用函数head获取<head>内容,title,body,p第一个<p>内容,strings所有程序在web上的字符串,即标签的内容,stripped_strings所有呈现在web上的非空字符串

(3)示例

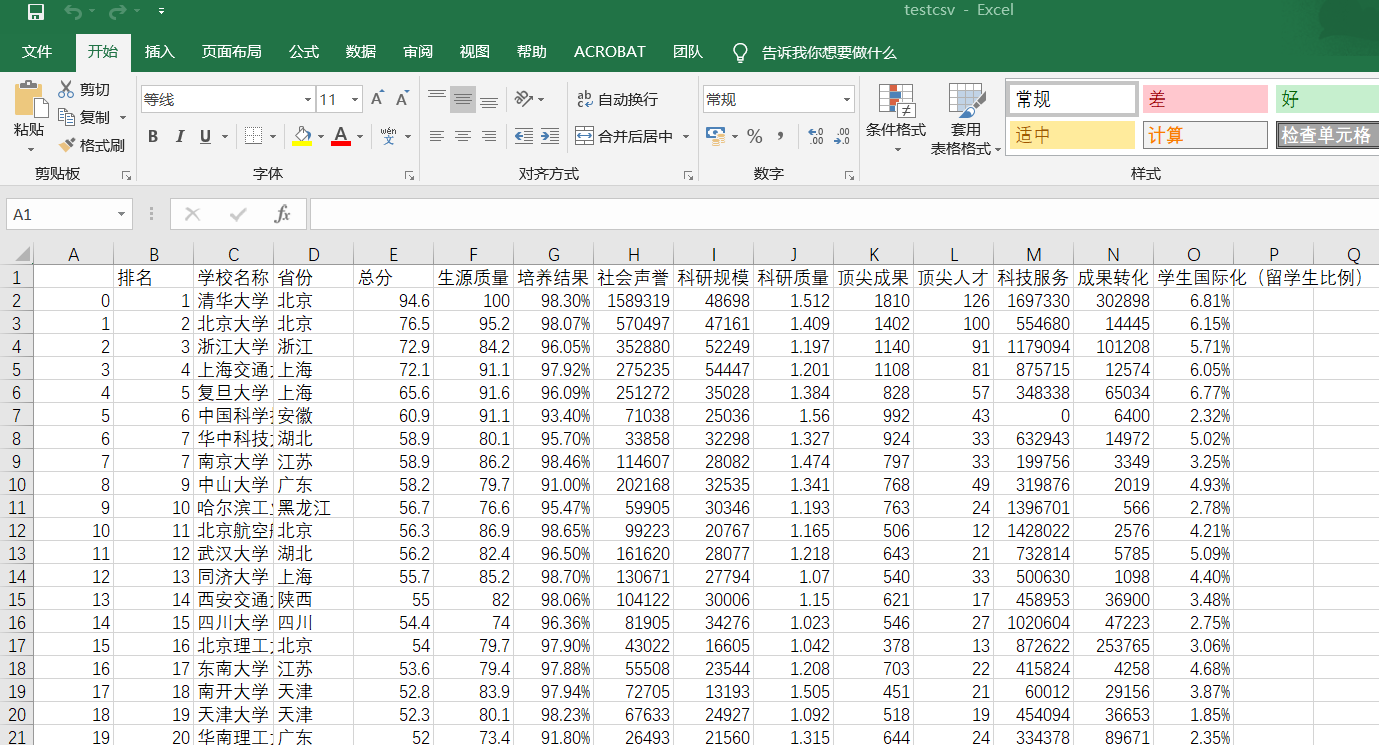

三.爬取中国大学排名

from bs4 import BeautifulSoup

import requests

import pandas as pd allUniv = [] def getHTMLText(url):

try:

r = requests.get(url, timeout=10)

r.raise_for_status()

r.encoding = 'utf-8'

return r.text

except:

return ""

def filUnivList(soup):

data = soup.find_all('tr')

for tr in data:

ltd = tr.find_all('td')

if len(ltd) == 0:

continue

singleUniv = []

for td in ltd:

singleUniv.append(td.string)

allUniv.append(singleUniv)

write_csv(allUniv) def write_csv(list):

name = ['排名', '学校名称', '省份', '总分', '生源质量(新生高考成绩得分)', '培养结果(毕业生就业率)', '社会声誉(社会捐赠收入·千元)', '科研规模(论文数量·篇)',\

'科研质量(论文质量·FWCI)', '顶尖成果(高被引论文·篇)', '顶尖人才(高被引学者·人)', '科技服务(企业科研经费·千元)', '成果转化(技术转让收入·千元)', '学生国际化(留学生比例)']

name2 = ['a', 'b', 'c']

test = pd.DataFrame(columns=name, data=list)

test.to_csv('e:/testcsv.csv', encoding='gbk') def main():

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html'

html = getHTMLText(url)

soup = BeautifulSoup(html, "html.parser")

filUnivList(soup)

print("完成") main()

效果图:

2019-05-19 Python之第一个爬虫和测试的更多相关文章

- 孤荷凌寒自学python第八十天开始写Python的第一个爬虫10

孤荷凌寒自学python第八十天开始写Python的第一个爬虫10 (完整学习过程屏幕记录视频地址在文末) 原计划今天应当可以解决读取所有页的目录并转而取出所有新闻的功能,不过由于学习时间不够,只是进 ...

- 孤荷凌寒自学python第七十九天开始写Python的第一个爬虫9并使用pydocx模块将结果写入word文档

孤荷凌寒自学python第七十九天开始写Python的第一个爬虫9 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 到今天终于完成了对docx模块针对 ...

- 孤荷凌寒自学python第七十五天开始写Python的第一个爬虫5

孤荷凌寒自学python第七十五天开始写Python的第一个爬虫5 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 直接上代码.详细过程见文末屏幕录像 ...

- 孤荷凌寒自学python第七十四天开始写Python的第一个爬虫4

孤荷凌寒自学python第七十四天开始写Python的第一个爬虫4 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 直接上代码.详细过程见文末屏幕录像 ...

- 孤荷凌寒自学python第七十三天开始写Python的第一个爬虫3

孤荷凌寒自学python第七十三天开始写Python的第一个爬虫3 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 直接上代码.详细过程见文末屏幕录像 ...

- 孤荷凌寒自学python第七十二天开始写Python的第一个爬虫2

孤荷凌寒自学python第七十二天开始写Python的第一个爬虫2 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 直接上代码.详细过程见文末屏幕录像 ...

- 孤荷凌寒自学python第七十一天开始写Python的第一个爬虫

孤荷凌寒自学python第七十一天开始写Python的第一个爬虫 (完整学习过程屏幕记录视频地址在文末) 在了解了requests模块和BeautifulSoup模块后,今天开始真正写一个自己的爬虫代 ...

- 孤荷凌寒自学python第七十八天开始写Python的第一个爬虫8

孤荷凌寒自学python第七十八天开始写Python的第一个爬虫8 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 到今天止基本完成了对docx模块针 ...

- 孤荷凌寒自学python第七十七天开始写Python的第一个爬虫7

孤荷凌寒自学python第七十七天开始写Python的第一个爬虫7 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 今天的学习仍然是在纯粹对docx模 ...

随机推荐

- 【ES】Java High Level REST Client 使用示例(增加修改)

ES提供了多种编程语言的链接方式,有Java API,PHP API,.NET API 官网可以详细了解 https://www.elastic.co/guide/en/elasticsearch/c ...

- iOS 原生库(AVFoundation)实现二维码扫描,封装的工具类,不依赖第三方库,可高度自定义扫描动画及界面(Swift 4.0)

Create QRScanner.swift file // // QRScanner.swift // NativeQR // // Created by Harvey on 2017/10/24. ...

- Swift 4.0 数组(Array)之过滤器(filter)的使用

我们先来定义一个常量整型数组 let array = [5, 4, 3, 1, 2] 过滤器(filter)使用之筛选出大于3的值 let resultArray = array.filter { ( ...

- Python:(使用matplotlib画图)次坐标轴,两个坐标轴

https://blog.csdn.net/Poul_henry/article/details/82533569

- Building Applications with Force.com and VisualForce(Dev401)(十):Designing Applications for Multiple Users: Building Business Processes that You Want

Dev401-011: Building Business Processes that You Want Course Objectives1.Describe the capabilities o ...

- 5分钟配置好你的AI开发环境

作者 | Revolver 无论是第一次设置TensorFlow的新手数据科学爱好者,还是使用TB级数据的经验丰富的AI工程师,安装库.软件包或者框架总是一个困难又繁琐的过程.但是像Docker这样的 ...

- PHP一致性hash

PHP提供了两种比较两个变量的方法: 松散比较使用 == or != : 两个变量都具有“相同的值”. 严格比较 === or !== : 两个变量都具有“相同的类型和相同的值”. 类型杂耍 真实陈述 ...

- macbook中出现2003 - Can't connect to MySQL server on '127.0.0.1' (61 "Connection refused") 如何解决

第一步 关闭mysql服务: 苹果->系统偏好设置->最下边点mysql 在弹出页面中 关闭mysql服务(点击stop mysql server) 如果这种方法没有成功: 可以使用命令行 ...

- 怎么获取WebAPI项目中图片在服务端的路径

1.这是我的项目结构. 2.路径格式为:[http://服务器域名/文件夹/文件.扩展名] 测试:假如我要获取到[logo_icon.jpg]这张图.在浏览器的地址栏中输入上面那个格式的路径. 3.可 ...

- ML-Agents(四)GridWorld

目录 ML-Agents(四)GridWorld Visual Observations Masking Discrete Actions 环境与训练参数 场景基本结构 代码分析 环境初始化代码 Ag ...