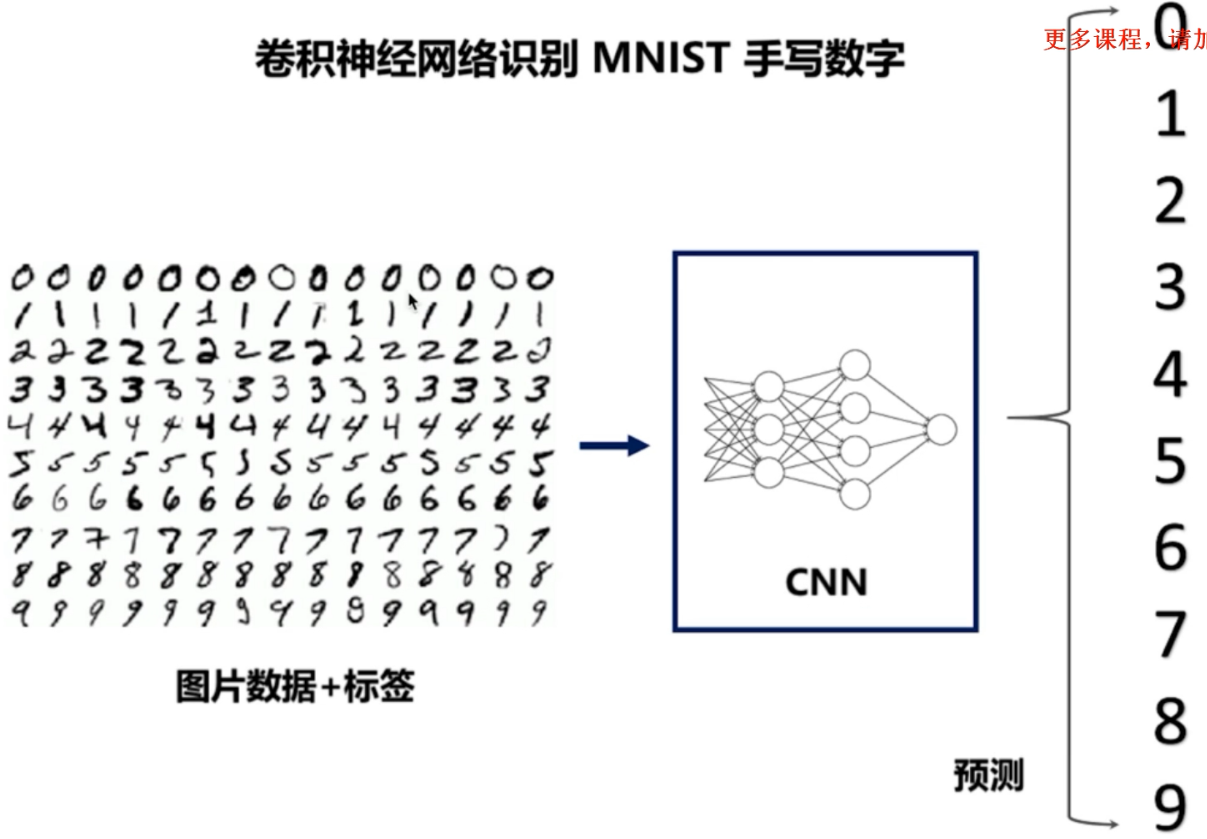

动手实现CNN卷积神经网络

数据集采用的是手写数据集(http://yann.lecun.com/exdb/mnist/):

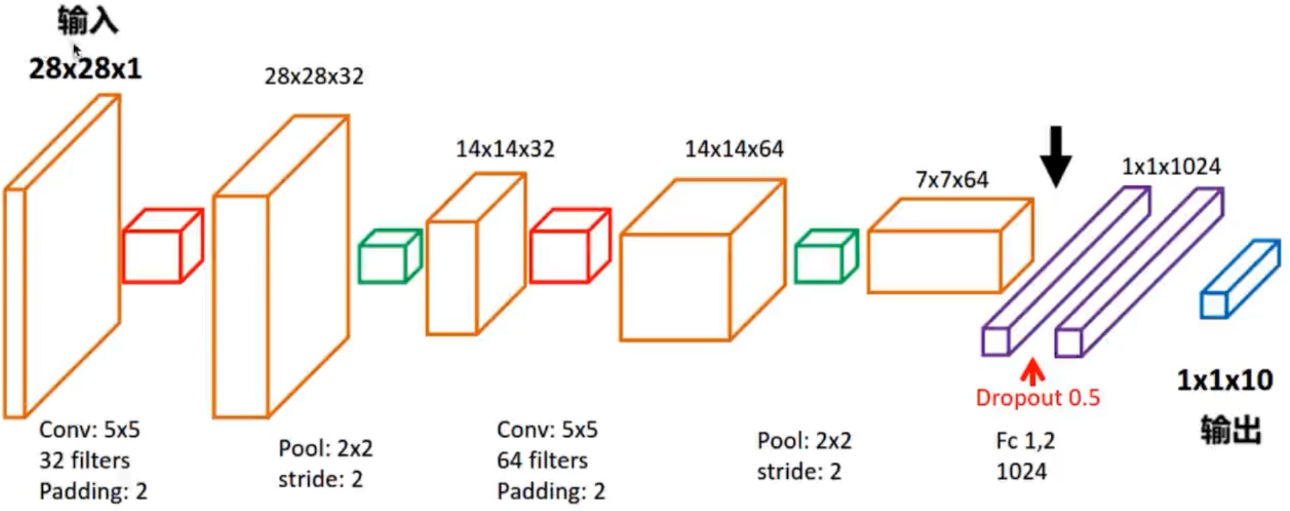

本文构建的CNN网络图如下:

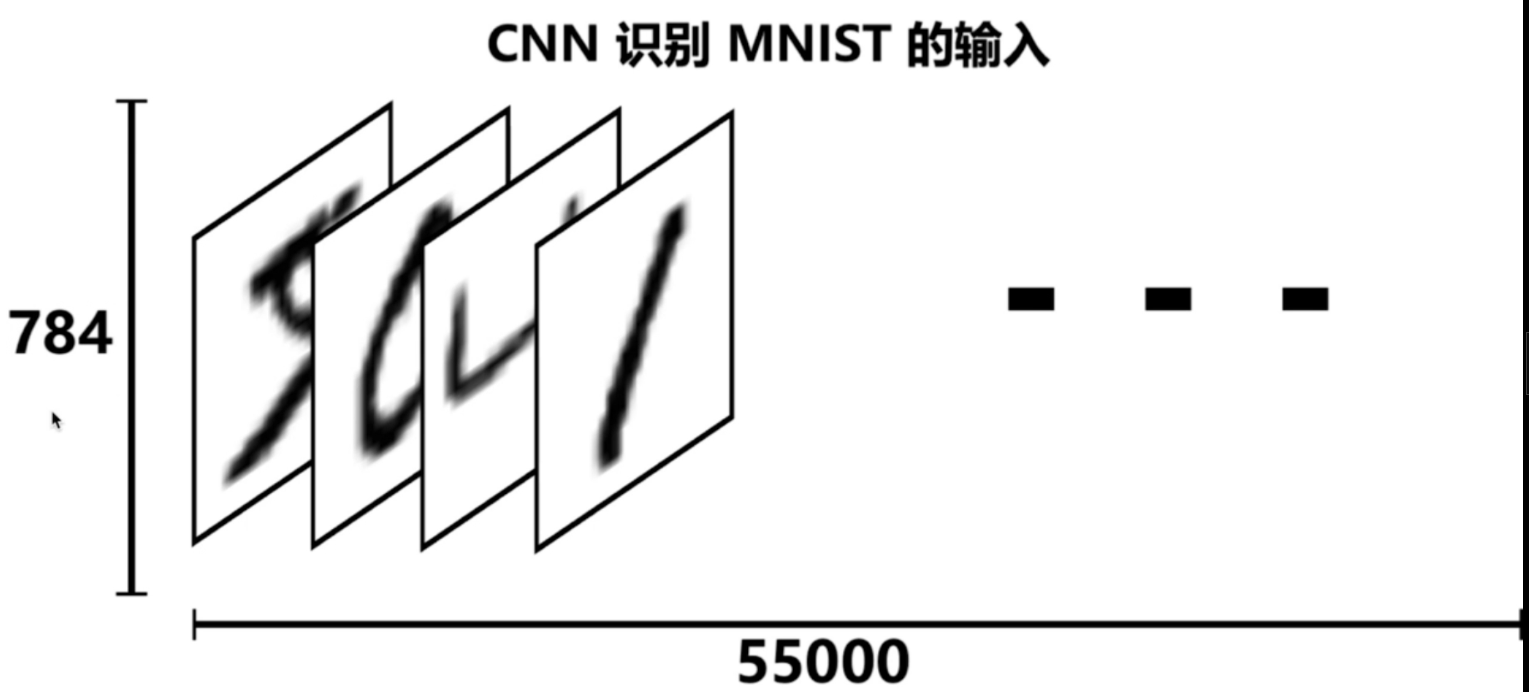

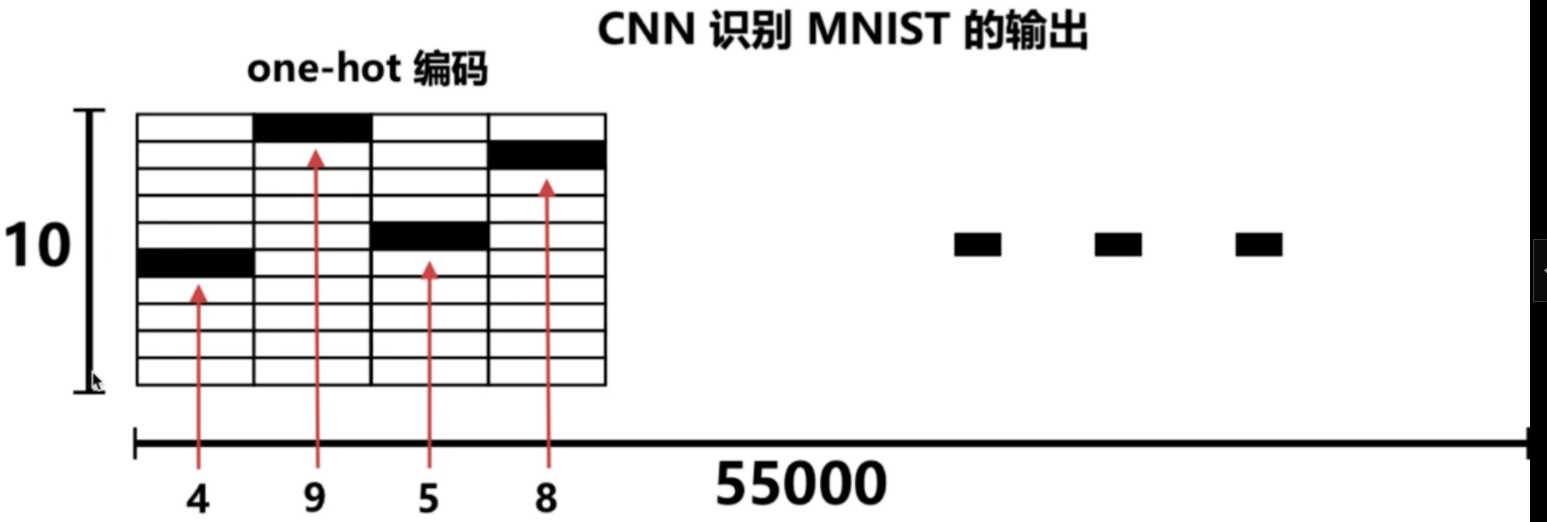

像素点:28*28 = 784,55000张手写数字图片。

# -*- coding: UTF-8 -*- import numpy as np

import tensorflow as tf # 下载并载入 MNIST 手写数字库(55000 * 28 * 28)55000 张训练图像

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets('mnist_data', one_hot=True)#将数据保存在mnist_data下 # one_hot 独热码的编码(encoding)形式

# 0, 1, 2, 3, 4, 5, 6, 7, 8, 9 的十位数字

# 0 : 1000000000

# 1 : 0100000000

# 2 : 0010000000

# 3 : 0001000000

# 4 : 0000100000

# 5 : 0000010000

# 6 : 0000001000

# 7 : 0000000100

# 8 : 0000000010

# 9 : 0000000001 # None 表示张量(Tensor)的第一个维度可以是任何长度

# 除以 255 是为了做 归一化(Normalization),把灰度值从 [0, 255] 变成 [0, 1] 区间

# 归一话可以让之后的优化器(optimizer)更快更好地找到误差最小值

input_x = tf.placeholder(tf.float32, [None, 28 * 28]) / 255. # 输入 output_y = tf.placeholder(tf.int32, [None, 10]) # 输出:10个数字的标签 # -1 表示自动推导维度大小。让计算机根据其他维度的值

# 和总的元素大小来推导出 -1 的地方的维度应该是多少

input_x_images = tf.reshape(input_x, [-1, 28, 28, 1]) # 改变形状之后的输入 # 从 Test(测试)数据集里选取 3000 个手写数字的图片和对应标签

test_x = mnist.test.images[:3000] # 图片

test_y = mnist.test.labels[:3000] # 标签 # 构建我们的卷积神经网络:

# 第 1 层卷积

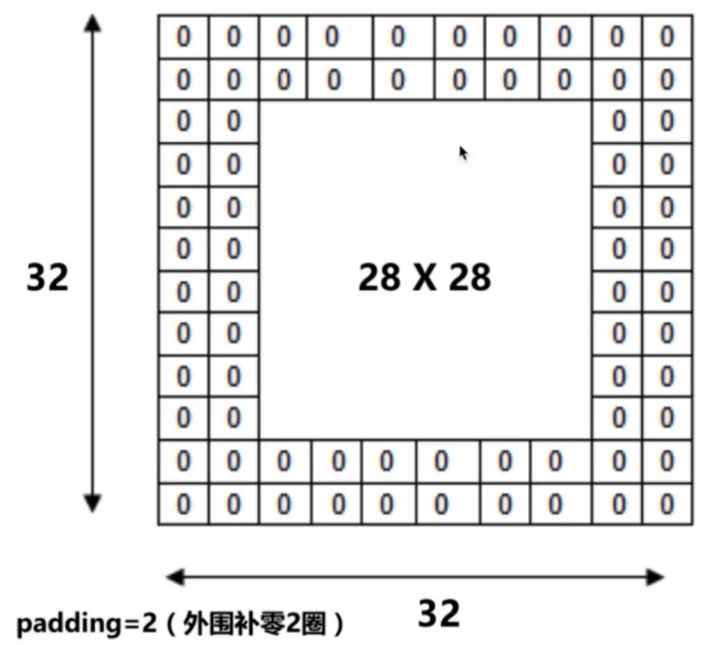

conv1 = tf.layers.conv2d( #conv2d指的是2维卷积

inputs=input_x_images, # 形状 [28, 28, 1]

filters=32, # 32 个过滤器,输出的深度(depth)是32

kernel_size=[5, 5], # 过滤器在二维的大小是 (5 * 5)

strides=1, # 步长是 1

padding='same', # same 表示输出的大小不变,因此需要在外围补零 2 圈

activation=tf.nn.relu # 激活函数是 Relu

) # 经过第一层卷积后输出的形状为 [28, 28, 32] # 第 1 层池化(亚采样)

pool1 = tf.layers.max_pooling2d(

inputs=conv1, # 形状 [28, 28, 32]

pool_size=[2, 2], # 过滤器在二维的大小是(2 * 2)

strides=2 # 步长是 2

) # 经过第 1 层池化后输出的形状 [14, 14, 32] # 第 2 层卷积

conv2 = tf.layers.conv2d(

inputs=pool1, # 形状 [14, 14, 32]

filters=64, # 64 个过滤器,输出的深度(depth)是64

kernel_size=[5, 5], # 过滤器在二维的大小是 (5 * 5)

strides=1, # 步长是 1

padding='same', # same 表示输出的大小不变,因此需要在外围补零 2 圈

activation=tf.nn.relu # 激活函数是 Relu

) # 经过第二层卷积后输出的形状为 [14, 14, 64] # 第 2 层池化(亚采样)

pool2 = tf.layers.max_pooling2d(

inputs=conv2, # 形状 [14, 14, 64]

pool_size=[2, 2], # 过滤器在二维的大小是(2 * 2)

strides=2 # 步长是 2

) # 形状 [7, 7, 64] # 平坦化(flat)。降维

flat = tf.reshape(pool2, [-1, 7 * 7 * 64]) # 形状 [7 * 7 * 64, ] # 1024 个神经元的全连接层

dense = tf.layers.dense(inputs=flat, units=1024, activation=tf.nn.relu) # Dropout : 丢弃 50%(rate=0.5)

dropout = tf.layers.dropout(inputs=dense, rate=0.5) # 10 个神经元的全连接层,这里不用激活函数来做非线性化了

logits = tf.layers.dense(inputs=dropout, units=10) # 输出。形状 [1, 1, 10] # 计算误差(先用 Softmax 计算百分比概率,

# 再用 Cross entropy(交叉熵)来计算百分比概率和对应的独热码之间的误差)

loss = tf.losses.softmax_cross_entropy(onehot_labels=output_y, logits=logits)

#onehot_labels指的是实际的标签值,logits指的是卷积神经网络的预测输出 # Adam 优化器来最小化误差,学习率 0.001

train_op = tf.train.AdamOptimizer(learning_rate=0.001).minimize(loss) # 精度。计算 预测值 和 实际标签 的匹配程度

# 返回 (accuracy, update_op), 会创建两个局部变量

accuracy = tf.metrics.accuracy(

labels=tf.argmax(output_y, axis=1),#第一个参数labels为真实标签 注:tf.argmax返回的是最大值的下标

predictions=tf.argmax(logits, axis=1),)[1]#第二个参数predictions为预测标签 # 创建会话

sess = tf.Session()

# 初始化变量:全局和局部

init = tf.group(tf.global_variables_initializer(), tf.local_variables_initializer())

sess.run(init) # 训练 5000 步。这个步数可以调节

for i in range(5000):

batch = mnist.train.next_batch(50) # 从 Train(训练)数据集里取 “下一个” 50 个样本

train_loss, train_op_ = sess.run([loss, train_op], {input_x: batch[0], output_y: batch[1]})

if i % 100 == 0:

test_accuracy = sess.run(accuracy, {input_x: test_x, output_y: test_y})

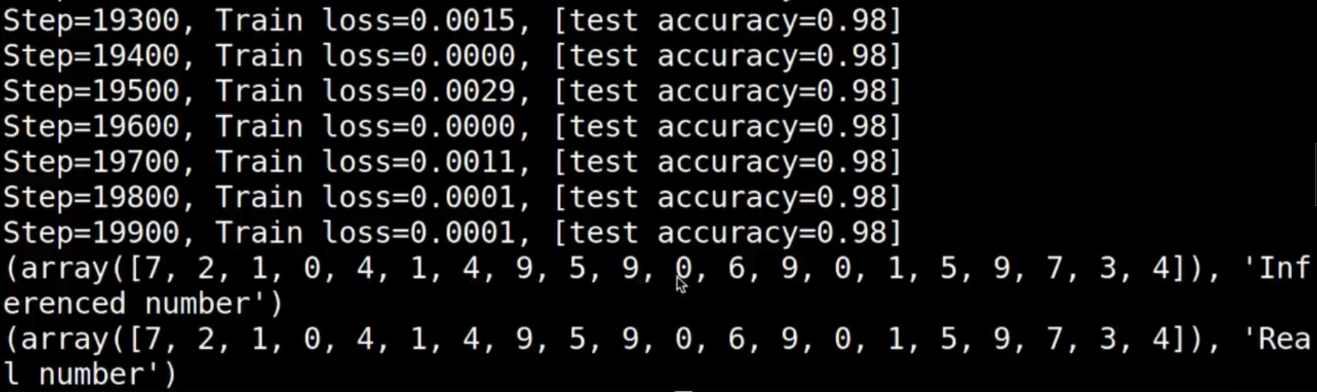

print("第 {} 步的 训练损失={:.4f}, 测试精度={:.2f}".format(i, train_loss, test_accuracy)) # 测试:打印 20 个预测值 和 真实值

test_output = sess.run(logits, {input_x: test_x[:20]})

inferred_y = np.argmax(test_output, 1)

print(inferred_y, '推测的数字') # 推测的数字

print(np.argmax(test_y[:20], 1), '真实的数字') # 真实的数字 # 关闭会话

sess.close()

结果:

动手实现CNN卷积神经网络的更多相关文章

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

https://www.zhihu.com/question/34681168 CNN(卷积神经网络).RNN(循环神经网络).DNN(深度神经网络)的内部网络结构有什么区别?修改 CNN(卷积神经网 ...

- Deep Learning模型之:CNN卷积神经网络(一)深度解析CNN

http://m.blog.csdn.net/blog/wu010555688/24487301 本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep le ...

- [转]Theano下用CNN(卷积神经网络)做车牌中文字符OCR

Theano下用CNN(卷积神经网络)做车牌中文字符OCR 原文地址:http://m.blog.csdn.net/article/details?id=50989742 之前时间一直在看 Micha ...

- Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现(转)

Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文, ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN,LSTM

http://cs231n.github.io/neural-networks-1 https://arxiv.org/pdf/1603.07285.pdf https://adeshpande3.g ...

- day-16 CNN卷积神经网络算法之Max pooling池化操作学习

利用CNN卷积神经网络进行训练时,进行完卷积运算,还需要接着进行Max pooling池化操作,目的是在尽量不丢失图像特征前期下,对图像进行downsampling. 首先看下max pooling的 ...

- cnn(卷积神经网络)比较系统的讲解

本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep learning简介 [2]Deep Learning训练过程 [3]Deep Learning模型之 ...

- Keras(四)CNN 卷积神经网络 RNN 循环神经网络 原理及实例

CNN 卷积神经网络 卷积 池化 https://www.cnblogs.com/peng8098/p/nlp_16.html 中有介绍 以数据集MNIST构建一个卷积神经网路 from keras. ...

- TensorFlow——CNN卷积神经网络处理Mnist数据集

CNN卷积神经网络处理Mnist数据集 CNN模型结构: 输入层:Mnist数据集(28*28) 第一层卷积:感受视野5*5,步长为1,卷积核:32个 第一层池化:池化视野2*2,步长为2 第二层卷积 ...

随机推荐

- matlab图像灰度调整——imadjust函数的使用

在MATLAB中,通过函数imadjust()进行图像灰度的调整,该函数调用格式如下: J=imadjust( I ) 对图像I进行灰度调整 J=imadjust( I,[low_in;high_i ...

- 超详细Qt5.9.5移植攻略

本文就来介绍下如何将Qt5.9.5移植到ARM开发板上. 以imx6开发板为例,使用Ubuntu14.04虚拟机作为移植环境. 准备工作 1.主机环境:Ubuntu14.04: 开发板:启扬IAC-I ...

- MySQL查询获取行号rownum

MySQL中可以使用变量产生行号,下面是2个简单例子: 使用工具:MySQL Workbench 说明:表heyf_10中字段,empid(员工工号).deptid(部门编号).salary(薪资): ...

- android studio: 让项目通过阿里云 maven jcenter 下载依赖资源

打开项目根目录下的 build.gradle(Project:项目名称一级的gradle),如下所示添加阿里 maven 库地址: // Top-level build file where you ...

- 解读typescript中 super关键字的用法

解读typescript中 super关键字的用法 传统的js,使用prototype实现父.子类继承.如果父.子类有同名的方法,子类去调用父类的同名方法需要用 “父类.prototype.metho ...

- C语言 消灭编译警告(Warning)

如何看待编译警告 当编译程序发现程序中某个地方有疑问,可能有问题时就会给出一个警告信息.警告信息可能意味着程序中隐含的大错误,也可能确实没有问题.对于警告的正确处理方式应该是:尽可能地消除之.对于编译 ...

- ifc构件加载到树形控件中

void IfcTreeWidget::setParentCheckState(QTreeWidgetItem *item) { if(!item) return; ; int childCount ...

- BIM IFC算量

1.基础工程:挖槽.垫层.基础底板.基础墙.地圈梁.暖气沟.回填土等:2.主体工程:梁.板.柱.墙等:3.屋顶工程:挑檐.女儿墙.保温.防水.压顶等:4.装修工程:外墙抹灰.墙裙.门窗套.内墙抹灰.粉 ...

- vue-slicksort拖拽组件

vue-slicksort拖拽组件 安装 通过npm安装 $ npm install vue-slicksort --save 通过yarn安装 $ yarn add vue-slicksort 插件 ...

- selenium3 web自动化测试框架 四:Unittest介绍及项目实战中的运用

unittest介绍及运用,可以参考之前写的文章,除了未结合web自动化演示,基础知识都有了 https://www.cnblogs.com/wuzhiming/p/8858305.html unit ...