分布式爬虫搭建系列 之三---scrapy框架初用

第一,scrapy框架的安装

通过命令提示符进行安装(如果没有安装的话)

pip install Scrapy

如果需要卸载的话使用命令为:

pip uninstall Scrapy

第二,scrapy框架的使用

先通过命令提示符创建项目,运行命令:

scrapy startproject crawlquote#crawlquote这是我起的项目名

其次,通过我们的神器PyCharm打开我们的项目--crawlquote(也可以将PyCharm打开我们使用虚拟环境创建的项目)

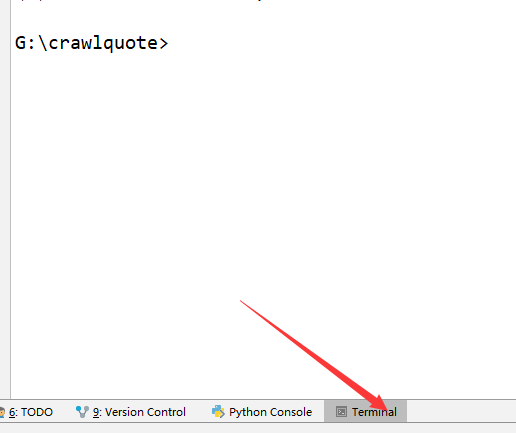

然后,打开PyCharm的Terminal,如图

然后在命令框中输入

scrapy genspider quotes quotes.toscrape.com

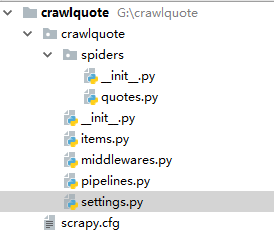

此时的代码目录为:

文件说明:

scrapy.cfg 项目的配置信息,主要为Scrapy命令行工具提供一个基础的配置信息。(真正爬虫相关的配置信息在settings.py文件中)

items.py 设置数据存储模板,用于结构化数据,如:Django的Model

pipelines 数据处理行为,如:一般结构化的数据持久化

settings.py 配置文件,如:递归的层数、并发数,延迟下载等

spiders 爬虫目录,如:创建文件,编写爬虫规则

quotes.py使我们书写的爬虫---里面是发起请求-->拿到数据---->临时存储到item.py中

运行爬虫命令为:

scrapy crawl quotes

第三,使用scrapy的基本流程

(1)明确需要爬取的数据有哪些

(2)分析页面结构知道需要爬取的内容在页面中的存在形式

(3)在item.py中定义需要爬取的数据的存储字段

(4)书写爬虫 -spider中定义(spiders中的quotes.py) --数据重新格式化化后在item.py中存储

(5)管道中--pipeline.py ----对item里面的内容在加工 , 以及定义链接数据库的管道

(6)配置文件中----settings.py中开启管道作用:ITEM_PIPELINES ,定义数据库的名称,以及链接地址

(7)中间件中----middlewares.py

根据上述的一个简单的代码演示:

1)item.py中

import scrapy class CrawlquoteItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

text = scrapy.Field()

author = scrapy.Field()

tags = scrapy.Field()

2)spiders--quotes(爬虫)

# -*- coding: utf- -*-

import scrapy

from crawlquote.items import CrawlquoteItem class QuotesSpider(scrapy.Spider):

name = 'quotes'

allowed_domains = ['quotes.toscrape.com']

start_urls = ['http://quotes.toscrape.com/'] def parse(self, response):

quotes = response.css('.quote')

for quote in quotes:

item = CrawlquoteItem()

text = quote.css('.text::text').extract_first() # 获取一个

author = quote.css('.author::text').extract_first()

tags = quote.css('.tags .tag::text').extract()

item['text'] = text

item['author'] = author

item['tags'] = tags

yield item # 将网页中的内容重新生成一个item以便于后面的认识 next = response.css('.pager .next a::attr(href)').extract_first()

url = response.urljoin(next) # urljoin翻页

yield scrapy.Request(url=url, callback=self.parse) # 递归调用

3)pipeline.py中

# -*- coding: utf- -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

import pymongo

from scrapy.exceptions import DropItem class TextPipeline(object):

def __init__(self):

self.limit = def process_item(self, item, spider): # 对重新生成的item进行再制作

if item['text']:

if len(item['text']) > self.limit:

item['text'] = item['text'][:self.limit].rstrip() + '...'

return item

else:

return DropItem('Missing Text') class MongoPipeline(object): # 与数据库有关的操作

def __init__(self, mongo_uri, mongo_db): # () MongoPipeline构造函数

self.mongo_uri = mongo_uri

self.mongo_db = mongo_db @classmethod

def from_crawler(cls, crawler): # ()读取settings里面的值,类方法

return cls(

mongo_uri=crawler.settings.get('MONGO_URI'),

mongo_db=crawler.settings.get('MONGO_DB')

) def open_spider(self, spider): # ()爬虫启动时需要的操作

self.client = pymongo.MongoClient(self.mongo_uri)

self.db = self.client[self.mongo_db] def process_item(self, item, spider): # 保存到mongodb数据库

name = item.__class__.__name__

self.db[name].insert(dict(item))

return item def close_spider(self, spider): # 关闭mongodb

self.client.close()

4)settings.py中

BOT_NAME = 'crawlquote' SPIDER_MODULES = ['crawlquote.spiders']

NEWSPIDER_MODULE = 'crawlquote.spiders' #数据库链接

MONGO_URI = 'localhost'

MONGO_DB = 'crawlquote' #项目管道开启

ITEM_PIPELINES = {

'crawlquote.pipelines.TextPipeline': ,

'crawlquote.pipelines.MongoPipeline': ,

}

5)此处还没有用的middelwares.py

总结一下:

针对某部分数据的爬取,先要在item中定义字段,然后在爬虫程序中通过选择器拿到数据并存储到item中,再然后通过pipeline的在加工+setting文件修改--存储到数据库中。此时简单爬取就实现了。

分布式爬虫搭建系列 之三---scrapy框架初用的更多相关文章

- 分布式爬虫搭建系列 之四---scrapy分布式框架

带录入SAFCDS

- 分布式爬虫搭建系列 之一------python安装及以及虚拟环境的配置及scrapy依赖库的安装

python及scrapy框架依赖库的安装步骤: 第一步,python的安装 在Windows上安装Python 首先,根据你的Windows版本(64位还是32位)从Python的官方网站下载Pyt ...

- 分布式爬虫搭建系列 之二-----神器PyCharm的安装

这里我们使用PyCharm作为开发工具,以下过程摘抄于:http://blog.csdn.net/qq_29883591/article/details/52664478 作者:陌上行走 Pytho ...

- Python爬虫进阶三之Scrapy框架安装配置

初级的爬虫我们利用urllib和urllib2库以及正则表达式就可以完成了,不过还有更加强大的工具,爬虫框架Scrapy,这安装过程也是煞费苦心哪,在此整理如下. Windows 平台: 我的系统是 ...

- 5、爬虫系列之scrapy框架

一 scrapy框架简介 1 介绍 (1) 什么是Scrapy? Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍.所谓的框架就是一个已经被集成了各种功能(高性能 ...

- 爬虫系列之Scrapy框架

一 scrapy框架简介 1 介绍 (1) 什么是Scrapy? Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍.所谓的框架就是一个已经被集成了各种功能(高性能 ...

- 爬虫(九)scrapy框架简介和基础应用

概要 scrapy框架介绍 环境安装 基础使用 一.什么是Scrapy? Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍.所谓的框架就是一个已经被集成了各种功能 ...

- Python3爬虫(十七) Scrapy框架(一)

Infi-chu: http://www.cnblogs.com/Infi-chu/ 1.框架架构图: 2.各文件功能scrapy.cfg 项目的配置文件items.py 定义了Item数据结构,所有 ...

- 爬虫 (5)- Scrapy 框架简介与入门

Scrapy 框架 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页 ...

随机推荐

- MVC框架中的值提供机制(三)

在MVC框架中NameValueCollectionValueProvider采用一个NameValueCollection作为数据源,DictionnaryValueProvider的数据源类型自然 ...

- 如何拿到半数面试公司Offer——我的Python求职之路(转载)

从八月底开始找工作,短短的一星期多一些,面试了9家公司,拿到5份Offer,可能是因为我所面试的公司都是些创业性的公司吧,不过还是感触良多,因为学习Python的时间还很短,没想到还算比较容易的找到了 ...

- 【数据库】python访问mysql

import MySQLdb 所有的数据库遵循相同的python database API 需要建立connection对象连接数据库,之后建立cursor对象处理数据. conn = MySQLdb ...

- Uncaught TypeError: Cannot read property 'decimalSeparator' of undefined

1.错误描述 jquery.jqGrid.min.js:477 Uncaught TypeError: Cannot read property 'decimalSeparator' of undef ...

- Hive——巧用transform处理复杂的字符串问题

相比于Map-Reduce,Hive对数据的处理相对简单,但是Hive本身提供的函数,对于处理复杂的字符串问题,就显得不是很方便,此时,可以借助transform,引入外界的Python程序对字符串进 ...

- Andriod部分手机频繁闪退,vivo y55a等,Skipped 62 frames! The application may be doing too much work on its main thread

问题描述: 部分手机频繁闪退的问题.比如:vivo y55a,在升级.交任务.穿戴装备等都有概率闪退... 表现: 卡几帧就马上闪退. 在学习技能.穿戴装备.升级等概率出现,新角色第3个任务“拦截少年 ...

- Python读取指定目录下指定后缀文件并保存为docx

最近有个奇葩要求 要项目中的N行代码 申请专利啥的 然后作为程序员当然不能复制粘贴 用代码解决.. 使用python-docx读写docx文件 环境使用python3.6.0 首先pip安装pytho ...

- asp.net mvc获得请求体所有内容

代码如下 Stream req = Request.InputStream; req.Seek(0, System.IO.SeekOrigin.Begin); string json = new St ...

- GitLab non-standard SSH port

/***************************************************************************** * GitLab non-standard ...

- 【MFC】MFC绘图不闪烁——双缓冲技术

MFC绘图不闪烁——双缓冲技术[转] 2010-04-30 09:33:33| 分类: VC|举报|字号 订阅 [转自:http://blog.163.com/yuanlong_zheng@126/ ...