[Python]jieba切词 添加字典 去除停用词、单字 python 2020.2.10

源码如下:

import jieba

import io

import re #jieba.load_userdict("E:/xinxi2.txt")

patton=re.compile(r'..') #添加字典

def add_dict():

f=open("E:/xinxi2.txt","r+",encoding="utf-8") #百度爬取的字典

for line in f:

jieba.suggest_freq(line.rstrip("\n"), True)

f.close() #对句子进行分词

def cut():

number=0

f=open("E:/luntan.txt","r+",encoding="utf-8") #要处理的内容,所爬信息,CSDN论坛标题

for line in f:

line=seg_sentence(line.rstrip("\n"))

seg_list=jieba.cut(line)

for i in seg_list:

print(i) #打印词汇内容

m=patton.findall(i)

#print(len(m)) #打印字符长度

if len(m)!=0:

write(i.strip()+" ")

line=line.rstrip().lstrip()

print(len(line))#打印句子长度

if len(line)>1:

write("\n")

number+=1

print("已处理",number,"行") #分词后写入

def write(contents):

f=open("E://luntan_cut2.txt","a+",encoding="utf-8") #要写入的文件

f.write(contents)

#print("写入成功!")

f.close() #创建停用词

def stopwordslist(filepath):

stopwords = [line.strip() for line in open(filepath, 'r', encoding='utf-8').readlines()]

return stopwords # 对句子进行去除停用词

def seg_sentence(sentence):

sentence_seged = jieba.cut(sentence.strip())

stopwords = stopwordslist('E://stop.txt') # 这里加载停用词的路径

outstr = ''

for word in sentence_seged:

if word not in stopwords:

if word != '\t':

outstr += word

#outstr += " "

return outstr #循环去除、无用函数

def cut_all():

inputs = open('E://luntan_cut.txt', 'r', encoding='utf-8')

outputs = open('E//luntan_stop.txt', 'a')

for line in inputs:

line_seg = seg_sentence(line) # 这里的返回值是字符串

outputs.write(line_seg + '\n')

outputs.close()

inputs.close() if __name__=="__main__":

add_dict()

cut()

luntan.txt的来源,地址:https://www.cnblogs.com/zlc364624/p/12285055.html

其中停用词可自行百度下载,或者自己创建一个txt文件夹,自行添加词汇用换行符隔开。

百度爬取的字典在前几期博客中可以找到,地址:https://www.cnblogs.com/zlc364624/p/12289008.html

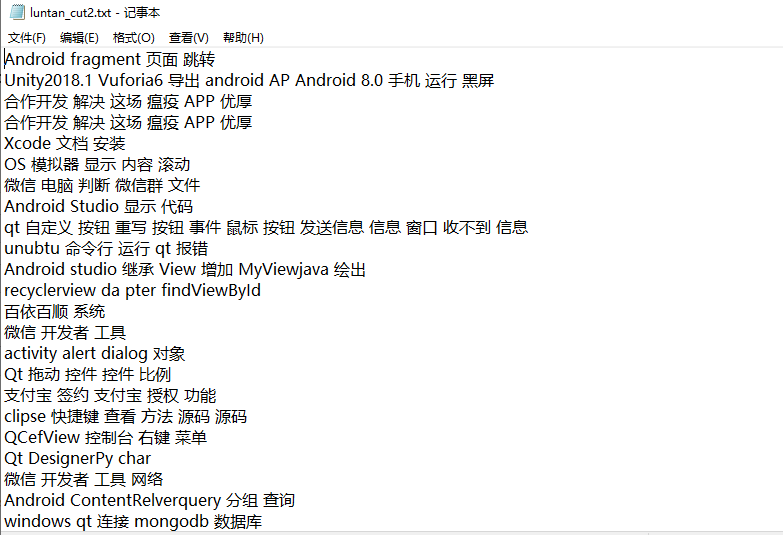

效果如下:

import jieba

import io

import re #jieba.load_userdict("E:/xinxi2.txt")

patton=re.compile(r'..') #添加字典

def add_dict():

f=open("E:/xinxi2.txt","r+",encoding="utf-8") #百度爬取的字典

for line in f:

jieba.suggest_freq(line.rstrip("\n"), True)

f.close() #对句子进行分词

def cut():

number=0

f=open("E:/luntan.txt","r+",encoding="utf-8") #要处理的内容,所爬信息,CSDN论坛标题

for line in f:

line=seg_sentence(line.rstrip("\n"))

seg_list=jieba.cut(line)

for i in seg_list:

print(i) #打印词汇内容

m=patton.findall(i)

#print(len(m)) #打印字符长度

if len(m)!=:

write(i.strip()+" ")

line=line.rstrip().lstrip()

print(len(line))#打印句子长度

if len(line)>:

write("\n")

number+=1

print("已处理",number,"行") #分词后写入

def write(contents):

f=open("E://luntan_cut2.txt","a+",encoding="utf-8") #要写入的文件

f.write(contents)

#print("写入成功!")

f.close() #创建停用词

def stopwordslist(filepath):

stopwords = [line.strip() for line in open(filepath, 'r', encoding='utf-8').readlines()]

return stopwords # 对句子进行去除停用词

def seg_sentence(sentence):

sentence_seged = jieba.cut(sentence.strip())

stopwords = stopwordslist('E://stop.txt') # 这里加载停用词的路径

outstr = ''

for word in sentence_seged:

if word not in stopwords:

if word != '\t':

outstr += word

#outstr += " "

return outstr #循环去除、无用函数

def cut_all():

inputs = open('E://luntan_cut.txt', 'r', encoding='utf-8')

outputs = open('E//luntan_stop.txt', 'a')

for line in inputs:

line_seg = seg_sentence(line) # 这里的返回值是字符串

outputs.write(line_seg + '\n')

outputs.close()

inputs.close() if __name__=="__main__":

add_dict()

cut()

[Python]jieba切词 添加字典 去除停用词、单字 python 2020.2.10的更多相关文章

- jieba文本分词,去除停用词,添加用户词

import jieba from collections import Counter from wordcloud import WordCloud import matplotlib.pyplo ...

- python去除停用词(结巴分词下)

python 去除停用词 结巴分词 import jieba #stopwords = {}.fromkeys([ line.rstrip() for line in open('stopword. ...

- (3.1)用ictclas4j进行中文分词,并去除停用词

酒店评论情感分析系统——用ictclas4j进行中文分词,并去除停用词 ictclas4j是中科院计算所开发的中文分词工具ICTCLAS的Java版本,因其分词准确率较高,而备受青睐. 注:ictcl ...

- python利用jieba进行中文分词去停用词

中文分词(Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个单独的词. 分词模块jieba,它是python比较好用的分词模块.待分词的字符串可以是 unicod ...

- 使用Python中的NLTK和spaCy删除停用词与文本标准化

概述 了解如何在Python中删除停用词与文本标准化,这些是自然语言处理的基本技术 探索不同的方法来删除停用词,以及讨论文本标准化技术,如词干化(stemming)和词形还原(lemmatizatio ...

- python编程基础知识—字典

字典 在python中,字典是一系列键-值对,每个键都与一个值相关联,可使用键来访问相关联的值.与键相关联的值可以是数字.字符串.列表乃至字典,即可将任何python对象用在字典中的值. 在pytho ...

- 如何在java中去除中文文本的停用词

1. 整体思路 第一步:先将中文文本进行分词,这里使用的HanLP-汉语言处理包进行中文文本分词. 第二步:使用停用词表,去除分好的词中的停用词. 2. 中文文本分词环境配置 使用的HanLP-汉 ...

- 词项邻近 & 停用词 & 词干还原

[词项邻近] 邻近操作符(proximity)用于指定查询中的两个词项应该在文档中互相靠近,靠近程度通常采用两者之间的词的个数或者是否同在某个结构单元(如句 子或段落)中出现来衡量. [停用词] 一些 ...

- python jieba分词(添加停用词,用户字典 取词频

中文分词一般使用jieba分词 1.安装 pip install jieba 2.大致了解jieba分词 包括jieba分词的3种模式 全模式 import jieba seg_list = jieb ...

随机推荐

- 一起了解 .Net Foundation 项目 No.6

.Net 基金会中包含有很多优秀的项目,今天就和笔者一起了解一下其中的一些优秀作品吧. 中文介绍 中文介绍内容翻译自英文介绍,主要采用意译.如与原文存在出入,请以原文为准. .NET Micro Fr ...

- 智和网管平台SugarNMS 2019年度IT综合监控突破性成果概览

一元复始,万象更新,欢辞旧岁,喜迎新年. 智和信通,精益求精,携手并进,迎战鼠年! 2020年1月10日,北京智和信通技术有限公司(以下简称“智和信通”)以“2020携手并进”为主题的年度庆典暨201 ...

- Java的七大排序

一.各个算法的时间复杂度 二,具体实现 1.直接选择排序 基本思想:在长度为n的序列中,第一次遍历找到该序列的最小值,替换掉第一个元素,接着从第二个元素开始遍历,找到剩余序列中的最小值,替换掉第二个元 ...

- linux之ls目录处理命令

目录处理命令:ls 解释 命令名称:ls 命令英文原意:list 命令所在路径:/bin/ls 执行权限:所有用户 功能描述:显示目录文件 语法 ls 选项[-ald] [文件或目录] -a 显示所有 ...

- 大厂面试必问题!HashMap 怎样解决hash桶碰撞?

HashMap冲突解决方法比较考验一个开发者解决问题的能力.下文给出HashMap冲突的解决方法以及原理分析,无论是在面试问答或者实际使用中,应该都会有所帮助.在Java编程语言中,最基本的结构就是两 ...

- 理解一致性Hash算法

简介 一致性哈希算法在1997年由麻省理工学院的Karger等人在解决分布式Cache中提出的,设计目标是为了解决因特网中的热点(Hot spot)问题,初衷和CARP十分类似.一致性哈希修正了CAR ...

- MySQL数据库的两种连接方式:TCP/IP和Socket

Linux平台环境下主要有两种连接方式,一种是TCP/IP连接方式,另一种就是socket连接. 在Windows平台下,有name pipe和share memory(不考虑)两种. TCP/IP连 ...

- HTML5中input新增类型+表单新增属性+其他标签属性

@ (猴头) Input 新增属性 email 邮箱(只在手机端有效) url 网址(只在iphone手机有效) tel 手机号(只在手机端有效) number 数字(右侧有上下按钮,只能输入 ...

- jQuery---委托事件原理

jQuery事件发展历程 事件发展历程:从简单事件,到bind,到委托事件,到on事件绑定 //简单事件,给自己注册的事件 $("div").click(function () { ...

- maven的核心概念——创建war工程

第十七章第四个Maven工程(war工程) 17.1 创建步骤 ①第一步:创建maven web工程 ②第二步:修改web.xml <?xml version="1.0" e ...