利用Tensorflow实现手写字符识别

模式识别领域应用机器学习的场景非常多,手写识别就是其中一种,最简单的数字识别是一个多类分类问题,我们借这个多类分类问题来介绍一下google最新开源的tensorflow框架,后面深度学习的内容都会基于tensorflow来介绍和演示

请尊重原创,转载请注明来源网站www.shareditor.com以及原始链接地址

什么是tensorflow

tensor意思是张量,flow是流。

张量原本是力学里的术语,表示弹性介质中各点应力状态。在数学中,张量表示的是一种广义的“数量”,0阶张量就是标量(比如:0、1、2……),1阶张量就是向量(比如:(1,3,4)),2阶张量就是矩阵,本来这几种形式是不相关的,但是都归为张量,是因为他们同时满足一些特性:1)可以用坐标系表示;2)在坐标变换中遵守同样的变换法则;3)有着相同的基本运算(如:加、减、乘、除、缩放、点积、对称……)

那么tensorflow可以理解为通过“流”的形式来处理张量的一种框架,是由google开发并开源,已经应用于google大脑项目开发

tensorflow安装

sudo pip install https://storage.googleapis.com/tensorflow/mac/tensorflow-0.9.0-py2-none-any.whl不同平台找对应的whl包

可能遇到的问题:

发现无法import tensorflow,问题在于protobuf版本不对,必须先卸载掉,再安装tensorflow,这样会自动安装3.0版本的protobuf

sudo pip uninstall protobuf

sudo brew remove protobuf260

sudo pip install --upgrade https://storage.googleapis.com/tensorflow/mac/tensorflow-0.9.0-py2-none-any.whl手写数字数据集获取

在http://yann.lecun.com/exdb/mnist/可以下载手写数据集,http://yann.lecun.com/exdb/mnist/train-images-idx3-ubyte.gz和http://yann.lecun.com/exdb/mnist/train-labels-idx1-ubyte.gz,下载解压后发现不是图片格式,而是自己特定的格式,为了说明这是什么样的数据,我写了一段程序来显示这些数字:

/************************

* author: SharEDITor

* date: 2016-08-02

* brief: read MNIST data

************************/

#include <stdio.h>

#include <stdint.h>

#include <assert.h>

#include <stdlib.h>

unsigned char *lables = NULL;

/**

* All the integers in the files are stored in the MSB first (high endian) format

*/

void copy_int(uint32_t *target, unsigned char *src)

{

*(((unsigned char*)target)+0) = src[3];

*(((unsigned char*)target)+1) = src[2];

*(((unsigned char*)target)+2) = src[1];

*(((unsigned char*)target)+3) = src[0];

}

int read_lables()

{

FILE *fp = fopen("./train-labels-idx1-ubyte", "r");

if (NULL == fp)

{

return -1;

}

unsigned char head[8];

fread(head, sizeof(unsigned char), 8, fp);

uint32_t magic_number = 0;

uint32_t item_num = 0;

copy_int(&magic_number, &head[0]);

// magic number check

assert(magic_number == 2049);

copy_int(&item_num, &head[4]);

uint64_t values_size = sizeof(unsigned char) * item_num;

lables = (unsigned char*)malloc(values_size);

fread(lables, sizeof(unsigned char), values_size, fp);

fclose(fp);

return 0;

}

int read_images()

{

FILE *fp = fopen("./train-images-idx3-ubyte", "r");

if (NULL == fp)

{

return -1;

}

unsigned char head[16];

fread(head, sizeof(unsigned char), 16, fp);

uint32_t magic_number = 0;

uint32_t images_num = 0;

uint32_t rows = 0;

uint32_t cols = 0;

copy_int(&magic_number, &head[0]);

// magic number check

assert(magic_number == 2051);

copy_int(&images_num, &head[4]);

copy_int(&rows, &head[8]);

copy_int(&cols, &head[12]);

uint64_t image_size = rows * cols;

uint64_t values_size = sizeof(unsigned char) * images_num * rows * cols;

unsigned char *values = (unsigned char*)malloc(values_size);

fread(values, sizeof(unsigned char), values_size, fp);

for (int image_index = 0; image_index < images_num; image_index++)

{

// print the label

printf("========================================= %d ======================================\n", lables[image_index]);

for (int row_index = 0; row_index < rows; row_index++)

{

for (int col_index = 0; col_index < cols; col_index++)

{

// print the pixels of image

printf("%3d", values[image_index*image_size+row_index*cols+col_index]);

}

printf("\n");

}

printf("\n");

}

free(values);

fclose(fp);

return 0;

}

int main(int argc, char *argv[])

{

if (-1 == read_lables())

{

return -1;

}

if (-1 == read_images())

{

return -1;

}

return 0;

}

下载并解压出数据集文件train-images-idx3-ubyte和train-labels-idx1-ubyte放到源代码所在目录后,编译并执行:

gcc -o read_images read_images.c

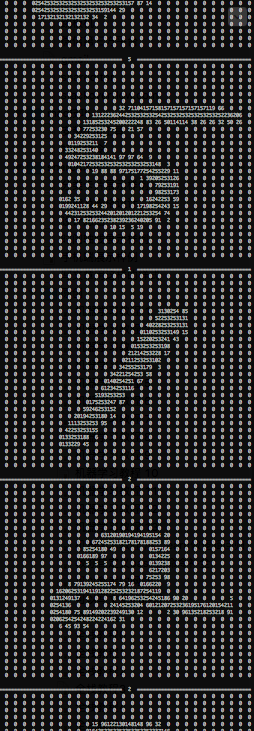

./read_images展示出来的效果如下:

一共有60000个图片,从代码可以看出数据集里存储的实际就是图片的像素

请尊重原创,转载请注明来源网站www.shareditor.com以及原始链接地址

softmax模型

我们在《机器学习教程 十三-用scikit-learn做逻辑回归》中介绍了逻辑回归模型。逻辑回归是用于解决二类分类问题(使用sigmoid函数),而softmax模型是逻辑回归模型的扩展,用来解决多类分类问题。

softmax意为柔和的最大值,也就是如果某个zj大于其他z,那么这个映射的分量就逼近于1,其他的分量就逼近于0,从而将其归为此分类,多个分量对应的就是多分类,数学形式和sigmoid不同,如下:

它的特点是,所有的softmax加和为1,其实它表示的是一种概率,即x属于某个分类的概率。

在做样本训练时,这里的xi计算方法是:

其中W是样本特征的权重,xj是样本的特征值,bi是偏置量。

详细来说就是:假设某个模型训练中我们设计两个特征,他们的值分别是f1和f2,他们对于第i类的权重分别是0.2和0.8,偏置量是1,那么

xi=f1*0.2+f2*0.8+1

如果所有的类别都计算出x的值,如果是一个训练好的模型,那么应该是所属的那个类别对应的softmax值最大

softmax回归算法也正是基于这个原理,通过大量样本来训练这里的W和b,从而用于分类的

tensorflow的优点

tensorflow会使用外部语言计算复杂运算来提高效率,但是不同语言之间的切换和不同计算资源之间的数据传输耗费很多资源,因此它使用图来描述一系列计算操作,然后一起传给外部计算,最后结果只传回一次,这样传输代价最低,计算效率最高

举个例子:

import tensorflow as tf

x = tf.placeholder(tf.float32, [None, 784])这里的x不是一个实际的x,而是一个占位符,也就是一个描述,描述成了二维浮点型,后面需要用实际的值来填充,这就类似于printf("%d", 10)中的占位符%d,其中第一维是None表示可无限扩张,第二维是784个浮点型变量

如果想定义可修改的张量,可以这样定义:

W = tf.Variable(tf.zeros([784,10]))

b = tf.Variable(tf.zeros([10]))其中W的维度是[784, 10],b的形状是[10]

有了这三个变量,我们可以定义我们的softmax模型:

y = tf.nn.softmax(tf.matmul(x,W) + b)这虽然定义,但是没有真正的进行计算,因为这只是先用图来描述计算操作

其中matmul是矩阵乘法,因为x的维度是[None, 784],W的维度是[784, 10],所以矩阵乘法得出的是[None, 10],这样可以和向量b相加

softmax函数会计算出10维分量的概率值,也就是y的形状是[10]

数字识别模型实现

基于上面定义的x、W、b,和我们定义的模型:

y = tf.nn.softmax(tf.matmul(x,W) + b)我们需要定义我们的目标函数,我们以交叉熵(衡量预测用于描述真相的低效性)为目标函数,让它达到最小:

其中y'是实际分布,y是预测的分布,即:

y_ = tf.placeholder("float", [None,10])

cross_entropy = -tf.reduce_sum(y_*tf.log(y))利用梯度下降法优化上面定义的Variable:

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy)其中0.01是学习速率,也就是每次对变量做多大的修正

按照上面的思路,最终实现的代码digital_recognition.py如下:

# coding:utf-8

import sys

reload(sys)

sys.setdefaultencoding( "utf-8" )

from tensorflow.examples.tutorials.mnist import input_data

import tensorflow as tf

flags = tf.app.flags

FLAGS = flags.FLAGS

flags.DEFINE_string('data_dir', './', 'Directory for storing data')

mnist = input_data.read_data_sets(FLAGS.data_dir, one_hot=True)

x = tf.placeholder(tf.float32, [None, 784])

W = tf.Variable(tf.zeros([784,10]))

b = tf.Variable(tf.zeros([10]))

y = tf.nn.softmax(tf.matmul(x,W) + b)

y_ = tf.placeholder("float", [None,10])

cross_entropy = -tf.reduce_sum(y_*tf.log(y))

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy)

init = tf.initialize_all_variables()

sess = tf.InteractiveSession()

sess.run(init)

for i in range(1000):

batch_xs, batch_ys = mnist.train.next_batch(100)

sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys})

correct_prediction = tf.equal(tf.argmax(y, 1), tf.argmax(y_, 1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

print(accuracy.eval({x: mnist.test.images, y_: mnist.test.labels}))

运行效果如下:

[root@mymac $] python digital_recognition.py

Extracting ./train-images-idx3-ubyte.gz

Extracting ./train-labels-idx1-ubyte.gz

Extracting ./t10k-images-idx3-ubyte.gz

Extracting ./t10k-labels-idx1-ubyte.gz

0.9039解释一下

flags.DEFINE_string('data_dir', './', 'Directory for storing data')表示我们用当前目录作为训练数据的存储目录,如果我们没有提前下好训练数据和测试数据,程序会自动帮我们下载到./

mnist = input_data.read_data_sets(FLAGS.data_dir, one_hot=True)这句直接用库里帮我们实现好的读取训练数据的方法,无需自行解析

for i in range(1000):

batch_xs, batch_ys = mnist.train.next_batch(100)

sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys})这几行表示我们循环1000次,每次从训练样本里选取100个样本来做训练,这样我们可以修改配置来观察运行速度

最后几行打印预测精度,当调整循环次数时可以发现总训练的样本数越多,精度就越高

利用Tensorflow实现手写字符识别的更多相关文章

- 【转】机器学习教程 十四-利用tensorflow做手写数字识别

模式识别领域应用机器学习的场景非常多,手写识别就是其中一种,最简单的数字识别是一个多类分类问题,我们借这个多类分类问题来介绍一下google最新开源的tensorflow框架,后面深度学习的内容都会基 ...

- 利用TensorFlow识别手写的数字---基于Softmax回归

1 MNIST数据集 MNIST数据集主要由一些手写数字的图片和相应的标签组成,图片一共有10类,分别对应从0-9,共10个阿拉伯数字.原始的MNIST数据库一共包含下面4个文件,见下表. 训练图像一 ...

- 利用TensorFlow识别手写的数字---基于两层卷积网络

1 为什么使用卷积神经网络 Softmax回归是一个比较简单的模型,预测的准确率在91%左右,而使用卷积神经网络将预测的准确率提高到99%. 2 卷积网络的流程 3 代码展示 # -*- coding ...

- OpenCV+TensorFlow图片手写数字识别(附源码)

初次接触TensorFlow,而手写数字训练识别是其最基本的入门教程,网上关于训练的教程很多,但是模型的测试大多都是官方提供的一些素材,能不能自己随便写一串数字让机器识别出来呢?纸上得来终觉浅,带着这 ...

- 仅用200个样本就能得到当前最佳结果:手写字符识别新模型TextCaps

由于深度学习近期取得的进展,手写字符识别任务对一些主流语言来说已然不是什么难题了.但是对于一些训练样本较少的非主流语言来说,这仍是一个挑战性问题.为此,本文提出新模型TextCaps,它每类仅用200 ...

- TensorFlow 之 手写数字识别MNIST

官方文档: MNIST For ML Beginners - https://www.tensorflow.org/get_started/mnist/beginners Deep MNIST for ...

- 利用SpringBoot+Logback手写一个简单的链路追踪

目录 一.实现原理 二.代码实战 三.测试 最近线上排查问题时候,发现请求太多导致日志错综复杂,没办法把用户在一次或多次请求的日志关联在一起,所以就利用SpringBoot+Logback手写了一个简 ...

- 一文全解:利用谷歌深度学习框架Tensorflow识别手写数字图片(初学者篇)

笔记整理者:王小草 笔记整理时间2017年2月24日 原文地址 http://blog.csdn.net/sinat_33761963/article/details/56837466?fps=1&a ...

- 【Keras篇】---Keras初始,两种模型构造方法,利用keras实现手写数字体识别

一.前述 Keras 适合快速体验 ,keras的设计是把大量内部运算都隐藏了,用户始终可以用theano或tensorflow的语句来写扩展功能并和keras结合使用. 二.安装 Pip insta ...

随机推荐

- event.currentTarget与event.target的差别介绍

event.currentTarget与event.target的差别想大家在使用的时候不是非常在意.本文以測试代码来解说它门之间的不同.即,event.currentTarget指向事件所绑定的元素 ...

- 開始搭建第一个zookeeper

首先须要下载zookeeper的tar包.地址为http://zookeeper.apache.org,然后再linux中解压并编译tar包. # tar-xvzf zookeeper-3.4.5.t ...

- 基于ArcGIS Flex API实现动态标绘(1.0)

标绘作为一种数据展示形式,在多个行业都有需求. 基于ArcGIS Flex API(3.6)实现标绘API,当前版本号1.0 alpha,支持经常使用几种标绘符号,包含: 圆弧.曲线.圆形.椭圆.弓形 ...

- ZOJ 1654--Place the Robots【二分匹配 && 经典建图】

Place the Robots Time Limit: 5 Seconds Memory Limit: 32768 KB Robert is a famous engineer. One ...

- 【移动开发】布局优化利器<include/>和ViewStub

本文翻译自<50 android hacks> 当创建复杂的布局的时候.有时候会发现加入了非常多的ViewGroup和View.随之而来的问题是View树的层次越来越深,应用也变的越来越慢 ...

- 0x59 单调队列优化DP

倍增DP太难啦心情好再回去做 poj1821 先让工匠按s排序,f[i][j]表示枚举到第i个工匠涂了j个木板(注意第j个木板不一定要涂) 那么f[i][j]可以直接继承f[i-1][j]和f[i][ ...

- [SCOI 2003] 字符串折叠

[题目链接] https://www.lydsy.com/JudgeOnline/problem.php?id=1090 [算法] 区间DP [代码] #include<bits/stdc++. ...

- struts的工作流程

- 一个请求过来,走前端控制器StrutsPrepareAndExecuteFilter -前端控制器是一个过滤器,过滤器中的核心方法是doFilter(),doFilter方法中首先处 ...

- [Javascript] 40个轻量级JavaScript脚本库

诸如jQuery, MooTools, Prototype, Dojo和YUI等JavaScript脚本库,大家都已经很熟悉.但这些脚本库有利也有弊--比如说JavaScript文件过大的问题.有时你 ...

- git 本地项目推送至远程仓库

1 在本地文件夹下创建一个 Git 仓库(如test目录下) git init 2 此时test文件夹即是你的maste主分支,你可以在改文件夹下写自己的项目 3 将test文件夹下的内容提交至暂存区 ...