【2023知乎爬虫】我用Python爬虫爬了2386条知乎评论!

您好,我是 @马哥python说,一枚10年程序猿。

一、爬取目标

前些天我分享过一篇微博的爬虫:

https://www.cnblogs.com/mashukui/p/16414027.html

但是知乎平台和微博平台的不同之处在于,微博平台的数据用于分析社会舆论热点事件是极好的,毕竟是个偏娱乐化的社交平台。但知乎平台的评论更加客观、讨论内容更加有深度,更加有专业性,基于此想法,我开发出了这个知乎评论的爬虫。

二、展示爬取结果

我在知乎上搜索了5个关于”考研“的知乎回答,爬取了回答下方的评论数据,共计2300+条数据。

https://www.zhihu.com/question/291278869/answer/930193847

https://www.zhihu.com/question/291278869/answer/802226501

https://www.zhihu.com/question/291278869/answer/857896805

https://www.zhihu.com/question/291278869/answer/910489150

https://www.zhihu.com/question/291278869/answer/935352960

爬取字段,含:

回答url、页码、评论作者、作者性别、作者主页、作者头像、评论时间、评论内容、评论级别。

部分数据截图:

三、爬虫代码讲解

3.1 分析知乎页面

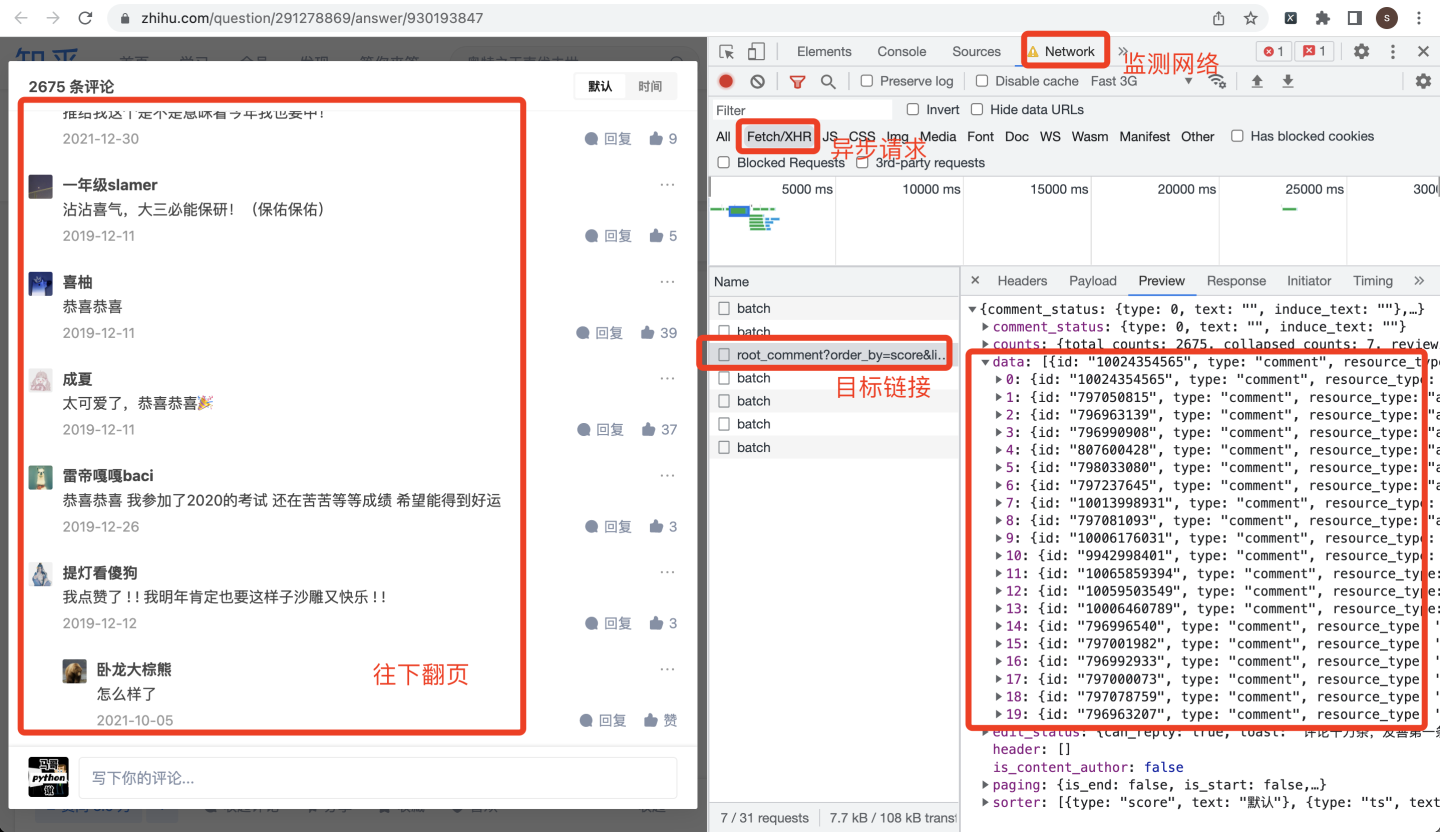

任意打开一个知乎回答,点开评论界面:

同时打开chrome浏览器的开发者模式,评论往下翻页,就会找到目标链接:

作为爬虫开发者,看到这种0-19的json数据,一定要敏感,这大概率就是评论数据了。猜测一下,每页有20条评论,逐级打开json数据:

基于此数据结构,开发爬虫代码。

3.2 爬虫代码

首先,导入用到的库:

import requests

import time

import pandas as pd

import os

从上面的截图可以看到,评论时间created_time是个10位时间戳,因此,定义一个转换时间的函数:

def trans_date(v_timestamp):

"""10位时间戳转换为时间字符串"""

timeArray = time.localtime(v_timestamp)

otherStyleTime = time.strftime("%Y-%m-%d %H:%M:%S", timeArray)

return otherStyleTime

作者的性别gender是0、1,所以也定义一个转换函数:

def tran_gender(gender_tag):

"""转换性别"""

if gender_tag == 1:

return '男'

elif gender_tag == 0:

return '女'

else: # -1

return '未知'

准备工作做好了,下面开始写爬虫。

请求地址url,从哪里得到呢?

打开Headers,找到Request URL,直接复制下来,然后替换:

先提取出一共多少评论,用于计算后面的翻页次数:

url0 = 'https://www.zhihu.com/api/v4/answers/{}/root_comments?order=normal&limit=20&offset=0&status=open'.format(answer_id)

r0 = requests.get(url0, headers=headers) # 发送请求

total = r0.json()['common_counts'] # 一共多少条评论

print('一共{}条评论'.format(total))

计算翻页次数,直接用评论总数除以20就好了:

# 判断一共多少页(每页20条评论)

max_page = int(total / 20)

print('max_page:', max_page)

下面,再次发送请求,获取评论数据:

url = 'https://www.zhihu.com/api/v4/answers/{}/root_comments?order=normal&limit=20&offset={}&status=open'.format(answer_id,str(offset))

r = requests.get(url, headers=headers)

print('正在爬取第{}页'.format(i + 1))

j_data = r.json()

comments = j_data['data']

现在,所有数据都在comments里面了,开始for循环遍历处理:

字段过多,这里以评论作者、评论性别为例,其他字段同理:

for c in comments: # 一级评论

# 评论作者

author = c['author']['member']['name']

authors.append(author)

print('作者:', author)

# 作者性别

gender_tag = c['author']['member']['gender']

genders.append(tran_gender(gender_tag))

其他字段不再赘述。

需要注意的是,知乎评论分为一级评论和二级评论(二级评论就是一级评论的回复评论),所以,为了同时爬取到二级评论,开发以下逻辑:(同样以评论作者、评论性别为例,其他字段同理)

if c['child_comments']: # 如果二级评论存在

for child in c['child_comments']: # 二级评论

# 评论作者

print('子评论作者:', child['author']['member']['name'])

authors.append(child['author']['member']['name'])

# 作者性别

genders.append(tran_gender(child['author']['member']['gender']))

待所有字段处理好之后,把所有字段的列表数据拼装到DataFrame,to_csv保存到csv文件里,完毕!

df = pd.DataFrame(

{

'回答url': answer_urls,

'页码': [i + 1] * len(answer_urls),

'评论作者': authors,

'作者性别': genders,

'作者主页': author_homepages,

'作者头像': author_pics,

'评论时间': create_times,

'评论内容': contents,

'评论级别': child_tag,

}

)

# 保存到csv文件

df.to_csv(v_result_file, mode='a+', index=False, header=header, encoding='utf_8_sig')

完整代码中还涉及到避免数据重复、字段值拼接、判断翻页终止等细节逻辑,详细了解请见文末。

四、同步视频

演示视频:

https://www.zhihu.com/zvideo/1545723927430979584

五、完整源码

附:微信公众号"老男孩的平凡之路"后台回复"爬知乎评论"即可获取。

更多爬虫源码: 点击前往

【2023知乎爬虫】我用Python爬虫爬了2386条知乎评论!的更多相关文章

- python爬虫-基础入门-python爬虫突破封锁

python爬虫-基础入门-python爬虫突破封锁 >> 相关概念 >> request概念:是从客户端向服务器发出请求,包括用户提交的信息及客户端的一些信息.客户端可通过H ...

- 【爬虫集合】Python爬虫

一.爬虫学习教程 1. https://www.jianshu.com/u/c32d557edfa3 2. WebMagic是一个简单灵活的Java爬虫框架.基于WebMagic,你可以快速开发出一个 ...

- 抖音爬虫教程,python爬虫采集反爬策略

一.爬虫与反爬简介 爬虫就是我们利用某种程序代替人工批量读取.获取网站上的资料信息.而反爬则是跟爬虫的对立面,是竭尽全力阻止非人为的采集网站信息,二者相生相克,水火不容,到目前为止大部分的网站都还是可 ...

- 【Python】【爬虫】如何学习Python爬虫?

如何学习Python爬虫[入门篇]? 路人甲 1 年前 想写这么一篇文章,但是知乎社区爬虫大神很多,光是整理他们的答案就够我这篇文章的内容了.对于我个人来说我更喜欢那种非常实用的教程,这种教程对于想直 ...

- Python爬虫入门一之综述

大家好哈,最近博主在学习Python,学习期间也遇到一些问题,获得了一些经验,在此将自己的学习系统地整理下来,如果大家有兴趣学习爬虫的话,可以将这些文章作为参考,也欢迎大家一共分享学习经验. Pyth ...

- [python]爬虫学习(一)

要学习Python爬虫,我们要学习的共有以下几点(python2): Python基础知识 Python中urllib和urllib2库的用法 Python正则表达式 Python爬虫框架Scrapy ...

- Python爬虫入门:综述

大家好哈,最近博主在学习Python,学习期间也遇到一些问题,获得了一些经验,在此将自己的学习系统地整理下来,如果大家有兴趣学习爬虫的话,可以将这些文章作为参考,也欢迎大家一共分享学习经验. Pyth ...

- Python爬虫:用BeautifulSoup进行NBA数据爬取

爬虫主要就是要过滤掉网页中没用的信息.抓取网页中实用的信息 一般的爬虫架构为: 在python爬虫之前先要对网页的结构知识有一定的了解.如网页的标签,网页的语言等知识,推荐去W3School: W3s ...

- 1.Python爬虫入门一之综述

要学习Python爬虫,我们要学习的共有以下几点: Python基础知识 Python中urllib和urllib2库的用法 Python正则表达式 Python爬虫框架Scrapy Python爬虫 ...

- python爬虫的教程

来源:http://cuiqingcai.com/1052.html 大家好哈,我呢最近在学习Python爬虫,感觉非常有意思,真的让生活可以方便很多.学习过程中我把一些学习的笔记总结下来,还记录了一 ...

随机推荐

- KafkaConsumerDemo

pom <dependency> <groupId>org.springframework.kafka</groupId> <artifactId>sp ...

- ftp安装与配置 云服务器 CentOS7

1.FTP的安装 #安装 yum install -y vsftpd #设置开机启动 systemctl enable vsftpd.service #启动 systemctl start vsftp ...

- verilog之wire和reg

verilog之wire和reg 1.区别 wire为线,reg为寄存器.至少初期这两个名词的意思是这样的.wire在电路设计中指代的就是某个点的逻辑值,而reg则指代某个寄存器输出的逻辑值.这个理解 ...

- KingbaseES查找慢查询语句和阻塞会话

在处理数据库性能问题时,识别和分析慢查询及阻塞会话是至关重要的步骤.数据库管理员和开发人员常常需要依赖特定的工具和查询语句来追踪这些性能瓶颈. 当数据库响应变慢或出现处理延迟时,第一步通常是查找那些执 ...

- net.sf.json.JSONObject,将MySQL数据库的数据读出转化为json数据

maven依赖: 1 <dependency> 2 <groupId>net.sf.json-lib</groupId> 3 <artifactId>j ...

- 2 URLEncode和Base64

1. URLEncode和Base64 在我们访问一个url的时候总能看到这样的一种url https://www.sogou.com/web?query=%E5%90%83%E9%A5%AD%E7% ...

- #SPFA#洛谷 4042 [AHOI2014/JSOI2014] 骑士游戏

题目 分析 如果我想普通攻击1,那么必须干掉所有产生的其它怪兽,这不由得可以用一个不等式来表示, \(普攻+\sum need<法攻\) 但是所需要消灭的怪兽同样可以这样进行,所以它可能具有后效 ...

- 攻防世界 debug

题目 分析过程 丢到PE里面 一开始,我看到下面的脱壳提示,以为是我没见过的壳,下载了相关工具脱壳--发现脱了后又出现没见过的脱壳提示,根据提示脱壳弄出来的东西怪怪的 卡题,查了资料 学到一个新知识点 ...

- vue3探索——使用ref与$parent实现父子组件间通信

在vue3中,可以使用vue3的API defineExpose()函数结合ref或者$parent,实现父子组件数据的传递. 子组件向父组件传递数据defineExpose()和ref 子组件:通过 ...

- Windows Server之KMS

KMS是什么? KMS全称是Key Management Service,本身就是微软官方提供的一种激活方式,通常用于大型组织客需要激活的客户端数量不固定的情况. 正常情况下,激活Windows系统需 ...