RNN-LSTM入门

RNN-LSTM入门

Last Edited: Dec 02, 2018 10:20 PM

Tags: 机器学习,论文阅读

RNN-Recurrent Neural Network

概念:

- 序列数据:简而言之,序列数据就是后面的数据与前面的数据相关的数据,例如上下文、时间序列等。

- 递归神经网络(RNN):在基础神经网络中加入了环形结构,让神经元的输出信号返回继续作为输入信号,目的是让t时刻的输出状态不仅与t时刻的输入相关联,还与t-1时刻的状态相关联。

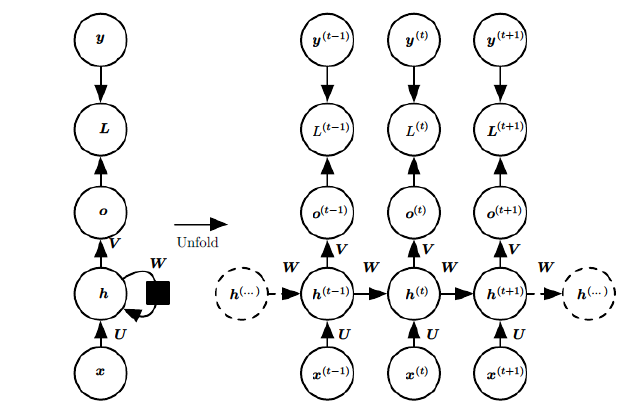

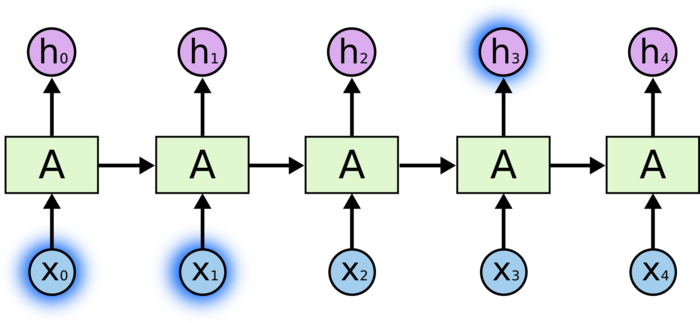

RNN结构图:

左侧为折叠情况下的RNN网络结构图,右侧为展开的RNN网络结构图。x为输入,h为循环的隐层,o为输出,L为损失函数,y是样本中的标准值,U、V、W为权值。

标准RNN的特点:

- 随着循环的进行,损失函数L也在积累。

- 权值共享(weight sharing),降低了参数数量。

- 每一个输入值都只与它本身的那条路线建立权连接,不会和别的神经元连接。

算法公式:

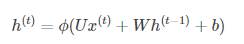

向前传播公式:

ϕ是激活函数,一般选择tanh函数,b为偏置量。

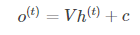

t时刻的输出公式:

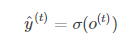

最终的预测模型为:

LSTM

概念:

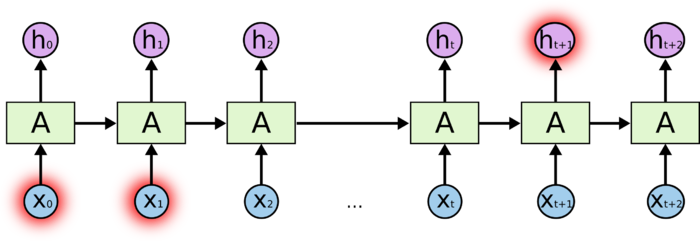

LSTM网络是RNN的一个变种,在RNN执行的过程中,对于距离较近的关键词有很好的记忆性,但是对于长距离关键词的记忆性比较低。下面两幅图分别展示了这两种情景:

X0、X1是h3的输入,输入与输出之间的距离比较近。

X0、X1与输出h t+1之间的距离太长,RNN对长时间记忆有明显的不足。

由此引出RNN的变种网络:LSTM网络。

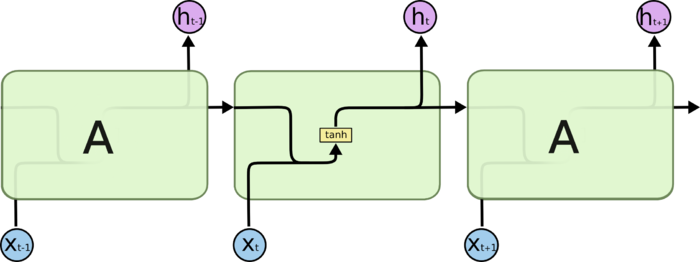

LSTM网络结构:

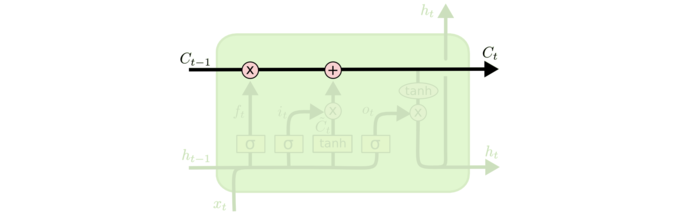

- 对于标准RNN网络,h是随着时间不断更新的。在LSTM网络中新加了一个循环点:细胞C。 细胞C随着时间流动带来了长期的记忆。

传统标准RNN网络,只有h是在循环更新的。

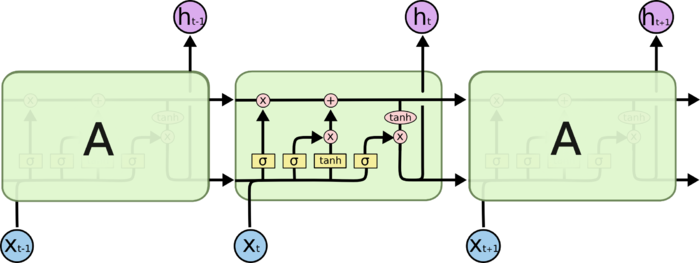

LSTM网络,在h更新的同时,细胞也在更新。

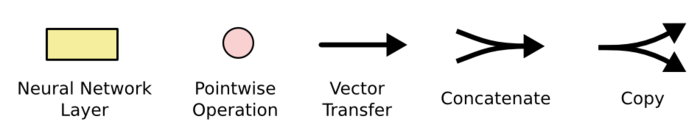

上图的图示。

细胞更新的路线。 两个粉色⚪表示信息进行一些基础的运算,在h循环更新的过程中,细胞C的信息也在不断更新。由于细胞C只是进行一些简单的运算,所以它的信息可以在流通中保持大体不变。

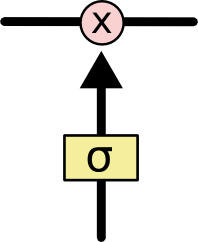

这样的结构称为LSTM的”门“结构,可以控制信息的进出。黄色方框里面是一个sigmoid函数。

LSTM网络输入输出流程:

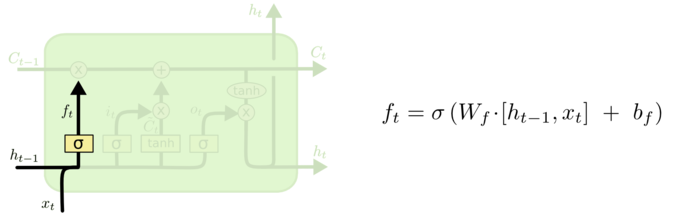

遗忘:选择忘记过去的某些信息

理解:并不是全部信息都要记住的,需要选择性遗忘。上一层的输入和本层的输入通过sigmoid函数变成一个取值在[0,1]的值,0表示完全遗忘,1表示必须记住。再通过“X”乘法操作与上层数据汇合。这里被称为遗忘门。

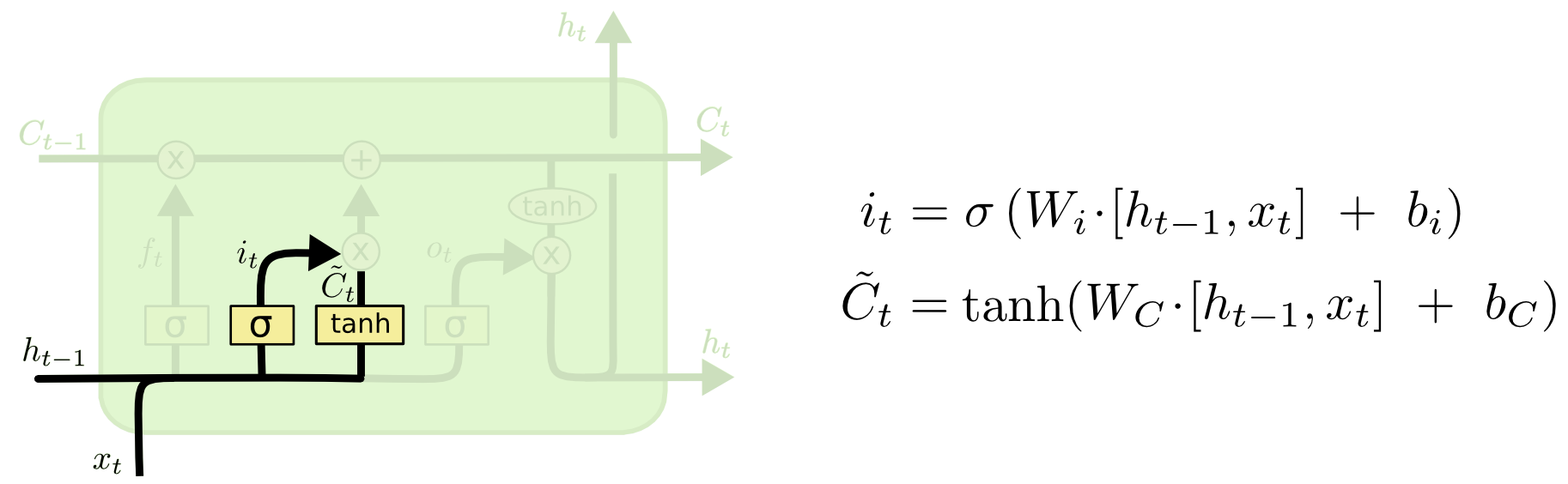

输入:选择记忆现在的某些信息

理解:将输入的信息分别通过sigmoid函数和tanh函数的处理,共同输入到“X”乘法运算中。同样的Sigmoid函数仍然输出一个[0,1]的值,表示该数据的可以记忆的价值是多少。tanh发挥的作用类似于RNN中发挥的作用,输出一个候选值。由Sigmoid函数决定该值要记忆多少。这里被称为输入门

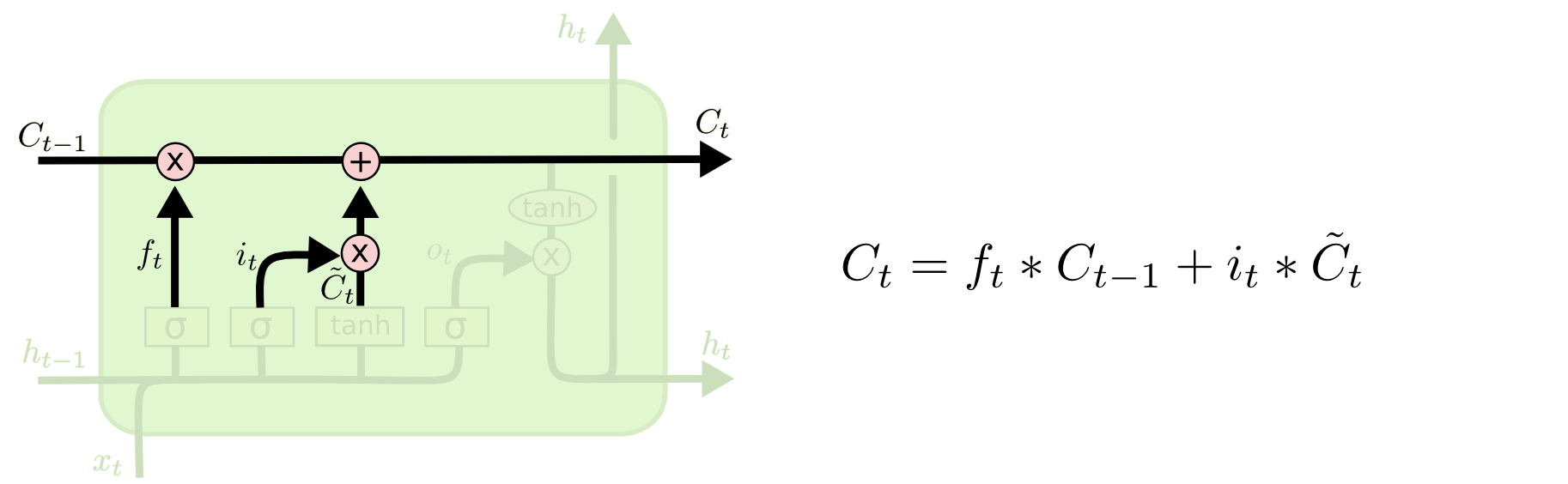

合并:将过去的记忆和现在的记忆合并在一起。

理解:两端记忆分别通过乘法后用加法运算合并到一起。

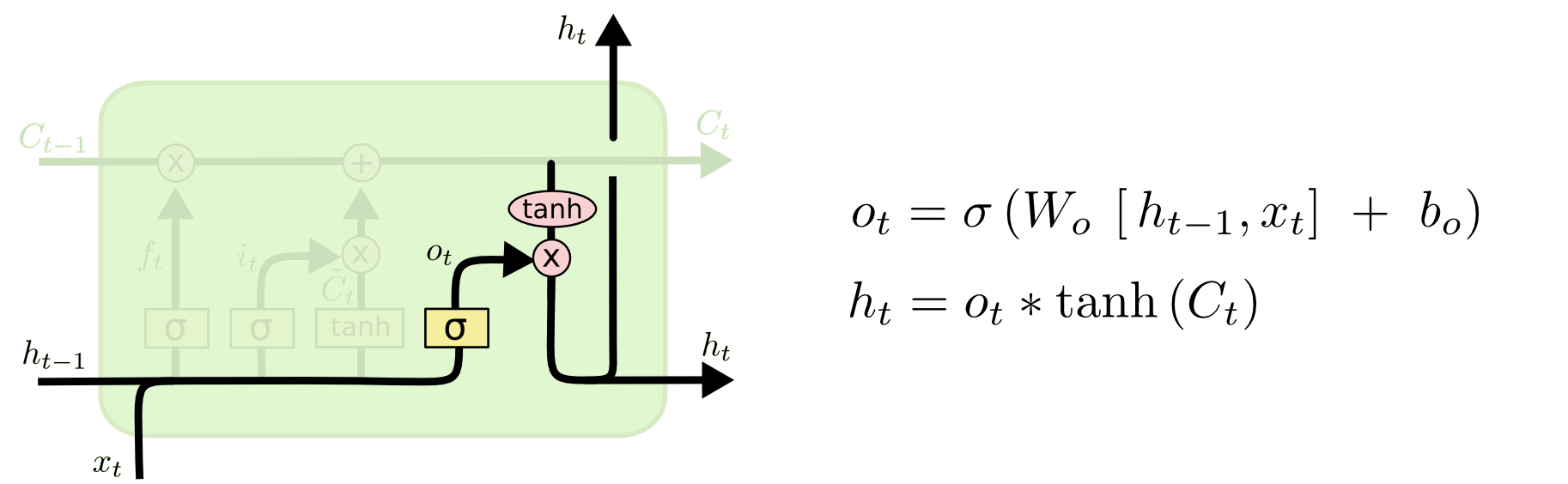

输出:

理解:最后把合并的细胞信息通过tanh函数与sigmoid的输出相乘,得到最终的输入,进入下一个神经元中。这里称为输出门。

在整个过程中,sigmoid函数起的是选择作用。 通过输出的值控制记忆的记忆程度。tanh起的是变换作用,与RNN中的作用类似。此外,LSTM还有其他变体,但是根据测试(Jozefowicz, et al. (2015))各个变体之间的差距很小。

部分图片来自网友博客,如有侵权,请联系我。

GCA-LSTM(Global Context-Aware Attention LSTM Networks)

原作者为:

Jun Liu , Gang Wang , Ping Hu , Ling-Yu Duan , Alex C. Kot

School of Electrical and Electronic Engineering, Nanyang Technological University, Singapore

Alibaba Group, Hangzhou, China

National Engineering Lab for Video Technology, Peking University, Beijing, China

{jliu029, wanggang, phu005, eackot}@ntu.edu.sg, lingyu@pku.edu.cn

RNN-LSTM入门的更多相关文章

- LSTM入门学习——本质上就是比RNN的隐藏层公式稍微复杂了一点点而已

LSTM入门学习 摘自:http://blog.csdn.net/hjimce/article/details/51234311 下面先给出LSTM的网络结构图: 看到网络结构图好像很复杂的样子,其实 ...

- 时间序列(六): 炙手可热的RNN: LSTM

目录 炙手可热的LSTM 引言 RNN的问题 恐怖的指数函数 梯度消失* 解决方案 LSTM 设计初衷 LSTM原理 门限控制* LSTM 的 BPTT 参考文献: 炙手可热的LSTM 引言 上一讲说 ...

- 深度学习中的序列模型演变及学习笔记(含RNN/LSTM/GRU/Seq2Seq/Attention机制)

[说在前面]本人博客新手一枚,象牙塔的老白,职业场的小白.以下内容仅为个人见解,欢迎批评指正,不喜勿喷![认真看图][认真看图] [补充说明]深度学习中的序列模型已经广泛应用于自然语言处理(例如机器翻 ...

- RNN/LSTM/GRU/seq2seq公式推导

概括:RNN 适用于处理序列数据用于预测,但却受到短时记忆的制约.LSTM 和 GRU 采用门结构来克服短时记忆的影响.门结构可以调节流经序列链的信息流.LSTM 和 GRU 被广泛地应用到语音识别. ...

- [NL系列] RNN & LSTM 网络结构及应用

http://www.jianshu.com/p/f3bde26febed/ 这篇是 The Unreasonable Effectiveness of Recurrent Neural Networ ...

- RNN LSTM 介绍

[RNN以及LSTM的介绍和公式梳理]http://blog.csdn.net/Dark_Scope/article/details/47056361 [知乎 对比 rnn lstm 简单代码] ...

- rnn,lstm and JuergenSchmidhuber

JuergenSchmidhuber 是瑞士的一位牛人,主要贡献是rnn, lstm. google的deep mind新作,Human-level control through deep rein ...

- RNN,LSTM,GRU基本原理的个人理解

记录一下对RNN,LSTM,GRU基本原理(正向过程以及简单的反向过程)的个人理解 RNN Recurrent Neural Networks,循环神经网络 (注意区别于recursive neura ...

- 用tensorflow搭建RNN(LSTM)进行MNIST 手写数字辨识

用tensorflow搭建RNN(LSTM)进行MNIST 手写数字辨识 循环神经网络RNN相比传统的神经网络在处理序列化数据时更有优势,因为RNN能够将加入上(下)文信息进行考虑.一个简单的RNN如 ...

- tensorflow学习之(十一)RNN+LSTM神经网络的构造

#RNN 循环神经网络 import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data tf.se ...

随机推荐

- [smf]smf论坛也很漂亮

smf论坛代码国内使用的比较少,可能是大家习惯了dz论坛的互动方式吧!但是,smf论坛系统不失为一款好的论坛系统,也是目前为数不多的开源代码.使用起来之后,你会体会到它强大的后台操作.(例如:插件的安 ...

- angular-指令

ng-app 作用域 ng-init 声明 module 模块 ng-model 双向绑定 ng-bind 绑定 angular是一个MVC框架:即 M------------------module ...

- 使用Kubeadm搭建Kubernetes(1.12.2)集群

Kubeadm是Kubernetes官方提供的用于快速安装Kubernetes集群的工具,伴随Kubernetes每个版本的发布都会同步更新,在2018年将进入GA状态,说明离生产环境中使用的距离越来 ...

- Vipe-技术选型

1.AOP,IOC框架-Spring 选择Spring是最不需要考虑的.应该90%以上的JAVA项目都有用Spring. 2.ORM框架-Mybatis Mybatis入门比较简单,并且对SQL语法的 ...

- Android插件化的兼容性(中):Android P的适配

Android系统的每次版本升级,都会对原有代码进行重构,这就为插件化带来了麻烦. Android P对插件化的影响,主要体现在两方面,一是它重构了H类中Activity相关的逻辑,另一个是它重构了I ...

- Java 多线程开发之 Callable 与线程池

前言 我们常见的创建线程的方式有 2 种:继承 Thread 和 实现 Runnable 接口. 其实,在 JDK 中还提供了另外 2 种 API 让开发者使用. 二.简单介绍 2.1 Callabl ...

- 吴恩达机器学习笔记31-梯度检验(Gradient Checking)

当我们对一个较为复杂的模型(例如神经网络)使用梯度下降算法时,可能会存在一些不容易察觉的错误,意味着,虽然代价看上去在不断减小,但最终的结果可能并不是最优解.为了避免这样的问题,我们采取一种叫做梯度的 ...

- MyBatis 的 XML 映射文件使用说明

简介 文档参考地址:http://www.mybatis.org/mybatis-3/zh/index.html MyBatis 的真正强大在于它的映射语句,也是它的魔力所在.由于它的异常强大,映射器 ...

- 文本编辑器 EditPlus 的激活与设置

说明 1.EditPlus是Windows的文本编辑器,具有内置的FTP,FTPS和sftp功能.虽然它可以作为一个很好的记事本替代品,但它也为网页作者和程序员提供了许多强大的功能. 2.语法高亮显示 ...

- 全栈开发工程师微信小程序-上(下)

全栈开发工程师微信小程序-上(下) icon 图标 success, success_no_circle, info, warn, waiting, cancel, download, search, ...