requests-html

目录

一 介绍

Python上有一个非常著名的HTTP库——requests,相信大家都听说过,用过的人都说非常爽!现在requests库的作者又发布了一个新库,叫做requests-html,看名字也能猜出来,这是一个解析HTML的库,具备requests的功能以外,还新增了一些更加强大的功能,用起来比requests更爽!接下来我们来介绍一下它吧。

# 官网解释

'''

This library intends to make parsing HTML (e.g. scraping the web) as simple and intuitive as possible. If you’re interested in financially supporting Kenneth Reitz open source, consider visiting this link. Your support helps tremendously with sustainability of motivation, as Open Source is no longer part of my day job. When using this library you automatically get: - Full JavaScript support!

- CSS Selectors (a.k.a jQuery-style, thanks to PyQuery).

- XPath Selectors, for the faint at heart.

- Mocked user-agent (like a real web browser).

- Automatic following of redirects.

- Connection–pooling and cookie persistence.

- The Requests experience you know and love, with magical parsing abilities.

- Async Support

'''

官网告诉我们,它比原来的requests模块更加强大,并且为我们提供了一些新的功能!

- 支持JavaScript

- 支持CSS选择器(又名jQuery风格, 感谢PyQuery)

- 支持Xpath选择器

- 可自定义模拟User-Agent(模拟得更像真正的web浏览器)

- 自动追踪重定向

- 连接池与cookie持久化

- 支持异步请求

二 安装

安装requests-html非常简单,一行命令即可做到。需要注意一点就是,requests-html只支持Python 3.6或以上的版本,所以使用老版本的Python的同学需要更新一下Python版本了。

# pip3 install requests-html

三 如何使用requests-html?

在我们学爬虫程序的时候用得最多的请求库就是requests与urllib,但问题是这些包只给我们提供了如何去目标站点发送请求,然后获取响应数据,接着再利用bs4或xpath解析库才能提取我们需要的数据。

import requests

from bs4 import BeautifulSoup

url = 'http://www.zuihaodaxue.cn/'

HEADERS = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.157 Safari/537.36'

}

response = requests.get(url, headers=HEADERS)

response.encoding = 'gbk'

# print(response.status_code)

# print(response.text)

soup = BeautifulSoup(response.text, 'lxml')

# 获取最新的五则新闻

post_rankings = soup.find_all(name='article', attrs={"class": "post_ranking"})

# 循环打印新闻简介内容

for post_ranking in post_rankings:

new = post_ranking.find(name='div', attrs={"class": 'post_summary'})

print(new.text)

以往爬虫的请求与解析

而在requests-html里面只需要一步就可以完成而且可以直接进行js渲染!requests的作者Kenneth Reitz 开发的requests-html 爬虫包 是基于现有的框架 PyQuery、Requests、lxml、beautifulsoup4等库进行了二次封装,作者将Requests的简单,便捷,强大又做了一次升级。

1、基本使用

from requests_html import HTMLSession # 获取请求对象

session = HTMLSession() # 往新浪新闻主页发送get请求

sina = session.get('https://news.sina.com.cn/')

# print(sina.status_code)

sina.encoding = 'utf-8' # 获取响应文本信息,与requests无区别

# print(sina.text)

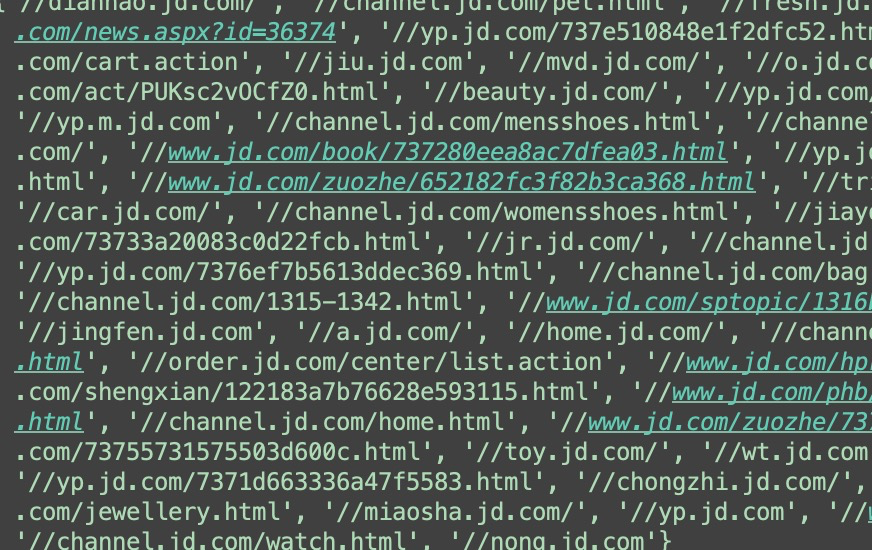

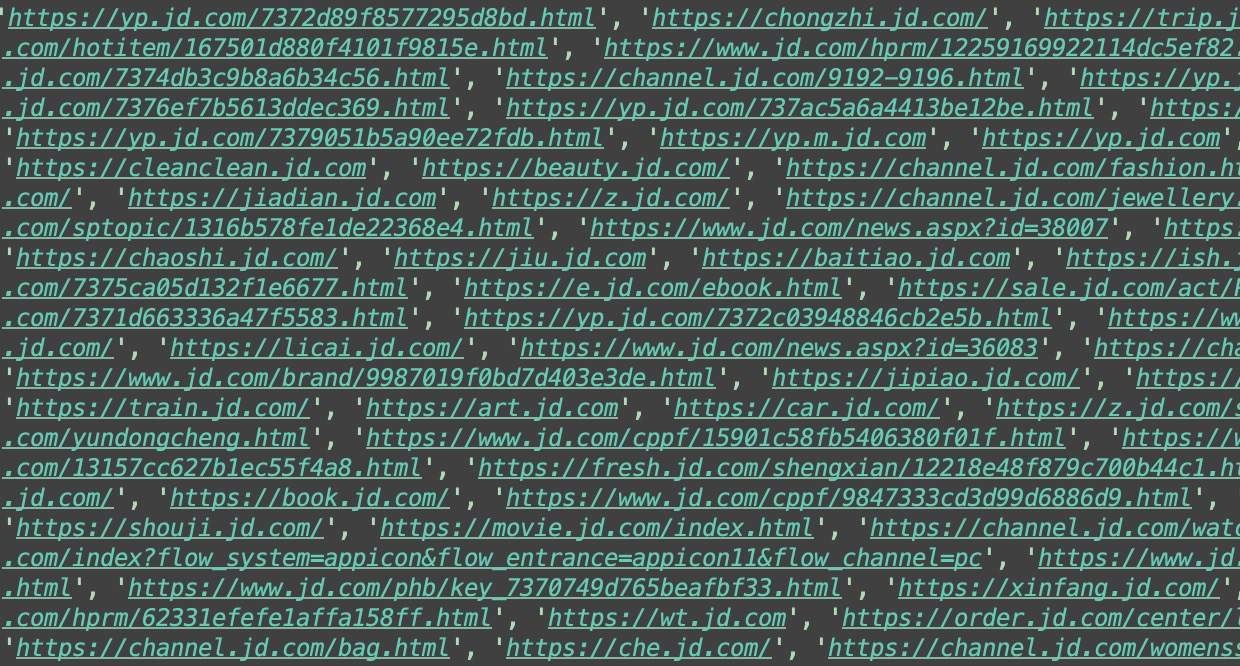

2、获取链接(links与abolute_links)

links返回的结果 absolute_links返回的结果

from requests_html import HTMLSession # 获取请求对象

session = HTMLSession() # 往京东主页发送get请求

jd = session.get('https://jd.com/') # 得到京东主页所有的链接,返回的是一个set集合

print(jd.html.links)

print('*' * 1000) # 若获取的链接中有相对路径,我们还可以通过absolute_links获取所有绝对链接

print(jd.html.absolute_links)

3、CSS选择器与XPATH

request-html支持CSS选择器和XPATH两种语法来选取HTML元素。首先先来看看CSS选择器语法,它需要使用HTML的 find 函数来查找元素。

'''

CSS选择器 and XPATH

1.通过css选择器选取一个Element对象

2.获取一个Element对象内的文本内容

3.获取一个Element对象的所有attributes

4.渲染出一个Element对象的HTML内容

5.获取Element对象内的特定子Element对象,返回列表

6.在获取的页面中通过search查找文本

7.支持XPath

8.获取到只包含某些文本的Element对象

'''

from requests_html import HTMLSession session = HTMLSession()

url = "https://www.qiushibaike.com/text/" # 获取响应数据对象

obj = session.get(url) # 1.通过css选择器选取一个Element对象

# 获取id为content-left的div标签,并且返回一个对象

content = obj.html.find('div#content-left', first=True) # 2.获取一个Element对象内的文本内容

# 获取content内所有文本

print(content.text) # 3.获取一个Element对象的所有attributes

# 获取content内所有属性

print(content.attrs) # 4.渲染出一个Element对象的完整的HTML内容

html = content.html

print(html) # 5.获取Element对象内的指定的所有子Element对象,返回列表

a_s = content.find('a')

print(a_s)

print(len(a_s)) # # 循环所有的a标签

for a in a_s:

# 获取a标签内所有属性的href属性 并拼接

href = a.attrs['href']

if href.startswith('/'):

url = 'https://www.qiushibaike.com' + href

print(url) # 6.在获取的页面中通过search查找文本

# {}大括号相当于正则的从头到后开始匹配,获取当中想要获取的数据

text = obj.html.search('把{}夹')[0] # 获取从 "把" 到 "夹" 字的所有内容

text = obj.html.search('把糗事{}夹')[0] # 获取从把子到夹字的所有内容

print(text) print('*' * 1000) # 7.支持XPath

a_s = obj.html.xpath('//a') # 获取html内所有的a标签

for a in a_s:

href = a.attrs['href'] # 若是//开头的url都扔掉

if href.startswith('//'):

continue # 若是/开头的都是相对路径

elif href.startswith('/'):

print('https://www.qiushibaike.com' + href) # 8.获取到只包含某些文本的Element对象(containing)

# 获取所有文本内容为幽默笑话大全_爆笑笑话_笑破你的肚子的搞笑段子 - 糗事百科 title标签

# 注意: 文本内有空格也必须把空格带上

title = obj.html.find('title', containing='幽默笑话大全_爆笑笑话_笑破你的肚子的搞笑段子 - 糗事百科')

print(title)

view code

四 支持JavaScript

支持JavaScript是我觉得作者更新后最为牛逼的一个地方,但是需要在第一次执行render的时候下载chromeium,然后通过它来执行js代码。

1、render的使用

from requests_html import HTMLSession session = HTMLSession() url = 'http://www.win4000.com/' obj = session.get(url) obj.encoding = 'utf-8' obj.html.render()

注意:第一次运行render()方法时,它会将Chromium下载到您的主目录中(例如~/.pyppeteer/)。这种情况只发生一次。

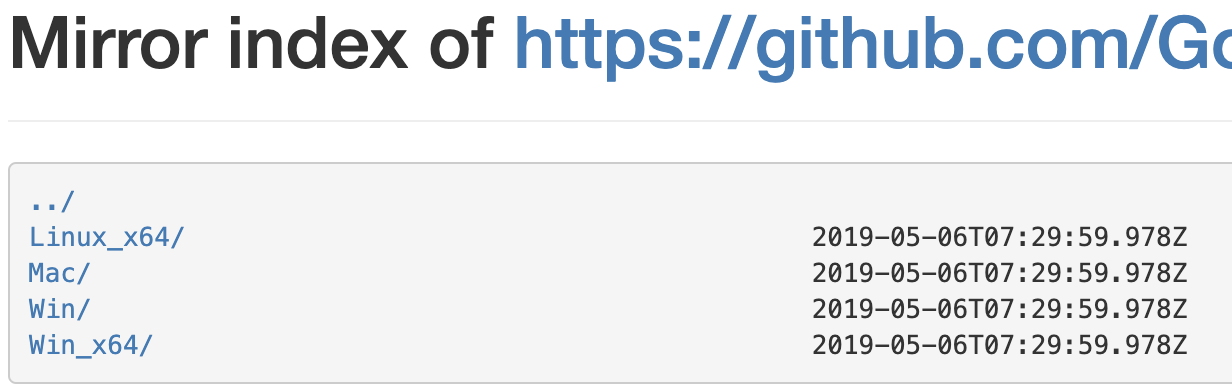

2、 下载Chromeium问题

因为是从国外的站点下载几分钟才3%,实在是太慢了。所以我们需要通过国内的镜像去下载!需要做以下几步:

- 手动下载Chrome

先去国内源下载自己需要的版本,地址:https://npm.taobao.org/mirrors/chromium-browser-snapshots/

- 修改chromeium_downloader.py文件

下载后之后解压后,进入python安装目录下的\Lib\site-packages\pyppeteer目录, 并打开chromium_downloader.py文件。# 找到自己的操作系统相应的配置位置

'''

chromiumExecutable = {

'linux': DOWNLOADS_FOLDER / REVISION / 'chrome-linux' / 'chrome',

'mac': (DOWNLOADS_FOLDER / REVISION / 'chrome-mac' / 'Chromium.app' /

'Contents' / 'MacOS' / 'Chromium'),

'win32': DOWNLOADS_FOLDER / REVISION / 'chrome-win32' / 'chrome.exe',

'win64': DOWNLOADS_FOLDER / REVISION / 'chrome-win32' / 'chrome.exe',

}

'''

from pyppeteer import __chromium_revision__, __pyppeteer_home__ DOWNLOADS_FOLDER = Path(__pyppeteer_home__) / 'local-chromium'

REVISION = os.environ.get('PYPPETEER_CHROMIUM_REVISION', __chromium_revision__) # 打印这两个变量可以知道执行的驱动具体位置

print(DOWNLOADS_FOLDER)

print(REVISION) '''

由上面可以知道:chromium路径是:C:\Users\Ray\AppData\Local\pyppeteer\pyppeteer\local-chromium\575458\chrome-win32\chrome.exe 所以自己建文件夹,然后一直到chrome-win32文件夹,把上面下载的chromium文件,拷贝到此目录下

'''

- 手动下载Chrome

五 自定义User-Agent

有些网站会使用User-Agent来识别客户端类型,有时候需要伪造UA来实现某些操作。如果查看文档的话会发现HTMLSession上的很多请求方法都有一个额外的参数**kwargs,这个参数用来向底层的请求传递额外参数。我们先向网站发送一个请求,看看返回的网站信息。

from requests_html import HTMLSession

# pprint可以把数据打印得更整齐

from pprint import pprint

import json

get_url = 'http://httpbin.org/get' session = HTMLSession() # 返回的是当前系统的headers信息

res = session.get(get_url)

pprint(json.loads(res.html.html)) # 可以在发送请求的时候更换user-agent

ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:62.0) Gecko/20100101 Firefox/62.0'

post_url = 'http://httpbin.org/get'

res = session.get(post_url, headers={'user-agent': ua})

pprint(json.loads(res.html.html)) # 如果你有需要可以在header中修改其他参数。

六 模拟表单提交(POST)

HTMLSession封装了一整套的HTTP方法,包括get、post、delete等, 对应HTTP中各个方法。

# 表单登录

r = session.post('http://httpbin.org/post', data={'username': 'tank_jam', 'password': 'tank9527'})

pprint(json.loads(r.html.html))

''' # 打印结果

{'args': {},

'data': '',

'files': {},

'form': {'password': 'tank9527', 'username': 'tank_jam'},

'headers': {'Accept': '*/*',

'Accept-Encoding': 'gzip, deflate',

'Content-Length': '35',

'Content-Type': 'application/x-www-form-urlencoded',

'Host': 'httpbin.org',

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_6) '

'AppleWebKit/603.3.8 (KHTML, like Gecko) '

'Version/10.1.2 Safari/603.3.8'},

'json': None,

'origin': '112.65.61.109, 112.65.61.109',

'url': 'https://httpbin.org/post'}

'''

七 支持异步请求

requests-html内部就封装好了aynsc异步请求的功能,可以提高我们的爬虫效率。

from requests_html import AsyncHTMLSession

from requests_html import HTMLSession

import time # 使用异步发送请求

async_session = AsyncHTMLSession() async def get_baidu():

url = 'https://www.baidu.com/'

res = await async_session.get(url)

print(res.html.absolute_links) async def get_sougou():

url = 'https://www.sogou.com/'

res = await async_session.get(url)

print(res.html.links) start_time = time.time()

async_session.run(get_baidu, get_sougou)

print('耗时:', time.time() - start_time) # 同步发送请求

session = HTMLSession() start_time = time.time()

res = session.get('https://www.baidu.com/')

print(res.html.links)

res = session.get('https://www.sogou.com/')

print(res.html.absolute_links)

print('耗时:', time.time() - start_time)

requests-html的更多相关文章

- requests的content与text导致lxml的解析问题

title: requests的content与text导致lxml的解析问题 date: 2015-04-29 22:49:31 categories: 经验 tags: [Python,lxml, ...

- requests源码阅读学习笔记

0:此文并不想拆requests的功能,目的仅仅只是让自己以后写的代码更pythonic.可能会涉及到一部分requests的功能模块,但全看心情. 1.另一种类的初始化方式 class Reques ...

- Python爬虫小白入门(二)requests库

一.前言 为什么要先说Requests库呢,因为这是个功能很强大的网络请求库,可以实现跟浏览器一样发送各种HTTP请求来获取网站的数据.网络上的模块.库.包指的都是同一种东西,所以后文中可能会在不同地 ...

- 使用beautifulsoup与requests爬取数据

1.安装需要的库 bs4 beautifulSoup requests lxml如果使用mongodb存取数据,安装一下pymongo插件 2.常见问题 1> lxml安装问题 如果遇到lxm ...

- python爬虫学习(6) —— 神器 Requests

Requests 是使用 Apache2 Licensed 许可证的 HTTP 库.用 Python 编写,真正的为人类着想. Python 标准库中的 urllib2 模块提供了你所需要的大多数 H ...

- ImportError: No module named 'requests'

补充说明: 当前环境是在windows环境下 python版本是:python 3.4. 刚开始学习python,一边看书一边论坛里阅读感兴趣的代码, http://www.oschina.net/c ...

- Python-第三方库requests详解

Requests 是用Python语言编写,基于 urllib,采用 Apache2 Licensed 开源协议的 HTTP 库.它比 urllib 更加方便,可以节约我们大量的工作,完全满足 HTT ...

- Requests 乱码

当使用Requests请求网页时,出现下面图片中的一些乱码,我就一脸蒙逼. 程序是这样的. def getLinks(articleUrl): headers = { "Uset-Agent ...

- 爬虫requests模块 2

会话对象¶ 会话对象让你能够跨请求保持某些参数.它也会在同一个 Session 实例发出的所有请求之间保持 cookie, 期间使用 urllib3 的 connection pooling 功能.所 ...

- 爬虫requests模块 1

让我们从一些简单的示例开始吧. 发送请求¶ 使用 Requests 发送网络请求非常简单. 一开始要导入 Requests 模块: >>> import requests 然后,尝试 ...

随机推荐

- 了解jsp,这一篇就够了.

jsp的执行过程: 1 客户端发出请求. 2 Web容器将JSP转译成Servlet源代码. 3 Web容器将产生的源代码进行编译. 4 Web容器加载编译后的代码并执行. 5 把执行结果响应至客户端 ...

- Spring69道面试题

Spring 概述 1. 什么是spring? Spring 是个java企业级应用的开源开发框架.Spring主要用来开发Java应用,但是有些扩展是针对构建J2EE平台的web应用.Spring ...

- ReentrantReadWriteLock 源码分析

ReentrantReadWriteLock 源码分析: 1:数据结构: 成员变量: private final ReentrantReadWriteLock.ReadLock readerLock ...

- 笔记本CPU性能排行

截图如下: 1. 图1 2. 图2 3. 4. 5. 6. 7. 8. 谢谢浏览!

- centos7.x下环境搭建(四)—redis安装

redis介绍 redis是用C语言开发的一个开源的高性能键值对(key-value)数据库.它通过提供多种键值数据类型来适应不同场景下的存储需求,目前为止redis支持的键值数据类型如下字符串.列表 ...

- Prometheus PromSQL 常用资源

Prometheus PromSQL 常用资源 PromSQL 使用 运算乘:*除:/加:+减:- 函数 sum() 函数:求出找到所有value的值 irate() 函数:统计平均速率 by (标签 ...

- Java学习:IO流

IO流 1.IO流 用于处理设备上的数据. 设备:硬盘,内存,键盘录入. 2. IO有具体的分类: 根据处理的数据类型不同:字节流和字符流. 根据流向不同:输入流和输出流. 字符流的由来: 因为文件编 ...

- 官方elasticsearch-certutiledit命令

地址:https://www.elastic.co/guide/en/elasticsearch/reference/7.5/certutil.html 语法: bin/elasticsearch-c ...

- 「福利」Java Swing 编写的可视化算法工程,包含树、图和排序

之前在整理<学习排序算法,结合这个方法太容易理解了>这篇文章时,发现了一个用 Java Swing 编写的可视化算法工程,真心不错!包含了常用数据结构和算法的动态演示,先来张图感受下: 可 ...

- sedlauncher.exe 磁盘爆满

打开应用和功能,搜KB4023057,然后卸载. 快捷键WIN+R打开运行,输入services.msc回车打开系统服务,找到Windows Remediation Service (sedsvc)和 ...