ambari集成impala

1.查看hdp版本,可在ambari-agent节点上查看

VERSION=`hdp-select status hadoop-client | sed 's/hadoop-client - \([0-9]\.[0-9]\).*/\1/'`

2.server节点上git克隆代码,其中下方$VERSION指的是上方的版本号

sudo git clone https://github.com/cas-bigdatalab/ambari-impala-service.git /var/lib/ambari-server/resources/stacks/HDP/$VERSION/services/IMPALA

如果出现SSL问题,可关闭SSL验证再执行

git config --global http.sslVerify false

git config --global http.sslversion tlsv1

如果你没有安装git,可到https://github.com/cas-bigdatalab/ambari-impala-service地址上下载代码,放到目录/var/lib/ambari-server/resources/stacks/HDP/$VERSION/services/IMPALA下

如果你的git安装有任何问题,参考文章后方附录git的安装升级配置

3.server上目录/etc/yum.repos下新建文件impala.repo

[cloudera-cdh5]

# Packages for Cloudera's Distribution for Hadoop, Version 5, on RedHat or CentOS 6 x86_64

name=Cloudera's Distribution for Hadoop, Version 5

baseurl=https://archive.cloudera.com/cdh5/redhat/6/x86_64/cdh/5/

gpgkey =https://archive.cloudera.com/cdh5/redhat/6/x86_64/cdh/RPM-GPG-KEY-cloudera

gpgcheck =

然后将此文件发送到各个需要安装的agent节点上

4.重启ambari-server

service ambari-server restart

5.重启成功后, 在页面里选择impala服务进行安装

这里选择server节点安装catalog , state_store

agent节点安装impala-daemon

由于要去cloudera官网下载rpm包,网速比较慢,若失败可多试几次。

6.安装成功后,在ambari服务配置里修改或添加HDFS配置

6.1 修改core-site.xml

<property>

<name>dfs.client.read.shortcircuit</name>

<value>true</value>

</property> <property>

<name>dfs.client.read.shortcircuit.skip.checksum</name>

<value>false</value>

</property> <property>

<name>dfs.datanode.hdfs-blocks-metadata.enabled</name>

<value>true</value>

</property>

6.2 修改hdfs-site.xml

<property>

<name>dfs.datanode.hdfs-blocks-metadata.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.block.local-path-access.user</name>

<value>impala</value>

</property>

<property>

<name>dfs.client.file-block-storage-locations.timeout.millis</name>

<value>60000</value>

</property>

7.重启hdfs及相关服务

8.启动impala服务

impala服务启动后一会就会停掉,不用着急,继续向下看

9.将各个节点上的hbase的jar包复制到impala目录下

需要将版本号去掉改为软连接,

因为我的节点上/usr/lib/impala/lib目录下已有hbase的三个jar包(hbase-annotations.jar,hbase-client.jar,hbase-common.jar),这几个就不需要再次建立软连接了

cp /usr/lib/hbase/lib/hbase-*.jar /usr/lib/impala/lib/

ln -s hbase-examples-1.2.-cdh5.16.1.jar hbase-examples.jar

ln -s hbase-external-blockcache-1.2.-cdh5.16.1.jar hbase-external-blockcache.jar

ln -s hbase-hadoop2-compat-1.2.-cdh5.16.1.jar hbase-hadoop2-compat.jar

ln -s hbase-hadoop-compat-1.2.-cdh5.16.1.jar hbase-hadoop-compat.jar

ln -s hbase-it-1.2.-cdh5.16.1.jar hbase-it.jar

ln -s hbase-prefix-tree-1.2.-cdh5.16.1.jar hbase-prefix-tree.jar

ln -s hbase-procedure-1.2.-cdh5.16.1.jar hbase-procedure.jar

ln -s hbase-resource-bundle-1.2.-cdh5.16.1.jar hbase-resource-bundle.jar

ln -s hbase-rest-1.2.-cdh5.16.1.jar hbase-rest.jar

ln -s hbase-rsgroup-1.2.-cdh5.16.1.jar hbase-rsgroup-1.2..jar

ln -s hbase-server-1.2.-cdh5.16.1.jar hbase-server.jar

ln -s hbase-shell-1.2.-cdh5.16.1.jar hbase-shell.jar

ln -s hbase-spark-1.2.-cdh5.16.1.jar hbase-spark.jar

ln -s hbase-thrift-1.2.-cdh5.16.1.jar hbase-thrift.jar

10.错误时,查看各节点日志/var/log/impala/

我的jdk版本是1.8,并需要在各节点上修改配置文件/etc/default/bigtop-utils,修改

export JAVA_HOME=/opt/module/jdk1..0_112

然后执行source /etc/default/bigtop-utils

11.ambari管理页面启动impala

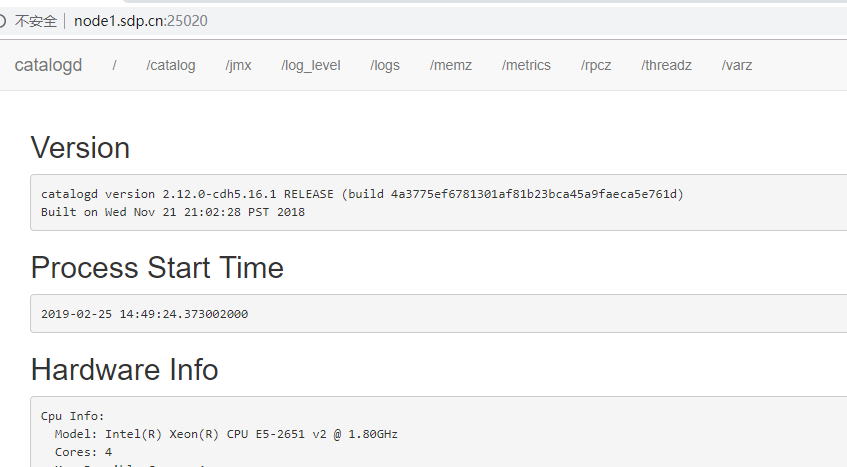

查看server上state_store

查看catalog

打开impalad各节点的ui

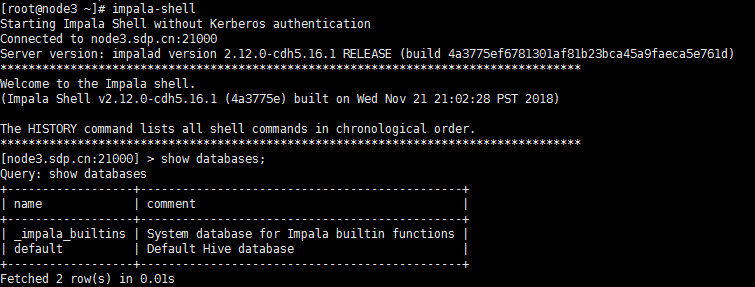

在impalad节点上打开shell客户端

参考:

https://www.cnblogs.com/zwgblog/p/6846030.html

https://github.com/cas-bigdatalab/ambari-impala-service

【附录】

git的安装升级配置

如果出现fatal: HTTP request failed此类问题,一般是由于git版本过低引起的,可参考下方升级

1.查看git版本

git --version

2.删除旧版本

yum remove git

3.安装git依赖包

yum install curl-devel expat-devel gettext-devel openssl-devel zlib-devel asciidoc

yum install gcc perl-ExtUtils-MakeMaker

4.下载新版本

cd /usr/local/src/

wget https://www.kernel.org/pub/software/scm/git/git-2.15.1.tar.xz

5.解压编译

tar -vxf git-2.15..tar.xz

cd git-2.15.

make prefix=/usr/local/git all

make prefix=/usr/local/git install

echo "export PATH=$PATH:/usr/local/git/bin" >> /etc/profile

source /etc/profile

6.查看版本变为2.15.1

git --version

ambari集成impala的更多相关文章

- 【原创】大数据基础之Ambari(4)通过Ambari部署Impala

ambari2.7.3(hdp3.1) 安装 impala2.12(自动安装最新) ambari的hdp中原生不支持impala安装,下面介绍如何通过mpack方式使ambari支持impala安装: ...

- Ambari集成Kerberos报错汇总

Ambari集成Kerberos报错汇总 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.查看报错的配置信息步骤 1>.点击Test Kerberos Client,查看相 ...

- 实战kudu集成impala

推荐阅读: 论主数据的重要性(正确理解元数据.数据元) CDC+ETL实现数据集成方案 Java实现impala操作kudu 实战kudu集成impala impala基本介绍 im ...

- ambari hdp 集成 impala

1.下载ambari-impala-service VERSION=`hdp-select status hadoop-client | sed 's/hadoop-client - \([0-9]\ ...

- kudu集成impala

Kudu 与 Apache Impala (孵化)紧密集成,允许开发人员使用 Impala 使用 Impala 的 SQL 语法从 Kudu tablets 插入,查询,更新和删除数据: 安装impa ...

- hdp (ambari) 集成hue

ambari-server resetambari-admin-password-reset https://github.com/EsharEditor/ambari-hue-service可以基于 ...

- 给Ambari集群里安装基于Hive的大数据实时分析查询引擎工具Impala步骤(图文详解)

不多说,直接上干货! Impala和Hive的关系(详解) 扩展博客 给Clouderamanager集群里安装基于Hive的大数据实时分析查询引擎工具Impala步骤(图文详解) 参考 horton ...

- 基于Ambari构建自己的大数据平台产品

目前市场上常见的企业级大数据平台型的产品主流的有两个,一个是Cloudera公司推出的CDH,一个是Hortonworks公司推出的一套HDP,其中HDP是以开源的Ambari作为一个管理监控工具,C ...

- Hadoop生态圈-开启Ambari的Kerberos安全选项

Hadoop生态圈-开启Ambari的Kerberos安全选项 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 在完成IPA-Server服务的安装之后,我们已经了解了他提供的基础功 ...

随机推荐

- MySQL对数据表进行分组查询(GROUP BY)

MySQL对数据表进行分组查询(GROUP BY) GROUP BY关键字可以将查询结果按照某个字段或多个字段进行分组.字段中值相等的为一组.基本的语法格式如下: GROUP BY 属性名 [HAVI ...

- 微信公众号关联(小游戏 小程序 跳转 盒子 wx.navigateToMiniProgram)

参考: 公众号关联小程序 关联公众号 关联后,登录小游戏,可在设置-关联设置中看到关联的公众号 在小游戏中使用wx.navigateToMiniProgram wx.navigateToMiniPro ...

- 【CF815D】Karen and Cards 单调栈+扫描线

[CF815D]Karen and Cards 题意:一张卡片有三个属性a,b,c,其上限分别为A,B,C,现在有n张卡片,定义一张卡片能打败另一张卡片当且仅当它的至少两项属性要严格大于另一张的对应属 ...

- ThreadLocal Java并发

ThreadLocal 文章来源:http://con.zhangjikai.com/ThreadLocal.html ThreadLocal 主要用来提供线程局部变量,也就是变量只对当前线程可见. ...

- github中删除一个repository

(1) 首先进入相应的repository,然后点击setting 2,点击 delete the repository (3) 输入要删除的repository名字,即可删除

- wordpress---page页面数据调用

在wordpress的开发中,会使用wordpress的的页面,那么页面数据该怎么调用呢? 拿到页面的 content: <?php if(have_posts()) : ?> <? ...

- python----并发之协程

<python并发之协程>一: 单线程下实现并发,即只在一个主线程,并且cpu只有一个的情况下实现并发.(并发的本质:切换+保存状态) cpu正在运行一个任务,会在两种情况下切去执行其他的 ...

- ubuntu查看隐藏文件夹

打开所要查看的文件目录,然后ctrl + h 快捷键可以显示隐藏文件 例如在/home目录下可以看到以下隐藏文件

- 替换{0}为指定的字符串(MessageFormat)

package com.text; import java.text.MessageFormat; /**替换{0}为指定的字符串*/ public class MessageFormatTest { ...

- Oracle管理监控之rlwrap-0.37.tar.gz实现sqlplus上下翻页

1.上传rlwrap-0.37.tar.gz到linux 2.解压rlwrap-0.37.tar.gz [root@node1 mnt]# tar zxvf rlwrap-0.37.tar.gz [r ...