pc客户端网页录音和压缩

web录音的功能,也就是怎么使用 getUserMedia

音频上传

栗子中最后返回的是Blob数据

return new Blob([dataview], { type: type })

因为对html5不熟,所以又查了一些数据

原来HTML5中使用FormData这个对象好方便

var fd = new FormData();

fd.append("audioData", blob);

var xhr = new XMLHttpRequest();

xhr.open("POST", url);

xhr.send(fd);

在C#服务器端 如下代码就可以接收了

public void ProcessRequest(HttpContext context)

{

if (context.Request.Files.Count > 0)

{

context.Request.Files[0].SaveAs("d:\\1.wav");

}

}

问题2:文件体积太大

是的,使用上面的栗子,直接录音保存后基本上2秒就需要400K,一段20秒的录音就达到了的4M

这样的数据根本无法使用,必须想办法压缩数据

我开始尝试读每一段代码

function encodeWAV(samples){

var buffer = new ArrayBuffer(44 + samples.length * 2);

var view = new DataView(buffer);

/* RIFF identifier */

writeString(view, 0, 'RIFF');

/* file length */

view.setUint32(4, 32 + samples.length * 2, true);

/* RIFF type */

writeString(view, 8, 'WAVE');

/* format chunk identifier */

writeString(view, 12, 'fmt ');

/* format chunk length */

view.setUint32(16, 16, true);

/* sample format (raw) */

view.setUint16(20, 1, true);

/* channel count */

view.setUint16(22, 2, true);

/* sample rate */

view.setUint32(24, sampleRate, true);

/* byte rate (sample rate * block align) */

view.setUint32(28, sampleRate * 4, true);

/* block align (channel count * bytes per sample) */

view.setUint16(32, 4, true);

/* bits per sample */

view.setUint16(34, 16, true);

/* data chunk identifier */

writeString(view, 36, 'data');

/* data chunk length */

view.setUint32(40, samples.length * 2, true);

floatTo16BitPCM(view, 44, samples);

return view;

}

上面的代码,就是把字节数据格式化成wav的格式的过程

所以我又去查了wav的头文件

要压缩,就要从上面三个红圈的地方入手

最简单的就是把双声道改成单声道的,

在录音的时候只需要记录一个声道就可以了

// 创建声音的缓存节点,createJavaScriptNode方法的

// 第二个和第三个参数指的是输入和输出都是双声道。

//recorder = context.createJavaScriptNode(bufferSize, 2, 2);

recorder = context.createJavaScriptNode(bufferSize, 1, 1);//这里改成1 this.node.onaudioprocess = function(e){

if (!recording) return;

worker.postMessage({

command: 'record',

buffer: [

e.inputBuffer.getChannelData(0)//,

//e.inputBuffer.getChannelData(1)// 这里只需要保存一个

]

});

} function exportWAV(type){

var bufferL = mergeBuffers(recBuffersL, recLength);

//var bufferR = mergeBuffers(recBuffersR, recLength);

var interleaved = interleave(bufferL);//, bufferR); //合并数据的时候去到对右声道的处理

var dataview = encodeWAV(interleaved);

var audioBlob = new Blob([dataview], { type: type }); this.postMessage(audioBlob);

} function interleave(inputL){//, inputR){//混合声道的时候去掉对右声道的处理

var length = inputL.length ;//+ inputR.length;

var result = new Float32Array(length); var index = 0,

inputIndex = 0; while (index < length){

result[index++] = inputL[inputIndex];

//result[index++] = inputR[inputIndex];

inputIndex++;

}

return result;

}

然后修改一下注释,我不喜欢英文的....

function encodeWAV(samples) {

var dataLength = samples.length * 2;

var buffer = new ArrayBuffer(44 + dataLength);

var view = new DataView(buffer);

var sampleRateTmp = sampleRate;

var sampleBits = 16;

var channelCount = 1;

var offset = 0;

/* 资源交换文件标识符 */

writeString(view, offset, 'RIFF'); offset += 4;

/* 下个地址开始到文件尾总字节数,即文件大小-8 */

view.setUint32(offset, /*32这里地方栗子中的值错了,但是不知道为什么依然可以运行成功*/ 36 + dataLength, true); offset += 4;

/* WAV文件标志 */

writeString(view, offset, 'WAVE'); offset += 4;

/* 波形格式标志 */

writeString(view, offset, 'fmt '); offset += 4;

/* 过滤字节,一般为 0x10 = 16 */

view.setUint32(offset, 16, true); offset += 4;

/* 格式类别 (PCM形式采样数据) */

view.setUint16(offset, 1, true); offset += 2;

/* 通道数 */

view.setUint16(offset, channelCount, true); offset += 2;

/* 采样率,每秒样本数,表示每个通道的播放速度 */

view.setUint32(offset, sampleRateTmp, true); offset += 4;

/* 波形数据传输率 (每秒平均字节数) 通道数×每秒数据位数×每样本数据位/8 */

view.setUint32(offset, sampleRateTmp * channelCount * (sampleBits / 8), true); offset += 4;

/* 快数据调整数 采样一次占用字节数 通道数×每样本的数据位数/8 */

view.setUint16(offset, channelCount * (sampleBits / 8), true); offset += 2;

/* 每样本数据位数 */

view.setUint16(offset, sampleBits, true); offset += 2;

/* 数据标识符 */

writeString(view, offset, 'data'); offset += 4;

/* 采样数据总数,即数据总大小-44 */

view.setUint32(offset, dataLength, true); offset += 4;

/* 采样数据 */

floatTo16BitPCM(view, 44, samples);

return view;

}

一旦把双声道变为单声道,数据直接缩小一半了

但是还不够

继续缩小体积

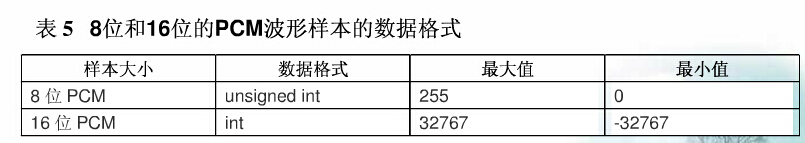

除了声道以外,还有一个可以缩减的地方就是采样位数 默认是16位的,我们改成8位 又可以减少一半了

function encodeWAV(samples) {

var sampleBits = 8;//16;//这里改成8位

var dataLength = samples.length * (sampleBits / 8);

var buffer = new ArrayBuffer(44 + dataLength);

var view = new DataView(buffer);

var sampleRateTmp = sampleRate;

var channelCount = 1;

var offset = 0;

/* 资源交换文件标识符 */

writeString(view, offset, 'RIFF'); offset += 4;

/* 下个地址开始到文件尾总字节数,即文件大小-8 */

view.setUint32(offset, /*32这里地方栗子中的值错了,但是不知道为什么依然可以运行成功*/ 36 + dataLength, true); offset += 4;

/* WAV文件标志 */

writeString(view, offset, 'WAVE'); offset += 4;

/* 波形格式标志 */

writeString(view, offset, 'fmt '); offset += 4;

/* 过滤字节,一般为 0x10 = 16 */

view.setUint32(offset, 16, true); offset += 4;

/* 格式类别 (PCM形式采样数据) */

view.setUint16(offset, 1, true); offset += 2;

/* 通道数 */

view.setUint16(offset, channelCount, true); offset += 2;

/* 采样率,每秒样本数,表示每个通道的播放速度 */

view.setUint32(offset, sampleRateTmp, true); offset += 4;

/* 波形数据传输率 (每秒平均字节数) 通道数×每秒数据位数×每样本数据位/8 */

view.setUint32(offset, sampleRateTmp * channelCount * (sampleBits / 8), true); offset += 4;

/* 快数据调整数 采样一次占用字节数 通道数×每样本的数据位数/8 */

view.setUint16(offset, channelCount * (sampleBits / 8), true); offset += 2;

/* 每样本数据位数 */

view.setUint16(offset, sampleBits, true); offset += 2;

/* 数据标识符 */

writeString(view, offset, 'data'); offset += 4;

/* 采样数据总数,即数据总大小-44 */

view.setUint32(offset, dataLength, true); offset += 4;

/* 采样数据 */

//floatTo16BitPCM(view, 44, samples);

floatTo8BitPCM(view, 44, samples);//这里改为写入8位的数据

return view;

}

8和16的取值范围不一样

对比一下To8和To16的方法

这里方法是我自己猜的,如果不对还望指出~~~

function floatTo16BitPCM(output, offset, input) {

for (var i = 0; i < input.length; i++, offset += 2) { //因为是int16所以占2个字节,所以偏移量是+2

var s = Math.max(-1, Math.min(1, input[i]));

output.setInt16(offset, s < 0 ? s * 0x8000 : s * 0x7FFF, true);

}

}

function floatTo8BitPCM(output, offset, input) {

for (var i = 0; i < input.length; i++, offset++) { //这里只能加1了

var s = Math.max(-1, Math.min(1, input[i]));

var val = s < 0 ? s * 0x8000 : s * 0x7FFF;

val = parseInt(255 / (65535 / (val + 32768))); //这里有一个转换的代码,这个是我个人猜测的,就是按比例转换

output.setInt8(offset, val, true);

}

}

怀着忐忑的心情,启动网页...居然听的到声音~居然成功了!!!

经过这样之后又减少了一半大小

最后就是这个采样率了

网页中录音组件的采样率是44100 不知道在哪里改,查询了一些资料,未果...

所以又自己猜测了,是不是我把已经缓存的时候按照比例抛弃一些就可以模拟减少采样率的操作呢?

比如现在已经缓存的数据大小是40960 是不是我直接间隔一位抛弃一次数据,将数据大小变成20480 就可以算是采样率变成22050了呢?

同理,要编程11025只要再抛弃一半的数据?

所以我又做了如下修改

function interleave(inputL, inputR) {

var compression = 44100 / 11025; //计算压缩率

var length = inputL.length / compression;

var result = new Float32Array(length);

var index = 0,

inputIndex = 0;

while (index < length) {

result[index] = inputL[inputIndex];

inputIndex += compression;//每次都跳过3个数据

index++;

}

return result;

}

function encodeWAV(samples) {

var dataLength = samples.length;

var buffer = new ArrayBuffer(44 + dataLength);

var view = new DataView(buffer);

var sampleRateTmp = 11025 ;//sampleRate;//写入新的采样率

var sampleBits = 8;

var channelCount = 1;

var offset = 0;

/* 资源交换文件标识符 */

writeString(view, offset, 'RIFF'); offset += 4;

/* 下个地址开始到文件尾总字节数,即文件大小-8 */

view.setUint32(offset, /*32*/ 36 + dataLength, true); offset += 4;

/* WAV文件标志 */

writeString(view, offset, 'WAVE'); offset += 4;

/* 波形格式标志 */

writeString(view, offset, 'fmt '); offset += 4;

/* 过滤字节,一般为 0x10 = 16 */

view.setUint32(offset, 16, true); offset += 4;

/* 格式类别 (PCM形式采样数据) */

view.setUint16(offset, 1, true); offset += 2;

/* 通道数 */

view.setUint16(offset, channelCount, true); offset += 2;

/* 采样率,每秒样本数,表示每个通道的播放速度 */

view.setUint32(offset, sampleRateTmp, true); offset += 4;

/* 波形数据传输率 (每秒平均字节数) 通道数×每秒数据位数×每样本数据位/8 */

view.setUint32(offset, sampleRateTmp * channelCount * (sampleBits / 8), true); offset += 4;

/* 快数据调整数 采样一次占用字节数 通道数×每样本的数据位数/8 */

view.setUint16(offset, channelCount * (sampleBits / 8), true); offset += 2;

/* 每样本数据位数 */

view.setUint16(offset, sampleBits, true); offset += 2;

/* 数据标识符 */

writeString(view, offset, 'data'); offset += 4;

/* 采样数据总数,即数据总大小-44 */

view.setUint32(offset, dataLength, true); offset += 4;

/* 采样数据 */

floatTo16BitPCM(view, 44, samples);

return view;

}

再次怀着忐忑的心情,启动网页...居然听的到声音~居然又成功了

最后把之前的代码整理封装一下

(function (window) {

//兼容

window.URL = window.URL || window.webkitURL;

navigator.getUserMedia = navigator.getUserMedia || navigator.webkitGetUserMedia || navigator.mozGetUserMedia || navigator.msGetUserMedia;

var HZRecorder = function (stream, config) {

config = config || {};

config.sampleBits = config.sampleBits || 16; //采样数位 8, 16

config.sampleRate = config.sampleRate || (16000); //采样率(16k)

var context = new (window.webkitAudioContext || window.AudioContext)();

alert(config.sampleBits);

alert(config.sampleRate);

var audioInput = context.createMediaStreamSource(stream);

var createScript = context.createScriptProcessor || context.createJavaScriptNode;

var recorder = createScript.apply(context, [4096, 1, 1]);

var audioData = {

size: 0 //录音文件长度

, buffer: [] //录音缓存

, inputSampleRate: context.sampleRate //输入采样率

, inputSampleBits: 16 //输入采样数位 8, 16

, outputSampleRate: config.sampleRate //输出采样率

, oututSampleBits: config.sampleBits //输出采样数位 8, 16

, input: function (data) {

this.buffer.push(new Float32Array(data));

this.size += data.length;

}

, compress: function () { //合并压缩

//合并

var data = new Float32Array(this.size);

var offset = 0;

for (var i = 0; i < this.buffer.length; i++) {

data.set(this.buffer[i], offset);

offset += this.buffer[i].length;

}

//压缩

var compression = (this.inputSampleRate / this.outputSampleRate);

var length = data.length / compression;

var result = new Float32Array(length);

var index = 0, j = 0;

while (index < length) {

result[index] = data[parseInt(j)];

j += compression;

index++;

}

return result;

}

, encodeWAV: function () {

var sampleRate = Math.min(this.inputSampleRate, this.outputSampleRate);

var sampleBits = Math.min(this.inputSampleBits, this.oututSampleBits);

var bytes = this.compress();

var dataLength = bytes.length * (sampleBits / 8);

var buffer = new ArrayBuffer(44 + dataLength);

var data = new DataView(buffer);

var channelCount = 1;//单声道

var offset = 0;

// alert(sampleRate);

// alert(sampleBits);

var writeString = function (str) {

for (var i = 0; i < str.length; i++) {

data.setUint8(offset + i, str.charCodeAt(i));

}

}

// 资源交换文件标识符

writeString('RIFF'); offset += 4;

// 下个地址开始到文件尾总字节数,即文件大小-8

data.setUint32(offset, 36 + dataLength, true); offset += 4;

// WAV文件标志

writeString('WAVE'); offset += 4;

// 波形格式标志

writeString('fmt '); offset += 4;

// 过滤字节,一般为 0x10 = 16

data.setUint32(offset, 16, true); offset += 4;

// 格式类别 (PCM形式采样数据)

data.setUint16(offset, 1, true); offset += 2;

// 通道数

data.setUint16(offset, channelCount, true); offset += 2;

// 采样率,每秒样本数,表示每个通道的播放速度

data.setUint32(offset, sampleRate, true); offset += 4;

// 波形数据传输率 (每秒平均字节数) 单声道×每秒数据位数×每样本数据位/8

data.setUint32(offset, channelCount * sampleRate * (sampleBits / 8), true); offset += 4;

// 快数据调整数 采样一次占用字节数 单声道×每样本的数据位数/8

data.setUint16(offset, channelCount * (sampleBits / 8), true); offset += 2;

// 每样本数据位数

data.setUint16(offset, sampleBits, true); offset += 2;

// 数据标识符

writeString('data'); offset += 4;

// 采样数据总数,即数据总大小-44

data.setUint32(offset, dataLength, true); offset += 4;

// 写入采样数据

if (sampleBits === 8) {

for (var i = 0; i < bytes.length; i++, offset++) {

var s = Math.max(-1, Math.min(1, bytes[i]));

var val = s < 0 ? s * 0x8000 : s * 0x7FFF;

val = parseInt(255 / (65535 / (val + 32768)));

data.setInt8(offset, val, true);

}

} else {

for (var i = 0; i < bytes.length; i++, offset += 2) {

var s = Math.max(-1, Math.min(1, bytes[i]));

data.setInt16(offset, s < 0 ? s * 0x8000 : s * 0x7FFF, true);

}

}

return new Blob([data], { type: 'audio/wav' });

}

};

//开始录音

this.start = function () {

audioInput.connect(recorder);

recorder.connect(context.destination);

}

//停止

this.stop = function () {

recorder.disconnect();

}

//获取音频文件

this.getBlob = function () {

this.stop();

return audioData.encodeWAV();

}

//回放

this.play = function (audio) {

audio.src = window.URL.createObjectURL(this.getBlob());

}

//上传

this.upload = function (url, callback) {

var fd = new FormData();

fd.append("audioData", this.getBlob());

var xhr = new XMLHttpRequest();

if (callback) {

xhr.upload.addEventListener("progress", function (e) {

callback('uploading', e);

}, false);

xhr.addEventListener("load", function (e) {

callback('ok', e);

}, false);

xhr.addEventListener("error", function (e) {

callback('error', e);

}, false);

xhr.addEventListener("abort", function (e) {

callback('cancel', e);

}, false);

}

xhr.open("POST", url);

xhr.send(fd);

}

//音频采集

recorder.onaudioprocess = function (e) {

audioData.input(e.inputBuffer.getChannelData(0));

//record(e.inputBuffer.getChannelData(0));

}

};

//抛出异常

HZRecorder.throwError = function (message) {

alert(message);

throw new function () { this.toString = function () { return message; } }

}

//是否支持录音

HZRecorder.canRecording = (navigator.getUserMedia != null);

//获取录音机

HZRecorder.get = function (callback, config) {

if (callback) {

if (navigator.getUserMedia) {

navigator.getUserMedia(

{ audio: true } //只启用音频

, function (stream) {

var rec = new HZRecorder(stream, config);

callback(rec);

}

, function (error) {

switch (error.code || error.name) {

case 'PERMISSION_DENIED':

case 'PermissionDeniedError':

HZRecorder.throwError('用户拒绝提供信息。');

break;

case 'NOT_SUPPORTED_ERROR':

case 'NotSupportedError':

HZRecorder.throwError('浏览器不支持硬件设备。');

break;

case 'MANDATORY_UNSATISFIED_ERROR':

case 'MandatoryUnsatisfiedError':

HZRecorder.throwError('无法发现指定的硬件设备。');

break;

default:

HZRecorder.throwError('无法打开麦克风。异常信息:' + (error.code || error.name));

break;

}

});

} else {

HZRecorder.throwErr('当前浏览器不支持录音功能。'); return;

}

}

}

window.HZRecorder = HZRecorder;

})(window);

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml">

<head>

<meta http-equiv="Content-Type" content="text/html; charset=utf-8" />

<title></title>

</head>

<body>

<div>

<audio controls autoplay></audio>

<input onclick="startRecording()" type="button" value="录音" />

<input onclick="stopRecording()" type="button" value="停止" />

<input onclick="playRecording()" type="button" value="播放" />

<input onclick="uploadAudio()" type="button" value="提交" />

</div> <script type="text/javascript" src="HZRecorder.js"></script> <script> var recorder; var audio = document.querySelector('audio'); function startRecording() {

HZRecorder.get(function (rec) {

recorder = rec;

recorder.start();

});

} function stopRecording() {

recorder.stop();

} function playRecording() {

recorder.play(audio);

} function uploadAudio() {

recorder.upload("Handler1.ashx", function (state, e) {

switch (state) {

case 'uploading':

//var percentComplete = Math.round(e.loaded * 100 / e.total) + '%';

break;

case 'ok':

//alert(e.target.responseText);

alert("上传成功");

break;

case 'error':

alert("上传失败");

break;

case 'cancel':

alert("上传被取消");

break;

}

});

} </script> </body>

</html>

参考资料

http://www.jsjtt.com/webkaifa/html5/2013-08-28/34.html

http://javascript.ruanyifeng.com/bom/webrtc.html

pc客户端网页录音和压缩的更多相关文章

- HTML5网页录音和压缩,边猜边做..(附源码)

宣传一下自己的qq群: (暗号:C#交流) 欢迎喜欢C#,热爱C#,正在学习C#,准备学习C#的朋友来这里互相学习交流,共同进步 群刚建,人不多,但是都是真正热爱C#的 我也是热爱C#的 希望大家可以 ...

- html5网页录音和语音识别

背景 在输入方式上,人们总是在追寻一种更高效,门槛更低的方式,来降低用户使用产品的学习成本.语音输入也是一种尝试较多的方式,有些直接使用语音(如微信语音聊天),有些需要将语音转化为文字(语音识别).接 ...

- 网易云音乐PC客户端加密API逆向解析

1.前言 网上已经有大量的web端接口解析的方法了,但是对客户端的接口解析基本上找不到什么资料,本文主要分析网易云音乐PC客户端的API接口交互方式. 通过内部的代理设置,使用fiddler作为代理工 ...

- 网络爬虫中Fiddler抓取PC端网页数据包与手机端APP数据包

1 引言 在编写网络爬虫时,第一步(也是极为关键一步)就是对网络的请求(request)和回复(response)进行分析,寻找其中的规律,然后才能通过网络爬虫进行模拟.浏览器大多也自带有调试工具可以 ...

- TeamTalk源码分析(十一) —— pc客户端源码分析

--写在前面的话 在要不要写这篇文章的纠结中挣扎了好久,就我个人而已,我接触windows编程,已经六七个年头了,尤其是在我读研的三年内,基本心思都是花在学习和研究windows程序上 ...

- Java SpringMVC实现PC端网页微信扫码支付完整版

一:前期微信支付扫盲知识 前提条件是已经有申请了微信支付功能的公众号,然后我们需要得到公众号APPID和微信商户号,这个分别在微信公众号和微信支付商家平台上面可以发现.其实在你申请成功支付功能之后,微 ...

- FIddler+Proxifer工具对windows PC客户端进行抓包

python的大火,带动了python爬虫. 爬虫就必定绕不开抓包. 目前最常见的就是网页抓包了,可以使用chrome进行,或者配合其他抓包软件 fiddler. 小程序有些兴起是,如跳一跳之类的,也 ...

- 【转】FIddler+Proxifer工具对windows PC客户端进行抓包

开篇:要想实现写爬虫,抓取到数据,首先我们应该分析客户端和服务器的请求/响应,前提就是我们能监控到客户端是如何与服务器交互的,下面来记录下常见的三种情况下的抓包方法 1.PC端浏览器网页抓包网页板抓包 ...

- 基于Sikuli GUI图像识别框架的PC客户端自动化测试实践

写在前面 最近两天,公司有个PC客户端的测试任务,除了最基础的功能测试外,还包括稳定性测试和兼容性测试需求.刚好去年接触过Sikuli这款基于GUI图像识别框架的自动化测试工具,于是便应用于测试工作中 ...

随机推荐

- 一次dns缓存引发的慘案

时间2015年的某个周六凌晨5点,公司官方的QQ群实用户反馈官网打不开了,但有的用户反馈能够打开.客服爬起来自己用电脑试了一下没有问题,就给客户反馈说.可能是自己网络的问题,请过会在试试.早点8点,越 ...

- 【AIX】查看当前目录下文件与文件夹大小

使用命令: du –sg ./* #以G为单位 du –sm ./* #以M为单位 du –sk ./* #以k为单位

- HttpServletResponse对象(一)

Web服务器收到客户端的http请求,会针对每一次请求,分别创建一个用于代表请求的request对象.和代表响应的response对象.request和response对象即然代表请求和响应,那我们要 ...

- linux下kerberos教程

一.kerberos介绍 Kerberos这一名词来源于希腊神话“三个头的狗——地狱之门守护者”系统设计上采用客户端/服务器结构与DES加密技术,并且能够进行相互认证,即客户端和服务器端均可对对方进行 ...

- 合并果子(NOIP2004)

合并果子(NOIP2004)[问题描述]在一个果园里,多多已经将所有的果子打了下来,而且按果子的不同种类分成了不同的堆.多多决定把所有的果子合成一堆.每一次合并,多多可以把两堆果子合并到一起,消耗的体 ...

- 转: 在Ogre中使用Havok物理引擎(源码)

作者:CYM 众所周知Ogre则是评价很高的一款图形渲染引擎,Havok则是世界一流的物理引擎,今天花了点时间将两者结合在了一块,做了个Demo 由于国内对Havok的研究似乎很少,网上也找不到多少资 ...

- 微信小程序解决方案合集

微信小程序解决方案合集:http://www.wxapp-union.com/special/solution.html 跳坑系列:http://www.wxapp-union.com/forum.p ...

- update pm storage

BEGIN #Routine body goes here... INSERT INTO EMS_PM_STORAGE ( AMOID, GP_BEGIN_TIME, EMS_RECORD_TIME, ...

- LeetCode——Combination Sum II

Given a collection of candidate numbers (C) and a target number (T), find all unique combinations in ...

- 【AI】Computing Machinery and Intelligence - 计算机器与智能

[论文标题] Computing Machinery and Intelligence (1950) [论文作者] A. M. Turing (Alan Mathison Turing) [论文链接] ...