Storm集成Siddhi

《Siddhi初探》中我们介绍了Siddhi的基本使用方法,并表示我们将把Siddhi集成到Storm中作为流任务处理引擎。本文将用《Storm初探》中的例子讲解如何集成Siddhi。

《Storm初探》中的例子把名字字符串进行分割与输出,我们将增加一个SIddhiBolt进行名字过滤,过滤规则是筛选出小于50岁的人的名字。

对于输出:刘备 49 关羽 50 张飞 51,曹操 49 郭嘉 50 荀彧 51。我们将过滤出刘备,曹操两个名字。代码如下:

package com.coshaho.learn.storm; import java.util.ArrayList;

import java.util.List;

import java.util.Map; import org.wso2.siddhi.core.SiddhiAppRuntime;

import org.wso2.siddhi.core.SiddhiManager;

import org.wso2.siddhi.core.event.Event;

import org.wso2.siddhi.core.query.output.callback.QueryCallback;

import org.wso2.siddhi.core.stream.input.InputHandler; import backtype.storm.task.OutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IRichBolt;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Tuple; /**

*

* NamesFilterSiddhiBolt.java Create on 2017年6月26日 下午11:08:45

*

* 类功能说明: 根据年龄过滤名称

*

* Copyright: Copyright(c) 2013

* Company: COSHAHO

* @Version 1.0

* @Author coshaho

*/

public class NamesFilterSiddhiBolt implements IRichBolt

{

private static final long serialVersionUID = 1L; private OutputCollector collector; private InputHandler inputHandler; @SuppressWarnings("rawtypes")

public void prepare(Map stormConf, TopologyContext context,

OutputCollector collector)

{

this.collector = collector;

init();

} private void init()

{

SiddhiManager siddhiManager = new SiddhiManager(); String siddhiApp = "" +

"define stream namesStream (name string, age int, streamid String); " +

"" +

"@info(name = 'namefilter') " +

"from namesStream[age < 50] " +

"select name,streamid,age " +

"insert into outputStream ;"; SiddhiAppRuntime siddhiAppRuntime = siddhiManager.createSiddhiAppRuntime(siddhiApp); siddhiAppRuntime.addCallback("namefilter", new QueryCallback()

{

@Override

public void receive(long timeStamp, Event[] inEvents, Event[] removeEvents)

{

for(Event event : inEvents)

{

String name = event.getData(0) + "";

String streamId = event.getData(1) + "";

String age = event.getData(2) + "";

List<Object> splitList = new ArrayList<Object>();

splitList.add(name);

System.out.println(name + " 年龄为 " + age);

collector.emit(streamId, splitList);

}

}

}); inputHandler = siddhiAppRuntime.getInputHandler("namesStream");

siddhiAppRuntime.start();

} public void execute(Tuple input)

{

String name = input.getString(0);

int age = input.getInteger(1);

String inputStream = input.getSourceStreamId();

try

{

inputHandler.send(new Object[]{name, age, inputStream});

}

catch (InterruptedException e)

{

e.printStackTrace();

} collector.ack(input);

} public void cleanup()

{

} public void declareOutputFields(OutputFieldsDeclarer declarer)

{

declarer.declare(new Fields("name"));

} public Map<String, Object> getComponentConfiguration()

{

return null;

}

}

需要简单的修改一下名称切割Bolt,增加age字段输出

public void execute(Tuple input)

{

// 打印线程号用于追踪Storm的分配策略

Thread current = Thread.currentThread();

String names = input.getString(0);

System.out.println("准备拆分" + names + "。当前线程号是" + current.getId() + "。");

List<Tuple> inputList = new ArrayList<Tuple>();

inputList.add(input);

String[] nameArray = names.split(" ");

int age = 49;

for(String name : nameArray)

{

List<Object> splitList = new ArrayList<Object>();

splitList.add(name);

splitList.add(age);

collector.emit(inputList, splitList);

age++;

}

collector.ack(input);

}

Topo发布时增加Siddhi过滤节点

public static void main(String[] args) throws InterruptedException

{

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout("names-reader", new NamesReaderSpout());

// 启动两个名字分割Task,名字列表随机分配给一个Task

builder.setBolt("names-spliter", new NamesSpliterBolt(), 2)

.shuffleGrouping("names-reader");

builder.setBolt("names-filter", new NamesFilterSiddhiBolt(), 1)

.shuffleGrouping("names-spliter");

// 启动两个Hello World Task,相同名字发送到同一个Task

builder.setBolt("hello-world", new HelloWorldBolt(), 2)

.fieldsGrouping("names-filter", new Fields("name")); Config conf = new Config();

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("storm-test", conf, builder.createTopology());

}

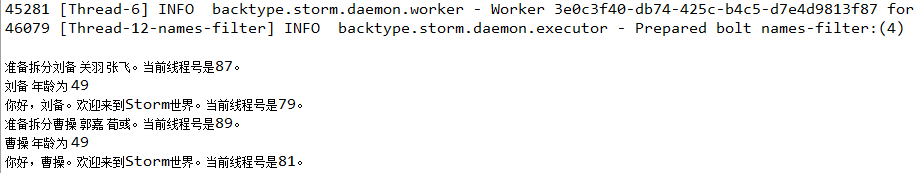

输出如下

Storm集成Siddhi的更多相关文章

- Storm集成Kafka应用的开发

我们知道storm的作用主要是进行流式计算,对于源源不断的均匀数据流流入处理是非常有效的,而现实生活中大部分场景并不是均匀的数据流,而是时而多时而少的数据流入,这种情况下显然用批量处理是不合适的,如果 ...

- storm集成kafka的应用,从kafka读取,写入kafka

storm集成kafka的应用,从kafka读取,写入kafka by 小闪电 0前言 storm的主要作用是进行流式的实时计算,对于一直产生的数据流处理是非常迅速的,然而大部分数据并不是均匀的数据流 ...

- Storm 学习之路(八)—— Storm集成HDFS和HBase

一.Storm集成HDFS 1.1 项目结构 本用例源码下载地址:storm-hdfs-integration 1.2 项目主要依赖 项目主要依赖如下,有两个地方需要注意: 这里由于我服务器上安装的是 ...

- Storm 系列(八)—— Storm 集成 HDFS 和 HBase

一.Storm集成HDFS 1.1 项目结构 本用例源码下载地址:storm-hdfs-integration 1.2 项目主要依赖 项目主要依赖如下,有两个地方需要注意: 这里由于我服务器上安装的是 ...

- storm集成kafka

kafkautil: import java.util.Properties; import kafka.javaapi.producer.Producer; import kafka.produce ...

- Storm集成Kafka的Trident实现

原本打算将storm直接与flume直连,发现相应组件支持比较弱,topology任务对应的supervisor也不一定在哪个节点上,只能采用统一的分布式消息服务Kafka. 原本打算将结构设 ...

- Storm集成Kafka编程模型

原创文章,转载请注明: 转载自http://www.cnblogs.com/tovin/p/3974417.html 本文主要介绍如何在Storm编程实现与Kafka的集成 一.实现模型 数据流程: ...

- Storm 学习之路(七)—— Storm集成 Redis 详解

一.简介 Storm-Redis提供了Storm与Redis的集成支持,你只需要引入对应的依赖即可使用: <dependency> <groupId>org.apache.st ...

- Storm 系列(七)—— Storm 集成 Redis 详解

一.简介 Storm-Redis 提供了 Storm 与 Redis 的集成支持,你只需要引入对应的依赖即可使用: <dependency> <groupId>org.apac ...

随机推荐

- jenkins定时任务未生效解决

近期在配置jenkins定时任务时,发现未生效,并没有按时触发任务 解决思路: 1.先查看下我们的定时任务有没有选择正确,如下说明: Poll SCM:定时检查源码变更,如果有更新就checkout最 ...

- MVC @RenderBody、@RenderSection、@RenderPage、@Html.RenderPartial、@Html.RenderAction

1.@RenderBody() 作用和母版页中的服务器控件类似,当创建基于此布局页面的视图时,视图的内容会和布局页面合并,而新创建视图的内容会通过布局页面的@RenderBody()方法呈现在标签之间 ...

- Unity3D笔记 愤怒的小鸟<一>场景切换

新建3个场景,场景1 Start 十秒后自动切换到场景2 Splash,场景2在二秒后自动切换到场景3 Selection 一.场景一Start 二.场景2 Splash 三.场景3 Selectio ...

- windows下的zookeeper安装

先在官网下载安装包(https://www.apache.org/dyn/closer.cgi/zookeeper/),单机安装非常简单,只要获取到 Zookeeper 的压缩包并解压到某个目录如:C ...

- python模块路径

Python会在以下路径中搜索它想要寻找的模块: 1. 程序所在的文件夹 2. 标准库的安装路径 3. 操作系统环境变量PYTHONPATH所包含的路径 将自定义库的路径添加到Python的库路径中去 ...

- 极大既然估计和高斯分布推导最小二乘、LASSO、Ridge回归

最小二乘法可以从Cost/Loss function角度去想,这是统计(机器)学习里面一个重要概念,一般建立模型就是让loss function最小,而最小二乘法可以认为是 loss function ...

- spring读取配置文件内容并自动注入

添加注解: @PropertySource(value={"classpath:venus.properties"}) 示例: import org.springframework ...

- 小希的迷宫---hdu1272

http://acm.hdu.edu.cn/showproblem.php?pid=1272 #include<stdio.h> #include<string.h> #inc ...

- 将字符串类型转化为date类型

直接上代码 import java.text.ParseException; import java.text.SimpleDateFormat; import java.util.Date; pub ...

- sql server维护解决方案(备份、检查完整性、索引碎片整理)

请务必看原文 原文:https://ola.hallengren.com/frequently-asked-questions.html 经常问的问题 入门 如何开始使用SQL Server维护解决方 ...