spark集成hbase与hive数据转换与代码练习

帮一个朋友写个样例,顺便练手啦~一直在做平台的各种事,但是代码后续还要精进啊。。。

import java.util.Date import org.apache.hadoop.hbase.HBaseConfiguration

import org.apache.hadoop.hbase.client.{Put, Scan, Result}

import org.apache.hadoop.hbase.io.ImmutableBytesWritable

import org.apache.hadoop.hbase.mapred.TableOutputFormat

import org.apache.hadoop.hbase.mapreduce.TableInputFormat

import org.apache.hadoop.hbase.util.Bytes

import org.apache.hadoop.mapred.JobConf

import org.apache.log4j.{Level, Logger}

import org.apache.spark.rdd.RDD

import org.apache.spark.sql.DataFrame

import org.apache.spark.sql.hive.HiveContext

import org.apache.spark.{SparkContext, SparkConf} /**

* Created by ysy on 2/10/17.

*/

object test { case class ysyTest(LS_certifier_no: String,loc: String,LS_phone_no: String) def main (args: Array[String]) {

val sparkConf = new SparkConf().setMaster("local").setAppName("ysy").set("spark.executor.memory", "1g")

val sc = new SparkContext(sparkConf)

val sqlContext = new HiveContext(sc)

sqlContext.sql("drop table pkq")

val columns = "LS_certifier_no,LS_location,LS_phone_no"

val hbaseRDD = dataInit(sc,"EVENT_LOG_LBS",columns).map(data =>{

val id =Bytes.toString(data._2.getValue("f1".getBytes, "LS_certifier_no".getBytes))

val loc = Bytes.toString(data._2.getValue("f1".getBytes, "LS_location".getBytes))

val phone = Bytes.toString(data._2.getValue("f1".getBytes, "LS_phone_no".getBytes))

(id,loc,phone)

})

val showData = hbaseRDD.foreach(println)

val datas = hbaseRDD.filter(_._1 != null).filter(_._2 != null).filter(_._3 != null)

val hiveDF = initHiveTableFromHbase(sc:SparkContext,sqlContext,datas)

writeHiveTableToHbase(sc,hiveDF) } def initHiveTableFromHbase(sc:SparkContext,sqlContext: HiveContext,hiveRDD:RDD[(String,String,String)]) : DataFrame = {

val hRDD = hiveRDD.map(p => ysyTest(p._1,p._2,p._3))

val hiveRDDSchema = sqlContext.createDataFrame(hiveRDD)

hiveRDDSchema.registerTempTable("pkq")

hiveRDDSchema.show(10)

hiveRDDSchema

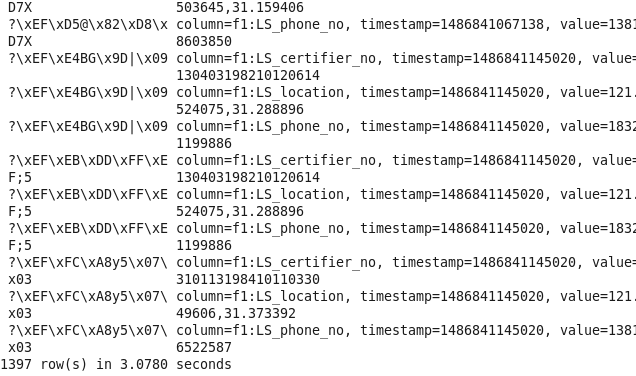

} def dataInit(sc : SparkContext,tableName : String,columns : String) : RDD[(ImmutableBytesWritable,Result)] = {

val configuration = HBaseConfiguration.create()

configuration.addResource("hbase-site.xml")

configuration.set(TableInputFormat.INPUT_TABLE,tableName )

val scan = new Scan

val column = columns.split(",")

for(columnName <- column){

scan.addColumn("f1".getBytes(),columnName.getBytes())

}

val hbaseRDD = sc.newAPIHadoopRDD(configuration,classOf[TableInputFormat],classOf[org.apache.hadoop.hbase.io.ImmutableBytesWritable],classOf[org.apache.hadoop.hbase.client.Result])

System.out.println(hbaseRDD.count())

hbaseRDD

} def writeHiveTableToHbase(sc : SparkContext,hiveDF : DataFrame) = {

val configuration = HBaseConfiguration.create()

configuration.addResource("hbase-site.xml ")

configuration.set(TableOutputFormat.OUTPUT_TABLE,"EVENT_LOG_LBS")

val jobConf = new JobConf(configuration)

jobConf.setOutputFormat(classOf[TableOutputFormat]) val putData = hiveDF.map(data =>{

val LS_certifier_no = data(0)

val LS_location = data(1)

val LS_phone_no = data(2)

(LS_certifier_no,LS_location,LS_phone_no)

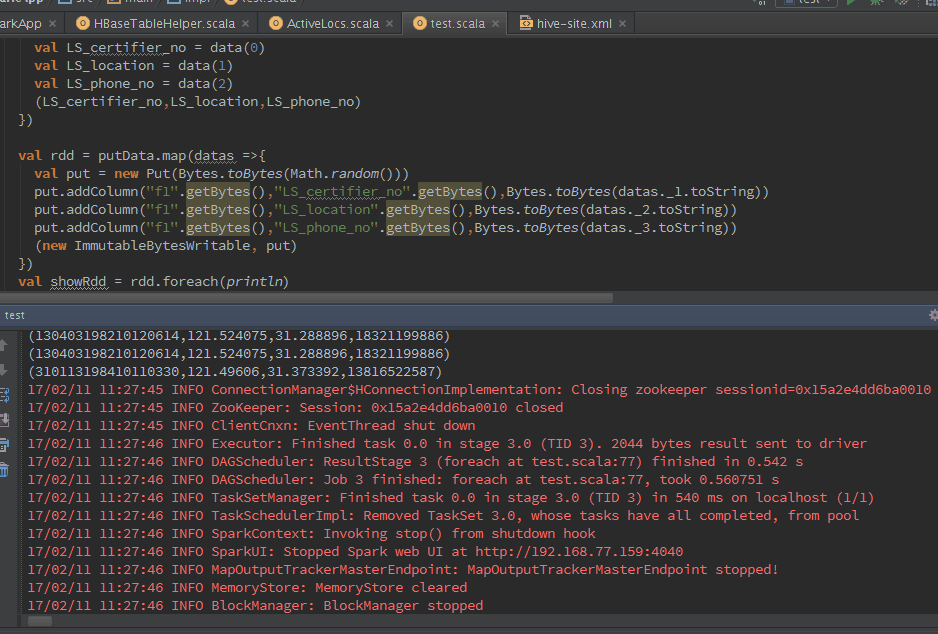

}) val rdd = putData.map(datas =>{

val put = new Put(Bytes.toBytes(Math.random()))

put.addColumn("f1".getBytes(),"LS_certifier_no".getBytes(),Bytes.toBytes(datas._1.toString))

put.addColumn("f1".getBytes(),"LS_location".getBytes(),Bytes.toBytes(datas._2.toString))

put.addColumn("f1".getBytes(),"LS_phone_no".getBytes(),Bytes.toBytes(datas._3.toString))

(new ImmutableBytesWritable, put)

})

val showRdd = rdd.foreach(println)

rdd.saveAsHadoopDataset(jobConf)

} }

spark集成hbase与hive数据转换与代码练习的更多相关文章

- 大数据学习系列之八----- Hadoop、Spark、HBase、Hive搭建环境遇到的错误以及解决方法

前言 在搭建大数据Hadoop相关的环境时候,遇到很多了很多错误.我是个喜欢做笔记的人,这些错误基本都记载,并且将解决办法也写上了.因此写成博客,希望能够帮助那些搭建大数据环境的人解决问题. 说明: ...

- Spark整合HBase,Hive

背景: 场景需求1:使用spark直接读取HBASE表 场景需求2:使用spark直接读取HIVE表 场景需求3:使用spark读取HBASE在Hive的外表 摘要: 1.背景 2.提交脚本 内容 场 ...

- spark集成hive遭遇mysql check失败的问题

问题: spark集成hive,启动spark-shell或者spark-sql的时候,报错: INFO MetaStoreDirectSql: MySQL check failed, assumin ...

- 大数据学习系列之九---- Hive整合Spark和HBase以及相关测试

前言 在之前的大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 中介绍了集群的环境搭建,但是在使用hive进行数据查询的时候会非常的慢,因为h ...

- HBASE与hive对比使用以及HBASE常用shell操作。与sqoop的集成

2.6.与 Hive 的集成2.6.1.HBase 与 Hive 的对比1) Hive(1) 数据仓库Hive 的本质其实就相当于将 HDFS 中已经存储的文件在 Mysql 中做了一个双射关系,以方 ...

- 大数据技术之_11_HBase学习_02_HBase API 操作 + HBase 与 Hive 集成 + HBase 优化

第6章 HBase API 操作6.1 环境准备6.2 HBase API6.2.1 判断表是否存在6.2.2 抽取获取 Configuration.Connection.Admin 对象的方法以及关 ...

- Hbase与hive集成与对比

HBase与Hive的对比 1.Hive (1) 数据仓库 Hive的本质其实就相当于将HDFS中已经存储的文件在Mysql中做了一个双射关系,以方便使用HQL去管理查询. (2) 用于数据分析.清洗 ...

- hbase与Hive的集成

1 HBase与Hive的对比 1.Hive (1) 数据仓库 Hive的本质其实就相当于将HDFS中已经存储的文件在Mysql中做了一个双射关系,以方便使用HQL去管理查询. (2) 用于数据分析. ...

- Hive集成HBase;安装pig

Hive集成HBase 配置 将hive的lib/中的HBase.jar包用实际安装的Hbase的jar包替换掉 cd /opt/hive/lib/ ls hbase-0.94.2* rm -rf ...

随机推荐

- 通过Xshell如何从Linux服务器下载文件(亲测可行)

到网上下载lrzsz安装包,这里以lrzsz-0.12.20.tar.gz为例 2 打开终端 cd 到安装包所在目录 tar zxvf lrzsz-0.12.20.tar.gz 解压安装包 3 进入解 ...

- VisualSVN Server的配置和使用方法

VisualSVN Server是免费的,而VisualSVN是收费的.VisualSVN是SVN的客户端,和Visual Studio集成在一起, VisualSvn Server是SVN的服务器端 ...

- Putty(菩提)远程连接服务器教程听语音

Putty是一款优秀的免费串行接口连接软件,由于其绿色和性能深受业界好评,绿色是指putty使用便捷只需要将putty下载到电脑,无需安装,只需要在电脑上新建一个快捷方式就可以使用.出色的性能是指pu ...

- 使用git bash提交代码到github托管

1.首先登录到https://github.com注册Github帐号,并且创建一个repository. 或者登录到 https://git.oschina.net/注册账号,并且创建一个rep ...

- mysql 查看索引使用情况

show status like 'Handler_read%'; Handler_read_key 代表着一个行被索引值读取的次数,值很低表明索引不经常用到,增加索引对性能改善不高. Handle ...

- ImmutableMap

不可变集合,为什么使用它呢?线程安全\更有效的利用内存\可作为常量 ImmutableMap.<String, Object> builder().put("yananList& ...

- Linux修改主机名脚本-不重启-支持RedHat、SUSE

需要用脚本修改主机名,涉及RedHat.SUSE系统,并且要求修改立即生效且不重启,下面就是我的脚本. 使用脚本的方法如下: 1 首先创建一个脚本文件,假如命名为ModifyHostname.sh: ...

- 函数式编程--使用lambda表达式

前面一篇博客我们已经说到了,lambda表达式允许使用更简洁的代码来创建只有一个抽象方法的接口的实例.现在我们来写一段java的命令者模式来自己研究下lambda表达式的语法. 这里重复下命令者模式: ...

- 【转】Awk 命令学习总结、AWk命令系列学习(linux shell)

前面的话 学习linux 的同人,都知道linux shell文本处理能力非常强大.有一组强大的文本处理工具:grep,sed,awk . 其中grep 经常用作查找匹配文本.sed用作文本编辑替换. ...

- redis数据类型-有序集合

有序集合类型 在集合类型的基础上有序集合类型为集合中的每个元素都关联了一个分数,这使得我们不仅可以完成插入.删除和判断元素是否存在等集合类型支持的操作,还能够获得分数最高(或最低)的前N个元素.获得指 ...