爬虫框架之Scrapy(四 ImagePipeline)

ImagePipeline

使用scrapy框架我们除了要下载文本,还有可能需要下载图片,scrapy提供了ImagePipeline来进行图片的下载。

ImagePipeline还支持以下特别的功能:

1 生成缩略图:通过配置IMAGES_THUMBS = {'size_name': (width_size,heigh_size),}

2 过滤小图片:通过配置IMAGES_MIN_HEIGHT和IMAGES_MIN_WIDTH来过滤过小的图片。

具体其他功能可以看下参考官网手册:https://docs.scrapy.org/en/latest/topics/media-pipeline.html.

ImagePipelines的工作流程

1 在spider中爬取需要下载的图片链接,将其放入item中的image_urls.

2 spider将其传送到pipieline

3 当ImagePipeline处理时,它会检测是否有image_urls字段,如果有的话,会将url传递给scrapy调度器和下载器

4 下载完成后会将结果写入item的另一个字段images,images包含了图片的本地路径,图片校验,和图片的url。

示例 爬取巴士lol的英雄美图

只爬第一页

第一步:items.py

import scrapy class Happy4Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

image_urls = scrapy.Field()

images = scrapy.Field()

爬虫文件lol.py

# -*- coding: utf-8 -*-

import scrapy

from happy4.items import Happy4Item class LolSpider(scrapy.Spider):

name = 'lol'

allowed_domains = ['lol.tgbus.com']

start_urls = ['http://lol.tgbus.com/tu/yxmt/'] def parse(self, response):

li_list = response.xpath('//div[@class="list cf mb30"]/ul//li')

for one_li in li_list:

item = Happy4Item()

item['image_urls'] =one_li.xpath('./a/img/@src').extract()

yield item

最后 settings.py

BOT_NAME = 'happy4' SPIDER_MODULES = ['happy4.spiders']

NEWSPIDER_MODULE = 'happy4.spiders' # Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0' # Obey robots.txt rules

ROBOTSTXT_OBEY = False

ITEM_PIPELINES = {

'scrapy.pipelines.images.ImagesPipeline': 1,

}

IMAGES_STORE = 'images'

不需要操作管道文件,就可以爬去图片到本地

极大的减少了代码量.

注意:因为图片管道会尝试将所有图片都转换成JPG格式的,你看源代码的话也会发现图片管道中文件名类型直接写死为JPG的。所以如果想要保存原始类型的图片,就应该使用文件管道。

示例 爬取mm131美女图片

要求爬取的就是这个网站

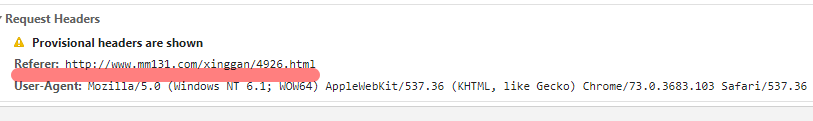

这个网站是有反爬的,当你直接去下载一个图片的时候,你会发现url被重新指向了别处,或者有可能是直接报错302,这是因为它使用了referer这个请求头里的字段,当你打开一个图片的url的时候,你的请求头里必须有referer,不然就会被识别为爬虫文件,禁止你的爬取,那么如何解决呢?

手动在爬取每个图片的时候添加referer字段。

xingan.py

# -*- coding: utf-8 -*-

import scrapy

from happy5.items import Happy5Item

import re class XinganSpider(scrapy.Spider):

name = 'xingan'

allowed_domains = ['www.mm131.com']

start_urls = ['http://www.mm131.com/xinggan/'] def parse(self, response):

every_html = response.xpath('//div[@class="main"]/dl//dd')

for one_html in every_html[0:-1]:

item = Happy5Item()

# 每个图片的链接

link = one_html.xpath('./a/@href').extract_first()

# 每个图片的名字

title = one_html.xpath('./a/img/@alt').extract_first()

item['title'] = title

# 进入到每个标题里面

request = scrapy.Request(url=link, callback=self.parse_one, meta={'item':item})

yield request # 每个人下面的图集

def parse_one(self, response):

item = response.meta['item']

# 找到总页数

total_page = response.xpath('//div[@class="content-page"]/span[@class="page-ch"]/text()').extract_first()

num = int(re.findall('(\d+)', total_page)[0])

# 找到当前页数

now_num = response.xpath('//div[@class="content-page"]/span[@class="page_now"]/text()').extract_first()

now_num = int(now_num)

# 当前页图片的url

every_pic = response.xpath('//div[@class="content-pic"]/a/img/@src').extract()

# 当前页的图片url

item['image_urls'] = every_pic

# 当前图片的refer

item['referer'] = response.url

yield item # 如果当前数小于总页数

if now_num < num:

if now_num == 1:

url1 = response.url[0:-5] + '_%d'%(now_num+1) + '.html'

elif now_num > 1:

url1 = re.sub('_(\d+)', '_' + str(now_num+1), response.url)

headers = {

'referer':self.start_urls[0]

}

# 给下一页发送请求

yield scrapy.Request(url=url1, headers=headers, callback=self.parse_one, meta={'item':item})

items.py

import scrapy class Happy5Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

image_urls = scrapy.Field()

images = scrapy.Field()

title = scrapy.Field()

referer = scrapy.Field()

pipelines.py

from scrapy.pipelines.images import ImagesPipeline

from scrapy.exceptions import DropItem

from scrapy.http import Request class Happy5Pipeline(object):

def process_item(self, item, spider):

return item class QiushiImagePipeline(ImagesPipeline): # 下载图片时加入referer请求头

def get_media_requests(self, item, info):

for image_url in item['image_urls']:

headers = {'referer':item['referer']}

yield Request(image_url, meta={'item': item}, headers=headers)

# 这里把item传过去,因为后面需要用item里面的书名和章节作为文件名 # 获取图片的下载结果, 控制台查看

def item_completed(self, results, item, info):

image_paths = [x['path'] for ok, x in results if ok]

if not image_paths:

raise DropItem("Item contains no images")

return item # 修改文件的命名和路径

def file_path(self, request, response=None, info=None):

item = request.meta['item']

image_guid = request.url.split('/')[-1]

filename = './{}/{}'.format(item['title'], image_guid)

return filename

settings.py

BOT_NAME = 'happy5' SPIDER_MODULES = ['happy5.spiders']

NEWSPIDER_MODULE = 'happy5.spiders' # Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0' # Obey robots.txt rules

ROBOTSTXT_OBEY = False

ITEM_PIPELINES = {

# 'scrapy.pipelines.images.ImagesPipeline': 1,

'happy5.pipelines.QiushiImagePipeline': 2,

}

IMAGES_STORE = 'images'

得到图片文件:

这种图还是要少看。

爬虫框架之Scrapy(四 ImagePipeline)的更多相关文章

- Scrapy爬虫框架教程(四)-- 抓取AJAX异步加载网页

欢迎关注博主主页,学习python视频资源,还有大量免费python经典文章 sklearn实战-乳腺癌细胞数据挖掘 https://study.163.com/course/introduction ...

- 06 爬虫框架:scrapy

爬虫框架:scrapy 一 介绍 Scrapy一个开源和协作的框架,其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的,使用它可以以快速.简单.可扩展的方式从网站中提取所需的数据.但目前S ...

- Python-S9-Day125-Web微信&爬虫框架之scrapy

01 今日内容概要 02 内容回顾:爬虫 03 内容回顾:网络和并发编程 04 Web微信之获取联系人列表 05 Web微信之发送消息 06 为什么request.POST拿不到数据 07 到底使用j ...

- 九、爬虫框架之Scrapy

爬虫框架之Scrapy 一.介绍 二.安装 三.命令行工具 四.项目结构以及爬虫应用简介 五.Spiders 六.Selectors 七.Items 八.Item Pipelin 九. Dowload ...

- Golang 网络爬虫框架gocolly/colly 四

Golang 网络爬虫框架gocolly/colly 四 爬虫靠演技,表演得越像浏览器,抓取数据越容易,这是我多年爬虫经验的感悟.回顾下个人的爬虫经历,共分三个阶段:第一阶段,09年左右开始接触爬虫, ...

- 爬虫框架之Scrapy

一.介绍 二.安装 三.命令行工具 四.项目结构以及爬虫应用简介 五.Spiders 六.Selectors 七.Items 八.Item Pipelin 九. Dowloader Middeware ...

- 洗礼灵魂,修炼python(72)--爬虫篇—爬虫框架:Scrapy

题外话: 前面学了那么多,相信你已经对python很了解了,对爬虫也很有见解了,然后本来的计划是这样的:(请忽略编号和日期,这个是不定数,我在更博会随时改的) 上面截图的是我的草稿 然后当我开始写博文 ...

- 爬虫框架:scrapy

一 介绍 Scrapy一个开源和协作的框架,其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的,使用它可以以快速.简单.可扩展的方式从网站中提取所需的数据.但目前Scrapy的用途十分广泛,可 ...

- 爬虫框架之Scrapy(一)

scrapy简介 scrapy是一个用python实现为了爬取网站数据,提取结构性数据而编写的应用框架,功能非常的强大. scrapy常应用在包括数据挖掘,信息处理或者储存历史数据的一系列程序中. s ...

随机推荐

- BZOJ_3653_谈笑风生_树状数组

BZOJ_3653_谈笑风生_树状数组 Description 设T 为一棵有根树,我们做如下的定义: ? 设a和b为T 中的两个不同节点.如果a是b的祖先,那么称“a比b不知道 高明到哪里去了”. ...

- 【毕业原版】-《贝德福特大学毕业证书》Bedfordhire一模一样原件

☞贝德福特大学毕业证书[微/Q:865121257◆WeChat:CC6669834]UC毕业证书/联系人Alice[查看点击百度快照查看][留信网学历认证&博士&硕士&海归& ...

- STM32F1固件库文件讲解与基于固件库新建MDK工程模板

操作系统:win10 1.文件目录 (在cmd下用"cd 文件夹" 进入到要显示的文件夹,如cd d:\en.stsw-stm32054,然后输入tree 回车就会出现上图的目录结 ...

- MIP 与 AMP 合作进展(3月7日)

"到目前为止,全网通过 MIP 校验的网页已超10亿.除了代码和缓存, MIP 还想做更多来改善用户体验移动页面." 3月7日,MIP 项目负责人在首次 AMP CONF 上发言. ...

- Oracle执行计划学习笔记

目录 一.获取执行计划的方法 (1) explain plan for (2) set autotrace on (3) statistics_level=all (4) dbms_xplan.dis ...

- asp.net core系列 51 Identity 授权(下)

1.6 基于资源的授权 前面二篇中,熟悉了五种授权方式(对于上篇讲的策略授权,还有IAuthorizationPolicyProvider的自定义授权策略提供程序没有讲,后面再补充).本篇讲的授权方式 ...

- Python与家国天下

导读:Python猫是一只喵星来客,它爱地球的一切,特别爱优雅而无所不能的 Python.我是它的人类朋友豌豆花下猫,被授权润色与发表它的文章.如果你是第一次看到这个系列文章,那我强烈建议,请先看看它 ...

- MOCK API 的定义及实践(使用eolinker实现)

MOCK API 的定义 根据百度百科的定义,mock测试就是在测试过程中,对于某些不容易构造或者不容易获取的对象,用一个虚拟的对象来创建以便测试的测试方法.这个虚拟的对象就是mock对象,mock对 ...

- 《k8s-1.13版本源码分析》-源码调试

源码分析系列文章已经开源到github,地址如下: github:https://github.com/farmer-hutao/k8s-source-code-analysis gitbook:ht ...

- 我们为什么要搞长沙.NET技术社区(二)

我们为什么要搞长沙.NET技术社区(二) 某种意义上讲,长沙和中国大部分内地城市一样,都是互联网时代的灯下黑.没有真正意义上的互联网公司,例如最近发布的中国互联网企业一百强中没有一家湖南或者长沙的公司 ...