Kafka与.net core(二)zookeeper

1.zookeeper简单介绍

1.1作用

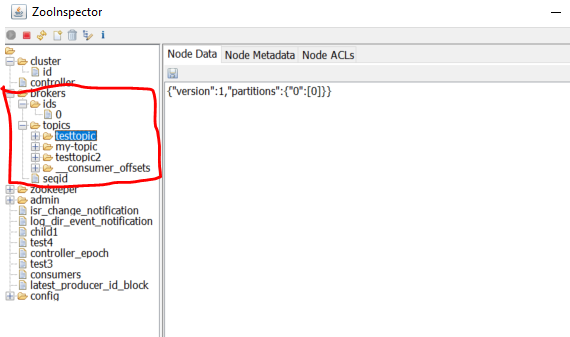

zookeeper的作用是存储kafka的服务器信息,topic信息,和cunsumer信息。如下图:

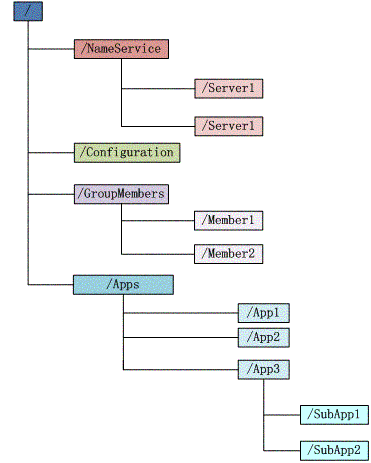

而zookeeper是个什么东西呢?简单来说就是一个具有通知机制的文件系统,引用网路上的一张图

可以看出来zookeeper是一个树形的文件结构,我们可以自定义node与node的值,并对node进行监视,当node的结构或者值变化时,我们可以收到通知。

1.2node类型

2.zookeeper命令操作

连接zookeeper

[root@iz2zei2y693gtrgwlibzlwz ~]# zkCli.sh -server ip:

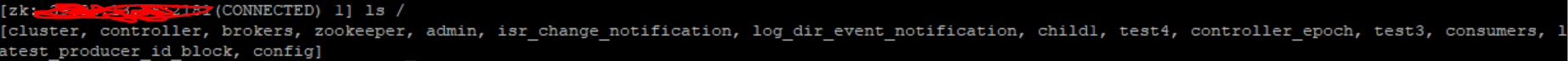

查看zookeeper的所有节点

ls /

查看某个节点的子节点

ls /brokers

创建节点

create /testaa dataaaa

获取节点的值

get /testaa

设置节点值

set /testaa aaabbb

删除节点

delete /testaa

这么看来实际上zookeeper跟数据库类似也是CURD操作,我们再来看看zookeeper的安全控制ACL

3.zookeeper的ACL

3.1ZK的节点有5种操作权限:

3.2身份的认证有4种方式:

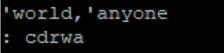

3.3ACL实例

[zk: :(CONNECTED) ] create /cys cys

访问一一下

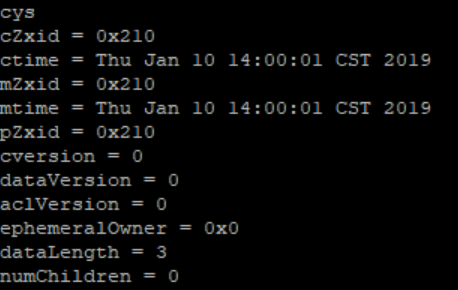

[zk: :(CONNECTED) ] get /cys

查看一下Acl

[zk: :(CONNECTED) ] getAcl /cys

下面我们设置一下他的用户

命令为:

具体操作如下:

addauth digest cys:

setAcl /cys auth:cys::crwda

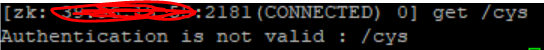

我们ctrl+c退出zkCli,重新连接一下,然后查询

get /cys

结果如下:

提示我们认证失败,我们登陆一下

addauth digest cys:

结果如下:

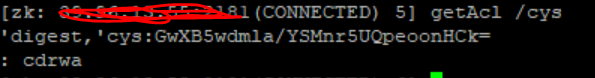

我们在查看一下/cys节点的Acl

可以看出来用户cys对应的密码(加密后的)和权限cdrwa

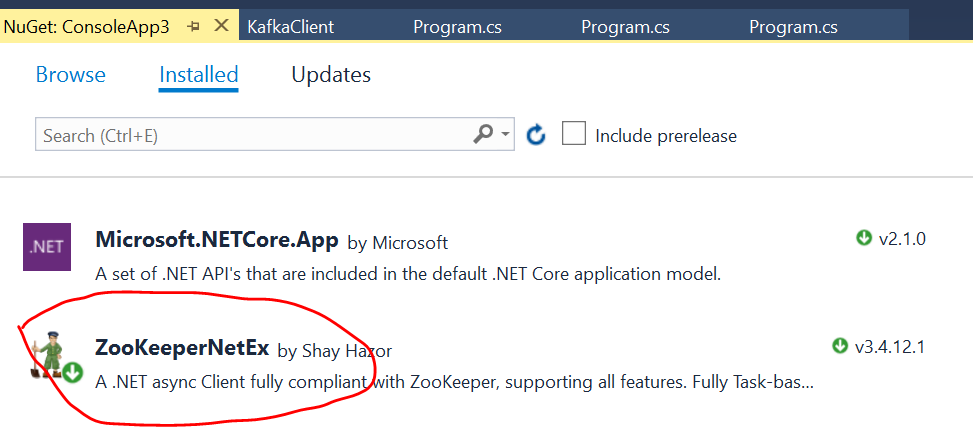

4..net core 操作

4.1新建server项目,引入ZookeeperNetEx这个nuget包

Server端代码

using org.apache.zookeeper;

using org.apache.zookeeper.data; using System;

using System.Collections.Generic;

using System.Text;

using System.Threading.Tasks; namespace ConsoleApp3

{

class Program

{

static void Main(string[] args)

{

while (true)

{

Console.WriteLine("输入path");

var path = Console.ReadLine();

string address = "39.**.**.**:2181";

ZooKeeper _zooKeeper = new ZooKeeper(address, * , null);

ZooKeeper.States states = _zooKeeper.getState();

//是否存在

Task<org.apache.zookeeper.data.Stat> stat = _zooKeeper.existsAsync(path);

stat.Wait();

if (stat.Result != null && stat.Status.ToString().ToLower() == "RanToCompletion".ToLower())

{

//已存在

Console.WriteLine($"{path}已存在");

}

else

{

Console.WriteLine("输入data");

var data = Console.ReadLine();

//创建

Task<string> task = _zooKeeper.createAsync(path, System.Text.Encoding.UTF8.GetBytes(data), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

task.Wait();

if (!string.IsNullOrEmpty(task.Result) && task.Status.ToString().ToLower() == "RanToCompletion".ToLower())

{

Console.WriteLine($"{path}创建成功");

}

}

Console.WriteLine("输入set data");

var dataA = Console.ReadLine();

//set值

Task<org.apache.zookeeper.data.Stat> statA = _zooKeeper.setDataAsync(path, System.Text.Encoding.UTF8.GetBytes(dataA));

statA.Wait();

if (statA.Result != null && statA.Status.ToString().ToLower() == "RanToCompletion".ToLower())

{

Console.WriteLine("set 成功");

} Console.WriteLine("输入子path");

var childpath = Console.ReadLine(); Console.WriteLine("输入子data");

var childdata = Console.ReadLine();

Task<string> childtask = _zooKeeper.createAsync(childpath, System.Text.Encoding.UTF8.GetBytes(childdata), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

childtask.Wait();

if (!string.IsNullOrEmpty(childtask.Result) && childtask.Status.ToString().ToLower() == "RanToCompletion".ToLower())

{

Console.WriteLine($"{childpath}创建成功");

} Console.ReadLine();

_zooKeeper.closeAsync().Wait();

}

////删除

//Console.WriteLine("输入delete path");

//var pathB = Console.ReadLine();

//Task taskA = _zooKeeper.deleteAsync(pathB);

//taskA.Wait();

//if (taskA.Status.ToString().ToLower() == "RanToCompletion".ToLower())

//{

// Console.WriteLine("delete 成功");

//} ////获取数据

//Task<DataResult> dataResult = _zooKeeper.getDataAsync(path, new NodeWatcher());

//dataResult.Wait();

//if (dataResult.Result != null && dataResult.Status.ToString().ToLower() == "RanToCompletion".ToLower())

//{

// Console.WriteLine(Encoding.UTF8.GetString(dataResult.Result.Data));

//}

}

} }

4.2新建client项目,引入ZookeeperNetEx这个nuget包

客户端代码

using org.apache.zookeeper;

using org.apache.zookeeper.data;

using System;

using System.Collections.Generic;

using System.Threading;

using System.Threading.Tasks; namespace Client

{

class Program

{

static void Main(string[] args)

{

Console.WriteLine("输入path");

var path = Console.ReadLine();

string address = "39.**.**.**:2181";

ZooKeeper _zooKeeper = new ZooKeeper(address, * , new DefaultWatcher());

//用户登陆

_zooKeeper.addAuthInfo("digest", System.Text.Encoding.Default.GetBytes("cys:123456"));

//获取child

var getresult = _zooKeeper.getChildrenAsync(path, true);

getresult.Wait(); //获取数据

Task<DataResult> dataResult = _zooKeeper.getDataAsync(path,true);

dataResult.Wait();

Thread.Sleep();

}

} public class DefaultWatcher : Watcher

{

internal static readonly Task CompletedTask = Task.FromResult(); /// <summary>

/// 接收通知

/// </summary>

/// <param name="event"></param>

/// <returns></returns>

public override Task process(WatchedEvent @event)

{

Console.WriteLine(string.Format("接收到ZooKeeper服务端的通知,State是:{0},EventType是:{1},Path是:{2}", @event.getState(), @event.get_Type(), @event.getPath() ?? string.Empty));

return CompletedTask;

}

}

}

这样当server端操作的时候,client端会通过watcher收到通知

Kafka与.net core(二)zookeeper的更多相关文章

- 【原创】kafka server源代码分析(二)

十四.AbstractFetcherManager.scala 该scala定义了两个case类和一个抽象类.两个case类很简单: 1. BrokerAndFectherId:封装了一个broker ...

- Kafka设计解析(二)Kafka High Availability (上)

转载自 技术世界,原文链接 Kafka设计解析(二)- Kafka High Availability (上) Kafka从0.8版本开始提供High Availability机制,从而提高了系统可用 ...

- 初试kafka消息队列中间件二(采用java代码收发消息)

初试kafka消息队列中间件二(采用java代码收发消息) 上一篇 初试kafka消息队列中间件一 今天的案例主要是将采用命令行收发信息改成使用java代码实现,根据上一篇的接着写: 先启动Zooke ...

- Apache Kafka简介与安装(二)

Kafka在Windows环境上安装与运行 简介 Apache kafka 是一个分布式的基于push-subscribe的消息系统,它具备快速.可扩展.可持久化的特点.它现在是Apache旗下的一个 ...

- Kafka学习之(二)Centos下安装Kafka

环境:Centos6.4,官方下载地址:http://kafka.apache.org/downloads ,前提是还需要安装了Java环境,本博客http://www.cnblogs.com/wt ...

- Kafka设计解析(二十)Apache Flink Kafka consumer

转载自 huxihx,原文链接 Apache Flink Kafka consumer Flink提供了Kafka connector用于消费/生产Apache Kafka topic的数据.Flin ...

- 【Spark】Spark Streaming + Kafka direct 的 offset 存入Zookeeper并重用

Spark Streaming + Kafka direct 的 offset 存入Zookeeper并重用 streaming offset设置_百度搜索 将 Spark Streaming + K ...

- ExpandoObject与DynamicObject的使用 RabbitMQ与.net core(一)安装 RabbitMQ与.net core(二)Producer与Exchange ASP.NET Core 2.1 : 十五.图解路由(2.1 or earler) .NET Core中的一个接口多种实现的依赖注入与动态选择看这篇就够了

ExpandoObject与DynamicObject的使用 using ImpromptuInterface; using System; using System.Dynamic; names ...

- Docker + .NET Core(二)

原文:Docker + .NET Core(二) 前言: 环境:centos7.5 64 位 正文: 首先我们在宿主机上安装 .NET Core SDK sudo rpm --import https ...

- CentOS-Docker搭建Kafka(单点,含:zookeeper、kafka-manager)

Docker搭建Kafka(单点,含:zookeeper.kafka-manager) 下载相关容器 $ docker pull wurstmeister/zookeeper $ docker pul ...

随机推荐

- Django学习---信号

Django学习之信号 如果我想对所有在数据库创建数据的时候记录一条日志. 比如我们在django中往数据库中增加一条数据,希望生成一条操作日志,或者在数据保存和数据保存之后都保存一条操作日志,那我们 ...

- OpenCL 使用函数 clCreateProgramWithBinary 来创建程序

▶ 函数 clCreateProgramWithSource 接收 OpenCL 代码(设备无关)来创建程序,而函数 clCreateProgramWithBinary 接收已经经过函数 clBuil ...

- 记一次微信小程序开发

之前在网上看到博客园新闻服务开放接口,因为自己本身有看博客园IT新闻的习惯,为了能随时随地简洁方便的浏览新闻,于是萌生了一个利用开放API开发一个微信小程序的想法. 1. mpvue初探 平时技术栈有 ...

- sdm 使用阿里云域名申请 Let’s Encrypt 通配符 域名证书

安装acme 进入 套件中心 点击安装 Git Server 之后进入SSh会使用git命令 方法1--------------------------------------- 获取代码 git c ...

- orchard cms 项目迁移

删除Orchard.Web 下的 App_Data 目录,重新安装项目

- 在Centos7下安装Python+Selenium+Firefox学习环境

Selenium 一自动化测试工具.它支持 Chrome,Safari,Firefox 等主流界面式浏览器,如果你在这些浏览器里面安装一个 Selenium 的插件,那么便可以方便地实现Web界面的测 ...

- 11-SSH综合案例:前台用户模块:激活邮件的发送

刚才已经把服务器的环境和客户端的软件已经搭建好了,现在就要发送邮件了.现在发送邮件的代码你不用重点去掌握啊,了解一下就行了. javax.activation javax.mail是Java EE 5 ...

- Python_07-常用函数

1 python常用常用函数 1.1 常用内置函数 1.2 类型转换函数 1.3 和操作系统相关的调用 1.3.1 操作举例 1.4 用os ...

- Cocoa Touch(二):数据存储CoreData, NSKeyArchiver, NSOutputStream, NSUserDefaults

应用程序离不开数据的永久存储,有两种方式实现存储:数据库和文本文件. 作为存储管理器,最基本的功能就是增删改查了. CoreData 1.插入 AppDelegate *app = [[UIAppli ...

- python selenium 测试环境的搭建及python mysql的连接

又来一篇傻瓜教程啦,防止在学习的小伙伴们走弯路. 1.python 环境搭建 python官网:https://www.python.org/downloads/ 选择最新版本python下载(如果 ...