第6章 通过CrawlSpider对招聘网站进行整站爬取

通过前几章的2个项目的学习,其实本章的拉钩网项目还是挺容易理解的。

本章主要的还是对CrawlSpider源码的解析,其实我对源码还不是很懂,只是会基本的一些功能而已。

不分小节记录了,直接上知识点,可能比较乱。

1.建立数据表sql语句参考

CREATE TABLE `lagou_job` (

`job_id` int(11) NOT NULL DEFAULT '' COMMENT '职位页面的id',

`title` varchar(255) NOT NULL COMMENT '职位名称',

`url` varchar(255) NOT NULL COMMENT '职位链接',

`salary` varchar(255) DEFAULT NULL COMMENT '工资',

`job_city` varchar(255) DEFAULT NULL COMMENT '城市',

`work_years` varchar(255) DEFAULT NULL COMMENT '工作经验',

`degree_need` varchar(255) DEFAULT NULL COMMENT '学历',

`job_type` varchar(255) DEFAULT NULL COMMENT '工作性质',

`publish_time` varchar(255) DEFAULT NULL COMMENT '发布时间',

`job_advantage` varchar(255) DEFAULT '' COMMENT '职位诱惑',

`job_desc` longtext COMMENT '职位描述',

`job_addr` varchar(255) DEFAULT NULL COMMENT '工作详细地点',

`company_url` varchar(255) DEFAULT NULL COMMENT '公司链接',

`company_name` varchar(255) DEFAULT NULL COMMENT '公司名称',

PRIMARY KEY (`job_id`)

) ENGINE=MyISAM DEFAULT CHARSET=utf8;

2.继承CrawlSpider

scrapy genspider -t crawl lagou www.lagou.com

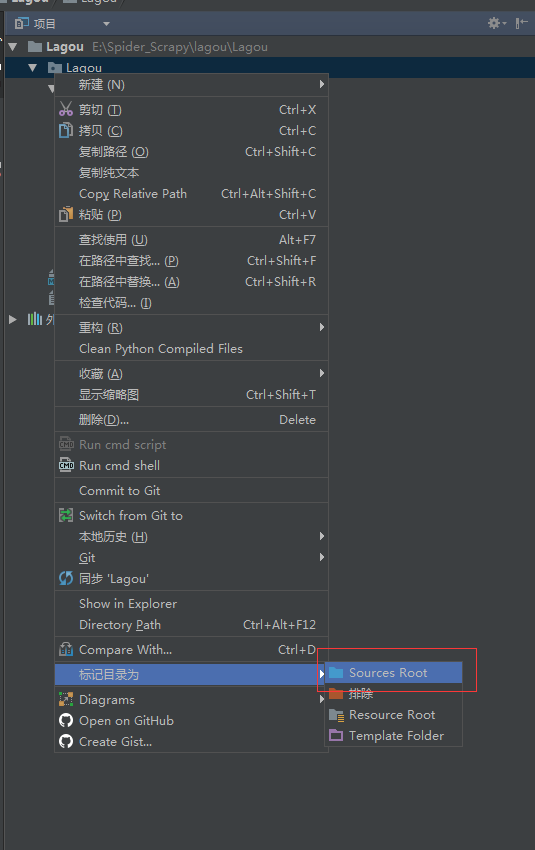

3.根目录问题

有时候from ... import ...出错的时候,可以看看根目录是不是对的

4.CrawlSpider使用说明

参考scrapy文档: http://scrapy-chs.readthedocs.io/zh_CN/latest/topics/spiders.html#crawlspider

作者:今孝

出处:http://www.cnblogs.com/jinxiao-pu/p/6757603.html

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接。

第6章 通过CrawlSpider对招聘网站进行整站爬取的更多相关文章

- 通过CrawlSpider对招聘网站进行整站爬取(拉勾网实战)

爬虫首先要明确自己要爬取的网站以及内容 进入拉勾网的网站然后看看想要爬取什么内容职位,薪资,城市,经验要求学历要求,全职或者兼职职位诱惑,职位描述提取公司的名称 以及 在拉勾网的url等等 然后在na ...

- Scrapy 使用CrawlSpider整站抓取文章内容实现

刚接触Scrapy框架,不是很熟悉,之前用webdriver+selenium实现过头条的抓取,但是感觉对于整站抓取,之前的这种用无GUI的浏览器方式,效率不够高,所以尝试用CrawlSpider来实 ...

- 写了一个Windows服务,通过C#模拟网站用户登录并爬取BUG列表查询有没有新的BUG,并提醒我

写了一个Windows服务,通过C#模拟网站用户登录并爬取BUG列表查询有没有新的BUG,并提醒我 1.HttpUtil工具类,用于模拟用户登录以及爬取网页: using System; using ...

- 网站seo整站优化有什么优势

http://www.wocaoseo.com/thread-314-1-1.html 现在很多企业找网络公司做网站优化,已经不再像以前那样做目标关键词,而是通过整站优化来达到企业营销目的 ...

- 8月份Python招聘情况怎么样?Python爬取招聘数据,并进行分析

前言 拉勾招聘是专业的互联网求职招聘平台.致力于提供真实可靠的互联网招聘求职找工作信息.今天我们一起使用 python 采集拉钩的 python 招聘信息,分析一下找到高薪工作需要掌握哪些技术 开发环 ...

- 歌曲网站,教你爬取 mp3 和 lyric

从歌曲网站,获取音频和歌词的流程: 1, 输入歌曲名,查找网站中存在的歌曲 id 2, 拿歌曲 id 下载歌词 lyric 简单的 url 拼接 3, 拿歌曲 id 下载音频 mp3 先用一个 POS ...

- wget整站抓取、网站抓取功能;下载整个网站;下载网站到本地

wget -r -p -np -k -E http://www.xxx.com 抓取整站 wget -l 1 -p -np -k http://www.xxx.com 抓取第一级 - ...

- python爬虫---CrawlSpider实现的全站数据的爬取,分布式,增量式,所有的反爬机制

CrawlSpider实现的全站数据的爬取 新建一个工程 cd 工程 创建爬虫文件:scrapy genspider -t crawl spiderName www.xxx.com 连接提取器Link ...

- scrapy框架之CrawlSpider全站自动爬取

全站数据爬取的方式 1.通过递归的方式进行深度和广度爬取全站数据,可参考相关博文(全站图片爬取),手动借助scrapy.Request模块发起请求. 2.对于一定规则网站的全站数据爬取,可以使用Cra ...

随机推荐

- [Cocos2d-x for WP8学习笔记] 获取系统字体

在Cocos2d-x for WP8较新的版本中,获取字体这一块,在wp8下默认返回了null,只能内嵌字体文件解决. 其实可以通过下面的方法获取系统的字体文件 CCFreeTypeFont::loa ...

- 【转】如何成为一名优秀的web前端工程师(前端攻城师)?

[转自]http://julying.com/blog/how-to-become-a-good-web-front-end-engineer/ 程序设计之道无远弗届,御晨风而返.———— 杰佛瑞 · ...

- 【OCP-12c】2019年CUUG OCP 071考试题库(79题)

79.Which statement is true about transactions? A. A set of Data Manipulation Language (DML) statemen ...

- 如何学习sql语言?

如何学习 SQL 语言? https://www.zhihu.com/question/19552975 没有任何基础的人怎么学SQL? https://www.zhihu.com/question/ ...

- [转] 测试环境下将centos6.8升级到centos7的操作记录

1)查看升级前的版本信息 lsb_release -a LSB Version: :base-4.0-amd64:base-4.0-noarch:core-4.0-amd64:core-4.0-noa ...

- Unity 下集成第三方原生 SDK,以极光厂商通道为例

Unity中集成三方SDK有两种方式: Unity 项目开发中时常有集成 Android 第三方 SDK 的需求,比如接入第三方推送,分享等功能.而第三方 SDK 的集成文档提到的往往是基于原生 An ...

- AI 的下一个重大挑战:理解语言的细微差别

简评:人类语言非常博大精妙,同一句话在不同的语境下,就有不同的含义.连人类有时候都不能辨别其中细微的差别,机器能吗?这就是人工智能的下一个巨大挑战:理解语言的细微差别.本文原作者是 Salesforc ...

- Eclipse中创建SpringBoot项目流程,及报错解决方案

1.下载最新的Eclipse(老版本的有可能不包含springBoot插件),然后在help中打开Eclipse MarketPlace,在Spring Marketplace 中搜索SpringBo ...

- 【Qt开发】实现系统托盘,托盘菜单,托盘消息

概述 系统托盘就是在系统桌面底部特定的区域显示运行的程序.windows在任务栏状态区域,linux在布告栏区域.应用程序系统托盘功能,是比较普遍的功能,本篇将详细的介绍如何实现该功能. 演示Demo ...

- 图的最小生成树的理解和实现:Prim和Kruskal算法

最小生成树 一个连通图的生成树是一个极小的连通子图,它含有图中所有的顶点,但只有足以构成一棵树的n-1条边.我们将构造连通网的最小代价生成树称为最小生成树(Minimum Cost Spanning ...