softmax、cross entropy和softmax loss学习笔记

之前做手写数字识别时,接触到softmax网络,知道其是全连接层,但没有搞清楚它的实现方式,今天学习Alexnet网络,又接触到了softmax,果断仔细研究研究,有了softmax,损失函数自然不可少。一起学习记录一下。

主要参考的博文:http://blog.csdn.net/u014380165/article/details/77284921

侵删!

先讲softmax。

softmax是一个全连接层,功能是将卷积神经网络计算后的多个神经元输出,映射到(0,1)区间,给出每种分类的概率情况。下面主要记录全连接层到损失层是如何计算的。

图的等号左边为全连接,w为权值,x是全连接层的输入(卷积运算激活池化后的特征向量,不一定为N*1,可以为S*P,这里只不过为了便于理解计算,把向量拉直为SP*1,即N*1,N=SP)假设全连接层前面连接的是一个卷积层,这个卷积层的输出是100个特征(也就是我们常说的feature map的channel为100),每个特征的大小是4*4,那么在将这些特征输入给全连接层之前会将这些特征flat成N*1的向量(这个时候N就是100*4*4=1600)。再看W,W是T*N的矩阵,其中N是由输入决定的,T是有网络输出的类别决定的,比如输出为10个类,则T=10.W和x运算后得到一个T*1的向量,向量大小没有限制。下一步就是softmax,softmax作用是将T个输入映射为概率,刚才打比方说有10个类别,则每个输出值就是每种类别的概率,显然概率之和为。分母为所有情况之和,分子为各种单一情况运算。

终于转化为概率了,那接下来为了衡量好坏,当然是选择误差函数了,因为是概率输入,当然理所当然使用交叉熵了,

Cross entropy

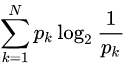

首先理一下熵的概念,现有关于样本集的2个概率分布p和q,其中p为真实分布,q非真实分布。按照真实分布p来衡量识别一个样本的所需要的编码长度的期望(即平均编码长度)为:

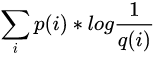

如果使用错误分布q来表示来自真实分布p的平均编码长度,则应该是:

其中第一个期望为信息熵,反应的是香农信息量的期望,第二个为交叉熵。信息熵代表的是随机变量或整个系统的不确定性,熵越大,随机变量或系统的不确定性就越大

链接:https://www.zhihu.com/question/41252833/answer/195901726

链接:https://www.zhihu.com/question/41252833/answer/108777563

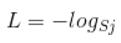

softmax的损失函数叫做softmax loss,其定义为:

首先L是损失。Sj是softmax的输出向量S的第j个值,前面已经介绍过了,表示的是这个样本属于第j个类别的概率。yj前面有个求和符号,j的范围也是1到类别数T,因此y是一个1*T的向量,里面的T个值,而且只有1个值是1,其他T-1个值都是0。那么哪个位置的值是1呢?答案是真实标签对应的位置的那个值是1,其他都是0。所以结果为:

j指向当前样本的真是标签。假设一个5分类问题,然后一个样本I的标签y=[0,0,0,1,0],也就是说样本I的真实标签是4,假设模型预测的结果概率(softmax的输出)p=[0.2,0.3,0.4,0.6,0.5],可以看出这个预测是对的,那么对应的损失L=-log(0.6),也就是当这个样本经过这样的网络参数产生这样的预测p时,它的损失是-log(0.6)。那么假设p=[0.2,0.3,0.4,0.1,0.5],这个预测结果就很离谱了,因为真实标签是4,而你觉得这个样本是4的概率只有0.1(远不如其他概率高,如果是在测试阶段,那么模型就会预测该样本属于类别5),对应损失L=-log(0.1)。那么假设p=[0.2,0.3,0.4,0.3,0.5],这个预测结果虽然也错了,但是没有前面那个那么离谱,对应的损失L=-log(0.3)。我们知道log函数在输入小于1的时候是个负数,而且log函数是递增函数,所以-log(0.6) < -log(0.3) < -log(0.1)。简单讲就是你预测错比预测对的损失要大,预测错得离谱比预测错得轻微的损失要大。

这个过程也说明了softmax和max的区别。如我有两个数a和b,max选取ab中概率最大的那个数,没有第二种可能,但是对于b不公平啊,a的可能性比b大,但是不代表b不可能取不到,所以我想根据概率选取,概率大的多去,概率小的少取,这就是softmax。

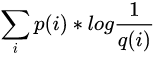

与

与

可见其实是一样的。感谢以上博主和知乎作者分享,理清了我的思路,谢谢。纪录下,由新发现再补充,有错请指教,谢谢

softmax、cross entropy和softmax loss学习笔记的更多相关文章

- softmax,softmax loss和cross entropy的区别

版权声明:本文为博主原创文章,未经博主允许不得转载. https://blog.csdn.net/u014380165/article/details/77284921 我们知道卷积神经网络(CNN ...

- softmax,softmax loss和cross entropy的讲解

1 softmax 我们知道卷积神经网络(CNN)在图像领域的应用已经非常广泛了,一般一个CNN网络主要包含卷积层,池化层(pooling),全连接层,损失层等.这一篇主要介绍全连接层和损失层的内容, ...

- keras 学习笔记:从头开始构建网络处理 mnist

全文参考 < 基于 python 的深度学习实战> import numpy as np from keras.datasets import mnist from keras.model ...

- Stanford CS20学习笔记

Lecture Note 2 Tensorboard P3 Data Structures P4 Math Operations P6 Data Types P7 tf native &&am ...

- 【转】TensorFlow四种Cross Entropy算法实现和应用

http://www.jianshu.com/p/75f7e60dae95 作者:陈迪豪 来源:CSDNhttp://dataunion.org/26447.html 交叉熵介绍 交叉熵(Cross ...

- 卷积神经网络系列之softmax,softmax loss和cross entropy的讲解

我们知道卷积神经网络(CNN)在图像领域的应用已经非常广泛了,一般一个CNN网络主要包含卷积层,池化层(pooling),全连接层,损失层等.虽然现在已经开源了很多深度学习框架(比如MxNet,Caf ...

- Softmax学习笔记

softmax用于多分类过程中,它将多个神经元的输出,映射到(0,1)区间内,可以看成概率来理解,从而来进行多分类! 他把一些输入映射为0-1之间的实数,并且归一化保证和为1,因此多分类的概率之和也刚 ...

- ufldl学习笔记和编程作业:Softmax Regression(softmax回报)

ufldl学习笔记与编程作业:Softmax Regression(softmax回归) ufldl出了新教程.感觉比之前的好,从基础讲起.系统清晰,又有编程实践. 在deep learning高质量 ...

- ufldl学习笔记与编程作业:Softmax Regression(vectorization加速)

ufldl学习笔记与编程作业:Softmax Regression(vectorization加速) ufldl出了新教程,感觉比之前的好.从基础讲起.系统清晰,又有编程实践. 在deep learn ...

随机推荐

- 如何打包发布加密的 Python 源代码

这里介绍一种使用 PyInstaller 和 PyArmor 来发布加密 Python 源代码的方式,能够达到以下目的 把所有 Python 源代码打包成为可执行文件,客户不需要 Python 就可以 ...

- Pycharm下安装模块

方法一:使用Pycharm的终端安装 一.网络爬虫 1.安装requests包 作用:简洁且简单的处理HTTP请求的第三方库 网址:https://pypi.org/project/requests/ ...

- Spring Data 教程 - Redis

1. Redis简介 Redis(Remote Dictionary Server ),即远程字典服务,是一个开源的使用ANSI C语言编写.支持网络.可基于内存亦可持久化的日志型.Key-Value ...

- EM(最大期望)算法推导、GMM的应用与代码实现

EM算法是一种迭代算法,用于含有隐变量的概率模型参数的极大似然估计. 使用EM算法的原因 首先举李航老师<统计学习方法>中的例子来说明为什么要用EM算法估计含有隐变量的概率模型参数. 假设 ...

- 经典卷积神经网络算法(5):ResNet

.caret, .dropup > .btn > .caret { border-top-color: #000 !important; } .label { border: 1px so ...

- SpringCloud Alibaba (三):Sentinel 流量控制组件

SpringCloud Alibaba (三):Sentinel 流量控制组件 Sentinel 是什么 随着微服务的流行,服务和服务之间的稳定性变得越来越重要.Sentinel 是面向分布式服务架构 ...

- Linux远程连接mongodb

当没有客户端工具,eg:robo3T时,如何修改mongodb里的数据呢? 1.连接mongodb服务器mongo 1.1.1.1:1688 2.查看数据库列表show dbs 3.选择使用log库u ...

- elk2

如果使用codec->json进行解码,表示输入到logstast中的input数据必须是json的格式,否则会解码失败 java中一句代码异常会抛出多条的堆栈日志,我们可以使用上面的mutil ...

- typeof、instanceof与constructor

typeof返回一个表达式的数据类型的字符串,返回结果为js基本的数据类型,包括number,boolean,string,object,undefined,function. 语法: typeof( ...

- springboot + rabbitmq 用了消息确认机制,感觉掉坑里了

本文收录在个人博客:www.chengxy-nds.top,技术资源共享,一起进步 最近部门号召大伙多组织一些技术分享会,说是要活跃公司的技术氛围,但早就看穿一切的我知道,这 T M 就是为了刷KPI ...