大数据hadoop安装

hadoop集群搭建--CentOS部署Hadoop服务

在了解了Hadoop的相关知识后,接下来就是Hadoop环境的搭建,搭建Hadoop环境是正式学习大数据的开始,接下来就开始搭建环境!我们用到环境为:VMware 12+CentOS6.4

hadoop安装步骤大纲:

1、准备硬件(一台虚拟主机)

2、虚拟机装linux系统(这里我们装的是CentOS)

3、准备网络连接

4、配置linux系统

5、安装jdk和hadoop

下面详细介绍环境的搭建:

1)准备linux环境

运行 Vm ware安装目录的 vmnetcfg.exe 程序 , 打开虚拟网络编辑器,

选择 VMnet1 仅主机模式,子网 IP 设为 192.168.1.0 ,子网掩码设为 255.255.255.0

说明: VMnet0 桥接模式, VMnet1 仅主机模式, VMnet8 NAT 模式。

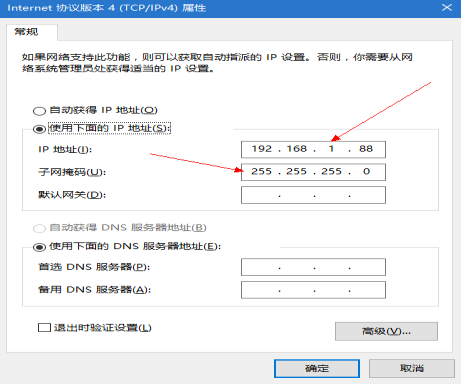

回到windows --> 打开网络和共享中心 -> 更改适配器设置 -> 右键VMnet1 -> 属性 -> 双击IPv4 -> 设置windows的IP:192.168.1.88 子网掩码:255.255.255.0 -> 点击确定

在虚拟软件上 --My Computer -> 选中虚拟机 -> 右键 -> settings -> network adapter -> host only -> ok

即:在 VMware 中,设置具体 Linux 实例的网络适配器为仅主机模式

2)修改linux相关配置

2.1修改linux的IP地址

点击右上角网络连接小电脑图标,选择 vpn 连接 — > 配置 vpn — > 有线 — >Auto eth1 — >编辑

— > I p v4设置 — >手动 — > 192.168.1.101 ,255.255.255.0,192.168.1.1 — >应用

使用shell指令: service network restart重启网络使之生效

2.2修改主机名

使用su root 切换到root用户,使用shell指令:vi /etc/shsconfig/network打开文件把主机名修改为一下的形式:

NETWORKING=yes

HOSTNAME= BigData

这里补充一下:对linux不太熟悉的,打开文件后不知道怎么去修改,修改完,怎么去保存,具体方法是:打开文件后按i进行插入操作,完毕后按ESC退出插入操作然后使用:":wq!"进行保存退出(注意指令时没有双引号的),加“!”的作用的强制保存退出。

注意:主机名中不能含有下划线,主机名生效需要重启系统,查了一些资料目前好像没有别的方法,是用reboot重启系统

2.3 配置主机名与本地映射关系

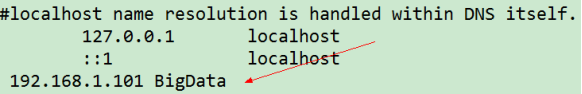

使用:vi /etc/hosts打开本地文件,配置成以下形式

2.4 关闭防火墙

linux系统由于防火墙的存在,不便于进行远程访问,为了方便其他计算机对linux进行远程访问,所以要将防火墙关闭。

使用指令:service iptables stop把防火墙关闭,另外补充以下指令:

#查看防火墙状态

service iptables status

#关闭防火墙

service iptables stop

#查看防火墙开机启动状态

chkconfig iptables --list

#关闭防火墙开机启动

chkconfig iptables off

注意: 关闭防火墙后,重启linux系统才能生效。

2.5 在 windows 配置主机名和本地映射关系

找到hosts 所在文件路径:C:\Windows\System32\drivers\etc \hosts用EditPlus或者其他工具打开,添加如下形式:

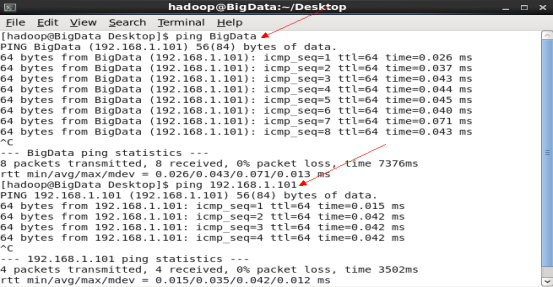

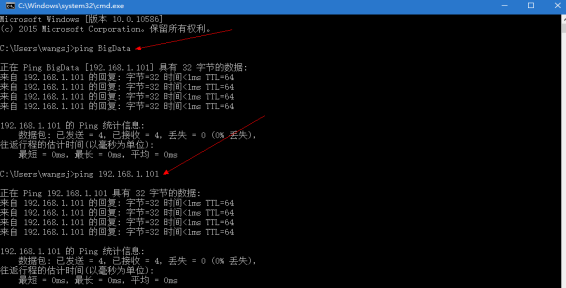

保存并退出,接下来再linux和window环境下测试是否正确。下面是测试指令:

ping BigData

ping 192.168.1.101

linux测试结果如下:

按ctrl+c停止传输

window环境下测试结果:

能够相互ping的通,证明网络连接正确。

2.6 生成并配置生成ssh免登陆密钥

由于hadoop在集群中的时候需要多个机器进行访问操作,一个集群存在成千上万的个节点,如果每次启动节点都需要输入密码,势必会很麻烦。linux机器之间使用ssh不需要用户名和密码。采用了数字签名RSA或者DSA来完成这个操作

#进入到我的home目录

cd ~/.ssh

ssh-keygen -t rsa (四个回车)

执行完这个命令后,会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

将公钥拷贝到要免登陆的机器上

ssh-copy-id BigData

3)安装jdk和 hadoop-2.4.1.tar.gz

3.1安装jdk

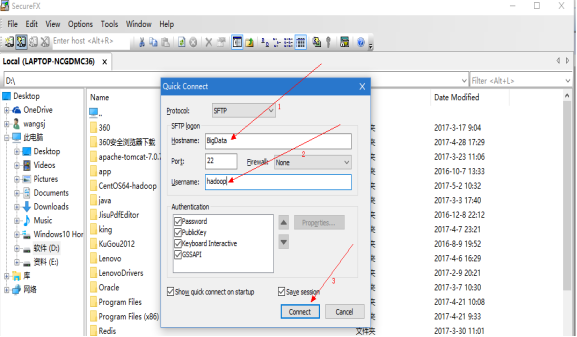

这里介绍常用的两个工具:SecureFXPortable和SecureCRTPortable,第一个用来将window下的相关文件上传到linux环境中,第二个用用来对linux进行操作,有了它就可以把linux虚拟机的桌面关闭了,这样可以节省资源。这两个工具通过域名和linux建立连接,从而达到远程操作linux的目的。

点击左上角第二个按钮,出现如图所示的窗口,输入主机名,用户名进行连接

然后将安装包拖到linux系统,下面一栏有进度显示,这样就把安装包传到了linux系统上。

最后使用:mkdir /software创建文件夹software,将jdk解压至software文件夹

解压指令:tar -xzvf / software /jdk-7u55-linux-i586.tar.gz -C / software

3.2 将java添加至环境变量

在root用户下,使用指令:vi /etc/profile 在文件结尾添加:

export JAVA_HOME=/ software /jdk1.7.0_55

export PATH=$PATH:$JAVA_HOME/bin

然后使用:使用 source /etc/profile 命令 , 使环境变量生效

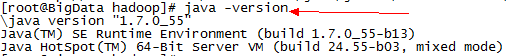

测试java环境:java 和java -version 出现以下信息说明安装成功。

3.3安装hadoop

这里选用的是比较稳定的2.4.1版本,其他版本只能装大同小异,hadoop的安装和jdk的安装步骤几乎一样,先上传压缩包,然后进行解压,同理安装在software目录下。

指令:tar -xzvf / software /hadoop-2.4.1.tar.gz -C / software

3.4 hadoop伪分布式环境配置

hadoop2.x的配置文件$HADOOP_HOME/etc/hadoop

伪分布式需要修改5个配置文件

1、配置hadoop环境变量

使用指令:vi / software/hadoop-2.4.1/etc/hadoop/hadoop-env.sh打开文件添加:

export JAVA_HOME= / software /jdk1.7.0_55

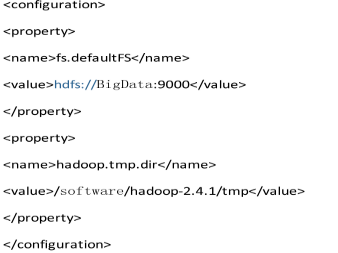

2、 修改 core-site.xml文件

指令:vi / software/hadoop-2.4.1/etc/hadoop/core-site.xml,打开后输入以下信息:

解释如下:

<!-- 指定HADOOP所使用的文件系统schema(URI),HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://BigData:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/software/hadoop-2.4.1/tmp</value>

</property>

3、修改 hdfs-site.xml文件

指令:vi / software/hadoop-2.4.1/etc/hadoop/hdfs-site.xml打开文件,添加以下信息:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

这个文件的目的是指定文件副本的数量,由于现在只有一台机器,所以value值为1,将来如果有多台机器,那么value的值就不是1了。

4、修改 mapred-site.xml文件 ,

首先需要去掉 .template 后缀,指令:mv mapred-site.xml.template mapred-site.xml,然后使用指令:

vi / software/hadoop-2.4.1/etc/hadoop/mapred-site.xml打开文件添加以下信息:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

目的是指定mr运行在yarn上

5、修改yarn-site.xml文件

指令:vi / software/hadoop-2.4.1/etc/hadoop/yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value> BigData </value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

解释

第一个property的作用是:指定YARN的老大(ResourceManager)的地址,第二个property的作用是:reducer获取数据的方式。

6、将hadoop添加至环境变量

使用指令:vi /etc/profile打开文件,添加以下信息:

export JAVA_HOME=/ software /jdk1.6.0_24

export HADOOP_HOME=/ software /hadoop-2.4.1

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

使用 source /etc/profile 命令 , 使环境变量生效

7、格式化 HDFS 文件系统

指令:hdfs namenode -format,目的是对namenode进行初始化

3.5 环境测试

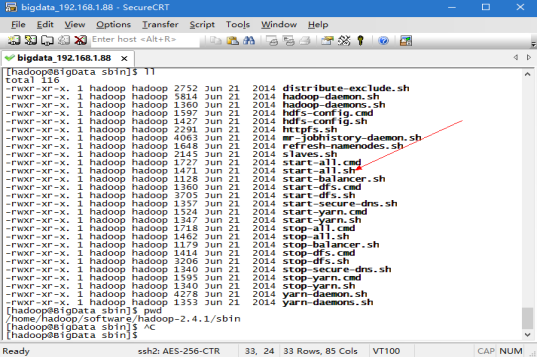

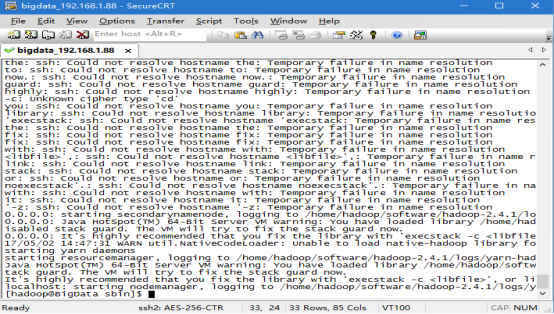

找到start-all.sh,具体在/home/hadoop/software/hadoop-2.4.1/sbin这个目录下,进去里面有很多指令,如图所示:

执行指令:sh start-all.sh,出现以下信息

启动的过程中,没有让输入密码,说明我们的ssh免密钥登陆也是正确的。

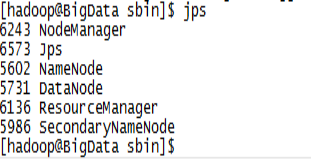

验证是否启动成功,执行指令jps,出现以下信息:

可以看到启动成功。

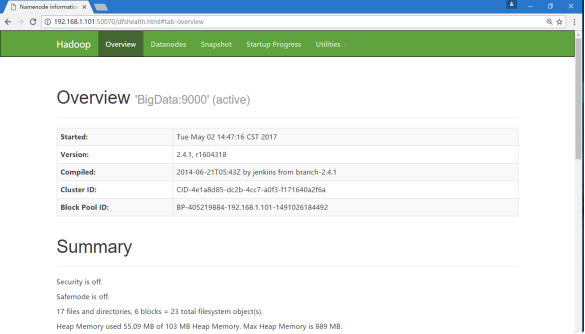

最后用网址进行验证:分别输入

http://192.168.1.101:50070 (HDFS管理界面)

http://192.168.1.101:8088 (MR管理界面)

至此,CentOS下搭建Hadoop服务已经完成,系统部署的过程中,与顺序无关,先那一步都可以,在搭建环境之前,需要学会在虚拟机上安装CentOS,这是前提工作,第一步完成后,再来搭建本文的环境就变得容易了。

大数据hadoop安装的更多相关文章

- 大数据-Hadoop安装

进入到Hadoop安装包路径下 [atguigu@hadoop101 ~]$ cd /opt/software/ 解压安装文件到/opt/module下面 [atguigu@hadoop101 sof ...

- 大数据软件安装之Hadoop(Apache)(数据存储及计算)

大数据软件安装之Hadoop(Apache)(数据存储及计算) 一.生产环境准备 1.修改主机名 vim /etc/sysconfig/network 2.修改静态ip vim /etc/udev/r ...

- 14周事情总结-机器人-大数据hadoop

14周随着考试的进行,其他该准备的事情也在并行的处理着,考试内容这里不赘述了 首先说下,关于机器人大赛的事情,受益颇多,机器人的制作需要机械和电控两方面 昨天参与舵机的测试,遇到的问题:舵机不动 排查 ...

- 成都大数据Hadoop与Spark技术培训班

成都大数据Hadoop与Spark技术培训班 中国信息化培训中心特推出了大数据技术架构及应用实战课程培训班,通过专业的大数据Hadoop与Spark技术架构体系与业界真实案例来全面提升大数据工程师 ...

- 大数据Hadoop学习之搭建hadoop平台(2.2)

关于大数据,一看就懂,一懂就懵. 一.概述 本文介绍如何搭建hadoop分布式集群环境,前面文章已经介绍了如何搭建hadoop单机环境和伪分布式环境,如需要,请参看:大数据Hadoop学习之搭建had ...

- 搭建大数据hadoop完全分布式环境遇到的坑

搭建大数据hadoop完全分布式环境,遇到很多问题,这里记录一部分,以备以后查看. 1.在安装配置完hadoop以后,需要格式化namenode,输入指令:hadoop namenode -forma ...

- 我搭建大数据Hadoop完全分布式环境遇到的坑---hadoop: command not found

搭建大数据hadoop环境,遇到很多问题,这里记录一部分,以备以后查看. [遇到问题].在安装配置完hadoop以后,需要格式化namenode,输入指令:hadoop namenode -forma ...

- 大数据软件安装之HBase(NoSQL数据库)

一.安装部署 1.Zookeeper正常部署 (见前篇博文大数据软件安装之ZooKeeper监控 ) [test@hadoop102 zookeeper-3.4.10]$ bin/zkServer.s ...

- 王家林的“云计算分布式大数据Hadoop实战高手之路---从零开始”的第十一讲Hadoop图文训练课程:MapReduce的原理机制和流程图剖析

这一讲我们主要剖析MapReduce的原理机制和流程. “云计算分布式大数据Hadoop实战高手之路”之完整发布目录 云计算分布式大数据实战技术Hadoop交流群:312494188,每天都会在群中发 ...

随机推荐

- Logback,SLF4J,Log4J2。了解它们并学习如何使用。(翻译)

背景 如果您正在或在任何Java项目上工作,则可能已记录了一些debug,error或info语句以进行调试或跟踪.通过将库记录到磁盘或其他某种介质上的文件中来写这些语句. 日志记录是任何项目的关键方 ...

- vue-router需要注意的点

1.在编程式导航中,如果提供了path,params会被忽略:需要提供name,或手写完整的带有参数的path;以下写法可取: const userId = '123'; 1.this.$route ...

- scrapydweb的初步使用(管理分布式爬虫)

https://github.com/my8100/files/blob/master/scrapydweb/README_CN.md 一.安装配置 1.请先确保所有主机都已经安装和启动 Scrapy ...

- celery订单定时回滚

目录 订单回滚 控制执行(多少时间后执行) celery异步定时任务 订单回滚 用celery异步,定时任务.可以设置:如果下单15分钟后没有支付,则取消订单.做反向操作 控制执行(多少时间后执行) ...

- mysql的那些事之架构

MySQL架构的那些事 此篇博客为原创,欢迎转载,转载时请注明出处,谢谢 最近深入学习了一下mysql的内容,想把自己的理解分享出来. mysql架构 逻辑架构 Connectors:连接器 Mana ...

- 使用docker构建hadoop集群

docker的使用越来越普遍了,大家不知道docker的还需要进一步学习一下.这次咱们使用docker去进行hadoop集群的构建. 使用docker构建的好处真的很多,一台电脑上可以学习安装很多想做 ...

- 阿里云加Picgo或MPic搭建最豪横的图床

阿里云加Picgo或MPic搭建最豪横的图床 首先解释一下什么是图床,图床其实就是提供图片存储的服务器. 对于自建博客来说,由于各种原因的限制(比如穷...)可能无法购买存储空间比较大的VPS. 而对 ...

- 雅奇880、990、小土豆调用EPX Studio 编译的DLL的编程方法~

在雅奇990中,使用“外部文件-调用链接库文件”命令实现与EP的通信,例如: 1.调用链接库文件(取项目文件信息() + '资源文件\Project1.dll', 'Unit1.rpas:Result ...

- 第三届上海市大学生网络安全大赛 流量分析 WriteUp

题目链接: https://pan.baidu.com/s/1Utfq8W-NS4AfI0xG-HqSbA 提取码: 9wqs 解题思路: 打开流量包后,按照协议进行分类,发现了存在以下几种协议类型: ...

- Swift4.1 新特性compactMap函数

关于compactMap函数 苹果在Swift 4.1中新增compactMap函数,用来代替flatMap函数. 在Swift标准库中compactMap定义如下 public func compa ...