Python scrapy框架爬取瓜子二手车信息数据

项目实施依赖:

python,scrapy ,fiddler

scrapy安装依赖的包:

可以到https://www.lfd.uci.edu/~gohlke/pythonlibs/ 下载 pywin32,lxml,Twisted,scrapy然后pip安装

项目实施开始:

1、创建scrapy项目:cmd中cd到需创建的文件目录下

scrapy startproject guazi

2、创建爬虫:cd到创建好的项目下

scrapy genspider gz guazi.com

3、分析目标网址:

第一次我直接用的谷歌浏览器的抓包分析,取得UA和Cookies请求,返回的html数据完全缺失,分析可能是携带的Cookies

有问题,然后就用fiddler抓包才,得到Cookies与谷歌上得到Cookies多了UA,时间等参数,

4、将UA,Cookies添加到下载中间中去:

class Guzi1DownloaderMiddleware(object):

def process_request(self, request, spider):

# 需要对得到的cookies处理成字典类型

request.cookies={}

request.headers["User-Agent"]=""

5、在settings中将DOWNLOADER_MIDDLEWARES打开

6、在spiders目录下找到gz.py开始编写爬虫逻辑处理

import scrapy

import time class GzSpider(scrapy.Spider):

name = 'gz'

allowed_domains = ['guazi.com']

start_urls = ['https://www.guazi.com/cd/buy/0'] def parse(self, response):

# 得到页面上所有车辆的url

url_list = response.xpath('//ul[@class="carlist clearfix js-top"]//li/a/@href').extract()

url_list = [response.urljoin(url) for url in url_list]

url_list = [url.replace("cq", "cd") for url in url_list]

for url in url_list:

yield scrapy.Request(url=url, callback=self.parse1, dont_filter=True) # 获取下一页的url

next_url = response.urljoin(response.xpath('//span[text()="下一页"]/../@href').extract_first())

if next_url:

yield scrapy.Request(url=next_url, callback=self.parse, dont_filter=True)

time.sleep(2) def parse1(self, response):

# 判断是否有数据

if response.xpath('//h2/text()').extract_first():

print(response.xpath('//h2/text()').extract_first().strip())

item = {}

item["车型"] = response.xpath('//h2/text()').extract_first().strip()

item["选车类型"] = response.xpath('//h2/span/text()').extract_first()

item["价格/万"] = response.xpath('//div[@class="pricebox js-disprice"]/span[1]/text()').extract_first().strip()

item["新车价格"] = response.xpath('//div[@class="pricebox js-disprice"]/span[2]/text()').extract_first().strip()

item["上牌时间"] = response.xpath('//ul[@class="basic-eleven clearfix"]/li[1]/div/text()').extract_first().strip()

item["公里数"] = response.xpath('//ul[@class="basic-eleven clearfix"]/li[2]/div/text()').extract_first().strip()

item["排量"] = response.xpath('//ul[@class="basic-eleven clearfix"]/li[3]/div/text()').extract_first().strip()

item["变速箱"] = response.xpath('//ul[@class="basic-eleven clearfix"]/li[4]/div/text()').extract_first().strip()

item["配置信息"] = response.xpath('//span[@class="type-gray"]//text()').extract()

item["网址"] = response.url

yield item

7、启动爬虫并保存为csv文件

scrapy crawl gz -o guanzi.csv

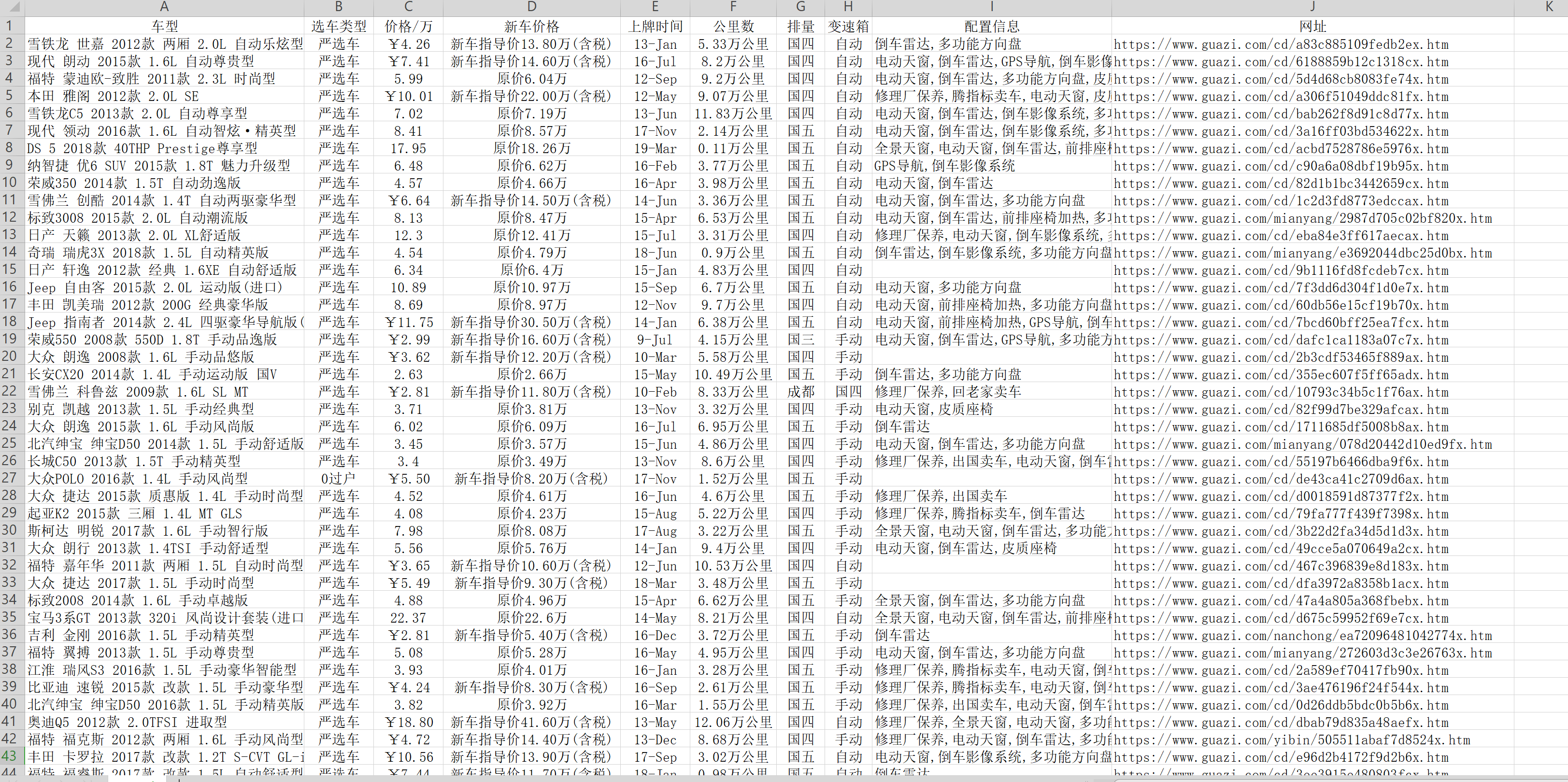

8、最后得到了想要的二手车信息,贴上部分截图

Python scrapy框架爬取瓜子二手车信息数据的更多相关文章

- 爬虫入门(四)——Scrapy框架入门:使用Scrapy框架爬取全书网小说数据

为了入门scrapy框架,昨天写了一个爬取静态小说网站的小程序 下面我们尝试爬取全书网中网游动漫类小说的书籍信息. 一.准备阶段 明确一下爬虫页面分析的思路: 对于书籍列表页:我们需要知道打开单本书籍 ...

- python scrapy框架爬取豆瓣

刚刚学了一下,还不是很明白.随手记录. 在piplines.py文件中 将爬到的数据 放到json中 class DoubanmoviePipelin2json(object):#打开文件 open_ ...

- Python——爬取瓜子二手车

# coding:utf8 # author:Jery # datetime:2019/5/1 5:16 # software:PyCharm # function:爬取瓜子二手车 import re ...

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- scrapy框架爬取小说信息

1.爬取目标网站:http://www.zhaoxiaoshuo.com/all.php?c=0&o=0&s=0&f=2&l=0&page=1 2.爬取目标网站 ...

- [Python学习] 简单爬取CSDN下载资源信息

这是一篇Python爬取CSDN下载资源信息的样例,主要是通过urllib2获取CSDN某个人全部资源的资源URL.资源名称.下载次数.分数等信息.写这篇文章的原因是我想获取自己的资源全部的评论信息. ...

- python之简单爬取一个网站信息

requests库是一个简介且简单的处理HTTP请求的第三方库 get()是获取网页最常用的方式,其基本使用方式如下 使用requests库获取HTML页面并将其转换成字符串后,需要进一步解析HTML ...

- scrapy框架爬取笔趣阁完整版

继续上一篇,这一次的爬取了小说内容 pipelines.py import csv class ScrapytestPipeline(object): # 爬虫文件中提取数据的方法每yield一次it ...

- scrapy框架爬取笔趣阁

笔趣阁是很好爬的网站了,这里简单爬取了全部小说链接和每本的全部章节链接,还想爬取章节内容在biquge.py里在加一个爬取循环,在pipelines.py添加保存函数即可 1 创建一个scrapy项目 ...

随机推荐

- 【LeetCode】Insertion Sort List

Sort a linked list using insertion sort. //用到O(N)的额外空间 public class Solution { public ListNode inser ...

- Double.valueOf()与Double.parseDouble()两者的区别

写代码用到这两个方法,不知道有什么区别,看一下源码: Double.parseDouble(String str) public static double parseDouble(String s) ...

- UVA1025 A Spy in the Metro —— DP

题目链接: https://vjudge.net/problem/UVA-1025 题解: 详情请看紫书P267. 与其说是DP题,我觉得更像是模拟题,特别是用记忆化搜索写. 递推: #include ...

- Objective-C学习之解析XML

通过soap请求webservice时,返回的数据是XML类型,有时候也需要解析本地的xml数据等,苹果自带类NSXMLParser解析xml还是很方便的,简单轻便 本文以解析本地XML为例,网络获取 ...

- html5--5-5 绘制填充矩形

html5--5-5 绘制填充矩形 学习要点 掌握绘制矩形的方法:strkeRect()/fillRect() 掌握绘制路径的 beginPath()和closePath() 矩形的绘制方法 rect ...

- 存储过程系列四: decode函数使用学习

Oracle 中 decode 函数用法 含义解释:decode(条件,值1,返回值1,值2,返回值2,...值n,返回值n,缺省值) 该函数的含义如下:IF 条件=值1 THEN RETURN(翻译 ...

- 【应用】图片翻转js

图片翻转:图片随着鼠标指针划过进行替换 <img src="example.gif" onmouseover="this.src='exampleTwo.gif'& ...

- 机器学习: 特征脸算法 EigenFaces

人脸识别是机器学习和机器视觉领域非常重要的一个研究方向,而特征脸算法是人脸识别里非常经典的一个算法,EigenFaces 是基于PCA (principal component analysis) 即 ...

- BZOJ_1044_[HAOI2008]木棍分割_二分答案+DP+单调队列

BZOJ_1044_[HAOI2008]木棍分割_二分答案+DP Description 有n根木棍, 第i根木棍的长度为Li,n根木棍依次连结了一起, 总共有n-1个连接处. 现在允许你最多砍断m个 ...

- ubuntu 16.04 apt-get 出现The package 'xxx' needs to be reinstalled, but I can't find an archive for it.

参考网址:http://www.ihaveapc.com/2011/10/fix-annoying-the-package-needs-to-be-reinstalled-but-i-cant-fin ...