spark使用jdbc批次提交方式写入phoniex的工具类

一、需求:spark写入phoniex

二、实现方式

1.官网方式

dataFrame.write

.format("org.apache.phoenix.spark")

.mode("overwrite")

.option("table", table)

.option("zkUrl", zkUrl)

.option("skipNormalizingIdentifier", true)

.save()

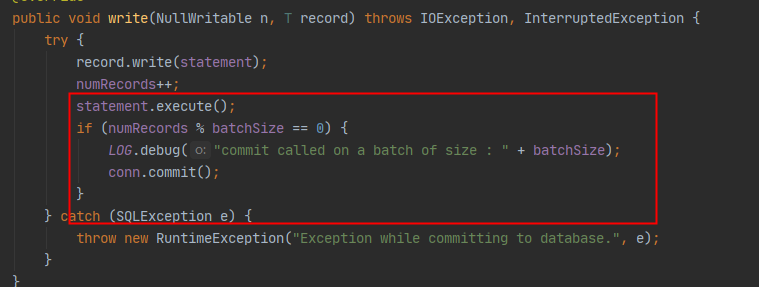

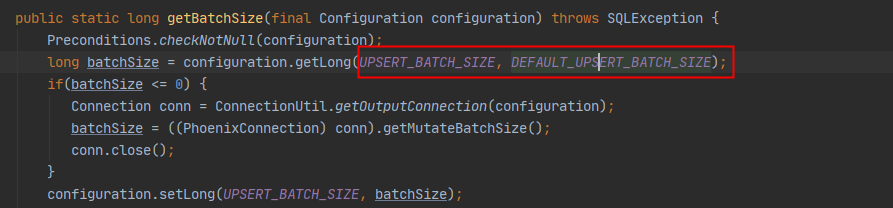

这个方式底层是使用MapReduce的RecordWriter实现类PhoenixRecordWriter通过jdbc方式写入

但是默认的batchsize是1000,所以插入速度极慢,但是官网没有说明写入的参数设置,需要去源码里面寻找一下

所以可以通过设置参数来提升速度

.option(PhoenixConfigurationUtil.UPSERT_BATCH_SIZE,batch)

二、自己实现jdbc的通用方式(任何jdbc方式都可以写入)

代码:

object JdbcUtils {

def jdbcBatchInsert(dataFrame: DataFrame, table: String, url: String, pro: Properties, batch: Int): Unit = {

val fields: Array[String] = dataFrame.schema.fieldNames

val schema: Array[StructField] = dataFrame.schema.toArray

val numFields = fields.length

val fieldsSql = fields.map(str => "\"".concat(str).concat("\"")).mkString("(", ",", ")")

val charSql = fields.map(str => "?").mkString(",")

val setters: Array[JDBCValueSetter] = schema.map(f => makeSetter(f.dataType))

val insertSql = s"upsert into $table $fieldsSql values ($charSql) "

System.err.println("插入sql:" + insertSql)

val start = System.currentTimeMillis()

dataFrame.rdd.foreachPartition(partition => {

val connection = DriverManager.getConnection(url, pro)

try {

connection.setAutoCommit(false)

val pstmt: PreparedStatement = connection.prepareStatement(insertSql)

var count = 0

var cnt = 0

partition.foreach(row => {

for (i <- 0 until numFields) {

if (row.isNullAt(i)) {

pstmt.setNull(i + 1, getJdbcType(schema(i).dataType))

} else {

setters(i).apply(pstmt, row, i)

}

}

pstmt.addBatch()

count += 1

if (count % batch == 0) {

pstmt.executeBatch()

connection.commit()

cnt += 1

println(s"${TaskContext.get.partitionId}分区,提交第${cnt}次,${count}tiao")

}

})

pstmt.executeBatch()

connection.commit()

println(s"第${TaskContext.get.partitionId}分区,共提交第${cnt},${count}条")

} finally {

connection.close()

}

})

val end = System.currentTimeMillis()

println(s"插入表$table,共花费时间${(end - start) / 1000}秒")

}

private type JDBCValueSetter = (PreparedStatement, Row, Int) => Unit

/**

* 类型匹配 如果有其他类型 自行添加

*

* @param dataType

* @return

*/

def makeSetter(dataType: DataType): JDBCValueSetter = dataType match {

case IntegerType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

if (row.isNullAt(pos)) {

stmt.setNull(pos + 1, java.sql.Types.INTEGER)

} else {

stmt.setInt(pos + 1, row.getInt(pos))

}

case LongType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setLong(pos + 1, row.getLong(pos))

case DoubleType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setDouble(pos + 1, row.getDouble(pos))

case FloatType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setFloat(pos + 1, row.getFloat(pos))

case ShortType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setInt(pos + 1, row.getShort(pos))

case ByteType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setInt(pos + 1, row.getByte(pos))

case BooleanType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setBoolean(pos + 1, row.getBoolean(pos))

case StringType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setString(pos + 1, row.getString(pos))

case BinaryType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setBytes(pos + 1, row.getAs[Array[Byte]](pos))

case TimestampType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setTimestamp(pos + 1, row.getAs[java.sql.Timestamp](pos))

case DateType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setDate(pos + 1, row.getAs[java.sql.Date](pos))

case t: DecimalType =>

(stmt: PreparedStatement, row: Row, pos: Int) =>

stmt.setBigDecimal(pos + 1, row.getDecimal(pos))

/* case ArrayType(et, _) =>

// remove type length parameters from end of type name

val typeName = getJdbcType(et, dialect).databaseTypeDefinition

.toLowerCase(Locale.ROOT).split("\\(")(0)

(stmt: PreparedStatement, row: Row, pos: Int) =>

val array = conn.createArrayOf(

typeName,

row.getSeq[AnyRef](pos).toArray)

stmt.setArray(pos + 1, array)*/

case _ =>

(_: PreparedStatement, _: Row, pos: Int) =>

throw new IllegalArgumentException(

s"Can't translate non-null value for field $pos")

}

/**

* sql类型匹配 如果有其他类型 自行添加

*

* @param dt

* @return

*/

private def getJdbcType(dt: DataType): Int = {

dt match {

case IntegerType => java.sql.Types.INTEGER

case LongType => java.sql.Types.BIGINT

case DoubleType => java.sql.Types.DOUBLE

case StringType => java.sql.Types.VARCHAR

case _ => java.sql.Types.VARCHAR

}

}

}

测试:

#config是个map集合要不要都可以

val connectionProperties = new Properties();

connectionProperties.setProperty(QueryServices.MAX_MUTATION_SIZE_ATTRIB, config.getOrDefault("phoenix.mutate.maxSize", "500000")); //改变默认的500000

connectionProperties.setProperty(QueryServices.MUTATE_BATCH_SIZE_BYTES_ATTRIB, config.getOrDefault("phoenix.mutate.batchSizeBytes", "1073741824000")) val batch = config.getOrDefault("phoenix.insert.batchSize", "50000").toInt //调用插入方法

JdbcUtils.jdbcBatchInsert(dataFrame, table, phoenixUrl, connectionProperties, batch);

spark使用jdbc批次提交方式写入phoniex的工具类的更多相关文章

- Java中常用的加密方式(附多个工具类)

一.Java常用加密方式 Base64加密算法(编码方式) MD5加密(消息摘要算法,验证信息完整性) 对称加密算法 非对称加密算法 数字签名算法 数字证书 二.分类按加密算法是否需要key被分为两类 ...

- 【JDBC】学习路径5-提取JDBCUtils工具类

回顾我们上面几节的内容,我们发现重复代码非常多,比如注册驱动.连接.关闭close()等代码,非常繁杂. 于是我们将这些重复的大段代码进行包装.提取成JDBCUtils工具类. 第一章:提取注册连接模 ...

- Spark jdbc postgresql数据库连接和写入操作源码解读

概述:Spark postgresql jdbc 数据库连接和写入操作源码解读,详细记录了SparkSQL对数据库的操作,通过java程序,在本地开发和运行.整体为,Spark建立数据库连接,读取数据 ...

- Spark Standalone与Spark on YARN的几种提交方式

不多说,直接上干货! Spark Standalone的几种提交方式 别忘了先启动spark集群!!! spark-shell用于调试,spark-submit用于生产. 1.spark-shell ...

- Spark jdbc postgresql数据库连接和写入操作源代码解读

概述:Spark postgresql jdbc 数据库连接和写入操作源代码解读.具体记录了SparkSQL对数据库的操作,通过java程序.在本地开发和执行.总体为,Spark建立数据库连接,读取数 ...

- spark之JDBC开发(实战)

一.概述 Spark Core.Spark-SQL与Spark-Streaming都是相同的,编写好之后打成jar包使用spark-submit命令提交到集群运行应用$SPARK_HOME/bin#. ...

- spark之JDBC开发(连接数据库测试)

spark之JDBC开发(连接数据库测试) 以下操作属于本地模式操作: 1.在Eclipse4.5中建立工程RDDToJDBC,并创建一个文件夹lib用于放置第三方驱动包 [hadoop@CloudD ...

- Spark使用jdbc时的并行度

Spark SQL支持数据源使用JDBC从其他数据库读取数据. 与使用JdbcRDD相比,应优先使用此功能. 这是因为结果以DataFrame的形式返回,并且可以轻松地在Spark SQL中进行处理或 ...

- 各种数据库使用JDBC连接的方式

Java数据库连接(JDBC)由一组用 Java 编程语言编写的类和接口组成.JDBC 为工具/数据库开发人员提供了一个标准的 API,使他们能够用纯Java API 来编写数据库应用程序.然而各个开 ...

- spark下使用submit提交任务后报jar包已存在错误

使用spark submit进行任务提交,离线跑数据,提交后的一段时间内可以application可以正常运行.过了一段时间后,就抛出以下错误: org.apache.spark.SparkExcep ...

随机推荐

- [GPT] 如何让 vue-router 打开新窗口

在Vue Router中打开新窗口可以通过使用 <router-link> 组件的 target 属性来实现.将 target 属性设置为`"_blank"`将会在 ...

- 13.prometheus监控tengine(无用)

一.环境准备 1.1 docker安装tengine带nginx-module-vts模块(二选一) mkdir /data/ -p cd /data/ # 通过git clone下载已经创建好的do ...

- 他又来了,.net开源智能家居之小米米家的c#原生sdk【MiHome.Net】1.0.0发布,快来打造你的私人智能家居吧

背景介绍 hi 大家好,我是三合,作为一个非著名懒人,智能家居简直刚需,在上一篇文章他来了他来了,.net开源智能家居之苹果HomeKit的c#原生sdk[Homekit.Net]1.0.0发布,快来 ...

- Springboot+Prometheus+grafana 制作自己的业务监控

目录 知识储备 系统架构 开始实现 生成业务指标 经典实现方法 自己的实现方案 引入依赖 配置文件 注册自己的指标[我这里用的是guaua格式数据] 写入指标 效果展示 配置prometheus 抓取 ...

- 还需要学习JDBC吗?如果需要该了解到怎么样的程度?

前言 只有光头才能变强. 文本已收录至我的GitHub精选文章,欢迎Star:https://github.com/ZhongFuCheng3y/3y 不知道大家在工作中还有没有写过JDBC,我在大三 ...

- su与sudo用法详解

su与sudo用法详解 目录 su与sudo用法详解 1. su和sudo详解:切换用户身份 1.1 shell登录类型和环境配置文件 1.2 su进行身份切换 1.3 sudo命令详解 1.3.1 ...

- Js中valueOf和toString区别和使用

对于number.string.Boolean.object.symbol数据类型调用valueOf方法,得到的都是数据本身(null.undefined两种类型上的原型链上没有valueOf方法) ...

- 10分钟了解Flink SQL使用

Flink 是一个流处理和批处理统一的大数据框架,专门为高吞吐量和低延迟而设计.开发者可以使用SQL进行流批统一处理,大大简化了数据处理的复杂性.本文将介绍Flink SQL的基本原理.使用方法.流批 ...

- 使用 JS 实现在浏览器控制台打印图片 console.image()

在前端开发过程中,调试的时候,我门会使用 console.log 等方式查看数据.但对于图片来说,仅靠展示的数据与结构,是无法想象出图片最终呈现的样子的. 虽然我们可以把图片数据通过 img 标签展示 ...

- 如何模拟HTTP请求并验证功能

要模拟HTTP请求并验证功能,你可以使用Spring Boot提供的MockMvc工具,它允许我们在没有实际启动HTTP服务器的情况下测试Spring MVC控制器.以下是一个使用MockMvc进行H ...