Flink-cdc实时读postgresql

由于公司业务需要,需要实时同步pgsql数据,我们选择使用flink-cdc方式进行

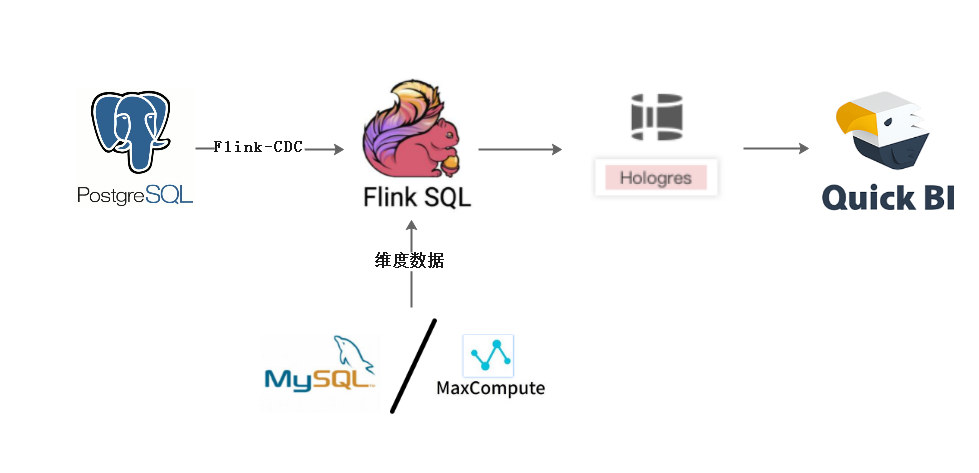

架构图:

前提步骤:

1,更改配置文件postgresql.conf

# 更改wal日志方式为logicalwal_level = logical # minimal, replica, or logical

# 更改solts最大数量(默认值为10),flink-cdc默认一张表占用一个slotsmax_replication_slots = 20 # max number of replication slots

# 更改wal发送最大进程数(默认值为10),这个值和上面的solts设置一样max_wal_senders = 20 # max number of walsender processes# 中断那些停止活动超过指定毫秒数的复制连接,可以适当设置大一点(默认60s)wal_sender_timeout = 180s # in milliseconds; 0 disable

更改配置文件postgresql.conf完成,需要重启pg服务生效,所以一般是在业务低峰期更改

2,新建用户并且给用户复制流权限

-- pg新建用户CREATE USER user WITH PASSWORD 'pwd';

-- 给用户复制流权限ALTER ROLE user replication;

-- 给用户登录数据库权限grant CONNECT ON DATABASE test to user;

-- 把当前库public下所有表查询权限赋给用户GRANT SELECT ON ALL TABLES IN SCHEMA public TO user;

3,发布表

-- 设置发布为true

update pg_publication set puballtables=true where pubname is not null;

-- 把所有表进行发布

CREATE PUBLICATION dbz_publication FOR ALL TABLES;

-- 查询哪些表已经发布

select * from pg_publication_tables;

4,更改表的复制标识包含更新和删除的值

-- 更改复制标识包含更新和删除之前值

ALTER TABLE test0425 REPLICA IDENTITY FULL;

-- 查看复制标识(为f标识说明设置成功)

select relreplident from pg_class where relname='test0425';

OK,到这一步,设置已经完全可以啦,上面步骤都是必须的

5,下面开始上代码:,

maven依赖

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_2.11</artifactId>

<version>1.13.0</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-scala -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_2.11</artifactId>

<version>1.13.0</version>

</dependency> <dependency>

<groupId>com.alibaba.ververica</groupId>

<artifactId>flink-connector-postgres-cdc</artifactId>

<version>1.1.0</version>

</dependency>

java代码

package flinkTest.connect; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.EnvironmentSettings;

import org.apache.flink.table.api.TableResult;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment; public class PgsqlToMysqlTest {

public static void main(String[] args) {

//设置flink表环境变量

EnvironmentSettings fsSettings = EnvironmentSettings.newInstance()

.useBlinkPlanner()

.inStreamingMode()

.build(); //获取flink流环境变量

StreamExecutionEnvironment exeEnv = StreamExecutionEnvironment.getExecutionEnvironment();

exeEnv.setParallelism(1); //表执行环境

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(exeEnv, fsSettings); //拼接souceDLL

String sourceDDL =

"CREATE TABLE pgsql_source (\n" +

" id int,\n" +

" name STRING,\n" +

" py_code STRING,\n" +

" seq_no int,\n" +

" description STRING\n" +

") WITH (\n" +

" 'connector' = 'postgres-cdc',\n" +

" 'hostname' = '***',\n" +

" 'port' = '5432',\n" +

" 'username' = '***',\n" +

" 'password' = '***',\n" +

" 'database-name' = '***',\n" +

" 'schema-name' = 'public',\n" +

" 'decoding.plugin.name' = 'pgoutput',\n" +

" 'debezium.slot.name' = '***',\n" +

" 'table-name' = '***'\n" +

")"; String sinkDDL =

"CREATE TABLE mysql_sink (\n" +

" id int,\n" +

" name STRING,\n" +

" py_code STRING,\n" +

" seq_no int,\n" +

" description STRING,\n" +

" PRIMARY KEY (id) NOT ENFORCED\n" +

") WITH (\n" +

" 'connector' = 'jdbc',\n" +

" 'url' = 'jdbc:mysql://ip:3306/DB?rewriteBatchedStatements=true&useUnicode=true&characterEncoding=UTF-8',\n" +

" 'username' = '***',\n" +

" 'password' = '***',\n" +

" 'table-name' = '***'\n" +

")"; String transformSQL =

"INSERT INTO mysql_sink " +

"SELECT id,name,py_code,seq_no,description " +

"FROM pgsql_source"; //执行source表ddl

tableEnv.executeSql(sourceDDL);

//执行sink表ddl

tableEnv.executeSql(sinkDDL);

//执行逻辑sql语句

TableResult tableResult = tableEnv.executeSql(transformSQL); }

}

表机构奉上:

-- pgsql表结构

CREATE TABLE "public"."test" (

"id" int4 NOT NULL,

"name" varchar(50) COLLATE "pg_catalog"."default" NOT NULL,

"py_code" varchar(50) COLLATE "pg_catalog"."default",

"seq_no" int4 NOT NULL,

"description" varchar(200) COLLATE "pg_catalog"."default",

CONSTRAINT "pk_zd_business_type" PRIMARY KEY ("id")

)

; -- mysql表结构

CREATE TABLE `test` (

`id` int(11) NOT NULL DEFAULT '0' COMMENT 'ID',

`name` varchar(50) DEFAULT NULL COMMENT '名称',

`py_code` varchar(50) DEFAULT NULL COMMENT '助记码',

`seq_no` int(11) DEFAULT NULL COMMENT '排序',

`description` varchar(200) DEFAULT NULL COMMENT '备注',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

6,下面就可以进行操作原表,然后增删改操作

Flink-cdc实时读postgresql的更多相关文章

- Fllin(七)【Flink CDC实践】

目录 FlinkCDC 1.简介 2.依赖 3.flink stream api 4.flink sql 5.自定义反序列化器 6.打包测试 FlinkCDC 1.简介 CDC是Change Data ...

- 阿里云体验有奖:使用PolarDB-X与Flink搭建实时数据大屏

体验简介 场景将提供一台配置了CentOS 8.5操作系统的ECS实例(云服务器).通过本教程的操作带您体验如何使用PolarDB-X与Flink搭建一个实时数据链路,模拟阿里巴巴双十一GMV大屏. ...

- 跟我一起读postgresql源码(八)——Executor(查询执行模块之——可优化语句的执行)

2.可优化语句的执行 可优化语句的共同特点是它们被查询编译器处理后都会生成査询计划树,这一类语句由执行器(Executor)处理.该模块对外提供了三个接口: ExecutorStart.Executo ...

- 跟我一起读postgresql源码(十)——Executor(查询执行模块之——Scan节点(下))

接前文跟我一起读postgresql源码(九)--Executor(查询执行模块之--Scan节点(上)) ,本篇把剩下的七个Scan节点结束掉. T_SubqueryScanState, T_Fun ...

- 跟我一起读postgresql源码(二)——Parser(查询分析模块)

上篇博客简要的介绍了下psql命令行客户端的前台代码.这一次,我们来看看后台的代码吧. 十分不好意思的是,上篇博客我们只说明了前台登陆的代码,没有介绍前台登陆过程中,后台是如何工作的.即:后台接到前台 ...

- Flink实战| Flink+Redis实时防刷接口作弊

随着人口红利的慢慢削减,互联网产品的厮杀愈加激烈,大家开始看好下沉市场的潜力,拼多多,趣头条等厂商通过拉新奖励,购物优惠等政策率先抢占用户,壮大起来.其他各厂商也紧随其后,纷纷推出自己产品的极速版,如 ...

- flink 处理实时数据的三重保障

flink 处理实时数据的三重保障 window+watermark 来处理乱序数据对于 TumblingEventTimeWindows window 的元数据startTime,endTime 和 ...

- (二)基于商品属性的相似商品推荐算法——Flink SQL实时计算实现商品的隐式评分

系列随笔: (总览)基于商品属性的相似商品推荐算法 (一)基于商品属性的相似商品推荐算法--整体框架及处理流程 (二)基于商品属性的相似商品推荐算法--Flink SQL实时计算实现商品的隐式评分 ( ...

- 指标统计:基于流计算 Oceanus(Flink) 实现实时 UVPV 统计

作者:吴云涛,腾讯 CSIG 高级工程师导语 | 最近梳理了一下如何用 Flink 来实现实时的 UV.PV 指标的统计,并和公司内微视部门的同事交流.然后针对该场景做了简化,并发现使用 Flink ...

随机推荐

- 记docker安装和ida远程调试问题

docker安装 1.卸载可能存在的旧版本: sudo apt-get remove docker docker-engine docker-ce docker.io 如果想要彻底卸载docker ...

- 05_pytorch的Tensor操作

05_pytorch的Tensor操作 目录 一.引言 二.tensor的基础操作 2.1 创建tensor 2.2 常用tensor操作 2.2.1 调整tensor的形状 2.2.2 添加或压缩t ...

- .NET6 平台系列3 .NET CLR 详解

系列目录 [已更新最新开发文章,点击查看详细] CLR 简介 运行时(Runtime Environment,简称Runtime ),是指那些支持在特定的平台上,用于运行特定编程语言编写的软件 ...

- Linux(CentOS7)安装与卸载MySQL8.0图文详解

Mysql数据库的安装对于开发者来说,是我们必然会面对的问题,它的安装过程其实并不复杂,并且网络上的安装教程也非常多,但是对于新手来说,各种不同形式的安装教程,又给新手们带来了要选择哪种方式进行安装的 ...

- 支持rotate和大小限制的golang log库

支持大小限制和rotate的log库,还是很有必要的,前者让你不再操心磁盘被吃光,后者让查日志更方便. 但是在golang中没有太好的实现,看过一些开源的和自行实现的,都有几个不满意的地方,比如: 没 ...

- 官宣 MAUI 在.NET Preview 3的最新进展

我们在.NET 6 Preview 3中交付了.NET多平台应用UI的移动和桌面开发的最新进展.此版本添加了Windows平台和WinUI 3,改进了基本应用程序和启动构建器,添加了原生生命周期事件, ...

- sublimeText常用插件

扩展包: EmmetAlignmentDocBlockrSideBarEnhancementsFileDiffsColorsublimelocalizationAutoFileNameA File ...

- 【Feign】Feign ,OpenFeign以及Ribbon之间的区别?

Ribbon Ribbon 是 Netflix开源的基于HTTP和TCP等协议负载均衡组件 Ribbon 可以用来做客户端负载均衡,调用注册中心的服务 Ribbon的使用需要代码里手动调用目标服务,请 ...

- hdu4403暴力搜索

题意: 给你一个数字串,让你在里面添加一个=和若干个+,使等式成立. 思路: lmax最大是15,直接暴搜,无压力,关键是判重,要在答案的时候判重,一开始在进队列之前判的,各种wa ...

- DVWA之 SQL Injection(Blind)

SQL Injection(Blind) SQL Injection(Blind),即SQL盲注,与一般注入的区别在于,一般的注入攻击者可以直接从页面上看到注入语句的执行结果,而盲注时攻击者通常是无法 ...