N最短路径分词

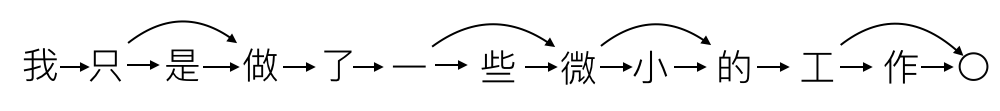

N最短路径算法是一种基于词典的分词算法. 每个句子将生成一个有向无环图, 每个字作为图的一个定点, 边代表可能的分词.

在上图中, 边的起点为词的第一个字, 边的终点为词尾的下一个字. 边1表示"我"字单字成词, 边2表示"只是"可以作为一个单词.

每个边拥有一个权值, 表示该词出现的概率. 最简单的做法是采用词频作为权值, 也可以采用TF-IDF值作为权值提高对低频词的分词准确度.

N最短路径分词即在上述有向无环图中寻找N条权值和最大的路径, 路径上的边标志了最可能的分词结果.通常我们只寻找权值和最大的那一条路径.

根据上图的权值最大路径得到的分词结果为: "我/只是/做/了/一些/微小/的/工作"

实现词典

词典将根据输入的文本, 统计各单词的词频:

class WordDictModel:

def __init__(self):

self.word_dict = {}

self.data = None

self.stop_words = {}

def load_data(self, filename):

self.data = open(filename, "r", encoding="utf-8")

def update(self):

# build word_dict

for line in self.data:

words = line.split(" ")

for word in words:

if word in self.stop_words:

continue

if self.word_dict.get(word):

self.word_dict[word] += 1

else:

self.word_dict[word] = 1

update函数可以在原有词典的基础上, 根据新的输入更新词频.

原始文本输入:

...

罗辑 离开 墓碑 , 站 到 他 为 自己 挖掘 的 墓穴 旁 , 将 手枪 顶到 自己 的 心脏 位置 , 说 : “ 现在 , 我 将 让 自己 的 心脏 停止 跳动 , 与此同时 我 也 将 成为 两个 世界 有史以来 最大 的 罪犯 。 对于 所 犯下 的 罪行 , 我 对 两个 文明 表示 深深 的 歉意 , 但 不会 忏悔 , 因为 这是 唯一 的 选择 。 我 知道 智子 就 在 身边 , 但 你们 对 人类 的 呼唤 从不 理睬 , 无言 是 最大 的 轻蔑 , 我们 忍受 这种 轻蔑 已经 两个 世纪 了 , 现在 , 如果 你们 愿意 , 可以 继续 保持 沉默 , 我 只 给 你们 三十 秒钟 时间

...

产生词频词典:

{

...

"伏击战": 26,

"生态园林": 3,

"造谣诽谤": 3,

"下关市": 11,

"水彩颜料": 3,

"虎踞龙盘": 5,

...

}

顺便编写save和load方法:

def save(self, filename="words.txt", code="txt"):

fw = open(filename, 'w', encoding="utf-8")

data = {

"word_dict": self.word_dict

}

# encode and write

if code == "json":

txt = json.dumps(data)

fw.write(txt)

elif code == "pickle":

pickle.dump(data, fw)

if code == 'txt':

for key in self.word_dict:

tmp = "%s %d\n" % (key, self.word_dict[key])

fw.write(tmp)

fw.close()

def load(self, filename="words.txt", code="txt"):

fr = open(filename, 'r', encoding='utf-8')

# load model

model = {}

if code == "json":

model = json.loads(fr.read())

elif code == "pickle":

model = pickle.load(fr)

elif code == 'txt':

word_dict = {}

for line in fr:

tmp = line.split(" ")

if len(tmp) < 2:

continue

word_dict[tmp[0]] = int(tmp[1])

model = {"word_dict": word_dict}

# update word dict

word_dict = model["word_dict"]

for key in word_dict:

if self.word_dict.get(key):

self.word_dict[key] += word_dict[key]

else:

self.word_dict[key] = word_dict[key]

fr.close()

最短路径分词

分词器需要继承WordDictModel, 并利用其词典. 遍历输入语句中所有子串, 并查询其词频构造有向无环图:

class DAGSegger(WordDictModel):

def build_dag(self, sentence):

dag = {}

for start in range(len(sentence)):

unique = [start + 1]

tmp = [(start + 1, 1)]

for stop in range(start+1, len(sentence)+1):

fragment = sentence[start:stop]

# use tf_idf?

num = self.word_dict.get(fragment, 0)

if num > 0 and (stop not in unique):

tmp.append((stop, num))

unique.append(stop)

dag[start] = tmp

return dag

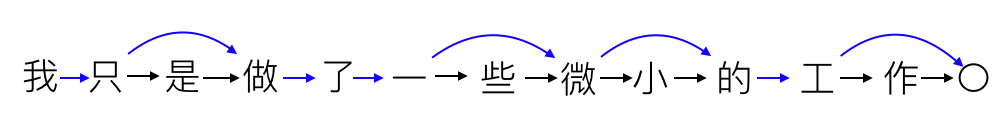

产生的dag格式:

{

0: [(1,1)],

1: [(2,1), (3,738)],

2: [(3,1)],

3: [(4,1)],

4: [(5,1)],

5: [(6,1), (7,2309)],

6: [(7,1)],

7: [(8,1), (9,304)],

8: [(9,1)],

9: [(10,1)],

10: [(11,1), (12,2605)],

11: [(12,1)],

}

字典中的值代表其键的后继顶点, 如1: [(2,1), (3,738)]表示顶点1到顶点2的权值为1, 到顶点3的权值为738.

最短路径最好使用Floyd或Dijsktra算法. 但其耗时太久, 大多数情况下使用贪心算法求得次优解就可以达到所需精度:

def predict(self, sentence):

Len = len(sentence)

route = [0] * Len

dag = self.build_dag(sentence) # {i: (stop, num)}

for i in range(0, Len):

route[i] = max(dag[i], key=lambda x: x[1])[0]

return route

词典法分词本身就是一种不精确的方法, 最短路径的最优解和次优解在分词效果上相差并不大.

但是, 求得最优解需要将时间复杂度由O(n2)提高到O(n3). 考虑常见句子的长度, 造成的性能损失难以接受.

最后, 做一下测试:

dag_segger = DAGSegger()

dag_segger.stop_words = seg_stop_words

dag_segger.load(filename=data_path("words.txt"))

def test_seg():

cases = [

"给你们传授一点人生的经验",

"我来到北京清华大学",

"长春市长春节讲话",

"我们在野生动物园玩",

"我只是做了一些微小的工作",

"国庆节我在研究中文分词",

"比起生存还是死亡来忠诚与背叛可能更是一个问题"

]

for case in cases:

result = dag_segger.cut(case)

print(result)

测试结果:

['给', '你们', '传授', '一点', '人生', '的', '经验']

['我', '来到', '北京', '清华大学']

['长春', '市长', '春节', '讲话']

['我们', '在', '野生', '动物园', '玩']

['我', '只是', '做', '了', '一些', '微小', '的', '工作']

['国庆节', '我', '在', '研究', '中文', '分词']

['比起', '生存', '还是', '死亡', '来', '忠诚', '与', '背叛', '可能', '更是', '一个', '问题']

因依赖关系,若要运行代码请clone整个项目, 并运行python3 test.py。

N最短路径分词的更多相关文章

- 自然语言处理工具HanLP-N最短路径分词

本篇给大家分享baiziyu 写的HanLP 中的N-最短路径分词.以为下分享的原文,部分地方有稍作修改,内容仅供大家学习交流! 首先说明在HanLP对外提供的接口中没有使用N-最短路径分词器的,作者 ...

- Hanlp中N最短路径分词详细介绍

N-最短路径 是中科院分词工具NLPIR进行分词用到的一个重要算法,张华平.刘群老师在论文<基于N-最短路径方法的中文词语粗分模型>中做了比较详细的介绍.该算法算法基本思想很简单,就是给定 ...

- 11大Java开源中文分词器的使用方法和分词效果对比

本文的目标有两个: 1.学会使用11大Java开源中文分词器 2.对比分析11大Java开源中文分词器的分词效果 本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那 ...

- Hanlp中使用纯JAVA实现CRF分词

Hanlp中使用纯JAVA实现CRF分词 与基于隐马尔可夫模型的最短路径分词.N-最短路径分词相比,基于条件随机场(CRF)的分词对未登录词有更好的支持.本文(HanLP)使用纯Java实现CRF模型 ...

- CRF分词的纯Java实现

与基于隐马尔可夫模型的最短路径分词.N-最短路径分词相比,基于随机条件场(CRF)的分词对未登录词有更好的支持.本文(HanLP)使用纯Java实现CRF模型的读取与维特比后向解码,内部特征函数采用 ...

- NLP舞动之中文分词浅析(一)

一.简介 针对现有中文分词在垂直领域应用时,存在准确率不高的问题,本文对其进行了简要分析,对中文分词面临的分词歧义及未登录词等难点进行了介绍,最后对当前中文分词实现的算法原理(基于词表. ...

- Python分词工具——pyhanlp

本文为本人学习pyhanlp的笔记,大多知识点来源于GitHubhttps://github.com/hankcs/HanLP/blob/master/README.md,文中的demo代码来源于该G ...

- HanLP-最短路径分词

今天介绍的内容是最短路径分词.最近换回了thinkpad x1,原因是mac的13.3寸的屏幕看代码实在是不方便,也可能是人老了吧,^_^.等把HanLP词法分析介绍结束后,还是会换回macbook ...

- 11大Java开源中文分词器的使用方法和分词效果对比,当前几个主要的Lucene中文分词器的比较

本文的目标有两个: 1.学会使用11大Java开源中文分词器 2.对比分析11大Java开源中文分词器的分词效果 本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那 ...

随机推荐

- Linux配置ntp时间服务器(全)

时间服务器作用: 大数据产生与处理系统是各种计算设备集群的,计算设备将统一.同步的标准时间用于记录各种事件发生时序, 如E-MAIL信息.文件创建和访问时间.数据库处理时间等. 大数据系统内不同计算设 ...

- tensorflow学习之(一)预测一条直线y = 0.1x + 0.3

#预测一条y = 0.1x + 0.3的直线 import tensorflow as tf import numpy as np #科学计算模块 ''' tf.random_normal([784, ...

- LOJ-10105(欧拉回路模板,套圈法,递归)

题目链接:传送门 思路: (1)用邻接表存储有向图和无向图,有向图和无向图的每条边均站两个单元,无向图有正向边和反向边的区分. (2)有向图有欧拉回路:所有点的入度=出度: 无向图有欧拉回路:所有点的 ...

- 调用redis的时候二维码不断刷新的排查

一.背景和现象. 项目是PHP开发的,点击登录的时候就根据随机数生成了二维码,缓存在了redis.用户用微信扫描了二维码分析出需要请求的链接,然后微信浏览器就请求了服务器,服务器通过了随机数认证.正当 ...

- 【转】学习Java虚拟机没用? 听听当事人是怎么说的!

我是大名鼎鼎的Java 虚拟机, 据说这个星球上每天有900多万程序员和我打交道,这真是一个惊人的数字. 这900多万人中不少人对我的技术内幕非常感兴趣, 有事儿没事儿都要把我“大卸八块”, 深入了 ...

- Vue学习笔记八:v-for,v-if,v-show指令

目录 v-for指令:遍历 HTML和效果图 v-for讲解 v-if和v-show:创建,删除,显示,隐藏 HTML和效果图 v-if和v-show的原理 v-for指令:遍历 HTML和效果图 有 ...

- cad.net DeepCloneObjects WasErased

/// <summary> /// 克隆图元到块表记录 /// </summary> /// <param name="objId">id数组& ...

- 8:String类

String类 String类的特点: 字符串对象一旦被初始化就不会被改变. 字符串是最常用的类型之一,所以为了使用方便java就给封装成了对象方便使用 public static void str ...

- 第四篇:断路器(Hystrix)

一.断路器简介. 在微服务架构中,根据业务来拆分成一个个的服务,服务与服务之间可以相互调用(RPC),在Spring Cloud可以用RestTemplate+Ribbon和Feign来调用.为了保证 ...

- Ubuntu 18.0.4安装docker

第一步:如果之前安装过docker,执行下面命令删除 apt-get remove docker docker-engine docker.io 删除后执行sudo apt-get update更新软 ...