scrapy下载 大文件处理

# 一个校花网图片下载的案例,也适合大文件处理,多个文件视频,音频处理

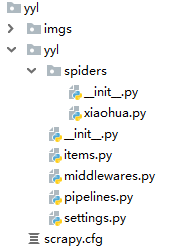

工程流程 --

scrapy startproject xx

cd xx

scrapy genspider hh www.xx.com

爬虫执行 scrapy crawl hh

import scrapy

from yyl.items import YylItem class ExampleSpider(scrapy.Spider):

name = 'xiaohua'

# allowed_domains = ['example.com']

start_urls = ['http://www.521609.com/daxuemeinv/'] def parse(self, response):

li_lst = response.xpath('//*[@id="content"]/div[2]/div[2]/ul/li')

# print(li_lst) for li in li_lst:

item = YylItem() #实例化

# item['src'] = 'http://www.521609.com{}'.format(li.xpath('./a/img/@src').extract_first())

item['src'] = 'http://www.521609.com' + li.xpath('./a/img/@src').extract_first() # 拼接完整地址

yield item # 管道负责 下载url 视频 压缩包 大文件下载的机制

爬虫文件

import scrapy class YylItem(scrapy.Item):

# define the fields for your item here like:

src = scrapy.Field()

items.py

import scrapy

from scrapy.pipelines.images import ImagesPipeline class YylPipeline(object):

def process_item(self, item, spider):

print(item)

return item # 使用一个scrapy封装好的一个专门用于大文件下载的管道类

class ImgPipeline(ImagesPipeline):

# 进行大文件的请求

def get_media_requests(self, item, info):

yield scrapy.Request(url=item['src']) # 用于指定被下载文件的名称

def file_path(self, request, response=None, info=None):

url = request.url

filename = url.split('/')[-1]

return filename #

def item_completed(self, results, item, info):

print(results) # 结果 True,{url path checksum}

return item # process_item中的return item 作用一致

管道.py

BOT_NAME = 'yyl' SPIDER_MODULES = ['yyl.spiders']

NEWSPIDER_MODULE = 'yyl.spiders' # Crawl responsibly by identifying yourself (and your website) on the user-agent USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36' # Obey robots.txt rules

ROBOTSTXT_OBEY = False # Configure maximum concurrent requests performed by Scrapy (default: 16)

#CONCURRENT_REQUESTS = 32 # Configure a delay for requests for the same website (default: 0)

# See https://doc.scrapy.org/en/latest/topics/settings.html#download-delay

# See also autothrottle settings and docs

#DOWNLOAD_DELAY = 3

# The download delay setting will honor only one of:

#CONCURRENT_REQUESTS_PER_DOMAIN = 16

#CONCURRENT_REQUESTS_PER_IP = 16 # Disable cookies (enabled by default)

#COOKIES_ENABLED = False # Disable Telnet Console (enabled by default)

#TELNETCONSOLE_ENABLED = False # Override the default request headers:

#DEFAULT_REQUEST_HEADERS = {

# 'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

# 'Accept-Language': 'en',

#} # Enable or disable spider middlewares

# See https://doc.scrapy.org/en/latest/topics/spider-middleware.html

#SPIDER_MIDDLEWARES = {

# 'yyl.middlewares.YylSpiderMiddleware': 543,

#} # Enable or disable downloader middlewares

# See https://doc.scrapy.org/en/latest/topics/downloader-middleware.html

#DOWNLOADER_MIDDLEWARES = {

# 'yyl.middlewares.YylDownloaderMiddleware': 543,

#} # Enable or disable extensions

# See https://doc.scrapy.org/en/latest/topics/extensions.html

#EXTENSIONS = {

# 'scrapy.extensions.telnet.TelnetConsole': None,

#} # Configure item pipelines

# See https://doc.scrapy.org/en/latest/topics/item-pipeline.html

ITEM_PIPELINES = {

'yyl.pipelines.YylPipeline': 301,

'yyl.pipelines.ImgPipeline': 300,

}

IMAGES_STORE = './imgs' LOG_LEVEL = 'ERROR'

settings.py

scrapy下载 大文件处理的更多相关文章

- 转(Response.WriteFile 无法下载大文件解决方法)

以前用Response.WriteFile(filename),但当遇到大文件时无法完整下载. 该方法最大的问题,它不是直接将数据抛到客户端,而是在服务器端(IIS)上缓存.当下载文件比较大时,服务器 ...

- python下载大文件

1. wget def download_big_file_with_wget(url, target_file_name): """ 使用wget下载大文件 Note: ...

- python 下载大文件

当使用requests的get下载大文件/数据时,建议使用使用stream模式. 当把get函数的stream参数设置成False时,它会立即开始下载文件并放到内存中,如果文件过大,有可能导致内存不足 ...

- ASP.Net 下载大文件的实现

当我们的网站需要支持下载大文件时,如果不做控制可能会导致用户在访问下载页面时发生无响应,使得浏览器崩溃.可以参考如下代码来避免这个问题. 关于此代码的几点说明: 1. 将数据分成较小的部分,然后将其移 ...

- Android 开发工具类 27_多线程下载大文件

多线程下载大文件时序图 FileDownloader.java package com.wangjialin.internet.service.downloader; import java.io.F ...

- ASP.NET Core下载大文件的实现

当我们的ASP.NET Core网站需要支持下载大文件时,如果不做控制可能会导致用户在访问下载页面时发生无响应,使得浏览器崩溃.可以参考如下代码来避免这个问题. 关于此代码的几点说明: 将数据分成较小 ...

- [libcurl]_[0基础]_[使用libcurl下载大文件]

场景: 1. 在Windows编程时, 下载http页面(html,xml)能够使用winhttp库,可是并非非常下载文件,由于会失败. 由此引出了WinINet库,无奈这个库的稳定性比較低,使用样例 ...

- ASP.Net 下载大文件的实现 (转)

原文:http://www.cnblogs.com/luisliu/p/4253815.html 当我们的网站需要支持下载大文件时,如果不做控制可能会导致用户在访问下载页面时发生无响应,使得浏览器崩溃 ...

- Linux如何使用cURL分割下载大文件

Linux如何使用cURL分割下载大文件 - 51CTO.COM http://os.51cto.com/art/201508/489368.htm

随机推荐

- Could not connect to SMTP host: smtp.qq.com, port: 465, response: -1 SpringBoot发送邮件

解决方案 换端口 QQ邮箱可以把端口换成587 设置属性 spring.mail.properties.mail.smtp.ssl.enable=true 原因 465端口是为SMTPS(SMTP-o ...

- 改变容器Size后,刷新地图大小。

You need to call the API to update map size. http://dev.openlayers.org/docs/files/OpenLayers/Map-js. ...

- Keep、小红书、美图…独角兽App能拿到新一轮救命钱吗?

大多数人热爱手机,不是因为时尚的外观或者结实的零部件,而是因琳琅满目的App赋予其太多的功能.智能手机最先是清理掉人类的零碎时间,现如今又开始肢解我们大块的时间,或者说,智能手机本身就是生活.在如此背 ...

- mybatis一对多 多对一 多对多

https://blog.csdn.net/AdminGuan/article/details/98952484 Mybatis的Mapper该如何编写多对一? 很简单,就是在resultMap标 ...

- 神器扒网站——teleport ultra

在平时的开发或者学习的过程中,我们难免会看到一些让人心动的网站,于是自己想把它搞下来,自己手工一个文件一个文件把它保存下来也可以实现,完成了也累得够呛,有一款扒站的神器,可以把你所喜欢的目标网站整个网 ...

- mybatis(三):框架结构

- 杭电oj1995——汉诺塔V(java实现)

正文之前,先说下做这题的心路历程(简直心累) 这是今天下午的第一道题 第一次看到题目标题——汉诺塔 内心OS:wc,汉诺塔诶,听名字就很难诶,没做过诶,肯定很难实现吧,不行,我得去看看讲解 然后就上b ...

- [P4550] 收集邮票 - 概率期望,dp

套路性地倒过来考虑,设\(f[i]\)表示拥有了\(i\)种票子时还需要多少次购买,\(g[i]\)表示还需要多少钱 推\(g[i]\)递推式时注意把代价倒过来(反正总数一定,从顺序第\(1\)张开始 ...

- mysql 1130 Navicat for MySQL 连接MySQL 8.0 出现1130错误

可能是帐号不允许从远程登陆,只能在localhost.这个时候只要在localhost的那台电脑登入MySQL后,更改"MySQL"数据库"user"表里的&q ...

- HTTP状态码详解【转】

HTTP状态码,我都是现查现用. 我以前记得几个常用的状态码,比如200,302,304,404, 503. 一般来说我也只需要了解这些常用的状态码就可以了. 如果是做AJAX,REST,网络爬虫, ...