深度学习-conv卷积

过滤器(卷积核)

传统的图像过滤器算子有以下几种:

- blur kernel:减少相邻像素的差异,使图像变平滑。

- sobel:显示相邻元素在特定方向上的差异。

- sharpen :强化相邻像素的差异,使图片看起来更生动。

- outline:也称为edge kernel,相邻像素相似亮度的像素点设成黑,有较大差异的设为白。

更多可参考 image-kernels 在线演示不同的卷积过滤器。

CNN 卷积层

CNN做的事情不是提前决定好过滤器,而是把过滤器当成参数不断调整学习,学出合适的过滤器。卷积网络的第一层执行的通常都是边缘检测,后面的层得到的都是更抽象的特征。CNN 卷积层的一个重要特性是权值共享.

权值共享:不同的感受域共享同一权值,因此也称为filter,能够大大减少权重的数量(所占的内存),这通常是有效的,因为filter过滤某一特征与具体的空间位置无关.但无独有偶,人脸图片通常是中心化的,即人的脑袋比较靠近中间,如此可以看出位置信息是有用的.对于这种情形我们可以取消权值共享机制,此时称这一层为Locally-Connected Layer.

有时候提到filter的长和宽大小而不提到深度,则深度是输入数据的整个深度(因此1x1的卷积核也是有意义的).如前一层的输入是 [16x16x20],感知域大小是3x3,那么卷积层中每个神经元将有3x3x20 = 180个到前一层的连接.

如果指明了深度,如96,那么卷积层中每个神经元到前一层有3x3x96个连接,96层连接到同一块区域,但是权重不相同.(注意有时候还以RGB三通道这三层作为一个整体,因此还要乘上3).

小卷积核

现在流行的网络结构设计多遵循小卷积核的设计原则, 小卷积核的优势:

3个3x3的卷积核的累加相当于1个7x7的卷积核,但是参数更少,计算量更小,有更多的非线性层计算.还可以通过加入1x1的"bottleneck"卷积核进一步减少计算(GoogLeNet等大量运用这种方式加深层次).如输入HxWxC经过下列步骤输出的维数不变:

\[

\require{AMScd}

\begin{CD}

H\times W\times C @>{\text{C/2 x Conv1x1}}>> H\times W\times C/2 \\

@. @V {\text{C/2 x Conv3x3}} VV \\

H\times W\times C @< \text{C x Conv1x1} << H\times W\times C/2

\end{CD}

\]

然而上述步骤中仍然使用了3x3卷积核,可以将其转成1x3与3x1的连接.

Dilated convolutions.卷积核在输入上滑动时可以让步长大到不同的感知域之间有间隙,这个间隙作为超参数(dilation膨胀).其作用相当于减少了一些卷积等层,更快地获取输入的空间信息.

卷积实现

卷积有三种主流的计算方式:转化为矩阵乘,winograd,和FFT。

在现代的 DL 框架中对卷积计算通常采用矩阵乘法的方式,使用im2col操作将输入数据与权重展开成二维矩阵(使得图像矩阵和卷积核能够直接相乘, 转换的反向操作为col2im),运用 BLAS API进行高效计算,缺点是占用许多内存.这种思想也可以用在pooling操作中.

没有广泛使用FFT的原因:

FFT只有在卷积核比较大的时候才有明显速度优势。但是CNN的卷积核一般都小于5,所以深度学习中一般不用FFT。FFT卷积没有广泛应用的原因是因为通用平台上有更合适的Winograd卷积的存在,而专用平台上直接降低运算精度是更合适的方案。不过,现在CNN里面越来越多的1×1卷积和depthwise卷积被加入,Winograd卷积的价值也越来越小了。1

下边简单介绍下快速傅里叶变换.

卷积定理(convolution theorem) 23

快速傅里叶变换被称为20世纪最重要的算法之一, 一个因素就是卷积定理.

傅里叶变换可以看作是对图像或者音频等数据的重新组织,它将时域和空域上的复杂卷积对应到了频域中的元素间简单的乘积。

一维连续域上两个连续函数的卷积:

\[

h(x)=f\bigotimes g=\int_{-\infty}^\infty f(x-u)g(u)du=\mathcal F^{-1}(\sqrt{2\pi}\mathcal F[f]\mathcal F[g])

\]

由卷积定理可以知道,两个矩阵卷积的结果等价于两个矩阵经过傅里叶变换(\(\mathcal F\)),进行元素级别相乘,再经过傅里叶逆变换(\(\mathcal F^{-1}\)). \(\sqrt{2\pi}\)是一个normalizer.

二维离散域(图像)上的卷积:

\[

\begin{align}

\text{feature map}=&\text{intput}\bigotimes\text{kernel} \\

=&\sum_{y=0}^M \sum_{x=0}^N \text{intput}(x-a,y-b)\cdot \text{kernel}(x,y) \\

=&\mathcal F^{-1}(\sqrt{2\pi}\mathcal F[\text{intput}]\mathcal F[\text{kernel}])

\end{align}

\]

快速傅里叶变换是一种将时域和空域中的数据转换到频域上去的算法。傅里叶变换用一些正弦和余弦波的和来表示原函数。必须注意的是,傅里叶变换一般涉及到复数,也就是说一个实数被变换为一个具有实部和虚部的复数。通常虚部只在一部分领域有用,比如将频域变换回到时域和空域上.

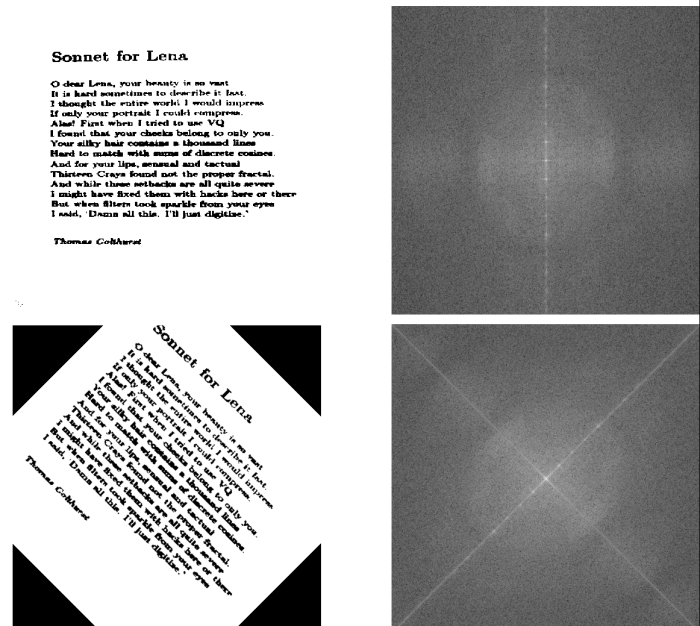

傅里叶变换图示4

从傅里叶变换中可以看出方向信息:

Images by Fisher & Koryllos (1998). Source

caffe中的卷积实现

卷积操作示意图如下,输入图片的维数为[c0,h0,w0];卷积核的维数为[c1,c0,hk,wk],其中c0在图中没有表示出来,一个卷积核可以看成由c1个维数为[c0,hk,wk]的三维滤波器组成,输出特征的维数为[c1,h1,w1]

转成二维矩阵乘法的高效计算:

更详细的im2col图示:

深度学习-conv卷积的更多相关文章

- 深度学习之卷积神经网络(CNN)的应用-验证码的生成与识别

验证码的生成与识别 本文系作者原创,转载请注明出处:https://www.cnblogs.com/further-further-further/p/10755361.html 目录 1.验证码的制 ...

- 深度学习之卷积神经网络CNN及tensorflow代码实例

深度学习之卷积神经网络CNN及tensorflow代码实例 什么是卷积? 卷积的定义 从数学上讲,卷积就是一种运算,是我们学习高等数学之后,新接触的一种运算,因为涉及到积分.级数,所以看起来觉得很复杂 ...

- 深度学习之卷积神经网络CNN及tensorflow代码实现示例

深度学习之卷积神经网络CNN及tensorflow代码实现示例 2017年05月01日 13:28:21 cxmscb 阅读数 151413更多 分类专栏: 机器学习 深度学习 机器学习 版权声明 ...

- 【神经网络与深度学习】卷积神经网络(CNN)

[神经网络与深度学习]卷积神经网络(CNN) 标签:[神经网络与深度学习] 实际上前面已经发布过一次,但是这次重新复习了一下,决定再发博一次. 说明:以后的总结,还应该以我的认识进行总结,这样比较符合 ...

- 深度学习之卷积神经网络(CNN)详解与代码实现(一)

卷积神经网络(CNN)详解与代码实现 本文系作者原创,转载请注明出处:https://www.cnblogs.com/further-further-further/p/10430073.html 目 ...

- 【转载】 深度学习之卷积神经网络(CNN)详解与代码实现(一)

原文地址: https://www.cnblogs.com/further-further-further/p/10430073.html ------------------------------ ...

- 深度学习之卷积神经网络(CNN)

卷积神经网络(CNN)因为在图像识别任务中大放异彩,而广为人知,近几年卷积神经网络在文本处理中也有了比较好的应用.我用TextCnn来做文本分类的任务,相比TextRnn,训练速度要快非常多,准确性也 ...

- 深度学习:卷积神经网络(convolution neural network)

(一)卷积神经网络 卷积神经网络最早是由Lecun在1998年提出的. 卷积神经网络通畅使用的三个基本概念为: 1.局部视觉域: 2.权值共享: 3.池化操作. 在卷积神经网络中,局部接受域表明输入图 ...

- 深度学习FPGA实现基础知识10(Deep Learning(深度学习)卷积神经网络(Convolutional Neural Network,CNN))

需求说明:深度学习FPGA实现知识储备 来自:http://blog.csdn.net/stdcoutzyx/article/details/41596663 说明:图文并茂,言简意赅. 自今年七月份 ...

随机推荐

- springMVC系列之(三) spring+springMVC集成(annotation方式)

个人认为使用框架并不是很难,关键要理解其思想,这对于我们提高编程水平很有帮助.不过,如果用都不会,谈思想就变成纸上谈兵了!!!先技术,再思想.实践出真知. 1.基本概念 1.1.Spring Spri ...

- Android开发学习之路--React-Native之初体验

近段时间业余在学node.js,租了个阿里云准备搭建后端,想用node.js,偶尔得知react-native可以在不同平台跑,js在iOS和android上都可以运行ok,今天就简单学习下rea ...

- 【Android 应用开发】 Android APK 反编译 混淆 反编译后重编译

反编译工具 : 总结了一下 linux, windows, mac 上的版本, 一起放到 CSDN 上下载; -- CSDN 下载地址 : http://download.csdn.net/detai ...

- UNIX环境高级编程——epoll函数使用详解

epoll - I/O event notification facility 在linux的网络编程中,很长的时间都在使用select来做事件触发.在linux新的内核中,有了一种替换它的机制,就是 ...

- OJ题:计算各个数的位数之和

题目描述: 输入一个大于0的数,要求各个位数的和. 例如: 输入12345 那么输出15 程序如下: ) ; }

- C++在单继承、多继承、虚继承时,构造函数、复制构造函数、赋值操作符、析构函数的执行顺序和执行内容

一.本文目的与说明 1. 本文目的:理清在各种继承时,构造函数.复制构造函数.赋值操作符.析构函数的执行顺序和执行内容. 2. 说明:虽然复制构造函数属于构造函数的一种,有共同的地方,但是也具有一定的 ...

- Socket编程实践(9) --套接字IO超时设置方法

引:超时设置3种方案 1. alarm超时设置方法 //代码实现: 这种方式较少用 void sigHandlerForSigAlrm(int signo) { return ; } signal(S ...

- int*p[ ]与int(*p)[ ]的不同

举例说明: 1)int* p[2] 是一个指向int型的指针数组,即:p是包含两个元素的指针数组,指针指向的是int型. 可以这样来用: #include <iostream> using ...

- 抓包工具Fidder详解

第一步:下载神器Fiddler,下载链接: http://fiddler2.com/get-fiddler 下载完成之后,傻瓜式的安装一下了! 现在这个下载链接失效了,可以百度下载 第二步:设置Fid ...

- Python学习 - 输入和输出

#输出 print('hello, python') print('The quick brown fox', 'jumps over', 'the lazy dog') #多个字符串,用逗号隔开,就 ...