[Machine Learning] logistic函数和softmax函数

简单总结一下机器学习最常见的两个函数,一个是logistic函数,另一个是softmax函数,若有不足之处,希望大家可以帮忙指正。本文首先分别介绍logistic函数和softmax函数的定义和应用,然后针对两者的联系和区别进行了总结。

1. logistic函数

1.1 logistic函数定义

引用wiki百科的定义:

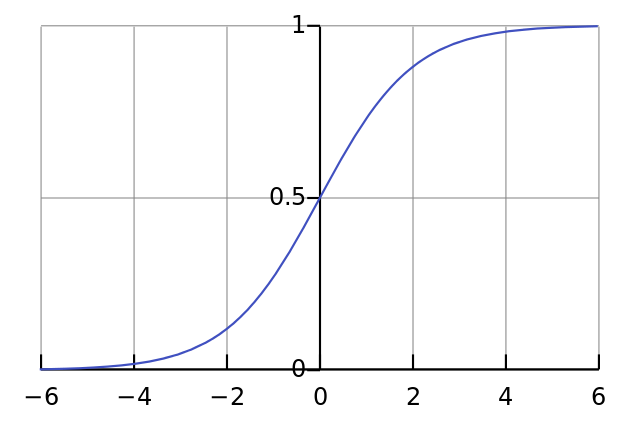

A logistic function or logistic curve is a common "S" shape (sigmoid curve).

其实逻辑斯谛函数也就是经常说的sigmoid函数,它的几何形状也就是一条sigmoid曲线。

logistic函数的公式形式如下:

$f(x) = \frac{L}{1+e^{-k(x-x_{0})}}$

其中,$x_{0}$表示了函数曲线的中心(sigmoid midpoint),$k$是曲线的坡度。

logistic的几何形状如下所示:

1.2 logistic函数的应用

logistic函数本身在众多领域中都有很多应用,我们只谈统计学和机器学习领域。

logistic函数在统计学和机器学习领域应用最为广泛或者最为人熟知的肯定是逻辑斯谛回归模型了。逻辑斯谛回归(Logistic Regression,简称LR)作为一种对数线性模型(log-linear model)被广泛地应用于分类和回归场景中。此外,logistic函数也是神经网络最为常用的激活函数,即sigmoid函数。

2. softmax函数

2.1 softmax函数的定义

同样,我们贴一下wiki百科对softmax函数的定义:

softmax is a generalization of logistic function that "squashes"(maps) a $K$-dimensional vector $z$ of arbitrary real values to a $K$-dimensional vector $\sigma(z)$ of real values in the range (0, 1) that add up to 1.

这句话既表明了softmax函数与logistic函数的关系,也同时阐述了softmax函数的本质就是将一个$K$维的任意实数向量压缩(映射)成另一个$K$维的实数向量,其中向量中的每个元素取值都介于(0,1)之间。

softmax函数形式如下:

$\sigma(z)_{j}=\frac{e^{z_{j}}}{\sum^{K}_{k=1}e^{z_{k}}}$

其中$j = 1,2, ... , K$。

2.2 sotfmax函数的应用

softmax函数经常用在神经网络的最后一层,作为输出层,进行多分类。此外,softmax在增强学习领域内,softmax经常被用作将某个值转化为激活概率,这类情况下,softmax的公式如下:

$P_{t}(a)=\frac{e^{\frac{q_{t}(a)}{T}}}{\sum^{n}_{i=1}e^{\frac{q_{t}(i)}{T}}}$

其中,$T$被称为是温度参数(temperature parameter)。当T很大时,即趋于正无穷时,所有的激活值对应的激活概率趋近于相同(激活概率差异性较小);而当T很低时,即趋于0时,不同的激活值对应的激活概率差异也就越大。这个结论很重要,Hinton在2015年的一篇paper中重点阐释了如何根据温度参数来soften神经网络的输出,从而提出了distillation的思想和方法。

3. logistic和softmax的关系

1)logistic具体针对的是二分类问题,而softmax解决的是多分类问题,因此从这个角度也可以理解logistic函数是softmax函数的一个特例。

这里借鉴UFLDL教程中的推导,具体的推导过程如下:

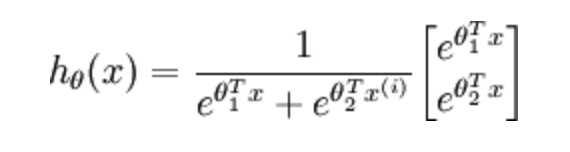

当分类数为2时,softmax回归的假设函数表示如下:

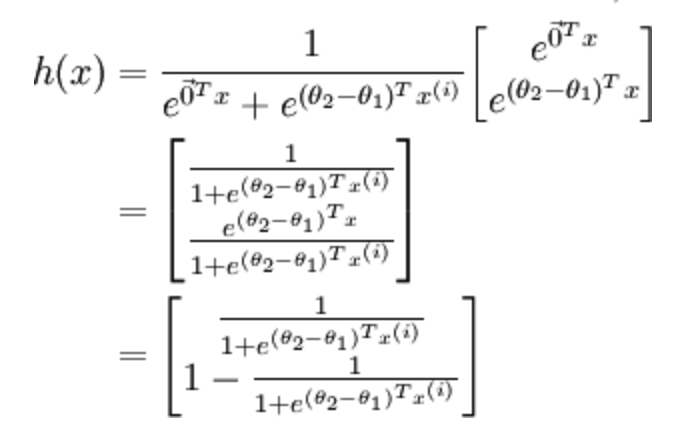

利用softmax回归参数冗余的特点,从两个参数向量中都减去向量$\theta_{1}$,得到:

最后,用$\theta^{'}$来表示$\theta_{2}-\theta_{1}$,上述公式可以表示为softmax回归器预测其中一个类别的概率为

$\frac{1}{1+e^{\theta^{'T}x^{i}}}$

另一个类别的概率为

$1-\frac{1}{1+e^{\theta^{'T}x^{i}}}$

这与logistic回归是完全一致的。

2)从概率角度来看logistic和softmax函数的区别。

softmax建模使用的分布是多项式分布,而logistic则基于伯努利分布,这方面具体的解释可以参考Andrew Ng的讲义去理解。

3)softmax回归和多个logistic回归的关系。

有了解的同学可能知道多个logistic回归通过叠加也同样可以实现多分类的效果,那么多个logistic回归和softmax一样不一样呢?

softmax回归进行的多分类,类与类之间是互斥的,即一个输入只能被归为一类;

多个logistic回归进行多分类,输出的类别并不是互斥的,即"苹果"这个词语既属于"水果"类也属于"3C"类别。

4. 参考内容

[1] wiki百科:logistic函数

[2] wiki百科:softmax函数

[Machine Learning] logistic函数和softmax函数的更多相关文章

- 机器学习---逻辑回归(二)(Machine Learning Logistic Regression II)

在<机器学习---逻辑回归(一)(Machine Learning Logistic Regression I)>一文中,我们讨论了如何用逻辑回归解决二分类问题以及逻辑回归算法的本质.现在 ...

- sigmoid 函数与 softmax 函数

sigmoid 函数与 softmax 函数 1. sigmoid 函数 sigmoid 函数又称:logistic函数,逻辑斯谛函数.其几何形状即为一条sigmoid曲线. lo ...

- [机器学习入门篇]-Logistic函数与Softmax函数

1.Logistic函数 在维基百科中,对logistic函数这样介绍道: A logistic function or logistic curve is a common "S" ...

- 机器学习---逻辑回归(一)(Machine Learning Logistic Regression I)

逻辑回归(Logistic Regression)是一种经典的线性分类算法.逻辑回归虽然叫回归,但是其模型是用来分类的. 让我们先从最简单的二分类问题开始.给定特征向量x=([x1,x2,...,xn ...

- Sigmoid函数与Softmax函数的理解

1. Sigmod 函数 1.1 函数性质以及优点 其实logistic函数也就是经常说的sigmoid函数,它的几何形状也就是一条sigmoid曲线(S型曲线). 其中z ...

- [Machine learning] Logistic regression

1. Variable definitions m : training examples' count \(X\) : design matrix. each row of \(X\) is a t ...

- How do I learn machine learning?

https://www.quora.com/How-do-I-learn-machine-learning-1?redirected_qid=6578644 How Can I Learn X? ...

- Logistic回归Cost函数和J(θ)的推导----Andrew Ng【machine learning】公开课

最近翻Peter Harrington的<机器学习实战>,看到Logistic回归那一章有点小的疑问. 作者在简单介绍Logistic回归的原理后,立即给出了梯度上升算法的code:从算法 ...

- Machine Learning/Introducing Logistic Function

Machine Learning/Introducing Logistic Function 打算写点关于Machine Learning的东西, 正好也在cnBlogs上新开了这个博客, 也就更新在 ...

随机推荐

- Dubbo学习之简单环境搭建

Dubbo服务的发展和作用: 首先,看下一般网站架构随着业务的发展,逻辑越来越复杂,数据量越来越大,交互越来越多之后的常规方案演进历程. 其次,当服务越来越多之后,我们需要做哪些服务治理? 最后,是d ...

- 关于IOS调用微信支付jsapi不起作用的解决方法

微信支付时,安卓机调用 jsapi可以支付,IOS就不行,点击立即支付,直接返回原立即支付页面,跟刷新页面差不多,解决方案很简单:两句话而已. 不得不说,微信支付坑太多了,我擦..... <sc ...

- Python Socket 网络编程

Socket 是进程间通信的一种方式,它与其他进程间通信的一个主要不同是:它能实现不同主机间的进程间通信,我们网络上各种各样的服务大多都是基于 Socket 来完成通信的,例如我们每天浏览网页.QQ ...

- 如何查看当前Ubuntu系统的版本

如何查看当前Ubuntu系统的版本 说来也惭愧,用Ubuntu差不多快1个月了,双系统是让朋友安的,只知道自己使用的是什么12版本的,具体怎么看还不知道,下面写一下查看当前Linux系统的版本的方法 ...

- C#进阶系列——WebApi 异常处理解决方案

前言:上篇C#进阶系列——WebApi接口传参不再困惑:传参详解介绍了WebApi参数的传递,这篇来看看WebApi里面异常的处理.关于异常处理,作为程序员的我们肯定不陌生,记得在介绍 AOP 的时候 ...

- [EF1]POCOs(Plain Old C# Object)Entity Framework 4.x: POCOs入门

原文链接:http://www.cnblogs.com/hjzhang/archive/2011/05/18/2050530.html POCOs 是在Visual Studio 2010和ASP.N ...

- 浏览器内核控制Meta标签说明文档【转】

背景介绍 由于众所周知的情况,国内的主流浏览器都是双核浏览器:基于Webkit内核用于常用网站的高速浏览.基于IE的内核用于兼容网银.旧版网站.以360的几款浏览器为例,我们优先通过Webkit内核渲 ...

- grails 优缺点分析

Grails是一套用于快速Web应用开发的开源框架,它基于Groovy编程语言,并构建于Spring.Hibernate等开源框架之上,是一个高生产力一站式框架. 易于使用的基于Hibernate的对 ...

- javascript 原型查找 再次试探~

前言 我们知道 对象字面量 是没有能力去查找自己原型的,它必须通过他的构造器来完成原型查找, 1本文将测试以下 a,new这个对象 之前/之后 改变构造器的原型,使其指向其他构造器的原型 b,new这 ...

- Python迭代器,可迭代对象,生成器

迭代器 迭代器(iterator)有时又称游标(cursor)是程式设计的软件设计模式,可在容器物件(container,例如链表或阵列)上遍访的界面,设计人员无需关心容器物件的内存分配的实现细节. ...