Sqoop使用,mysql,hbase,hive等相互转换

Sqoop 是一款用来在不同数据存储软件之间进行数据传输的开源软件,它支持多种类型的数据储存软件。

安装 Sqoop

1.下载sqoop并加mysql驱动包

http://mirror.bit.edu.cn/apache/sqoop/,下载,如下载sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz,

要从 MySQL 导数据需要安装 MySQL driver。如 mysql-connector-java-5.1.38.tar.gz,解压以后把 jar 包放到 Sqoop 目录下的 lib 目录下。

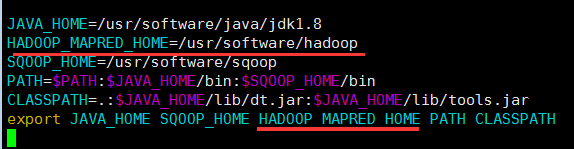

2.配置环境变量

要把HADOOP_MAPRED_HOME添加到系统环境,否则会报错/usr/software/sqoop/bin/../../hadoop/mapreduce does not exist!

需要 vi /etc/profiles加

SQOOP_HOME=/usr/software/hadoop

export HADOOP_MAPRED_HOME=/usr/software/hadoop export SQOOP_HOME=/usr/software/hadoop

从 MySQL 到 HDFS

mysql测试表 bbb 为例

sqoop import --connect jdbc:mysql://<dburi>/<dbname> --username <username> --password <password> --table <tablename> --check-column <col> --incremental <mode> --last-value <value> --target-dir <hdfs-dir> --fields-terminated-by '\t'

例子:

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password admin --table bbb --check-column id --incremental append --last-value '1' --target-dir output_hb --fields-terminated-by '\t'

参数说明:

参数说明: dburi:数据库的访问连接,例如: jdbc:mysql://192.168.1.124:3306/ 如果您的访问连接中含有参数,那么请用单引号将整个连接包裹住,例如’jdbc:mysql://192.168.1.124:3306/mydatabase?useUnicode=true’

dbname:数据库的名字,例如:user。

username:数据库登录用户名。

password:用户对应的密码。

tablename:MySQL 表的名字。

col:要检查的列的名称。

mode:该模式决定Sqoop如何定义哪些行为新的行。取值为append或lastmodified。

value:前一个导入中检查列的最大值。

hdfs-dir:HDFS 的写入目录,例如:/user/hive/result。

–check-column,用来指定一些列,这些列在导入时用来检查做决定数据是否要被作为增量数据,在一般关系型数据库中,都存在类似Last_Mod_Date的字段或主键。注意:这些被检查的列的类型不能是任意字符类型,例如Char,VARCHAR…(即字符类型不能作为增量标识字段)

–incremental,用来指定增量导入的模式(Mode),append和lastmodified

–last-value,指定上一次导入中检查列指定字段最大值

--fields-terminated-by 行分隔符 ,如 '\t'

--lines-terminated-by 列分隔符,hive只支持'\n'作为行分隔符,默认也是'\n'

更加详细的参数使用请参考 Sqoop Import。

从 HDFS 到 MySQL

需要先创建好对应 HDFS 中的数据结构的 MySQL 表,然后在集群的 Master 节点上执行如下命令,指定要导的数据文件的路径。

sqoop export --connect jdbc:mysql://<dburi>/<dbname> --username <username> --password <password> --table <tablename> --export-dir <hdfs-dir>

从 MySQL 到 Hive

在集群的 Master 节点上执行如下命令后,从MySQL数据库导入数据的同时,也会新建一个 Hive 表。

sqoop import --connect jdbc:mysql://<dburi>/<dbname> --username <username> --password <password> --table <tablename> --check-column <col> --incremental <mode> --last-value <value> --fields-terminated-by "\t" --lines-terminated-by "\n" --hive-import --target-dir <hdfs-dir> --create-hive-table --hive-table <hive-tablename>

报错处理:若报错“Hive does not support the SQL type for column GoodsPic” ,解决:对那列名指定类型,如 --map-column-hive GoodsPic=string

例子:

sqoop import -Dorg.apache.sqoop.splitter.allow_text_splitter=true --connect jdbc:postgresql://192.168.101.4:5432/postgres --username postgres --password 'admin' --table t_acc_master --hive-import --target-dir venus --hive-table venus.t_acc_master --hive-overwrite -m 1

参数说明:

--hive-table:对应的 Hive 中的表名,可以是 xxx.yyy 代表 数据库.表 。

--hdfs-dir:将源数据导入到HDFS上的那个文件夹下

--create-hive-table:没表就自动创建(默认是textfile的,不是parquet的)

--hive-overwrite 覆盖同步

从 Hive 到 MySQL

请参考上面的从 HDFS 到 MySQL的命令,只需要指定 Hive 表对应的 HDFS 路径就可以了。

例如:

sqoop export --connect jdbc:mysql://127.0.0.1:3306/parkdb --username xiaoming --password '' --table t_vip_user --export-dir 'hive_g2park/vip/*' --fields-terminated-by "\t"

--fields-terminated-by指明hdfs数据到mysql的分割凭据

具体如下:hdfs数据到hive中,以及hdfs数据隐身理解

从 MySQL 到 OSS

类似从 MySQL 到 HDFS,只是 --target-dir 不同。在集群的 Master 节点上执行如下命令:

注意1: OSS 地址中的 host 有内网地址、外网地址和 VPC 网络地址之分。如果用经典网络,需要指定内网地址,杭州是 oss-cn-hangzhou-internal.aliyuncs.com,VPC 要指定 VPC 内网,杭州是 vpc100-oss-cn-hangzhou.aliyuncs.com。

注意2: 目前同步到OSS不支持—delete-target-dir,用这个参数会报错Wrong FS。如果要覆盖以前目录的数据 ,可以在调用sqoop前,用hadoop fs -rm -r osspath先把原来的oss目录删了。

sqoop import --connect jdbc:mysql://<dburi>/<dbname> --username <username> --password <password> --table <tablename> --check-column <col> --incremental <mode> --last-value <value> --target-dir <oss-dir> --temporary-rootdir <oss-tmpdir>

参数说明:

oss-dir:OSS 的写入目录,例如:oss://<accessid>:<accesskey>@<bucketname>.oss-cn-hangzhou-internal.aliyuncs.com/result。

oss-tmpdir:临时写入目录。指定append模式的同时,需要指定该参数。如果目标目录已经存在于HDFS中,则Sqoop将拒绝导入并覆盖该目录的内容。采用append模式后,Sqoop会将数据导入临时目录,然后将文件重命名为正常目标目录。

从OSS到MySQL

类似MySQL到HDFS,只是—export-dir不同。需要创建好对应OSS中的数据结构的MySQL表

然后在集群的Master节点上执行如下:指定要导的数据文件的路径

sqoop export --connect jdbc:mysql://<dburi>/<dbname> --username <username> --password <password> --table <tablename> --export-dir <oss-dir>

参数:

oss-dir:oss的写入目录,例如:oss://<accessid>:<accesskey>@<bucketname>.oss-cn-hangzhou-internal.aliyuncs.com/result

注意: oss地址host有内网地址,外网地址,VPC网络地址之分。如果 用经典网络,需要指定内网地址,杭州是oss-cn-hangzhou-internal.aliyuncs.com,vpc要指定vpc内网,杭州是vpc100-oss-cn-hangzhou.aliyuncs.com

使用 SQL 作为导入条件

除了指定 MySQL 的全表导入,还可以写 SQL 来指定导入的数据,如下所示:

sqoop import --connect jdbc:mysql://<dburi>/<dbname> --username <username> --password <password> --query <query-sql> --split-by <sp-column> --hive-import --hive-table <hive-tablename> --target-dir <hdfs-dir>- 例子:

sqoop import --connect jdbc:mysql://localhost:3306/gznt --username gznt_r --password '123' --query "SELECT NodeCode,NodeName from tb_bmda where 1=1 AND \$CONDITIONS " --split-by NodeCode --target-dir output2

参数说明:

query-sql:使用的查询语句,例如:”SELECT * FROM profile WHERE id>1 AND \$CONDITIONS”。记得要用引号包围,最后一定要带上 AND \$CONDITIONS。

sp-column:进行切分的条件,一般跟 MySQL 表的主键。

hdfs-dir:要导到 MySQL 去的 HDFS 的数据目录,例如:/user/hive/result。

hive-tablename:对应的 Hive 中的表名,可以是 xxx.yyy。

从MYSQL到HBASE

类似MySQL到HDFS,只是—export-dir不同。需要创建好对应OSS中的数据结构的MySQL表

然后在集群的Master节点上执行如下:指定要导的数据文件的路径

ps:红色可以不填

sqoop import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://localhost:3306/gznt --username gznt_r --password '123' --table t_bmda --columns NodeCode,NodeType,NodeName,IsWarehouse,IsAssetUser --hbase-table hbase_bmda --column-family info --hbase-row-key NodeCode --where "ID >= 5"

参数:

-D sqoop.hbase.add.row.key=true 是否将rowkey相关字段写入列族中,默认false,默认你在列族中看不到任何row key中的字段。

--hbase-create-table 如果hbase中该表不存在则创建,ps:我加了这个,就报错了,据说了版本兼容问题,可以先手动创建好hbase的表和列族

--hbase-row-key < col > 指定字段作为row key ,如果输入表包含复合主键,用逗号分隔

从HIVE到HBASE

hive下建表(hbase下会自动创建对应表):

CREATE TABLE IF NOT EXISTS all_detail (

key string comment "rowkey",

SaleDate varchar(60),

NodeCode varchar(60),

NodeName varchar(60)

)

STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler'

WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,info:SaleDate,info:NodeCode,info:NodeName")

TBLPROPERTIES("hbase.table.name" = "hbase_tb");

;

注意点:

1.建表的时候,必须建一个 key column,如上的 key string comment "rowkey"

2.hbase.columns.mapping中是hive与hbase的对应,即 把SaleData,NodeCode,NodeName数据同步到hbase_tb下的info列族下。

附录:

Sqoop使用

Sqoop 简介及安装部署

使用Sqoop从MySQL导入数据到Hive和HBase 及近期感悟

Sqoop使用,mysql,hbase,hive等相互转换的更多相关文章

- sqoop: mysql to hive

sqoop import --connect 数据库连接 --username 数据库用户名--password 数据库密码 --table 导入的表 -m 1 --hive-import --tar ...

- sqoop import mysql to hive table:GC overhead limit exceeded

1. Scenario description when I use sqoop to import mysql table into hive, I got the following error: ...

- Sqoop导入关系数据库到Hive

参考:segmentfault.com:Sqoop导入关系数据库到Hive Sqoop 是 apache 下用于 RDBMS 和 HDFS 互相导数据的工具.本文以 mysql 数据库为例,实现关系数 ...

- 使用Sqoop从MySQL导入数据到Hive和HBase 及近期感悟

使用Sqoop从MySQL导入数据到Hive和HBase 及近期感悟 Sqoop 大数据 Hive HBase ETL 使用Sqoop从MySQL导入数据到Hive和HBase 及近期感悟 基础环境 ...

- Centos搭建mysql/Hadoop/Hive/Hbase/Sqoop/Pig

目录: 准备工作 Centos安装 mysql Centos安装Hadoop Centos安装hive JDBC远程连接Hive Hbase和hive整合 Centos安装Hbase 准备工作: 配置 ...

- sqoop:mysql和Hbase/Hive/Hdfs之间相互导入数据

1.安装sqoop 请参考http://www.cnblogs.com/Richardzhu/p/3322635.html 增加了SQOOP_HOME相关环境变量:source ~/.bashrc ...

- sqoop将mysql数据导入hbase、hive的常见异常处理

原创不易,如需转载,请注明出处https://www.cnblogs.com/baixianlong/p/10700700.html,否则将追究法律责任!!! 一.需求: 1.将以下这张表(test_ ...

- 教程 | 使用Sqoop从MySQL导入数据到Hive和HBase

基础环境 sqoop:sqoop-1.4.5+cdh5.3.6+78, hive:hive-0.13.1+cdh5.3.6+397, hbase:hbase-0.98.6+cdh5.3.6+115 S ...

- 使用Sqoop从mysql向hdfs或者hive导入数据时出现的一些错误

1.原表没有设置主键,出现错误提示: ERROR tool.ImportTool: Error during import: No primary key could be found for tab ...

随机推荐

- 【运维】略谈Raid级别

*何为Raid? Raid就是磁盘阵列(Redundant Arrays of Independent Disks,RAID),有"独立磁盘构成的具有冗余能力的阵列&quo ...

- 2018 “百度之星”程序设计大赛 - 初赛(A)

第二题还算手稳+手快?最后勉强挤进前五百(期间看着自己从两百多掉到494名) 1001 度度熊拼三角 (hdoj 6374) 链接:http://acm.hdu.edu.cn/showprob ...

- Java9 新特性

Java9中的9个新特性 1. Java 平台级模块系统 2. Linking 3. JShell: 交互式 Java REPL 4. 改进的 Javadoc 5. 集合工厂方法 6. 改进的 Str ...

- python3 - 默认参数为列表

默认参数的坑 定义一个函数,传入一个list,添加一个end再返回 1 2 3 def add_end(L=[]): L.append('END') return L 正常调用时,结 ...

- 测试cpu的简单工具-dhrystone【转】

转自:https://blog.csdn.net/feixiaoxing/article/details/9005587 版权声明:本文为博主原创文章,未经博主允许不得转载. https://blog ...

- VC里判断系统是不是64bit

不过,理论上来说,也可以用一个int的大小作为参考,判断是32位还是64位.sizeof(int) == 4 //32位系统.sizeof(int) == 8 //64位系统. 也可以使用函数如下: ...

- 在TOMCAT下配置工程的默认访问设置(转)

对工程的部署一般是将工程的压缩文件放在tomcat安装目录的webapps下,访问时通过键入:http://localhost:8080/xx(假定为本机访问,xx是部署时的应用工程的访问名字). 而 ...

- MySQL--pymysql模块

import pymysqlaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaa连接conn=pymysql.connect(host='127.0.0. ...

- FreeSWITCH 增删模组

今天在尝试FreeSWITCH新功能时,遇到一个问题,就是该功能所需要的模组没有加载,导致写了好久的代码不能看到效果,让人很是忧伤啊! 再此,将FS模组增删的方法记录下,以方便遇到同样问题的童鞋. 具 ...

- oracle 11.2.0.4 rac 打补丁

本次安装pus环境是11.2.0.4 rac,打的patch为11.2.0.4.180717 (Includes Database PSU),gi补丁和数据库补丁一起打 安装最新opatch版本 un ...