python爬虫-基础入门-爬取整个网站《1》

python爬虫-基础入门-爬取整个网站《1》

描述:

使用环境:python2.7.15 ,开发工具:pycharm,现爬取一个网站页面(http://www.baidu.com)所有数据。

python代码如下:

# -*- coding: utf-8 -*-

import urllib2

def baiduNet() :

request = urllib2.Request("http://www.baidu.com")

response = urllib2.urlopen(request)

netcontext = response.read()

file = open("baidutext.txt","w")

file.write(netcontext)

if __name__ == "__main__" :

baiduNet()

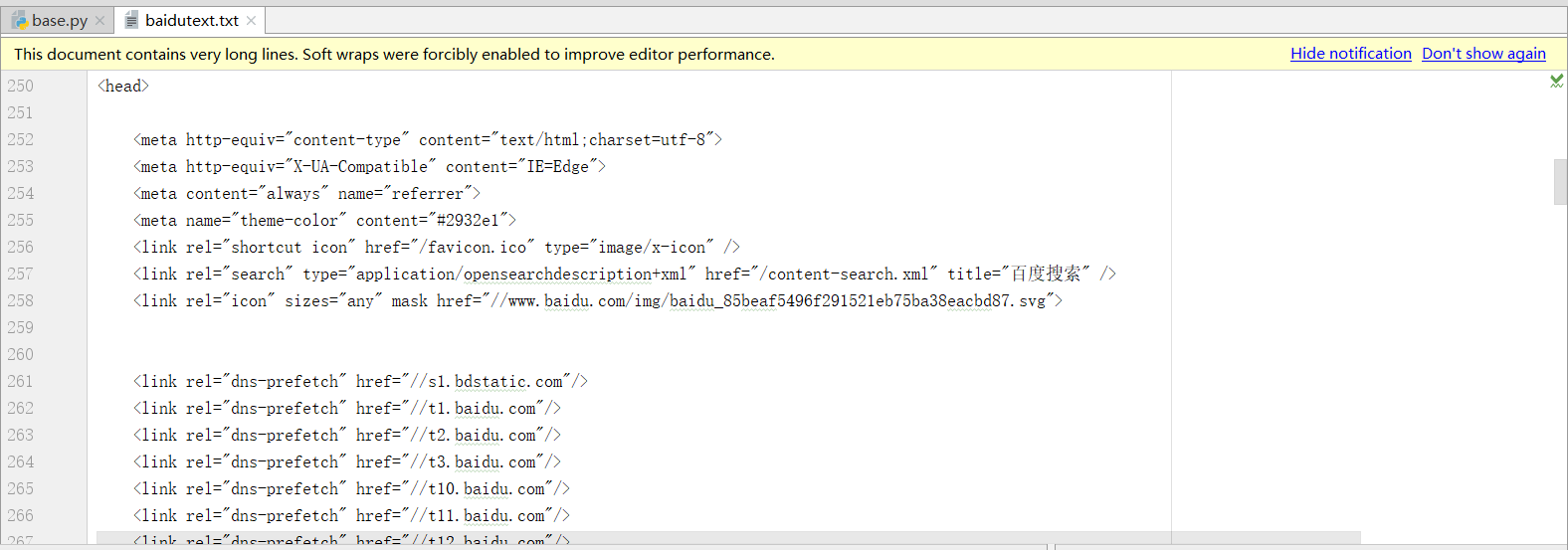

执行后baidutext.txt数据,部分截图如下:

打开浏览器,访问百度,鼠标右键页面,查看源代码,如下:

使用代码爬取到的页面数据和源网站页面数据是一样的,爬取网页成功。

如有问题,欢迎纠正!!!

如有转载,请标明源处:https://www.cnblogs.com/Charles-Yuan/p/9903221.html

python爬虫-基础入门-爬取整个网站《1》的更多相关文章

- python爬虫-基础入门-爬取整个网站《3》

python爬虫-基础入门-爬取整个网站<3> 描述: 前两章粗略的讲述了python2.python3爬取整个网站,这章节简单的记录一下python2.python3的区别 python ...

- python爬虫-基础入门-爬取整个网站《2》

python爬虫-基础入门-爬取整个网站<2> 描述: 开场白已在<python爬虫-基础入门-爬取整个网站<1>>中描述过了,这里不在描述,只附上 python3 ...

- Python 网络爬虫 002 (入门) 爬取一个网站之前,要了解的知识

网站站点的背景调研 1. 检查 robots.txt 网站都会定义robots.txt 文件,这个文件就是给 网络爬虫 来了解爬取该网站时存在哪些限制.当然了,这个限制仅仅只是一个建议,你可以遵守,也 ...

- python爬虫基础应用----爬取校花网视频

一.爬虫简单介绍 爬虫是什么? 爬虫是首先使用模拟浏览器访问网站获取数据,然后通过解析过滤获得有价值的信息,最后保存到到自己库中的程序. 爬虫程序包括哪些模块? python中的爬虫程序主要包括,re ...

- Python爬虫基础--分布式爬取贝壳网房屋信息(Client)

1. client_code01 2. client_code02 3. 这个时候运行多个client就可以分布式进行数据爬取.

- Python爬虫基础--分布式爬取贝壳网房屋信息(Server)

1. server_code01 2. server_code02 3. server_code03

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- python爬虫-基础入门-python爬虫突破封锁

python爬虫-基础入门-python爬虫突破封锁 >> 相关概念 >> request概念:是从客户端向服务器发出请求,包括用户提交的信息及客户端的一些信息.客户端可通过H ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

随机推荐

- hdu6363 bookshelf 容斥+数列+数论gcd定理(也可以Möbius)

#define _CRT_SECURE_NO_WARNINGS #include<cmath> #include<iostream> #include<stdio.h&g ...

- 编译安装hadoop2.x

1.Requirements: * Unix System * JDK 1.7+ * Maven 3.0 or later * Findbugs 1.3.9 (if running findbugs) ...

- 动画支持的一些keypath

transform.scale = 比例轉換 transform.scale.x = 闊的比例轉換 transform.scale.y = 高的比例轉換 transform.rotation.z = ...

- piano class 12

1,不要记谱子,眼睛要一直看着谱子,手指凭感觉找琴键 2,弹的时候一定要按照谱子上标出来的指法弹奏,很重要 3,两只手要会跷跷板弹奏 4,八分音符,一般第二个会比第一个弱一点,但是要看自己感觉 5,慢 ...

- linux添加新硬盘

1.添加新磁盘 2.fdisk -l查看磁盘被识别的名称 3.如果输入fdisk -l命令没有找到新的磁盘,按下面步骤操作 1)进入到cd /sys/class/scsi_host/ 2)echo & ...

- #include<stdio.h> #include "stdio.h"

https://baike.baidu.com/item/#include <stdio.h> #include <stdio.h> 编辑 #include<stdio. ...

- Chrome中安装Firebug插件

Chrome中的Firebug插件:Firebug Lite 1.Firebug Lite下载:http://chromecj.com/web-development/2015-05/471/down ...

- Java+Selenium 常见问题QA

一:日期控件二:上传控件三:页面隐藏元素四:弹出窗口的处理五:富文本框编辑器六:元素高亮 一:日期控件selenium不能直接对日期控件操作,可以通过js对日期控件做赋值操作 WebElement i ...

- python获取指定目录下特定格式的文件名

之前一直用windows下的bat脚本获取一个目录下的指定格式的文件名,如下所示: dir *.jpg /b/s > train.set pause 十分简单,将这个bat文件放到你想要获取文件 ...

- 对vue.js的template编译的理解

简而言之,就是先转化成AST树,再得到的render函数返回VNode(Vue的虚拟DOM节点) 详情步骤: 首先,通过compile编译器把template编译成AST语法树(abstract sy ...